.net core i上 K8S(一)集群搭建

1.前言

以前搭建集群都是使用nginx反向代理,但现在我们有了更好的选择——K8S。我不打算一上来就讲K8S的知识点,因为知识点还是比较多,我打算先从搭建K8S集群讲起,我也是在搭建集群的过程中熟悉了K8S的一些概念,希望对大家有所帮助。K8S集群的搭建难度适中,网上有很多搭建k8s的教程,我搭建的过程中或多或少遇到一些问题,现在就把我总结完的教程给大家总结一下。这里主要讲通过二进制包安装K8S

2.集群组件介绍

| 节点 | ip | 组件 |

| master | 192.168.8.201 |

etcd:存储集群节点信息 kubectl:管理集群组件,通过kubectl控制集群 kube-controller-manage:监控节点是否健康,不健康则自动修复至健康状态 kube-scheduler:负责为kube-controller-manage创建的pod选择合适的节点,将节点信息写入etcd |

| node | 192.168.8.202 |

kube-proxy:service与pod通信 kubelet:kube-scheduler将节点数据存入etcd后,kubelet获取到并按规则创建pod docker |

3.etcd安装

yum install etcd –y

vi /etc/etcd/etcd.conf

修改etcd.conf内容

ETCD_LISTEN_CLIENT_URLS="http://0.0.0.0:2379"

启动

systemctl start etcd

systemctl enable etcd

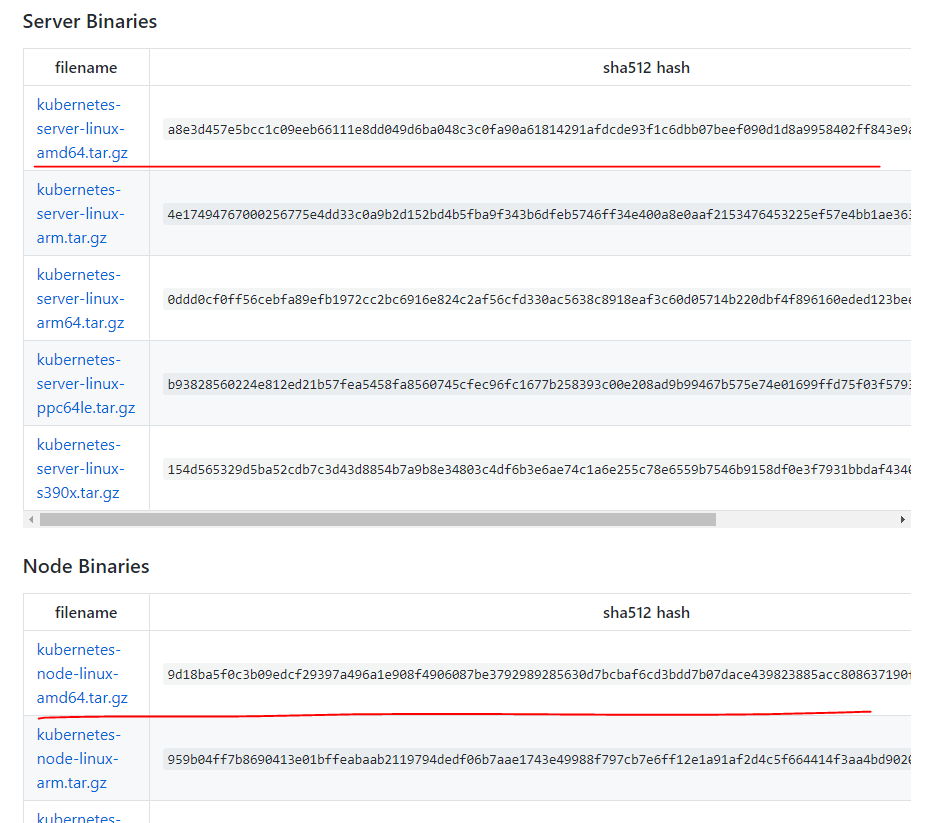

4.下载k8s安装包

打开github中k8s地址,选择一个版本的安装包

点击CHANGELOG-1.13.md,在master节点上安装server包,node节点上安装node包

5.master节点安装server

tar zxvf kubernetes-server-linux-amd64.tar.gz #解压

mkdir -p /opt/kubernetes/{bin,cfg} #创建文件夹

mv kubernetes/server/bin/{kube-apiserver,kube-scheduler,kube-controller-manager,kubectl} /opt/kubernetes/bin #移动文件到上一步的文件夹

chmod +x /opt/kubernetes/bin/*

5.1配置apiserver

cat <<EOF >/opt/kubernetes/cfg/kube-apiserver KUBE_APISERVER_OPTS="--logtostderr=true \\

--v= \\

--etcd-servers=http://192.168.8.201:2379 \\

--insecure-bind-address=0.0.0.0 \\

--insecure-port= \\

--advertise-address=192.168.8.201 \\

--allow-privileged=true \\

--service-cluster-ip-range=10.10.10.0/ \\

--service-node-port-range=- \\

--admission-control=NamespaceLifecycle,LimitRanger,SecurityContextDeny,ResourceQuota" EOF

cat <<EOF >/usr/lib/systemd/system/kube-apiserver.service

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes [Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-apiserver

ExecStart=/opt/kubernetes/bin/kube-apiserver \$KUBE_APISERVER_OPTS

Restart=on-failure [Install]

WantedBy=multi-user.target

EOF

5.2配置kube-controller-manager

cat <<EOF >/opt/kubernetes/cfg/kube-controller-manager KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=true \\

--v= \\

--master=127.0.0.1: \\

--leader-elect=true \\

--address=127.0.0.1" EOF

cat <<EOF >/usr/lib/systemd/system/kube-controller-manager.service

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes [Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-controller-manager

ExecStart=/opt/kubernetes/bin/kube-controller-manager \$KUBE_CONTROLLER_MANAGER_OPTS

Restart=on-failure [Install]

WantedBy=multi-user.target

EOF

5.3配置kube-scheduler

cat <<EOF >/opt/kubernetes/cfg/kube-scheduler KUBE_SCHEDULER_OPTS="--logtostderr=true \\

--v= \\

--master=127.0.0.1: \\

--leader-elect" EOF

cat <<EOF >/usr/lib/systemd/system/kube-scheduler.service

[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes [Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-scheduler

ExecStart=/opt/kubernetes/bin/kube-scheduler \$KUBE_SCHEDULER_OPTS

Restart=on-failure [Install]

WantedBy=multi-user.target

EOF

5.4运行kube-api与kube-controller-manager与kube-scheduler

vim ku.sh #创建一个脚本,内容如下

#!/bin/bash systemctl daemon-reload

systemctl enable kube-apiserver

systemctl restart kube-apiserver systemctl enable kube-controller-manager

systemctl restart kube-controller-manager systemctl enable kube-scheduler

systemctl restart kube-scheduler

执行以上脚本

chmod +x *.sh #给权限 ./ku.sh #运行

5.5将kubectl配置到环境变量,便于执行

echo "export PATH=$PATH:/opt/kubernetes/bin" >> /etc/profile

source /etc/profile

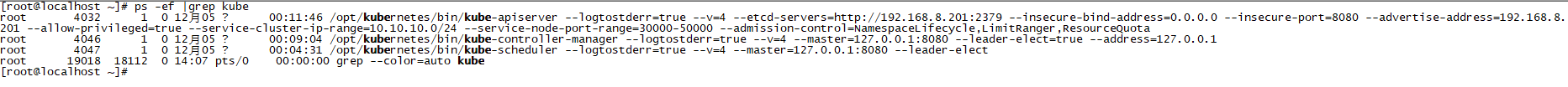

至此server安装成功,可通过命令查看相关进程是否启动成功

ps -ef |grep kube

启动失败可通过以下命令查看信息

journalctl -u kube-apiserver

6.安装node节点

6.1docker安装

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sudo yum makecache fast

sudo yum -y install docker-ce

sudo systemctl start docker

6.2解压node.zip包

tar zxvf kubernetes-node-linux-amd64.tar.gz

mkdir -p /opt/kubernetes/{bin,cfg}

mv kubernetes/node/bin/{kubelet,kube-proxy} /opt/kubernetes/bin/

chmod +x /opt/kubernetes/bin/*

6.3创建配置文件

vim /opt/kubernetes/cfg/kubelet.kubeconfig

apiVersion: v1

kind: Config

clusters:

- cluster:

server: http://192.168.8.201:8080

name: kubernetes

contexts:

- context:

cluster: kubernetes

name: default-context

current-context: default-context

vim /opt/kubernetes/cfg/kube-proxy.kubeconfig

apiVersion: v1

kind: Config

clusters:

- cluster:

server: http://192.168.8.201:8080

name: kubernetes

contexts:

- context:

cluster: kubernetes

name: default-context

current-context: default-context

cat <<EOF >/opt/kubernetes/cfg/kubelet KUBELET_OPTS="--logtostderr=true \\

--v= \\

--address=192.168.8.202 \\

--hostname-override=192.168.8.202 \\

--kubeconfig=/opt/kubernetes/cfg/kubelet.kubeconfig \\

--allow-privileged=true \\

--cluster-dns=10.10.10.2 \\

--cluster-domain=cluster.local \\

--fail-swap-on=false \\

--pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0" EOF

cat <<EOF >/usr/lib/systemd/system/kubelet.service

[Unit]

Description=Kubernetes Kubelet

After=docker.service

Requires=docker.service [Service]

EnvironmentFile=-/opt/kubernetes/cfg/kubelet

ExecStart=/opt/kubernetes/bin/kubelet \$KUBELET_OPTS

Restart=on-failure

KillMode=process [Install]

WantedBy=multi-user.target

EOF

cat <<EOF >/opt/kubernetes/cfg/kube-proxy KUBE_PROXY_OPTS="--logtostderr=true \

--v= \

--hostname-override=192.168.8.202 \

--kubeconfig=/opt/kubernetes/cfg/kube-proxy.kubeconfig" EOF

cat <<EOF >/usr/lib/systemd/system/kube-proxy.service

[Unit]

Description=Kubernetes Proxy

After=network.target [Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-proxy

ExecStart=/opt/kubernetes/bin/kube-proxy \$KUBE_PROXY_OPTS

Restart=on-failure [Install]

WantedBy=multi-user.target

EOF

6.4启动kube-proxy与kubelet

vim ku.sh

#!/bin/bash systemctl daemon-reload

systemctl enable kubelet

systemctl restart kubelet systemctl enable kube-proxy

systemctl restart kube-proxy

至此node安装完成,查看是否安装成功

失败则查看日志

journalctl -u kubelet

7.master节点验证是否有node节点

查看集群健康状态

至此master与node安装成功

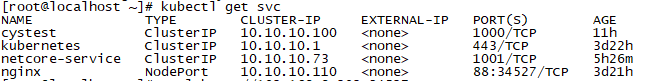

8.启动一个nginx示例

kubectl run nginx --image=nginx --replicas=

kubectl expose deployment nginx --port= --target-port= --type=NodePort

验证

浏览器访问

9.安装dashbord

vim kube.yaml

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

labels:

app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kube-system

spec:

replicas:

selector:

matchLabels:

app: kubernetes-dashboard

template:

metadata:

labels:

app: kubernetes-dashboard

annotations:

scheduler.alpha.kubernetes.io/tolerations: |

[

{

"key": "dedicated",

"operator": "Equal",

"value": "master",

"effect": "NoSchedule"

}

]

spec:

containers:

- name: kubernetes-dashboard

image: registry.cn-hangzhou.aliyuncs.com/google_containers/kubernetes-dashboard-amd64:v1.7.0

imagePullPolicy: Always

ports:

- containerPort:

protocol: TCP

args:

- --apiserver-host=http://192.168.8.201:8080

livenessProbe:

httpGet:

path: /

port:

initialDelaySeconds:

timeoutSeconds: --- kind: Service

apiVersion: v1

metadata:

labels:

app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kube-system

spec:

type: NodePort

ports:

- port:

targetPort:

selector:

app: kubernetes-dashboard

创建

kubectl create -f kube.yaml

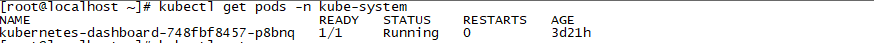

查看pod

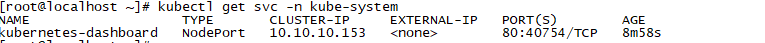

查看端口

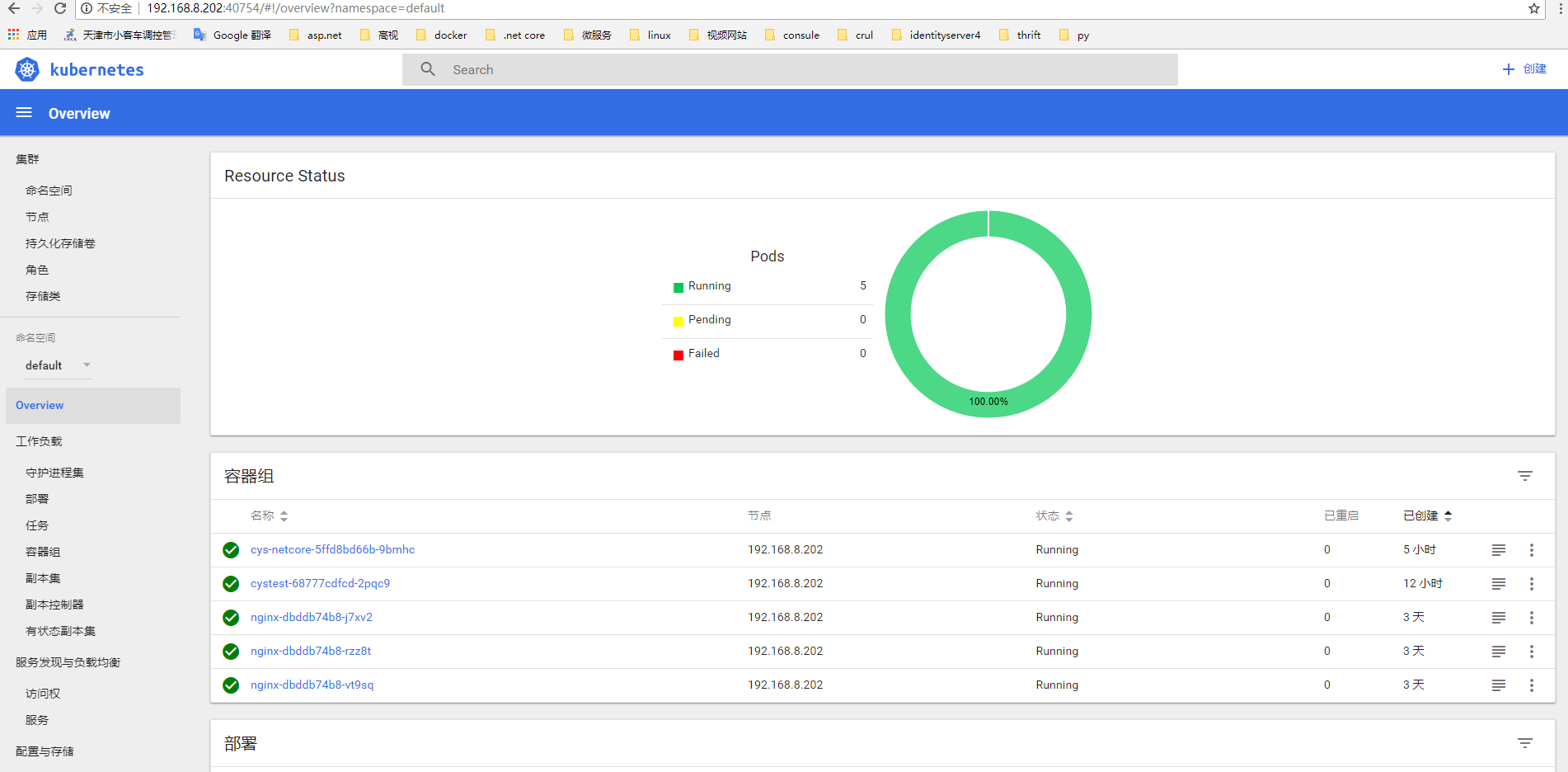

访问bord

至此集群搭建完成

.net core i上 K8S(一)集群搭建的更多相关文章

- K8S之集群搭建

转自声明 ASP.NET Core on K8S深入学习(1)K8S基础知识与集群搭建 1.K8S环境搭建的几种方式 搭建K8S环境有几种常见的方式如下: (1)Minikube Minikube是一 ...

- 初试 Centos7 上 Ceph 存储集群搭建

转载自:https://cloud.tencent.com/developer/article/1010539 1.Ceph 介绍 Ceph 是一个开源的分布式存储系统,包括对象存储.块设备.文件系统 ...

- K8s 上的分布式存储集群搭建(Rook/ceph)

转载自:https://mp.weixin.qq.com/s/CdLioTzU4oWI688lqYKXUQ 1 环境准备 1.1 基础环境 3台配置一致的虚拟机 虚拟机配置:4c 8g 虚拟机操作系统 ...

- k8s docker集群搭建

一.Kubernetes系列之介绍篇 •Kubernetes介绍 1.背景介绍 云计算飞速发展 - IaaS - PaaS - SaaS Docker技术突飞猛进 - 一次构建,到处运行 - 容器 ...

- Kubernetes(k8s) docker集群搭建

原文地址:https://blog.csdn.net/real_myth/article/details/78719244 一.Kubernetes系列之介绍篇 •Kubernetes介绍 1.背 ...

- 使用国内的镜像源搭建 kubernetes(k8s)集群

1. 概述 老话说的好:努力学习,提高自己,让自己知道的比别人多,了解的别人多. 言归正传,之前我们聊了 Docker,随着业务的不断扩大,Docker 容器不断增多,物理机也不断增多,此时我们会发现 ...

- 2-20 MySQL集群搭建实现高可用

MySQL集群概述和安装环境 MySQL Cluster是MySQL适合于分布式计算环境的高实用.高冗余版本.Cluster的汉语是"集群"的意思.它采用了NDB Cluster ...

- 前端静态站点在阿里云自建 K8S DevOps 集群上优雅的进行 CI/CD

目录 网站 域名 K8S DevOps 集群 私有 Gitlab 使用 Docker 编译站点 * Dockerfile * 构建编译 Image * 测试编译 Image * 推送镜像到 Aliyu ...

- .Net Core2.1 秒杀项目一步步实现CI/CD(Centos7.2)系列一:k8s高可用集群搭建总结以及部署API到k8s

前言:本系列博客又更新了,是博主研究很长时间,亲自动手实践过后的心得,k8s集群是购买了5台阿里云服务器部署的,这个集群差不多搞了一周时间,关于k8s的知识点,我也是刚入门,这方面的知识建议参考博客园 ...

随机推荐

- django网页的分页功能,大家如果有疑问请留言

url文件 from django.contrib import admin from django.conf.urls import url from app01 import views urlp ...

- 第1章WCF简介(WCF全面解析读书笔记2)

第1章 WCF简介 面向服务架构(SOA)是近年来备受业界关注的一个主题,它代表了软件架构的一种方向.顺应SOA发展潮流,微软于2006年年底推出了一种新的分布式通信框架Windows Communi ...

- WPF Shader 正片叠底

新建文本文档拷贝以下代码 //正片叠底sampler2D implicitInput : register(s0);sampler2D oldInput : register(s1);float4 m ...

- solr的客户端操作:使用solrj进行curd操作

导入相关的jar包 <dependency> <groupId>org.apache.solr</groupId> <artifactId>solr-s ...

- Echarts主题颜色

Echarts主题颜色搜集: 直接覆盖默认颜色即可 例如在 echarts.setOption({ '#2ec7c9','#b6a2de','#5ab1ef','#ffb980','#d87a80', ...

- Selenium自动化测试WebDriver下载

1. 所有版本chrome下载 是不是很难找到老版本的chrome?博主收集了几个下载chrome老版本的网站,其中哪个下载的是原版的就不得而知了. http://www.slimjet.com/ch ...

- 采用AutoIt实现文件上传

在非常规的上传界面中,AutoIt可以操作Windows资源管理器实现上传路径的输入. AutoIt中编辑以下脚本,需通过“AutoIt Windows Info”定位资源管理器路径输入位置信息及打开 ...

- PropertyPlaceholderConfigurer使用及@Value使用注意事项

思考 PropertyPlaceholderConfigurer和<context:property-placeholder/>有何区别? @Value在Controller层和Servi ...

- 使用Qt Installer Framework制作软件安装包

概述 Qt Installer Framework(缩写QIF)是Qt官方用于生成软件安装包的工具.包括Qt Creator和Qt Installer Framework自身的安装包都是由这个工具制作 ...

- Cw210开发板

达内培训嵌入式开发板 qt + kernel uboot toolchain