eclipse添加hadoop开发插件

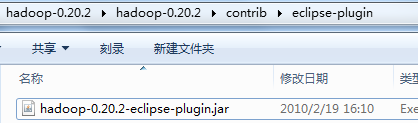

在开发hadoop的时候去查找了一下eclipse marketplace是没有找到hadoop的插件,上网又找了一下发现原来hadoop中其实是带有这样的插件的,

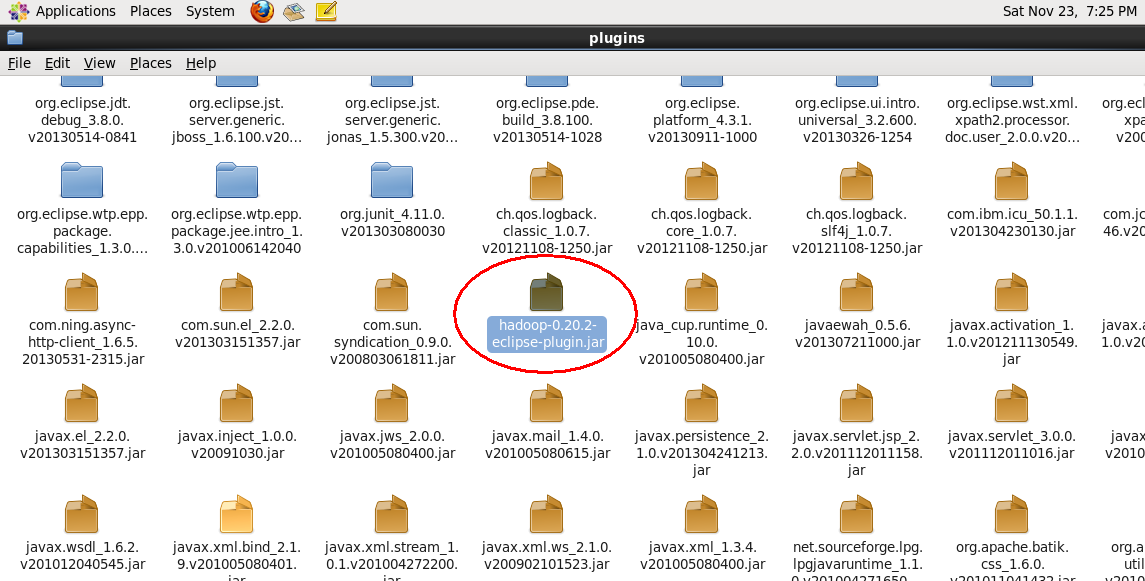

其实很简单只要将这个插件复制到eclipse/plugins目录下然后重启eclipse就可以了

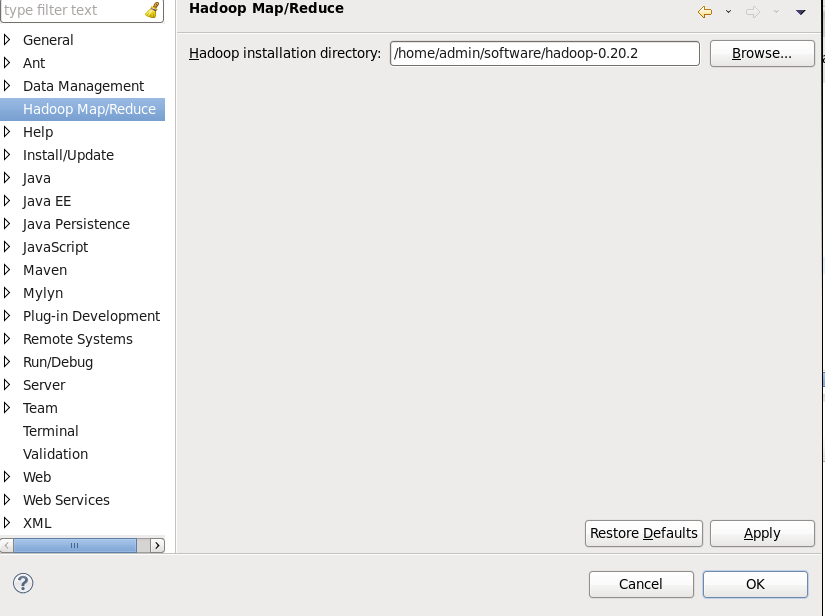

重启之后就可以看到eclipse == 》window ==》 preferences 可以看到多了一个Hadoop Map/Reduce 点击Browse按钮找到你的hadoop的解压目录如图:

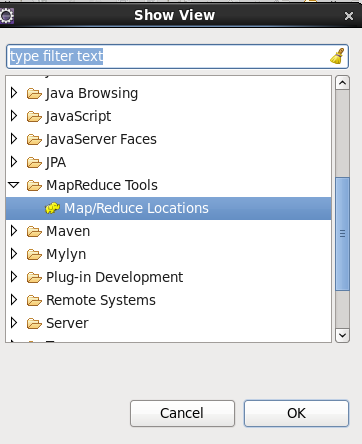

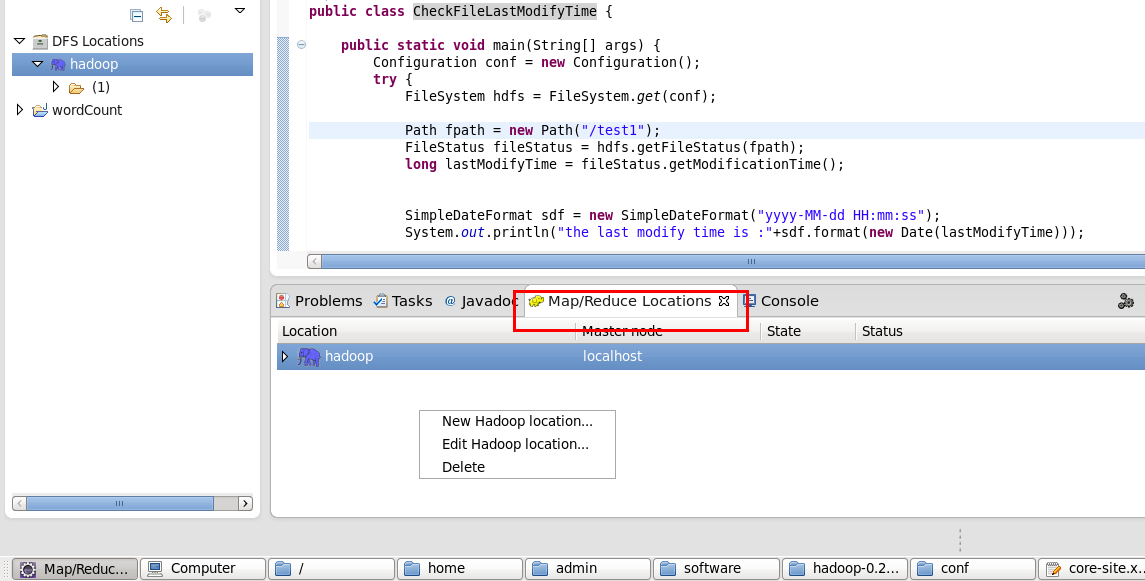

配置好了环境之后我们来创建一个本地连接,点击Windows==》show view ==》 other 选择MapReduce Tools ==》Map/Reduce Location

然后我们新建一个本地连接,这这里右键 New hadoop Location

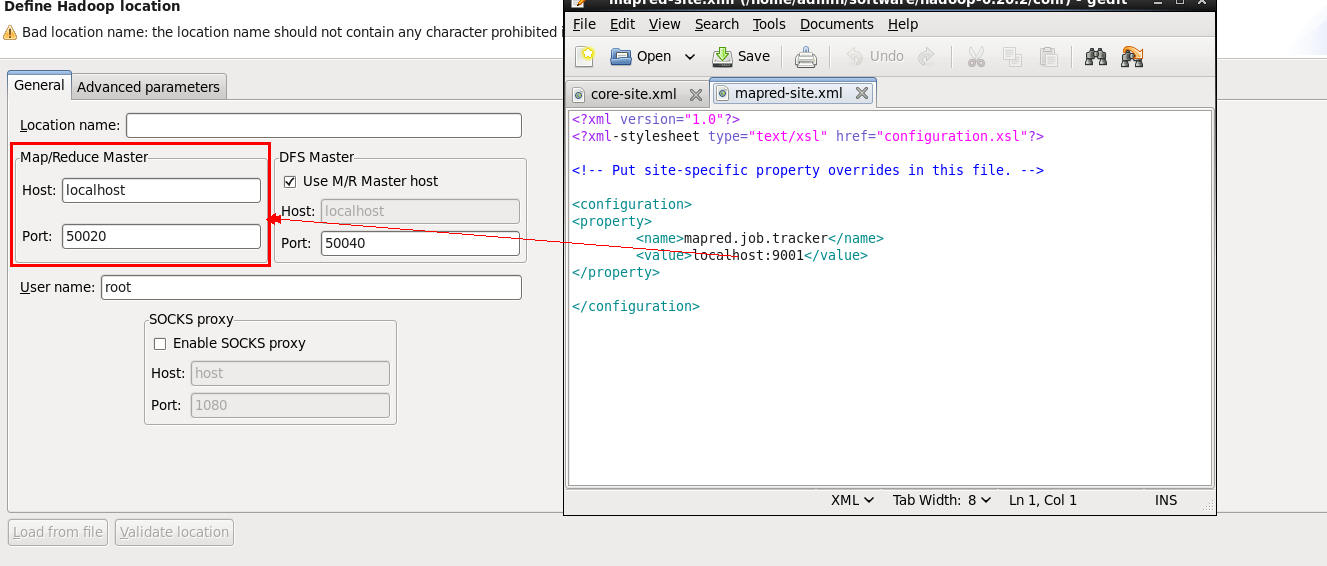

然后我们的配置host:这里的Map/Reduce Master对应hadoop配置文件中的mapred-site.xml

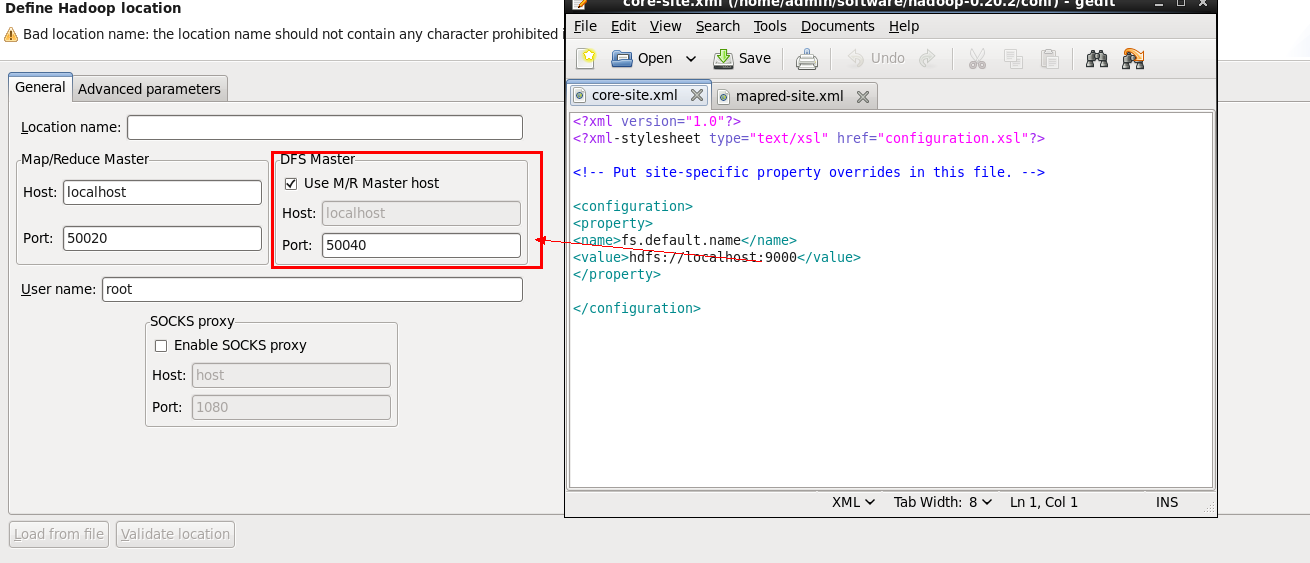

DFS Master的配置对应core-site.xml详细请看图

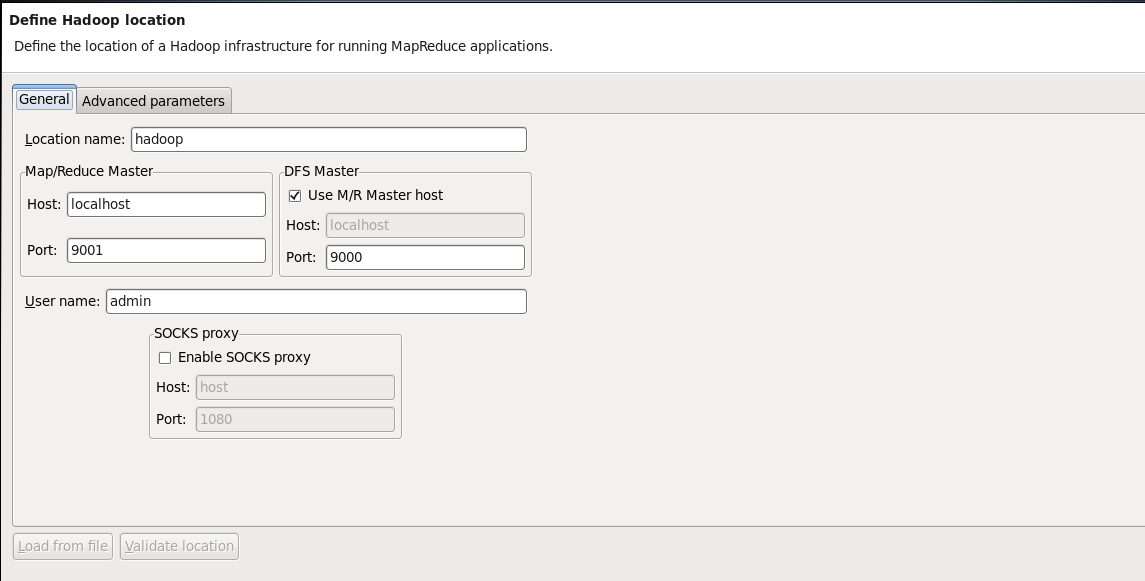

配置好后的应该是这样的:

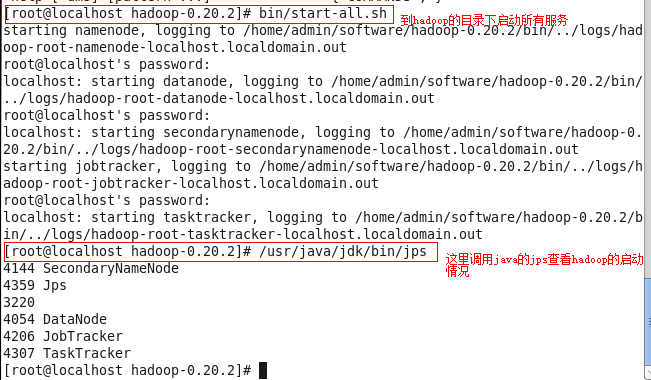

这里配置好之后我们可以启动hadoop来简单的测试一下

如果跟上面的输出信息一样证明正常启动了,如果没有正常启动估计是在配置的时候除了问题。下面我给几个简单的小测试程序可以运行一下

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* copy local file to hadoop system 将文件拷贝到HDFS

* @author root

*

*/

public class ConpyFile { public static void main(String[] args) {

//get local system configuration

Configuration conf = new Configuration();

try { FileSystem hdfs = FileSystem.get(conf); Path src = new Path("/home/admin/test3");

Path dst = new Path("/"); hdfs.copyFromLocalFile(src, dst);; FileStatus files[] = hdfs.listStatus(dst); for(int i = 0; i < files.length; i++){

System.out.println("status :"+files[i]);

}

} catch (IOException e) {

e.printStackTrace();

} } }

这里注意我的文件是已经创建的然后拷贝到hdfs上如果在上传的时候找不到文件可能跟linux下的权限有关系。建议修改权限就可以了。

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* create a hdfs file 创建hdfs文件

* @author root

*

*/

public class CreateHDFSFile { public static void main(String[] args) {

Configuration conf = new Configuration(); //获取系统的hadoop的配置环境

try {

FileSystem hdfs = FileSystem.get(conf);//获取文件系统对象

byte bytes[] = "Hello word !".getBytes();

Path dfs = new Path("/test");

FSDataOutputStream outputStream = hdfs.create(dfs);

outputStream.write(bytes, 0, bytes.length);

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} } }

重命名hadoop系统中的一个文件的名称:

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* rename hdfs file

* @author root

*

*/

public class ReNameHDFSFile { public static void main(String[] args) {

Configuration conf = new Configuration();

FileSystem hdfs;

try {

hdfs = FileSystem.get(conf);

Path frpath = new Path("/test3");

Path topath = new Path("/test1");

boolean isRename = hdfs.rename(frpath, topath);

System.out.println("rename is finish:"+isRename); } catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

检查文件的最后的修改时间:

package com.hadoop.test; import java.io.IOException;

import java.text.SimpleDateFormat;

import java.util.Date; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* check hdfs file last modify time

* @author root

*

*/

public class CheckFileLastModifyTime { public static void main(String[] args) {

Configuration conf = new Configuration();

try {

FileSystem hdfs = FileSystem.get(conf); Path fpath = new Path("/test1");

FileStatus fileStatus = hdfs.getFileStatus(fpath);

long lastModifyTime = fileStatus.getModificationTime(); SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

System.out.println("the last modify time is :"+sdf.format(new Date(lastModifyTime))); } catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} } }

eclipse添加hadoop开发插件的更多相关文章

- Ubuntu环境下eclipse的hadoop开发

在安装好hadoop伪分布式后,开始搭建eclipse的hadoop开发环境 我的版本信息如下: Ubuntu 版本 12.10 Hadoop版本 1.2.1 Java版本 1.6.0_31(命令j ...

- [原创] 毕设---在myeclipes中安装Hadoop开发插件

1.安装Hadoop开发插件 hadoop安装包contrib/目录下有个插件hadoop-0.20.2-eclipse-plugin.jar,拷贝到myeclipse根目录下/dropins目录下. ...

- 在ubuntu下使用Eclipse搭建Hadoop开发环境

一.安装准备1.JDK版本:jdk1.7.0(jdk-7-linux-i586.tar.gz)2.hadoop版本:hadoop-1.1.1(hadoop-1.1.1.tar.gz)3.eclipse ...

- JBPM学习第2篇:为Eclipse添加JBPM开发支持

1.Eclipse添加JBoss支持插件 参考:Eclipse添加JBoss支持 若已安装,直接跳过! 2.Eclipse添加Drools插件 jbpm-installer-full解压后的文件夹中找 ...

- 为Eclipse添加反编译插件,更好的调试

为Eclipse添加反编译插件,更好的调试 一般来说,我们的项目或多或少的都会引用一些外部jar包,如果可以查看jar包的源代码,对于我们的调试可以说是事半功倍. 1.下载并安装jad.exe.将ja ...

- 在windows环境中用eclipse搭建hadoop开发环境

1. 整体环境和设置 1.1 hadoo1.0.4集群部署在4台VMWare虚拟机中,这四台虚拟机都是通过NAT模式连接主机 集群中/etc/hosts文件配置 #本机127.0.0.1 localh ...

- 基于Eclipse搭建hadoop开发环境

一.基础环境准备 1.Eclipse 下载地址:http://pan.baidu.com/s/1slArxAP 2.JDK1.8 下载地址:http://pan.baidu.com/s/1i5iNy ...

- perl环境配置以及Eclipse安装perl开发插件

简介: 这篇文章将详细介绍 EPIC 组件的安装,EPIC 编辑环境,调试运行环境,着重介绍如何使用 EPIC 来快速.简便.准确地调试 Perl 语言程序,包括对于 Perl 程序的单步执行,断点用 ...

- eclipse基础及开发插件

Eclipse:http://www.eclipse.org/downloads/ Compare Package:http://www.eclipse.org/downloads/packages/ ...

随机推荐

- 接口是干爹, 继承是亲爹 ---JAVA

接口(interface)是干爹, 因为你可以有很多很多的干爹爹... 继承(extends)是亲爹, 因为你只能有一个父类, 只有一个亲生的父亲. 单继承,多接口?./>./..

- (博弈论)hdoj 1079 Calendar Game

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=1079 题解:题目大意,两个人Adam和Eve一块儿玩游戏,游戏规则是从1900年1月1日到2001年1 ...

- Castle IOC容器内幕故事(上)

主要内容 1.WindsorContainer分析 2.MicroKernel分析 3.注册组件流程 一.WindsorContainer分析 WindsorContainer是Castle的IOC容 ...

- contentWindow 和contentDocument区别 及iframe访问

a>contentWindow 兼容各个浏览器,可取得子窗口的 window 对象. b>contentDocument Firefox 支持,> ie8 的ie支持.可取得子窗口的 ...

- iPhone中国移动收不到彩信,联通不用设置都可以,具体设置方法:

打开“设置”. 打开“通用”. 打开“蜂窝移动网络”. 打开“蜂窝数据移动网络”. 在“蜂窝移动数据”一栏中的“APN”处填入“cmnet”. 在“彩信”一栏中的“APN”处填入“cmnet”,“MM ...

- 系列文章--精通CSS.DIV网页样式与布局学习

精通CSS.DIV网页样式与布局(八)——滤镜的使用 精通CSS.DIV网页样式与布局(七)——制作实用菜单 精通CSS.DIV网页样式与布局(六)——页面和浏览器元素 精通CSS.DIV网页样式与布 ...

- openflashchart + flex

Hello openflashchart+flex的demo: http://blog.webasp.com.au/2009/06/open-flash-chart-as-a-swc/ http:// ...

- IE6中奇数宽高的BUG

一个外部的相对定位div,内部一个绝对定位的div(right:0), 如图: 可是在IE6下查看,却变成了right:1px的效果了: IE6还有奇数宽高的bug,解决方案就是将外部相对定位的div ...

- Pre-compile (pre-JIT) your assembly on the fly, or trigger JIT compilation ahead-of-time (转)

Introduction All .NET developers know that one of the best features of the CLR is JIT-compilation: J ...

- .NET连接SAP系统专题:C#调用RFC代码(三)

本文就说明在C#中如何编写代码来调用SAP中的RFC函数获取数据. 首先需要引用两个NCO3.0的DLL DLL下载地址:http://files.cnblogs.com/mengxin523/SAP ...