【DeepLearning学习笔记】Coursera课程《Neural Networks and Deep Learning》——Week1 Introduction to deep learning课堂笔记

Coursera课程《Neural Networks and Deep Learning》 deeplearning.ai

Week1 Introduction to deep learning

What is a Neural Network?

让我们从一个房价预测的例子开始讲起。

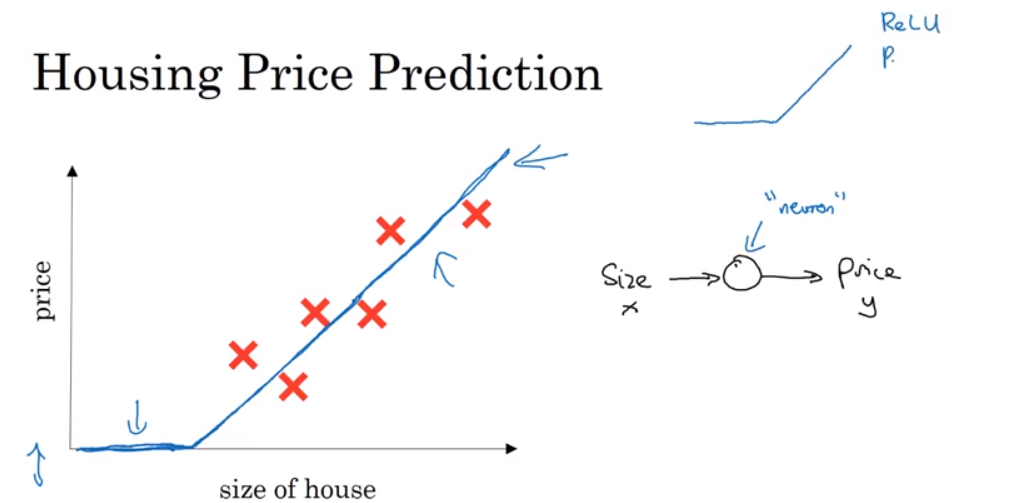

假设你有一个数据集,它包含了六栋房子的信息。所以,你知道房屋的面积是多少平方英尺或者平方米,并且知道房屋价格。这时,你想要拟合一个根据房屋面积预测房价的函数。

如果使用线性回归进行拟合,那么可以拟合出一条直线。但是我们知道,价格永远不会是负数的。因此,为了替代一条可能会让价格为负的直线,我们把直线折一下,让它在这里归零。所以这条粗的蓝线最终就是我们的函数。

我们可以把这个方程当做一个很简单的神经网络。

我们把房屋的面积作为神经网络的输入(我们称之为\(x\)),通过一个节点(一个小圆圈),最终输出了价格(我们用\(y\)表示)。其实这个小圆圈就是一个单独的神经元。接着你的网络实现了左边这个函数的功能。

在有关神经网络的文献中,经常看得到这个函数。从趋近于零开始,然后变成一条直线。这个函数被称作ReLU激活函数,它的全称是修正线性单元Rectified Linear Unit。可以理解成\(max(0,x)\),这也是得到一个这种形状的函数的原因。

如果这是一个单神经元网络,不管规模大小,它正是通过把这些单个神经元叠加在一起来形成。如果你把这些神经元想象成单独的乐高积木,你就通过搭积木来完成一个更大的神经网络。

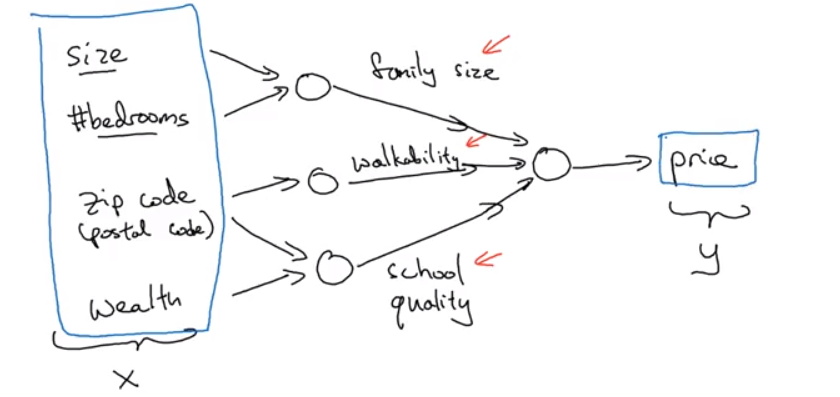

假设我们不仅仅用房屋的面积来预测它的价格,现在你有了一些有关房屋的其它特征,比如卧室的数量,或许有一个很重要的因素,一家人的数量也会影响房屋价格,这个房屋能住下一家人或者是四五个人的家庭吗?而这确实是基于房屋大小,以及真正决定一栋房子是否能适合你们家庭人数的卧室数。

你可能知道邮政编码或许能作为一个特征,告诉你步行化程度。比如这附近是不是高度步行化,你是否能步行去杂货店或者是学校,以及你是否需要驾驶汽车。有些人喜欢居住在以步行为主的区域,另外根据邮政编码还和富裕程度相关(在美国是这样的)。但在其它国家也可能体现出附近学校的水平有多好。

在图上每一个画的小圆圈都可以是ReLU的一部分,也就是指修正线性单元,或者其它稍微非线性的函数。基于房屋面积和卧室数量,可以估算家庭人口,基于邮编,可以估测步行化程度或者学校的质量。最后这些决定人们乐意花费多少钱。

以此为例,\(x\) 是所有的这四个输入,\(y\) 是你尝试预测的价格,把这些单个的神经元叠加在一起,我们就有了一个稍微大一点的神经网络。

神经网络的一部分神奇之处在于,当你实现它之后,你要做的只是输入\(x\),就能得到输出\(y\)。因为它可以自己计算你训练集中样本的数目以及所有的中间过程。中间的这些圆圈被叫做隐藏单元圆圈,在一个神经网络中,它们每个都从输入的四个特征获得自身输入。

值得注意的是神经网络给予了足够多的关于\(x\)和\(y\)的数据,给予了足够的训练样本有关\(x\)和\(y\)。神经网络非常擅长计算从\(x\)到\(y\)的精准映射函数。

Supervised Learning with Neural Networks

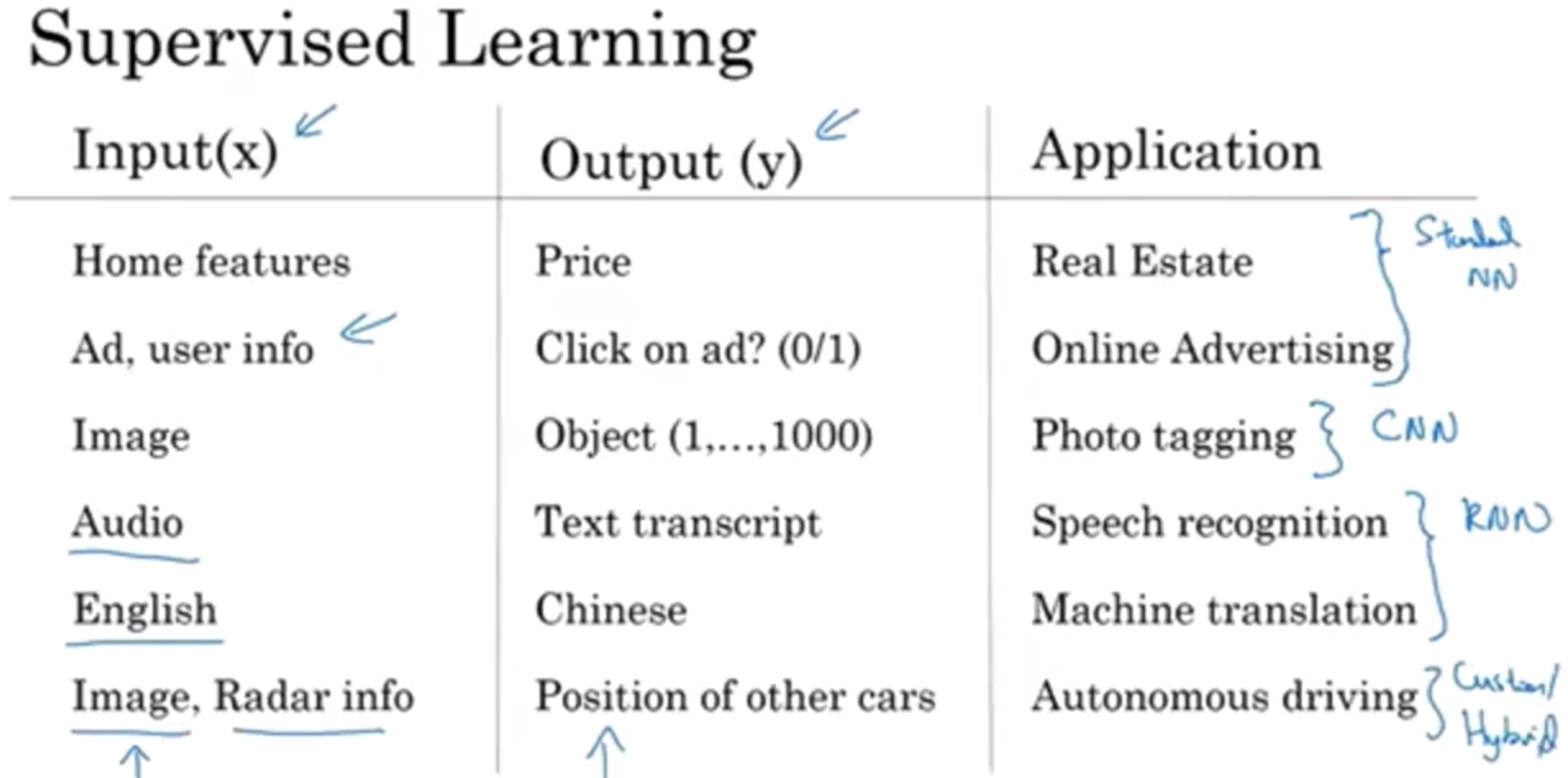

监督学习的一些应用举例,以及它们常用的神经网络。

神经网络类型

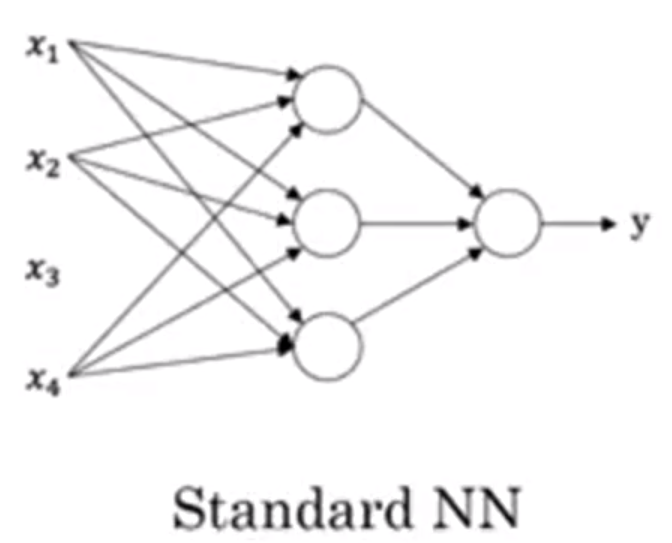

下图是一种标准神经网络。

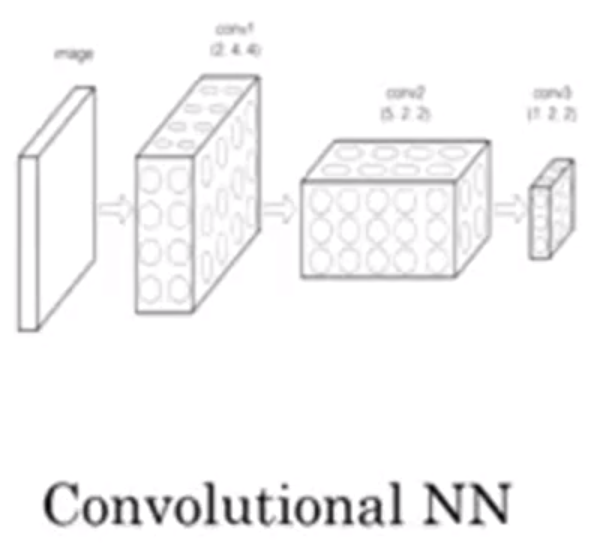

而下图是卷积神经网络(CNN)。它通常用于图像数据。

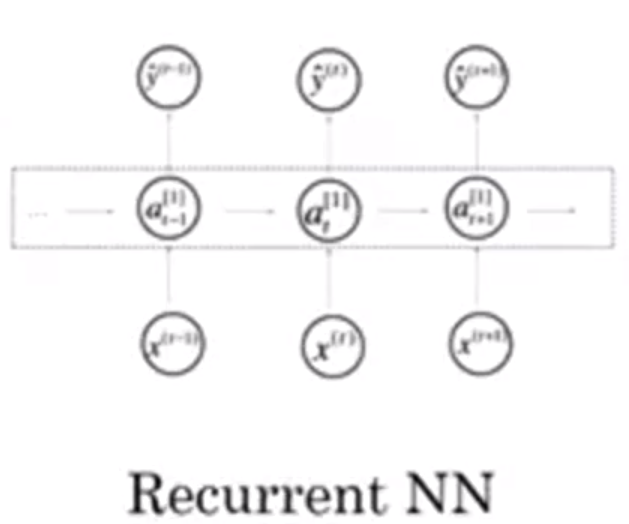

下图是递归神经网络(RNN)。它非常适合处理一维序列,一维序列化数据也许就是时序数据。

结构化数据与非结构化数据

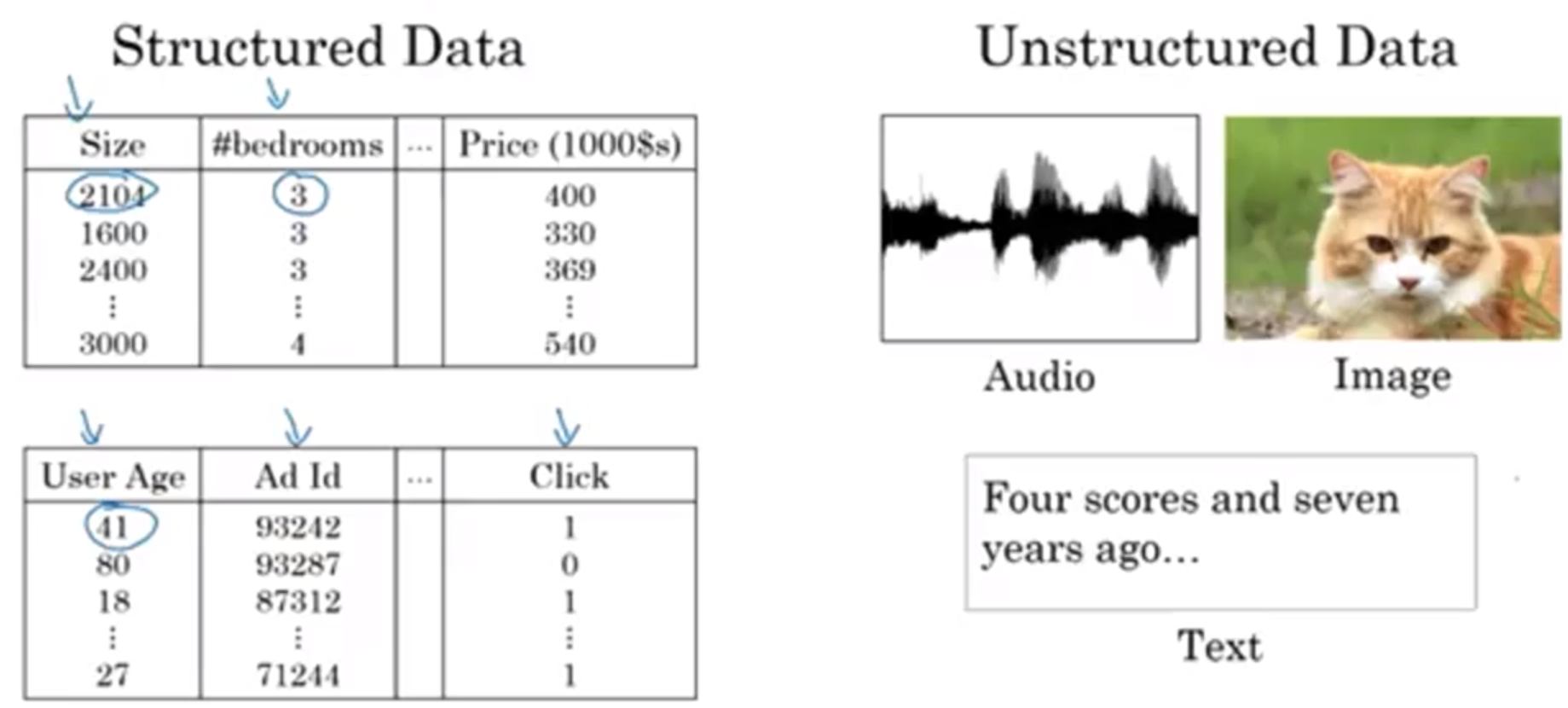

结构化数据(Structured Data)意味着数据的基本数据库。例如在房价预测中,你可能有一个数据库,有专门的几列数据告诉你卧室的大小和数量,这就是结构化数据。

非结构化数据(Unstructured Data)是指比如音频,原始音频或者你想要识别的图像或文本中的内容。这里的特征可能是图像中的像素值或文本中的单个单词。

Why is Deep Learning taking off?

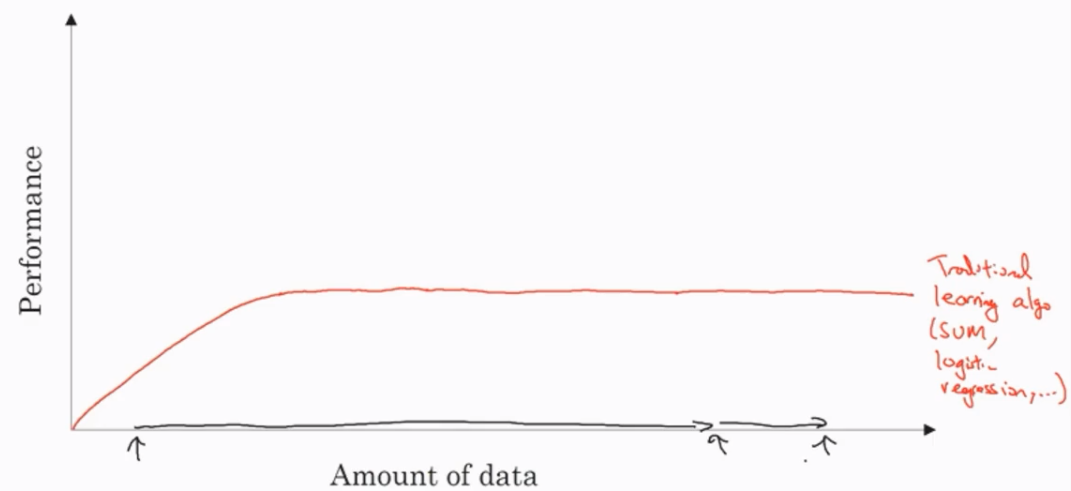

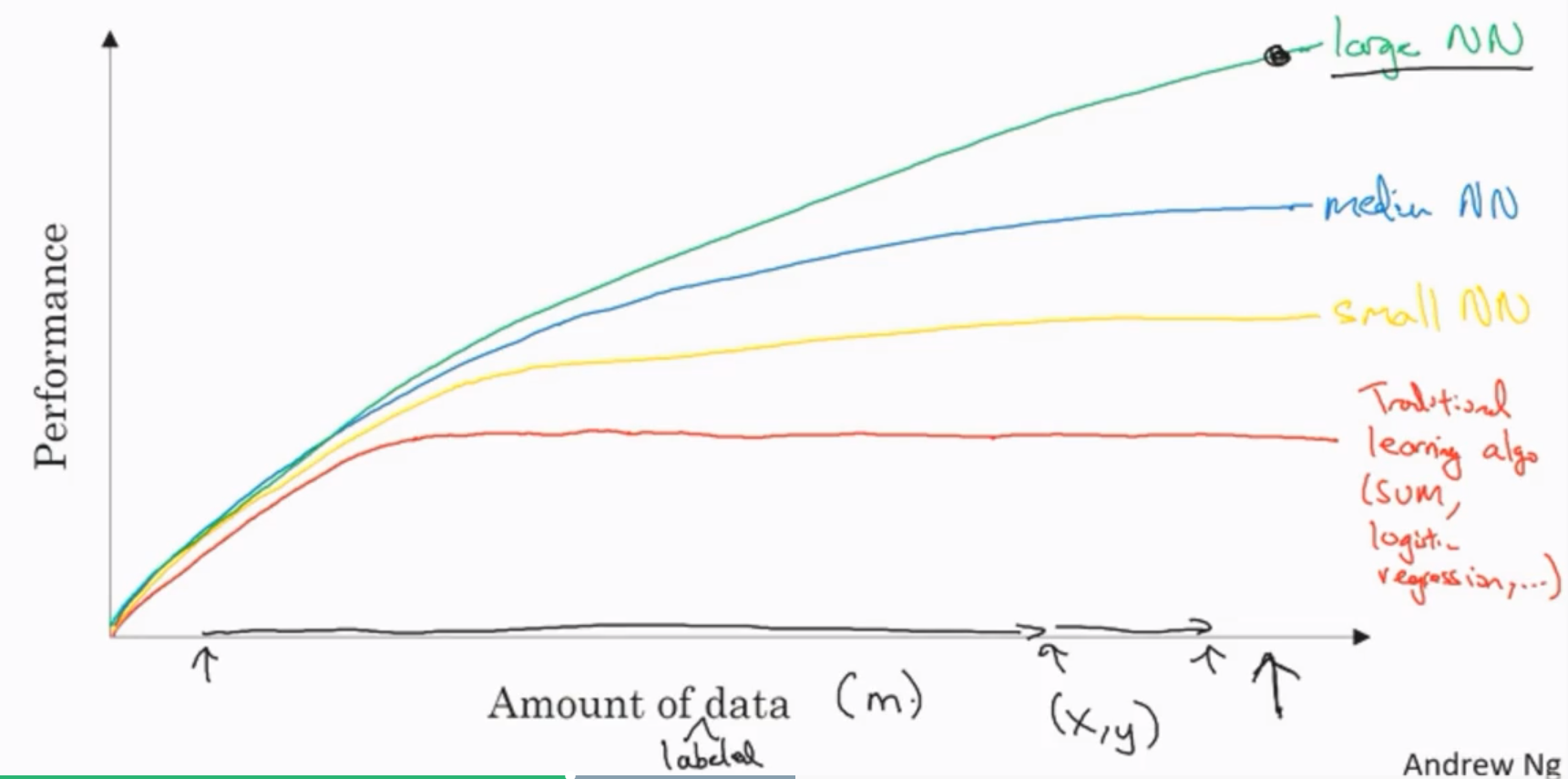

如果你把一个传统机器学习算法的性能画出来,作为数据量的一个函数,你可能得到一个弯曲的线,就像图中这样,它的性能一开始在增加更多数据时会上升,但是一段变化后它的性能就会像一个高原一样。假设你的水平轴拉的很长很长,它们不知道如何处理规模巨大的数据。

神经网络展现出的是,如果你训练一个小型的神经网络,那么这个性能可能会像下图黄色曲线表示那样;如果你训练一个稍微大一点的神经网络,比如说一个中等规模的神经网络(下图蓝色曲线),它在某些数据上面的性能也会更好一些;如果你训练一个非常大的神经网络,它就会变成下图绿色曲线那样,并且保持变得越来越好。因此可以注意到两点:如果你想要获得较高的性能体现,那么你有两个条件要完成,第一个是你需要训练一个规模足够大的神经网络,以发挥数据规模量巨大的优点,另外你需要能画到\(x\)轴的这个位置,所以你需要很多的数据。因此我们经常说规模一直在推动深度学习的进步,这里的规模指的也同时是神经网络的规模,我们需要一个带有许多隐藏单元的神经网络,也有许多的参数及关联性,就如同需要大规模的数据一样。事实上如今最可靠的方法来在神经网络上获得更好的性能,往往就是要么训练一个更大的神经网络,要么投入更多的数据,这只能在一定程度上起作用,因为最终你耗尽了数据,或者最终你的网络是如此大规模导致将要用太久的时间去训练,但是仅仅提升规模的的确确地让我们在深度学习的世界中摸索了很多时间。

【参考】

【DeepLearning学习笔记】Coursera课程《Neural Networks and Deep Learning》——Week1 Introduction to deep learning课堂笔记的更多相关文章

- Coursera, Deep Learning 1, Neural Networks and Deep Learning - week1, Introduction to deep learning

整个deep learing 系列课程主要包括哪些内容 Intro to Deep learning

- 【网页开发学习】Coursera课程《面向 Web 开发者的 HTML、CSS 与 Javascript》Week1课堂笔记

Coursera课程<面向 Web 开发者的 HTML.CSS 与 Javascript> Johns Hopkins University Yaakov Chaikin Week1 In ...

- Stanford机器学习笔记-5.神经网络Neural Networks (part two)

5 Neural Networks (part two) content: 5 Neural Networks (part two) 5.1 cost function 5.2 Back Propag ...

- Stanford机器学习笔记-4. 神经网络Neural Networks (part one)

4. Neural Networks (part one) Content: 4. Neural Networks (part one) 4.1 Non-linear Classification. ...

- 论文笔记:Diffusion-Convolutional Neural Networks (传播-卷积神经网络)

Diffusion-Convolutional Neural Networks (传播-卷积神经网络)2018-04-09 21:59:02 1. Abstract: 我们提出传播-卷积神经网络(DC ...

- 【论文笔记】Progressive Neural Networks 渐进式神经网络

Progressive NN Progressive NN是第一篇我看到的deepmind做这个问题的.思路就是说我不能忘记第一个任务的网络,同时又能使用第一个任务的网络来做第二个任务. 为了不忘记之 ...

- 论文笔记(1)-Dropout-Improving neural networks by preventing co-adaptation of feature detectors

Improving neural networks by preventing co-adaptation of feature detectors 是Hinton在2012年6月份发表的,从这篇文章 ...

- 论文笔记——Factorized Convolutional Neural Networks

1. 论文思想 将3D卷积分解为spatial convolution in each channel and linear projection across channels. (spatial ...

- 论文笔记—Flattened convolution neural networks for feedforward acceleration

1. 论文思想 一维滤过器.将三维卷积分解成三个一维卷积.convolution across channels(lateral), vertical and horizontal direction ...

随机推荐

- 基于c++的ostu算法的实现

图像二值化算法是图像处理的基础.一般来说,二值化算法可以分为两个类别:全局二值化和局部二值化.全局二值化是指通过某种算法找到一个全局的阈值T,对图像中坐标为(x,y)的像素值做如下处理: Ostu就是 ...

- Windows API封装:LoadLibrary/FreeLibrary

LoadLibrary/LoadLibraryEx用来加载DLL到自己的进程空间,使用完用FreeLibrary释放,一般使用方式如下: HINSTANCE hInstRich = ::Load ...

- udp->ip & tcp->ip 发送数据包的目的地址的源地址是什么时候确定的?

udp->ip & tcp->ip udp到ip层是:ip_send_skb tcp到ip层是: ip_queue_xmit 拿tcp为例,在使用[ip_queue_xmit, i ...

- 如何在存储过程中执行set命令 我来答

1.EXEC使用EXEC命令两种用种执行存储程另种执行态批处理所讲都第二种用 面先使用EXEC演示例,代码1DECLARE @TableName VARCHAR(50),@Sql NVARCHAR ( ...

- init只创建一次 只有父类的init创建servletContext的对象

init只创建一次 只有父类的init创建servletContext的对象 如果重写父类的方法 但不显示调用父类的init 是不会创建servletContext对象的

- poj 1469 COURSES (二分匹配)

COURSES Time Limit: 1000MS Memory Limit: 10000K Total Submissions: 16877 Accepted: 6627 Descript ...

- bzoj1208: [HNOI2004]宠物收养所 (sbt)

切傻逼题还能wa那么多次我也是醉了 好啦其实是sbt都不会敲了(一直用神器treap) 重点是研究了下陈大神的删除,以前treap的删除都是直接旋转去删的…… 还是treap大法好&…… 题解 ...

- HUD.2544 最短路 (Dijkstra)

HUD.2544 最短路 (Dijkstra) 题意分析 1表示起点,n表示起点(或者颠倒过来也可以) 建立无向图 从n或者1跑dij即可. 代码总览 #include <bits/stdc++ ...

- HDOJ(HDU).1241 Oil Deposits(DFS)

HDOJ(HDU).1241 Oil Deposits(DFS) [从零开始DFS(5)] 点我挑战题目 从零开始DFS HDOJ.1342 Lotto [从零开始DFS(0)] - DFS思想与框架 ...

- bzoj4822: [Cqoi2017]老C的任务(扫描线+BIT/线段树)

裸题... 依旧是写了BIT和线段树两种(才不是写完线段树后才想起来可以写BIT呢 怎么卡常数都挺大...QAQ ccz和yy的写法好快哇%%% BIT: #include<iostream&g ...