Python实现结巴分词统计高频中文词汇

代码

- 1 # 读取文件

- 2 fn = open('youxi.txt', 'rt', encoding='utf-8') # 打开文件

- 3 string_data = fn.read() # 读出整个文件

- 4 fn.close() # 关闭文件

- 5

- 6 # 文本预处理

- 7 pattern = re.compile(u'\t|\n|\.|-|:|;|\)|\(|\?|"') # 定义正则表达式匹配模式

- 8 string_data = re.sub(pattern, '', string_data) # 将符合模式的字符去除

- 9

- 10 # 文本分词

- 11 seg_list_exact = jieba.cut(string_data, cut_all=False) # 精确模式分词

- 12 object_list = []

- 13

- 14 # 分词并去除停用词

- 15 remove_words = set()

- 16 fr = open('stopword.txt', encoding = 'UTF-8')

- 17 for word in fr:

- 18 remove_words.add(str(word).strip())

- 19 fr.close()

- 20

- 21 for word in seg_list_exact: # 循环读出每个分词

- 22 if word not in remove_words: # 如果不在去除词库中

- 23 object_list.append(word) # 分词追加到列表

- 24

- 25 # 词频统计

- 26 word_counts = collections.Counter(object_list) # 对分词做词频统计

- 27 word_counts_top10 = word_counts.most_common(100) # 获取前100最高频的词

- 28 print(word_counts_top10) # 输出检查

需要引入的库

- 1 import re # 正则表达式库

- 2 import collections # 词频统计库

- 3 import numpy as np # numpy数据处理库

- 4 import jieba # 结巴分词

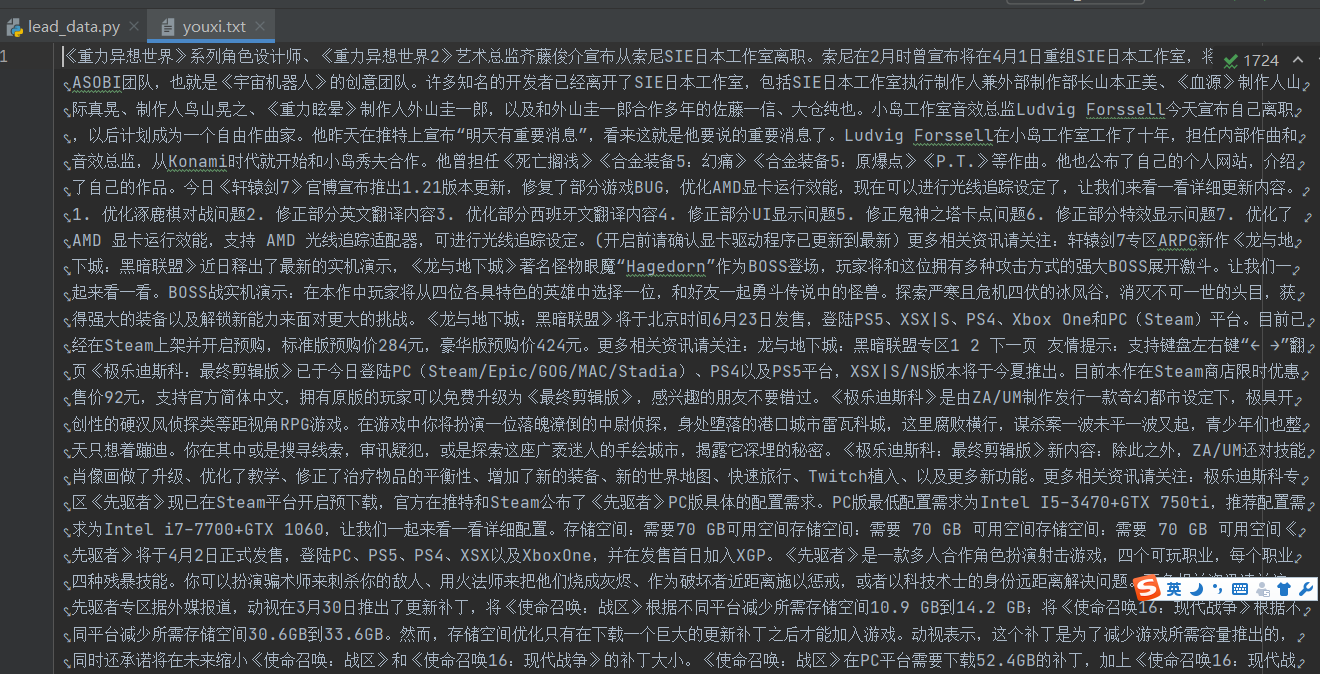

文件内容示例

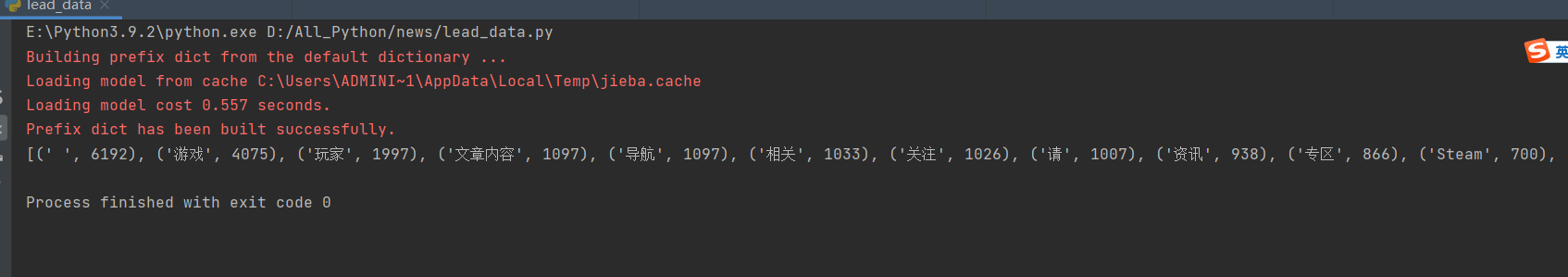

处理结果示例(前100)

Python实现结巴分词统计高频中文词汇的更多相关文章

- Python中结巴分词使用手记

手记实用系列文章: 1 结巴分词和自然语言处理HanLP处理手记 2 Python中文语料批量预处理手记 3 自然语言处理手记 4 Python中调用自然语言处理工具HanLP手记 5 Python中 ...

- 中文分词接口api,采用结巴分词PHP版中文分词接口

中文分词,分词就是将连续的字序列按照一定的规范重新组合成词序列的过程.我们知道,在英文的行文中,单词之间是以空格作为自然分界符的,而中文只是字.句和段能通过明显的分界符来简单划界,唯独词没有一个形式上 ...

- python中文分词:结巴分词

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词.其基本实现原理有三点: 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规 ...

- python 中文分词:结巴分词

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词.其基本实现原理有三点: 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规 ...

- Simple: SQLite3 中文结巴分词插件

一年前开发 simple 分词器,实现了微信在两篇文章中描述的,基于 SQLite 支持中文和拼音的搜索方案.具体背景参见这篇文章.项目发布后受到了一些朋友的关注,后续也发布了一些改进,提升了项目易用 ...

- 结巴分词和自然语言处理HanLP处理手记

手记实用系列文章: 1 结巴分词和自然语言处理HanLP处理手记 2 Python中文语料批量预处理手记 3 自然语言处理手记 4 Python中调用自然语言处理工具HanLP手记 5 Python中 ...

- python jieba分词(结巴分词)、提取词,加载词,修改词频,定义词库 -转载

转载请注明出处 “结巴”中文分词:做最好的 Python 中文分词组件,分词模块jieba,它是python比较好用的分词模块, 支持中文简体,繁体分词,还支持自定义词库. jieba的分词,提取关 ...

- 中文分词之结巴分词~~~附使用场景+demo(net)

常用技能(更新ing):http://www.cnblogs.com/dunitian/p/4822808.html#skill 技能总纲(更新ing):http://www.cnblogs.com/ ...

- Python 结巴分词(1)分词

利用结巴分词来进行词频的统计,并输出到文件中. 结巴分词github地址:结巴分词 结巴分词的特点: 支持三种分词模式: 精确模式,试图将句子最精确地切开,适合文本分析: 全模式,把句子中所有的可以成 ...

- 结巴(jieba)中文分词及其应用实践

中文文本分类不像英文文本分类一样只需要将单词一个个分开就可以了,中文文本分类需要将文字组成的词语分出来构成一个个向量.所以,需要分词. 这里使用网上流行的开源分词工具结巴分词(jieba),它可以有效 ...

随机推荐

- Java I/O 教程(二) 介绍OutputStream 和 InputStream

OutputStream vs InputStream 我们来看一下两者的工作图: OutputStream 输出流 Java应用程序使用输出流将数据写入到某个目的地,可以是一个文件,数组,外围设备或 ...

- Java并发编程实例--3.打断一个线程

一般来讲一个java程序如果运行着多个线程,那么只有在这些线程都运行完毕后才会终止. 但有时候,我们需要去结束某个线程或者取消某个任务.此时就用到了Java线程的打断机制,即interruption. ...

- 深入理解Go语言(08):sync.WaitGroup源码分析

一.sync.WaitGroup简介 1.1 sync.WaitGroup 解决了什么问题 在编程的时候,有时遇到一个大的任务,为了提高计算速度,会用到并发程序,把一个大的任务拆分成几个小的独立的任务 ...

- ThreadLocal的应用场景和注意事项有哪些?

https://cloud.tencent.com/developer/article/1618405

- HTTP1.0/HTTP1.1/HTTP2.0的演进

HTTP1.0 短连接,每次请求都需要重新建立连接 不支持断点续传 HTTP1.1 支持长连接,同一个客户端连接可保持长连接,请求可在连接中顺序发出. 查看http请求头中有keepalive 参数 ...

- 【Azure Redis 缓存】Redis连接无法建立问题的排查(注:Azure Redis集成在VNET中)

问题描述 在Azure App Service中部署的应用,需要连接到Redis中,目标Redis已经集成了虚拟网络(VNET)并且在Redis的网络防火墙中已经添加App Service的出站IP地 ...

- nebula-br local-store 模式,快速搭建主备集群实践

因为线上图数据库目前为单集群,数据量比较大,有以下缺点: 单点风险,一旦集群崩溃或者因为某些查询拖垮整个集群,就会导致所有图操作受影响 很多优化类但会影响读写的操作不好执行,比如:compact.ba ...

- 云原生基础设施实践:NebulaGraph 的 KubeBlocks 集成故事

像是 NebulaGraph 这类基础设施上云,通用的方法一般是将线下物理机替换成云端的虚拟资源,依托各大云服务厂商实现"服务上云".但还有一种选择,就是依托云数据基础设施,将数据 ...

- linux FTP服务搭建,匿名用户访问创建上传文件

1.安装vsftpd 首先确认本地是否安装vftpd rpm -qa|grep vftpd 安装vsftpd yum install vsftpd 为什么呢??因为写权限问题 root 用户. 这 ...

- python 字典列表,元组列表 列表嵌套字典 列表嵌套元组 字典嵌套列表

列表嵌套字典 l=[] for i in alist: kk = {} names.append(i.string) a_url.append(i.get('href')) kk['章节名']=i.s ...