scrapy的CrawlSpider类

了解CrawlSpider

踏实爬取一般网站的常用spider,其中定义了一些规则(rule)来提供跟进link的方便机制,也许该spider不适合你的目标网站,但是对于大多数情况是可以使用的。因此,可以以此为七点,根据需求修改部分方法,当然也可以实现自己的spider。

官方文档:http://scrapy-chs.readthedocs.io/zh_CN/0.24/topics/spiders.html#crawlspider

CrawlSpider的使用

简单使用

创建爬虫文件:scrapy genspider -t crawl "spider_name" "url"

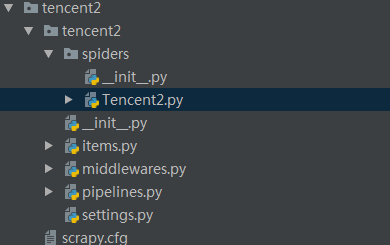

得到如下目录:

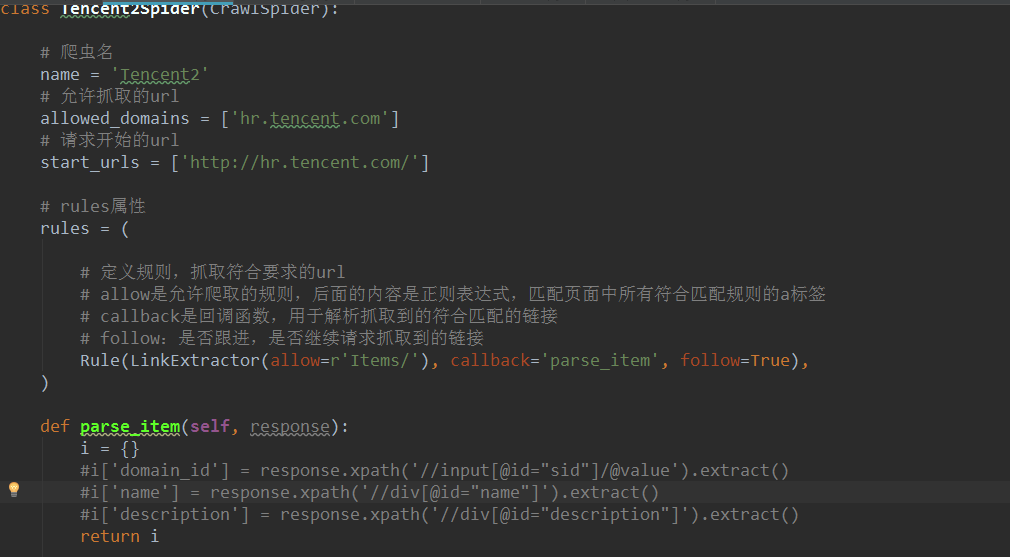

其中spider文件夹中的爬虫文件下的内容如下所示:

CrawlSpider是Spider的派生类,Spider类的设计原则是只爬取start_url列表中的网页,而CrawlSpider类中定义了一些规则(rule)来提取跟进link的方便机制,从而爬取的网页中获取link并继续爬取。

方法属性

Name:定义spider的名字

allow_domains:包含了spider允许抓起去的域名列表。

start_url:初始化url列表,当没有指定的url时,spider将从该列表中开始进行爬取。

start_requests(self):该方法返回一个可迭代对象,该对象包含了spider用于抓取的第一个request。

parse(self, resposne):默认的Request对象回调函数,用来处理返回的response,以及生成Items或者Request对象。

使用CralwSpider抓取数据

编写CrawlSpider,抓取腾讯招聘的信息,具体网页分析,见:

http://www.cnblogs.com/pythoner6833/p/9018782.html

具体代码如下:

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from tencent2.items import Tencent2Item, DetailsItem class Tencent2Spider(CrawlSpider): # 爬虫名

name = 'Tencent2'

# 允许抓取的url

allowed_domains = ['hr.tencent.com']

# 请求开始的url

start_urls = ['https://hr.tencent.com/position.php?'] # rules属性

rules = ( # 定义规则,抓取符合要求的url

# allow是允许爬取的规则,后面的内容是正则表达式,匹配页面中所有符合匹配规则的a标签

# callback是回调函数,用于解析抓取到的符合匹配的链接

# follow:是否跟进,是否继续请求抓取到的链接

Rule(LinkExtractor(allow=r'start=\d+'), callback='parse_tencent', follow=True), #编写匹配详情页的规则,抓取到详情页的链接后不用跟进

Rule(LinkExtractor(allow=r'position_detail\.php\?id=\d+'), callback='parse_detail', follow=False),

) def parse_tencent(self, response):

# 获取页面中招聘信息在网页中位置节点

node_list = response.xpath('//tr[@class="even"] | //tr[@class="odd"]') # 遍历节点,进入详情页,获取其他信息

for node in node_list:

# 实例化,填写数据

item = Tencent2Item() item['position_name'] = node.xpath('./td[1]/a/text()').extract_first()

item['position_link'] = node.xpath('./td[1]/a/@href').extract_first()

item['position_type'] = node.xpath('./td[2]/text()').extract_first()

item['wanted_number'] = node.xpath('./td[3]/text()').extract_first()

item['work_location'] = node.xpath('./td[4]/text()').extract_first()

item['publish_time'] = node.xpath('./td[5]/text()').extract_first() yield item def parse_detail(self, response):

"""

解析详情页数据

:param response:

:return:

"""

item = DetailsItem()

# 从详情页获取工作责任和工作技能两个字段名

item['work_duties'] = ''.join(response.xpath('//ul[@class="squareli"]')[0].xpath('./li/text()').extract())

item['work_skills'] = ''.join(response.xpath('//ul[@class="squareli"]')[1].xpath('./li/text()').extract())

yield item

其他部分,包括items.py和数据保存的pipelines.py里的代码编写和上文中链接里的已解释。

scrapy的CrawlSpider类的更多相关文章

- Scrapy框架——CrawlSpider类爬虫案例

Scrapy--CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 此案例采用的是CrawlSpider类实现爬虫. 它是Spider的派生类,Spide ...

- python爬虫入门(八)Scrapy框架之CrawlSpider类

CrawlSpider类 通过下面的命令可以快速创建 CrawlSpider模板 的代码: scrapy genspider -t crawl tencent tencent.com CrawSpid ...

- Scrapy的Spider类和CrawlSpider类

Scrapy shell 用来调试Scrapy 项目代码的 命令行工具,启动的时候预定义了Scrapy的一些对象 设置 shell Scrapy 的shell是基于运行环境中的python 解释器sh ...

- scrapy项目4:爬取当当网中机器学习的数据及价格(CrawlSpider类)

scrapy项目3中已经对网页规律作出解析,这里用crawlspider类对其内容进行爬取: 项目结构与项目3中相同如下图,唯一不同的为book.py文件 crawlspider类的爬虫文件book的 ...

- Scrapy框架-CrawlSpider

目录 1.CrawlSpider介绍 2.CrawlSpider源代码 3. LinkExtractors:提取Response中的链接 4. Rules 5.重写Tencent爬虫 6. Spide ...

- 13.CrawlSpider类爬虫

1.CrawlSpider介绍 Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 此案例采用的是CrawlSpider类实现爬虫. 它是Spider的派生类,Spider类的设 ...

- 全栈爬取-Scrapy框架(CrawlSpider)

引入 提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法 ...

- Scrapy框架——CrawlSpider爬取某招聘信息网站

CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 它是Spider的派生类,Spider类的设计原则是只爬取start_url列表中的网页, 而Craw ...

- python爬虫之Scrapy框架(CrawlSpider)

提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬去进行实现的(Request模块回调) 方法二:基于CrawlSpi ...

随机推荐

- Java多线程编程(一)Java多线程技能

一.进程和多线程的概念以及线程的优点 打开Windo任务管理器可以看到很多正在运行着的exe程序,完全可以将运行在内存中的exe文件理解成进程,进程是受操作系统管理的基本运行单元. 线程可以理解成在进 ...

- Redis(九)哨兵:Redis Sentinel

Redis的主从复制模式下,一旦主节点由于故障不能提供服务,需要人工将从节点晋升为主节点,同时还要通知应用方更新主节点地址,对于很多应用场景这种故障处理的方式是无法接受的. Redis从2.8开始正式 ...

- Modbus协议笔记

读线圈:就是说读开关量输出的状态,看看开关量输出的到底是开着的还是关着的,这样说有点不专业,但是好明白.比如要在上位机显示开关量输出的当状态,就得用这个功能码. 写线圈:就是说读开关量输入的状态,开关 ...

- node-批量上传文件

很多项目可能都会涉及到的业务是关于多文件上传的,那么需要使用到redis或者第三方库(使用redis)来实现任务队列,甚至需要控制并发量和分包(一次请求传多个文件),这样每次都会以实现功能来完成,但是 ...

- python中基本运算符

基本运算符 a // b 取整 a % b 取余 a ** b a 的b次方 a == b 判断运算符左右两边值是否相等 a != b 判断运算符左右两边值是否不等 a > b a >= ...

- 工厂模式(C++)

转载来源:https://www.runoob.com/design-pattern/ 工厂模式 创建型模式,它提供了一种创建对象的最佳方式. 在工厂模式中,我们在创建对象时不会对客户端暴露创建逻辑, ...

- CVE-2019-16097:Harbor任意管理员注册漏洞复现

0x00 Harbor简介 Harbor是一个用于存储和分发Docker镜像的企业级Registry服务器,通过添加一些企业必需的功能特性,例如安全.标识和管理等,扩展了开源Docker Distri ...

- numpy.array 基本操作

import numpy as np np.random.seed(0) x = np.arange(10) x """ array([0, 1, 2, 3, 4, 5, ...

- [考试反思]1011csp-s模拟测试69:无常

承蒙大脸skyh的毒奶,加之以被kx和Parisb以及板儿逼剥夺了一中午的睡眠(其实还有半个晚上)RP守恒终于失效了,连续两场没考好 RP也是不够了,竟然考原题,而且还不换题,连样例都一模一样只不过加 ...

- NOIP模拟测试36考试反思

这次考试..炸裂,归根到底是心态问题,考试的时候T1秒正解,但是调了三个小时死活没调出来,最后弃了,T2极水,没时间打了,T3题看都没看,总而言之就是不行. 教练说的对,一时强不一定一直强,心态其实也 ...