用go语言爬取珍爱网 | 第二回

昨天我们一起爬取珍爱网首页,拿到了城市列表页面,接下来在返回体城市列表中提取城市和url,即下图中的a标签里的href的值和innerText值。

提取a标签,可以通过CSS选择器来选择,如下:

$('#cityList>dd>a');就可以获取到470个a标签:

这里只提供一个思路,go语言标准库里没有CSS解析库,通过第三方库可以实现。具体可以参考文章:

https://my.oschina.net/2xixi/blog/488811

http://liyangliang.me/posts/2016/03/zhihu-go-insight-parsing-html-with-goquery/

这两篇文章都是用goquery解析 HTML,用到了库:

https://github.com/PuerkitoBio/goquery

也可以用xpath去解析html,可以参考:

https://github.com/antchfx/xquery

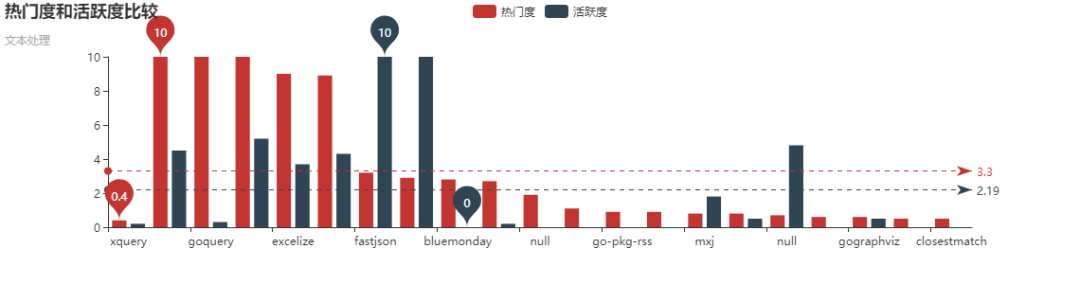

xpath和goquery相比还是比较麻烦的,通过以下这张图可以看出来goquery要活跃的多:

我们这里不用xpath,也不用goquery提取,用更加通用的正则表达式来提取。

从上图可以看出,返回体中的a标签里都是这种形式,XXX表示城市拼音,XX表示城市中文,其他的都一样。

<a href="http://www.zhenai.com/zhenghun/XXX"

class="">XX</a>

所以可以写出以下的正则表达式来匹配:

compile := regexp.MustCompile(`<a href="http://www.zhenai.com/zhenghun/[0-9a-z]+"[^>]*>[^<]+</a>`)

正则表达式说明:

1、href的值都类似http://www.zhenai.com/zhenghun/XX

2、XX可以是数字和小写字母,所以[0-9a-z],+表示至少有一个

3、[^>]*表示匹配不是>的其他字符任意次

4、[^<]+表示匹配不是<的其他字符至少一次

然后利用分组获取url和城市,代码如下:

func printAllCityInfo(body []byte){

//href的值都类似http://www.zhenai.com/zhenghun/XX

//XX可以是数字和小写字母,所以[0-9a-z],+表示至少有一个

//[^>]*表示匹配不是>的其他字符任意次

//[^<]+表示匹配不是<的其他字符至少一次

compile := regexp.MustCompile(`<a href="(http://www.zhenai.com/zhenghun/[0-9a-z]+)"[^>]*>([^<]+)</a>`)

submatch := compile.FindAllSubmatch(body, -1)

for _, matches := range submatch {

//打印

fmt.Printf("City:%s URL:%s\n", matches[2], matches[1])

}

//可以看到匹配个数为470个

fmt.Printf("Matches count: %d\n", len(submatch))

}

那么提取URL和City的完整代码如下:

package main

import (

"fmt"

"io/ioutil"

"net/http"

"golang.org/x/text/transform"

//"golang.org/x/text/encoding/simplifiedchinese"

"io"

"golang.org/x/text/encoding"

"bufio"

"golang.org/x/net/html/charset"

"regexp"

)

func main() {

//返送请求获取返回结果

resp, err := http.Get("http://www.zhenai.com/zhenghun")

if err != nil {

panic(fmt.Errorf("Error: http Get, err is %v\n", err))

}

//关闭response body

defer resp.Body.Close()

if resp.StatusCode != http.StatusOK {

fmt.Println("Error: statuscode is ", resp.StatusCode)

return

}

//utf8Reader := transform.NewReader(resp.Body, simplifiedchinese.GBK.NewDecoder())

utf8Reader := transform.NewReader(resp.Body, determinEncoding(resp.Body).NewDecoder())

body, err := ioutil.ReadAll(utf8Reader)

if err != nil {

fmt.Println("Error read body, error is ", err)

}

printAllCityInfo(body)

//打印返回值

//fmt.Println("body is ", string(body))

}

func determinEncoding(r io.Reader) encoding.Encoding {

//这里的r读取完得保证resp.Body还可读

body, err := bufio.NewReader(r).Peek(1024)

if err != nil {

fmt.Println("Error: peek 1024 byte of body err is ", err)

}

//这里简化,不取是否确认

e, _, _ := charset.DetermineEncoding(body, "")

return e

}

func printAllCityInfo(body []byte){

//href的值都类似http://www.zhenai.com/zhenghun/XX

//XX可以是数字和小写字母,所以[0-9a-z],+表示至少有一个

//[^>]*表示匹配不是>的其他字符任意次

//[^<]+表示匹配不是<的其他字符至少一次

compile := regexp.MustCompile(`<a href="(http://www.zhenai.com/zhenghun/[0-9a-z]+)"[^>]*>([^<]+)</a>`)

/*matches := compile.FindAll(body, -1)

//matches是二维数组[][]byte

for _, m := range matches {

fmt.Printf("%s\n", m)

}

*/

submatch := compile.FindAllSubmatch(body, -1)

//submatch是三维数组[][][]byte

/* for _, matches := range submatch {

//[][]byte

for _, m := range matches {

fmt.Printf("%s ", m)

}

fmt.Println()

}*/

for _, matches := range submatch {

//打印

fmt.Printf("City:%s URL:%s\n", matches[2], matches[1])

}

//可以看到匹配个数为470个

fmt.Printf("Matches count: %d\n", len(submatch))

//打印abc

//fmt.Printf("%s\n", []byte{97,98,99})

}

运行后,可以看到输出了URL和City:

今天我们完成了URL和城市的提取,明天我们将利用URL,来进一步分析城市的男女性个人信息。

本公众号免费提供csdn下载服务,海量IT学习资源,如果你准备入IT坑,励志成为优秀的程序猿,那么这些资源很适合你,包括但不限于java、go、python、springcloud、elk、嵌入式 、大数据、面试资料、前端 等资源。同时我们组建了一个技术交流群,里面有很多大佬,会不定时分享技术文章,如果你想来一起学习提高,可以公众号后台回复【2】,免费邀请加技术交流群互相学习提高,会不定期分享编程IT相关资源。

扫码关注,精彩内容第一时间推给你

用go语言爬取珍爱网 | 第二回的更多相关文章

- 用go语言爬取珍爱网 | 第一回

我们来用go语言爬取"珍爱网"用户信息. 首先分析到请求url为: http://www.zhenai.com/zhenghun 接下来用go请求该url,代码如下: packag ...

- 用go语言爬取珍爱网 | 第三回

前两节我们获取到了城市的URL和城市名,今天我们来解析用户信息. 用go语言爬取珍爱网 | 第一回 用go语言爬取珍爱网 | 第二回 爬虫的算法: 我们要提取返回体中的城市列表,需要用到城市列表解析器 ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- GoLang爬取花瓣网美女图片

由于之前一直想爬取花瓣网(http://huaban.com/partner/uc/aimeinv/pins/) 的图片,又迫于没时间,所以拖了很久. 鉴于最近在学go语言,就刚好用这个练手了. 预览 ...

- 网络爬虫之定向爬虫:爬取当当网2015年图书销售排行榜信息(Crawler)

做了个爬虫,爬取当当网--2015年图书销售排行榜 TOP500 爬取的基本思想是:通过浏览网页,列出你所想要获取的信息,然后通过浏览网页的源码和检查(这里用的是chrome)来获相关信息的节点,最后 ...

- 使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- Node.js爬虫-爬取慕课网课程信息

第一次学习Node.js爬虫,所以这时一个简单的爬虫,Node.js的好处就是可以并发的执行 这个爬虫主要就是获取慕课网的课程信息,并把获得的信息存储到一个文件中,其中要用到cheerio库,它可以让 ...

- python 爬虫之爬取大街网(思路)

由于需要,本人需要对大街网招聘信息进行分析,故写了个爬虫进行爬取.这里我将记录一下,本人爬取大街网的思路. 附:爬取得数据仅供自己分析所用,并未用作其它用途. 附:本篇适合有一定 爬虫基础 crawl ...

- 基于爬取百合网的数据,用matplotlib生成图表

爬取百合网的数据链接:http://www.cnblogs.com/YuWeiXiF/p/8439552.html 总共爬了22779条数据.第一次接触matplotlib库,以下代码参考了matpl ...

随机推荐

- 数据库常用SQL语句(三):子查询

一.为什么会使用子查询 虽然可以通过连接查询来实现多表查询数据记录,但不建议使用,因为连接查询的性能很差,为什么呢?我们来进行分析,例如 我们要查询部门表t_dept 和雇员表t_employee中的 ...

- python安装第三方包的安装路径, dist-packages和site-packages区别

简单来说 如果是系统自带的python,会使用dist-packages目录 如果你手动安装python,它会直接使用目录site-packages 这允许你让两个安装隔离开来 dist-packag ...

- .NET Core 获取请求类容(body)

.Net Core 对于body多次读取,开放了一个参数EnableRewind(),该参数在第一次读取body之前开启,之后body信息可以多次读取:core时代取消了之前的stream.posit ...

- [VB.NET Tips]VB.NET专有的字符串处理函数

.NET Framework类库中含有专门为Visual Basic.NET程序员设计的函数和过程. 这些方法虽然是为VB.NET程序员设计的,但是也可以被.NET Framework上支持的任何语言 ...

- 【linux】【elasticsearch】docker部署elasticsearch及elasticsearch-head

前言 Elasticsearch是一个基于Apache Lucene(TM)的开源搜索引擎.无论在开源还是专有领域,Lucene可以被认为是迄今为止最先进.性能最好的.功能最全的搜索引擎库.但是,Lu ...

- sql server 建表,主键与外键约束

主键: 能唯一区分表中每一行 外键:为某表的一列,是另一个表的主键,外键定义了两表之间的联系 商品类别表 use eshopgocreate table category( name varchar( ...

- WordPress对接微信小程序遇到的问题

1.文章内容中的“<”和“>”字符显示问题 小程序是使用“wxPares工具来实现html转wxml的,如果你的文本包含了代码比如xml会携带<>符号,程序会将其转化,造成解析 ...

- 暑期——第八周总结(1,安装好hadoop之后访问http://localhost:50070,无法连接【已解决】 2,Hbase命令详解)

所花时间:7天 代码行:800(Java) 博客量:1篇 了解到知识点 : 一:http://localhost:50070无法访问 安装好hadoop之后 输入所有东西都有 可就是访问50070无法 ...

- 针对媒体不实报道误导大众--抹黑C#工资垫底

最近注意到一些媒体故意抹黑C# 工资垫底,参见 https://www.toutiao.com/i6741889572931633668/: 通过搜索引擎搜索<编程语言薪酬排行:Python薪资 ...

- redis-分片(转)

转:https://www.cnblogs.com/houziwty/p/5167075.html 分片(partitioning)就是将你的数据拆分到多个 Redis 实例的过程,这样每个实例将只包 ...