spark-2.4.0-hadoop2.7-简单操作

1. 说明

本文基于:spark-2.4.0-hadoop2.7-高可用(HA)安装部署

2. 启动Spark Shell

在任意一台有spark的机器上执行

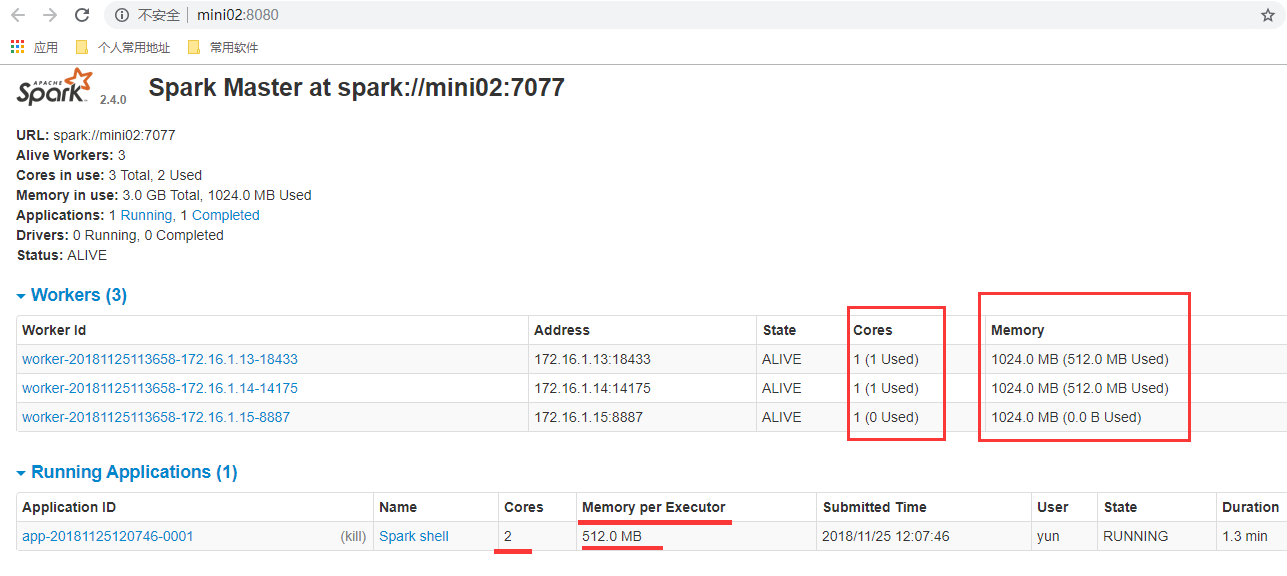

# --master spark://mini02:7077 连接spark的master,这个master的状态为alive,而不是standby

# --total-executor-cores 总共占用2核CPU

# --executor-memory 512m 每个woker占用512m内存

[yun@mini03 ~]$ spark-shell --master spark://mini02:7077 --total-executor-cores 2 --executor-memory 512m

-- :: WARN NativeCodeLoader: - Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel). For SparkR, use setLogLevel(newLevel).

Spark context Web UI available at http://mini03:4040

Spark context available as 'sc' (master = spark://mini02:7077, app id = app-20181125120746-0001).

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.4.

/_/ Using Scala version 2.11. (Java HotSpot(TM) -Bit Server VM, Java 1.8.0_112)

Type in expressions to have them evaluated.

Type :help for more information. scala> sc

res0: org.apache.spark.SparkContext = org.apache.spark.SparkContext@77e1b84c

注意:

如果启动spark shell时没有指定master地址,但是也可以正常启动spark shell和执行spark shell中的程序,其实是启动了spark的local模式,该模式仅在本机启动一个进程,没有与集群建立联系。

2.1. 相关截图

3. 执行第一个spark程序

该算法是利用蒙特•卡罗算法求PI

[yun@mini03 ~]$ spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://mini02:7077 \

--total-executor-cores \

--executor-memory 512m \

/app/spark/examples/jars/spark-examples_2.-2.4..jar

# 打印的信息如下:

-- :: WARN NativeCodeLoader: - Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

-- :: INFO SparkContext: - Running Spark version 2.4.

………………

-- :: INFO TaskSetManager: - Finished task 97.0 in stage 0.0 (TID ) in ms on 172.16.1.14 (executor ) (/)

-- :: INFO TaskSetManager: - Finished task 98.0 in stage 0.0 (TID ) in ms on 172.16.1.13 (executor ) (/)

-- :: INFO TaskSetManager: - Finished task 99.0 in stage 0.0 (TID ) in ms on 172.16.1.14 (executor ) (/)

-- :: INFO TaskSchedulerImpl: - Removed TaskSet 0.0, whose tasks have all completed, from pool

-- :: INFO DAGScheduler: - ResultStage (reduce at SparkPi.scala:) finished in 3.881 s

-- :: INFO DAGScheduler: - Job finished: reduce at SparkPi.scala:, took 4.042591 s

Pi is roughly 3.1412699141269913

………………

4. Spark shell求Word count 【结合Hadoop】

1、启动Hadoop

2、将文件放到Hadoop中

[yun@mini05 sparkwordcount]$ cat wc.info

zhang linux

linux tom

zhan kitty

tom linux

[yun@mini05 sparkwordcount]$ hdfs dfs -ls /

Found items

drwxr-xr-x - yun supergroup -- : /hbase

drwx------ - yun supergroup -- : /tmp

drwxr-xr-x - yun supergroup -- : /wordcount

-rw-r--r-- yun supergroup -- : /zookeeper-3.4..tar.gz

[yun@mini05 sparkwordcount]$ hdfs dfs -mkdir -p /sparkwordcount/input

[yun@mini05 sparkwordcount]$ hdfs dfs -put wc.info /sparkwordcount/input/.info

[yun@mini05 sparkwordcount]$ hdfs dfs -put wc.info /sparkwordcount/input/.info

[yun@mini05 sparkwordcount]$ hdfs dfs -put wc.info /sparkwordcount/input/.info

[yun@mini05 sparkwordcount]$ hdfs dfs -put wc.info /sparkwordcount/input/.info

[yun@mini05 sparkwordcount]$ hdfs dfs -ls /sparkwordcount/input

Found items

-rw-r--r-- yun supergroup -- : /sparkwordcount/input/.info

-rw-r--r-- yun supergroup -- : /sparkwordcount/input/.info

-rw-r--r-- yun supergroup -- : /sparkwordcount/input/.info

-rw-r--r-- yun supergroup -- : /sparkwordcount/input/.info

3、进入spark shell命令行,并计算

[yun@mini03 ~]$ spark-shell --master spark://mini02:7077 --total-executor-cores 2 --executor-memory 512m

# 计算完毕后,打印在命令行

scala> sc.textFile("hdfs://mini01:9000/sparkwordcount/input").flatMap(_.split(" ")).map((_, )).reduceByKey(_+_).sortBy(_._2, false).collect

res6: Array[(String, Int)] = Array((linux,), (tom,), (kitty,), (zhan,), ("",), (zhang,))

# 计算完毕后,保存在HDFS【因为有多个文件组成,则有多个reduce,所以输出有多个文件】

scala> sc.textFile("hdfs://mini01:9000/sparkwordcount/input").flatMap(_.split(" ")).map((_, )).reduceByKey(_+_).sortBy(_._2, false).saveAsTextFile("hdfs://mini01:9000/sparkwordcount/output")

# 计算完毕后,保存在HDFS【将reduce设置为1,输出就只有一个文件】

scala> sc.textFile("hdfs://mini01:9000/sparkwordcount/input").flatMap(_.split(" ")).map((_, )).reduceByKey(_+_, ).sortBy(_._2, false).saveAsTextFile("hdfs://mini01:9000/sparkwordcount/output1")

4、在HDFS的查看结算结果

[yun@mini05 sparkwordcount]$ hdfs dfs -ls /sparkwordcount/

Found items

drwxr-xr-x - yun supergroup -- : /sparkwordcount/input

drwxr-xr-x - yun supergroup -- : /sparkwordcount/output

drwxr-xr-x - yun supergroup -- : /sparkwordcount/output1

[yun@mini05 sparkwordcount]$ hdfs dfs -ls /sparkwordcount/output

Found items

-rw-r--r-- yun supergroup -- : /sparkwordcount/output/_SUCCESS

-rw-r--r-- yun supergroup -- : /sparkwordcount/output/part-

-rw-r--r-- yun supergroup -- : /sparkwordcount/output/part-

-rw-r--r-- yun supergroup -- : /sparkwordcount/output/part-

-rw-r--r-- yun supergroup -- : /sparkwordcount/output/part-

[yun@mini05 sparkwordcount]$

[yun@mini05 sparkwordcount]$ hdfs dfs -cat /sparkwordcount/output/part*

(linux,)

(tom,)

(,)

(zhang,)

(kitty,)

(zhan,)

###############################################

[yun@mini05 sparkwordcount]$ hdfs dfs -ls /sparkwordcount/output1

Found items

-rw-r--r-- yun supergroup -- : /sparkwordcount/output1/_SUCCESS

-rw-r--r-- yun supergroup -- : /sparkwordcount/output1/part-

[yun@mini05 sparkwordcount]$ hdfs dfs -cat /sparkwordcount/output1/part-

(linux,)

(tom,)

(,)

(zhang,)

(kitty,)

(zhan,)

spark-2.4.0-hadoop2.7-简单操作的更多相关文章

- spark编译安装 spark 2.1.0 hadoop2.6.0-cdh5.7.0

1.准备: centos 6.5 jdk 1.7 Java SE安装包下载地址:http://www.oracle.com/technetwork/java/javase/downloads/java ...

- Spark学习笔记0——简单了解和技术架构

目录 Spark学习笔记0--简单了解和技术架构 什么是Spark 技术架构和软件栈 Spark Core Spark SQL Spark Streaming MLlib GraphX 集群管理器 受 ...

- spark sql的简单操作

测试数据 sparkStu.text zhangxs chenxy wangYr teacher wangx teacher sparksql { ,"job":"che ...

- moloch1.8.0简单操作手册

moloch1.8.0简单操作手册 Sessions 页面:Sessions主要通过非常简单的查询语言来构建表达式追溯数据流量,以便分析. SPIView 页面: SPIGraph页面:SPIGrap ...

- spark 1.1.0 单机与yarn部署

环境:ubuntu 14.04, jdk 1.6, scala 2.11.4, spark 1.1.0, hadoop 2.5.1 一 spark 单机模式 部分操作参考:http://www.cnb ...

- Spark快速入门 - Spark 1.6.0

Spark快速入门 - Spark 1.6.0 转载请注明出处:http://www.cnblogs.com/BYRans/ 快速入门(Quick Start) 本文简单介绍了Spark的使用方式.首 ...

- Apache Spark 2.2.0 中文文档 - Spark 编程指南 | ApacheCN

Spark 编程指南 概述 Spark 依赖 初始化 Spark 使用 Shell 弹性分布式数据集 (RDDs) 并行集合 外部 Datasets(数据集) RDD 操作 基础 传递 Functio ...

- Apache Spark 2.2.0 中文文档 - Spark Streaming 编程指南 | ApacheCN

Spark Streaming 编程指南 概述 一个入门示例 基础概念 依赖 初始化 StreamingContext Discretized Streams (DStreams)(离散化流) Inp ...

- Apache Spark 2.2.0 中文文档 - Spark SQL, DataFrames and Datasets Guide | ApacheCN

Spark SQL, DataFrames and Datasets Guide Overview SQL Datasets and DataFrames 开始入门 起始点: SparkSession ...

- Apache Spark 2.2.0 中文文档 - SparkR (R on Spark) | ApacheCN

SparkR (R on Spark) 概述 SparkDataFrame 启动: SparkSession 从 RStudio 来启动 创建 SparkDataFrames 从本地的 data fr ...

随机推荐

- 你可能不知道的css-doodle

好久没写文章了,下笔突然陌生了许多. 第一个原因是刚找到一份前端的工作,业务上都需要尽快的了解,第二个原因就是懒还有拖延的习惯,一旦今天没有写文章,就由可能找个理由托到下一周,进而到了下一周又有千万条 ...

- Chapter 5 Blood Type——28

Mike came through the door then, glancing from me to Edward. 然后Mike从门里走出来,看了一眼我和Edward The look he g ...

- 补习系列(6)- springboot 整合 shiro 一指禅

目标 了解ApacheShiro是什么,能做什么: 通过QuickStart 代码领会 Shiro的关键概念: 能基于SpringBoot 整合Shiro 实现URL安全访问: 掌握基于注解的方法,以 ...

- #12 Python函数

前言 矩形的面积 S = ab,只要知道任一矩形的的长和宽,就可以带入上式求得面积.这样有什么好处呢?一个公式,适用于全部矩形,一个公式,重复利用,减少了大脑的记忆负担.像这类用变量代替不变量的思想在 ...

- 第13章 切换到混合流并添加API访问 - Identity Server 4 中文文档(v1.0.0)

在之前的快速入门中,我们探讨了API访问和用户身份验证.现在我们想把这两个部分放在一起. OpenID Connect和OAuth 2.0组合的优点在于,您可以使用单个协议和使用令牌服务进行单次交换来 ...

- ElasticSearch入门点滴

这是Elasticsearch-6.2.4 版本系列的第一篇: ElasticSearch入门 第一篇:Windows下安装ElasticSearch ElasticSearch入门 第二篇:集群配置 ...

- 31.C++-虚函数之构造函数与析构函数分析

1.构造函数不能为虚函数 当我们将构造函数定义为虚函数时,会直接报错: 首先回忆下以前学的virtual虚函数概念: 如果类定义了虚函数,创建对象时,则会分配内存空间,并且为该父类以及其所有子类的内存 ...

- Java高阶语法---Volatile

背景:听说Volatile Java高阶语法亦是挺进BAT的必经之路. Volatile: volatile同步机制又涉及Java内存模型中的可见性.原子性和有序性,恶补基础一波. 可见性: 可见性简 ...

- Html和Css学习笔记-css进阶-盒模型

我的邮箱地址:zytrenren@163.com欢迎大家交流学习纠错! 此篇博客是我的复习笔记,html和css学的时间太久了,忘得差不多了,最近要使用一下,所以重新打开html的书略读,后记录了标签 ...

- JavaScript知识点 思维导图

javascript变量 javascript数据类型 javascript运算符 javascript流程语句 javascript数组 javascript字符串函数 javascript函数基础 ...