Spark:java api读取hdfs目录下多个文件

需求:

由于一个大文件,在spark中加载性能比较差。于是把一个大文件拆分为多个小文件后上传到hdfs,然而在spark2.2下如何加载某个目录下多个文件呢?

public class SparkJob {

public static void main(String[] args) {

String filePath = args[0];

// initialize spark session

String appName = "Streaming-MRO-Load-Multiple-CSV-Files-Test";

SparkSession sparkSession = SparkHelper.getInstance().getAndConfigureSparkSession(appName);

// reader multiple csv files.

try {

Dataset<Row> rows = sparkSession.read().option("delimiter", "|").option("header", false)

.csv(filePath).toDF(getNCellSchema());

rows.show(10);

} catch (Exception ex) {

ex.printStackTrace();

}

try {

Dataset<String> rows = sparkSession.read().textFile(filePath);

rows.show(10);

} catch (Exception ex) {

ex.printStackTrace();

}

SparkHelper.getInstance().dispose();

}

private static Seq<String> getNCellSchema() {

List<String> ncellColumns = "m_id,m_eid,m_int_id,.....";

List<String> columns = new ArrayList<String>();

for (String column : ncellColumns) {

columns.add(column);

}

Seq<String> columnsSet = JavaConversions.asScalaBuffer(columns);

return columnsSet;

}

}

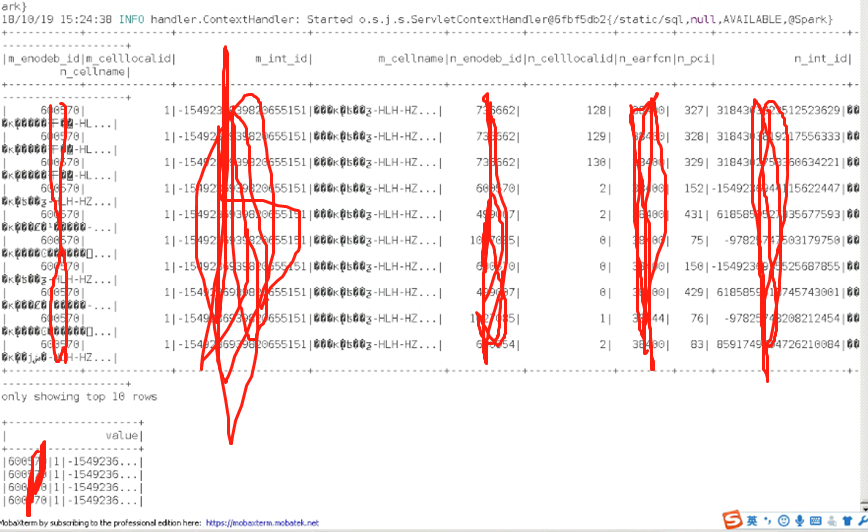

测试结果:

Spark:java api读取hdfs目录下多个文件的更多相关文章

- Java中读取某个目录下的所有文件和文件夹

import java.io.File; public class Test1 { public static void main(String[] args) { String path=" ...

- 使用JAVA API读取HDFS的文件数据出现乱码的解决方案

使用JAVA api读取HDFS文件乱码踩坑 想写一个读取HFDS上的部分文件数据做预览的接口,根据网上的博客实现后,发现有时读取信息会出现乱码,例如读取一个csv时,字符串之间被逗号分割 英文字符串 ...

- [转]读取assets目录下的数据库文件

在做Android应用的时候,不可避免要用到数据库.但是当我们把应用的apk部署到真机上的时候,已经创建好的数据库及其里边的数据是不能随着apk一起安装到真机上的. (PS:这篇博客解决了我前面博客中 ...

- java获取ubuntu某个目录下的所有文件信息

java获取ubuntu某个目录下的所有文件信息 public List<VCFile> getAllFiles(String basicDirName) { List<VCFile ...

- Python读取指定目录下指定后缀文件并保存为docx

最近有个奇葩要求 要项目中的N行代码 申请专利啥的 然后作为程序员当然不能复制粘贴 用代码解决.. 使用python-docx读写docx文件 环境使用python3.6.0 首先pip安装pytho ...

- 遍历并读取指定目录下的所有文件内容,写入Map集合然后输出在控制台和本地文件

public class FileWrite { public static void main(String[] args) throws Exception { //封装数据源目录 File sr ...

- Python读取一个目录下的所有文件

#!/usr/bin/python # -*- coding:utf8 -*- import os allFileNum = 0 def printPath(level, path): global ...

- Java API 读取HDFS的单文件

HDFS上的单文件: -bash-3.2$ hadoop fs -ls /user/pms/ouyangyewei/data/input/combineorder/repeat_rec_categor ...

- java 实现读取某个目录下指定类型的文件

我这里是读取txt类型的文件,在指定的目录下有不同类型的文件 实现代码,读取txt类型的文件并打印出该文件的绝对路径 package com.SBgong.test; import java.io.F ...

随机推荐

- java多线程快速入门(七)

什么是守护线程 守护线程是为用户线程服务的这么一个线程,主线程结束,守护线程也结束 package com.cppdy; class MyThread3 extends Thread{ @Overri ...

- java uitl

Random类 //生成随机数 https://i.cnblogs.com/EditPosts.aspx?opt=1

- CSS3:HSL和HSLA

<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8" ...

- mysql操作查询结果case when then用法举例

举例1: 使用该查询,得出iFavoriteID,iFavUserType ,cUser,iArticleID,dFavoriteTime五个字段的值: SELECT iFavoriteID,CASE ...

- A. 【UR #16】破坏发射台

题解: 首先看n是偶数的 那么就是不需要满足对面这个性质的 这样就可以dp了 f[i][0/1]表示dp到第i位,当前数等于或不等于第一位的方案数 然后显然可以用矩阵优化 再考虑n为奇数 用一样的思路 ...

- SQL存储过程使用参考代码

存储过程 use EBuy go --常用的系统存储过程 sp_addmessage --将新的用户定义错误消息存储在SQL Server数据库实例中 sp_helptext --显示用 ...

- HDU2473 Junk-Mail Filter 并查集

欢迎访问~原文出处——博客园-zhouzhendong 去博客园看该题解 题目传送门 - HDU2473 题意概括 一堆点. 要你支持合并两组点.分离某组点中的一个,这两种操作. 点数<=100 ...

- 第四章: 4.1 logging模块 | 正则表达式

修改json数据然后写入json文件中 f = open('1234.json','r',encoding='utf-8') data = f.read() data1 = json.loads(da ...

- 017 SpringMVC中CRUD实例

一:新建项目(下面的几乎属于公共的方法,不需要改动) 1.结构 2.添加lib 3.配置web.xml <?xml version="1.0" encoding=" ...

- Python开发之pip使用详解

1 pip的优点 pip如今已经成为了Python的一大特色,可以很方便得协助Python开发者进行包管理.综合来说,匹配拥有如下优点: pip提供了丰富的功能,其竞争对手easy_install只支 ...