2023-03-21:音视频解混合(demuxer)为MP3和H264,用go语言编写。

2023-03-21:音视频解混合(demuxer)为MP3和H264,用go语言编写。

答案2023-03-21:

步骤1:安装github.com/moonfdd/ffmpeg-go

go get -u github.com/moonfdd/ffmpeg-go

步骤2:导入所需的库

接下来,我们需要导入所需的库。这些库包括fmt、os、exec以及FFmpeg库中的libavcodec、libavdevice、libavformat和libavutil。在本教程中,我们还将使用moonfdd/ffmpeg-go库,该库提供了一些便捷的函数和类型定义,可帮助我们更轻松地使用FFmpeg库。

package main

import (

"fmt"

"os"

"os/exec"

"github.com/moonfdd/ffmpeg-go/ffcommon"

"github.com/moonfdd/ffmpeg-go/libavcodec"

"github.com/moonfdd/ffmpeg-go/libavdevice"

"github.com/moonfdd/ffmpeg-go/libavformat"

"github.com/moonfdd/ffmpeg-go/libavutil"

)

步骤3:设置FFmpeg库路径

在使用FFmpeg库之前,我们需要设置FFmpeg库的路径。您可以通过设置环境变量来实现这一点,也可以直接调用FFmpeg库的SetXxxPath函数进行设置。

// 设置环境变量

os.Setenv("Path", os.Getenv("Path")+";./lib")

// 设置FFmpeg库路径

ffcommon.SetAvutilPath("./lib/avutil-56.dll")

ffcommon.SetAvcodecPath("./lib/avcodec-58.dll")

ffcommon.SetAvdevicePath("./lib/avdevice-58.dll")

ffcommon.SetAvfilterPath("./lib/avfilter-56.dll")

ffcommon.SetAvformatPath("./lib/avformat-58.dll")

ffcommon.SetAvpostprocPath("./lib/postproc-55.dll")

ffcommon.SetAvswresamplePath("./lib/swresample-3.dll")

ffcommon.SetAvswscalePath("./lib/swscale-5.dll")

步骤4:定义必要的变量

在使用FFmpeg库之前,我们需要定义一些必要的变量。这些变量包括输入文件名、输出音频文件名、输出视频文件名、输入格式上下文、输出音频格式上下文、输出视频格式上下文、AVPacket等。在本教程中,我们还定义了用于保存视频索引和音频索引的变量。

var ifmtCtx, ofmtCtxAudio, ofmtCtxVideo *libavformat.AVFormatContext

var packet libavcodec.AVPacket

var videoIndex ffcommon.FInt = -1

var audioIndex ffcommon.FInt = -1

var ret ffcommon.FInt = 0

inFileName := "./resources/big_buck_bunny.mp4"

outFilenameAudio := "./out/a22.aac"

outFilenameVideo := "./out/a22.h264"

步骤5:注册设备

在使用FFmpeg库之前,我们需要先注册设备。您可以使用libavdevice.AvdeviceRegisterAll()函数来注册所有支持的设备。

libavdevice.AvdeviceRegisterAll()

步骤6:打开输入流

在从音视频文件中分离出音频和视频之前,我们需要打开音视频文件的输入流。您可以使用libavformat.AvformatOpenInput函数来打开输入流,并使用ifmtCtx参数保存输入流的上下文。

if libavformat.AvformatOpenInput(&ifmtCtx, inFileName, nil, nil) < 0 {

fmt.Printf("Could not open input file '%s'\n", inFileName)

return

}

defer ifmtCtx.AvformatCloseInput()

步骤7:读取媒体信息

打开输入流后,我们需要读取音视频文件的媒体信息。您可以使用libavformat.AvformatFindStreamInfo函数来读取媒体信息,并使用libavutil.AvDumpFormat函数将媒体信息输出到控制台。

if ifmtCtx.AvformatFindStreamInfo(nil) < 0 {

fmt.Println("Could not find stream information")

return

}

libavutil.AvDumpFormat(ifmtCtx, 0, inFileName, 0)

步骤8:查找音频和视频流

在读取媒体信息后,我们需要查找音频和视频流。您可以使用libavformat.AvformatFindStreamInfo函数来查找音频和视频流,并使用videoIndex和audioIndex变量保存视频流和音频流的索引。

for i := 0; i < int(ifmtCtx.NbStreams()); i++ {

codecParams := ifmtCtx.Streams()[i].CodecParameters()

codecType := codecParams.AvCodecGetType()

switch codecType {

case libavutil.AVMEDIA_TYPE_VIDEO:

if videoIndex == -1 {

videoIndex = ffcommon.FInt(i)

}

case libavutil.AVMEDIA_TYPE_AUDIO:

if audioIndex == -1 {

audioIndex = ffcommon.FInt(i)

}

}

}

if videoIndex == -1 || audioIndex == -1 {

fmt.Println("Could not find video or audio stream")

return

}

步骤9:打开输出流

在查找音频和视频流后,我们需要打开输出流,以便将分离出的音频和视频写入文件。您可以使用libavformat.AvformatAllocOutputContext2函数创建输出格式上下文,并使用ofmtCtxAudio和ofmtCtxVideo变量保存输出格式上下文。

// 打开输出音频流

if ofmtCtxAudio = libavformat.AvformatAllocOutputContext2(nil, nil, "", outFilenameAudio); ofmtCtxAudio == nil {

fmt.Printf("could not create output context for '%s'\n", outFilenameAudio)

return

}

// 打开输出视频流

if ofmtCtxVideo = libavformat.AvformatAllocOutputContext2(nil, nil, "h264", outFilenameVideo); ofmtCtxVideo == nil {

fmt.Printf("could not create output context for '%s'\n", outFilenameVideo)

return

}

步骤10:写入文件头

打开输出流后,我们需要写入文件头。您可以使用libavformat.AvformatWriteHeader函数来写入文件头。

// 写入音频文件头

if (ofmtCtxAudio.Oformat().Flags() & libavformat.AVFMT_NOFILE) == 0 {

if ret = ofmtCtxAudio.AvioOpen(nil, libavformat.AVIO_FLAG_WRITE); ret < 0 {

fmt.Printf("could not open output file '%s'\n", outFilenameAudio)

return

}

defer ofmtCtxAudio.AvioClose()

}

if ret = ofmtCtxAudio.AvformatWriteHeader(nil); ret < 0 {

fmt.Println("Could not write output file header")

return

}

// 写入视频文件头

if (ofmtCtxVideo.Oformat().Flags() & libavformat.AVFMT_NOFILE) == 0 {

if ret = ofmtCtxVideo.AvioOpen(nil, libavformat.AVIO_FLAG_WRITE); ret < 0 {

fmt.Printf("could not open output file '%s'\n", outFilenameVideo)

return

}

defer ofmtCtxVideo.AvioClose()

}

if ret = ofmtCtxVideo.AvformatWriteHeader(nil); ret < 0 {

fmt.Println("Could not write output file header")

return

}

步骤11:分离音频和视频

写入文件头后,我们可以开始分离音频和视频了。您可以使用libavformat.AvReadFrame函数读取音视频帧,并根据音频或视频流的索引将音频帧写入音频文件,将视频帧写入视频文件。

for {

if ret = ifmtCtx.AvReadFrame(&packet); ret <0 {

break

}

defer packet.AvPacketUnref()

if packet.StreamIndex() == audioIndex {

// 写入音频流

if ret = ofmtCtxAudio.AvInterleavedWriteFrame(&packet); ret < 0 {

fmt.Printf("error while writing audio frame: %v\n", ret)

return

}

} else if packet.StreamIndex() == videoIndex {

// 写入视频流

if ret = ofmtCtxVideo.AvInterleavedWriteFrame(&packet); ret < 0 {

fmt.Printf("error while writing video frame: %v\n", ret)

return

}

}

}

步骤12:写入文件尾

完成音视频分离后,我们需要写入文件尾。您可以使用libavformat.AvWriteTrailer函数来写入文件尾。

// 写入音频文件尾

if ret = ofmtCtxAudio.AvWriteTrailer(); ret < 0 {

fmt.Println("Could not write output file trailer")

return

}

// 写入视频文件尾

if ret = ofmtCtxVideo.AvWriteTrailer(); ret < 0 {

fmt.Println("Could not write output file trailer")

return

}

完整代码

// https://feater.top/ffmpeg/ffmpeg-demuxer-video-to-mp3-and-h264

package main

import (

"fmt"

"os"

"os/exec"

"github.com/moonfdd/ffmpeg-go/ffcommon"

"github.com/moonfdd/ffmpeg-go/libavcodec"

"github.com/moonfdd/ffmpeg-go/libavdevice"

"github.com/moonfdd/ffmpeg-go/libavformat"

"github.com/moonfdd/ffmpeg-go/libavutil"

)

func open_codec_context(streamIndex *ffcommon.FInt, ofmtCtx **libavformat.AVFormatContext, ifmtCtx *libavformat.AVFormatContext, type0 libavutil.AVMediaType) ffcommon.FInt {

var outStream, inStream *libavformat.AVStream

// int ret = -1, index = -1;

var ret ffcommon.FInt = -1

var index ffcommon.FInt = -1

index = ifmtCtx.AvFindBestStream(type0, -1, -1, nil, 0)

if index < 0 {

fmt.Printf("can't find %s stream in input file\n", libavutil.AvGetMediaTypeString(type0))

return ret

}

inStream = ifmtCtx.GetStream(uint32(index))

outStream = (*ofmtCtx).AvformatNewStream(nil)

if outStream == nil {

fmt.Printf("failed to allocate output stream\n")

return ret

}

ret = libavcodec.AvcodecParametersCopy(outStream.Codecpar, inStream.Codecpar)

if ret < 0 {

fmt.Printf("failed to copy codec parametes\n")

return ret

}

outStream.Codecpar.CodecTag = 0

*streamIndex = index

return 0

}

func main() {

os.Setenv("Path", os.Getenv("Path")+";./lib")

ffcommon.SetAvutilPath("./lib/avutil-56.dll")

ffcommon.SetAvcodecPath("./lib/avcodec-58.dll")

ffcommon.SetAvdevicePath("./lib/avdevice-58.dll")

ffcommon.SetAvfilterPath("./lib/avfilter-56.dll")

ffcommon.SetAvformatPath("./lib/avformat-58.dll")

ffcommon.SetAvpostprocPath("./lib/postproc-55.dll")

ffcommon.SetAvswresamplePath("./lib/swresample-3.dll")

ffcommon.SetAvswscalePath("./lib/swscale-5.dll")

genDir := "./out"

_, err := os.Stat(genDir)

if err != nil {

if os.IsNotExist(err) {

os.Mkdir(genDir, 0777) // Everyone can read write and execute

}

}

inFileName := "./resources/big_buck_bunny.mp4"

outFilenameAudio := "./out/a22.aac"

outFilenameVideo := "./out/a22.h264"

var ifmtCtx, ofmtCtxAudio, ofmtCtxVideo *libavformat.AVFormatContext

var packet libavcodec.AVPacket

var videoIndex ffcommon.FInt = -1

var audioIndex ffcommon.FInt = -1

var ret ffcommon.FInt = 0

//注册设备

libavdevice.AvdeviceRegisterAll()

for {

//打开输入流

if libavformat.AvformatOpenInput(&ifmtCtx, inFileName, nil, nil) < 0 {

fmt.Printf("Cannot open input file.\n")

break

}

//获取流信息

if ifmtCtx.AvformatFindStreamInfo(nil) < 0 {

fmt.Printf("Cannot find stream info in input file.\n")

break

}

//创建输出上下文:视频

libavformat.AvformatAllocOutputContext2(&ofmtCtxVideo, nil, "", outFilenameVideo)

if ofmtCtxVideo == nil {

fmt.Printf("can't create video output context")

break

}

//创建输出上下文:音频

libavformat.AvformatAllocOutputContext2(&ofmtCtxAudio, nil, "", outFilenameAudio)

if ofmtCtxAudio == nil {

fmt.Printf("can't create audio output context")

break

}

ret = open_codec_context(&videoIndex, &ofmtCtxVideo, ifmtCtx, libavutil.AVMEDIA_TYPE_VIDEO)

if ret < 0 {

fmt.Printf("can't decode video context\n")

break

}

ret = open_codec_context(&audioIndex, &ofmtCtxAudio, ifmtCtx, libavutil.AVMEDIA_TYPE_AUDIO)

if ret < 0 {

fmt.Printf("can't decode video context\n")

break

}

//Dump Format------------------

fmt.Printf("\n==============Input Video=============\n")

ifmtCtx.AvDumpFormat(0, inFileName, 0)

fmt.Printf("\n==============Output Video============\n")

ofmtCtxVideo.AvDumpFormat(0, outFilenameVideo, 1)

fmt.Printf("\n==============Output Audio============\n")

ofmtCtxAudio.AvDumpFormat(0, outFilenameAudio, 1)

fmt.Printf("\n======================================\n")

//打开输出文件:视频

if ofmtCtxVideo.Oformat.Flags&libavformat.AVFMT_NOFILE == 0 {

if libavformat.AvioOpen(&ofmtCtxVideo.Pb, outFilenameVideo, libavformat.AVIO_FLAG_WRITE) < 0 {

fmt.Printf("can't open output file: %s\n", outFilenameVideo)

break

}

}

//打开输出文件:音频

if ofmtCtxAudio.Oformat.Flags&libavformat.AVFMT_NOFILE == 0 {

if libavformat.AvioOpen(&ofmtCtxAudio.Pb, outFilenameAudio, libavformat.AVIO_FLAG_WRITE) < 0 {

fmt.Printf("can't open output file: %s\n", outFilenameVideo)

break

}

}

//写文件头

if ofmtCtxVideo.AvformatWriteHeader(nil) < 0 {

fmt.Printf("Error occurred when opening video output file\n")

break

}

if ofmtCtxAudio.AvformatWriteHeader(nil) < 0 {

fmt.Printf("Error occurred when opening audio output file\n")

break

}

for {

var ofmtCtx *libavformat.AVFormatContext

var inStream, outStream *libavformat.AVStream

if ifmtCtx.AvReadFrame(&packet) < 0 {

break

}

inStream = ifmtCtx.GetStream(packet.StreamIndex)

if packet.StreamIndex == uint32(videoIndex) {

outStream = ofmtCtxVideo.GetStream(0)

ofmtCtx = ofmtCtxVideo

} else if packet.StreamIndex == uint32(audioIndex) {

outStream = ofmtCtxAudio.GetStream(0)

ofmtCtx = ofmtCtxAudio

} else {

continue

}

//convert PTS/DTS

packet.Pts = libavutil.AvRescaleQRnd(packet.Pts, inStream.TimeBase, outStream.TimeBase,

libavutil.AV_ROUND_NEAR_INF|libavutil.AV_ROUND_PASS_MINMAX)

packet.Dts = libavutil.AvRescaleQRnd(packet.Dts, inStream.TimeBase, outStream.TimeBase,

libavutil.AV_ROUND_NEAR_INF|libavutil.AV_ROUND_PASS_MINMAX)

packet.Duration = libavutil.AvRescaleQ(packet.Duration, inStream.TimeBase, outStream.TimeBase)

packet.Pos = -1

packet.StreamIndex = 0

//write

if ofmtCtx.AvInterleavedWriteFrame(&packet) < 0 {

fmt.Printf("Error muxing packet\n")

break

}

packet.AvPacketUnref()

}

//write file trailer

ofmtCtxVideo.AvWriteTrailer()

ofmtCtxAudio.AvWriteTrailer()

break

}

libavformat.AvformatCloseInput(&ifmtCtx)

if ofmtCtxVideo != nil && (ofmtCtxVideo.Oformat.Flags&libavformat.AVFMT_NOFILE) == 0 {

ofmtCtxVideo.Pb.AvioClose()

}

if ofmtCtxAudio != nil && (ofmtCtxAudio.Oformat.Flags&libavformat.AVFMT_NOFILE) == 0 {

ofmtCtxAudio.Pb.AvioClose()

}

ofmtCtxVideo.AvformatFreeContext()

ofmtCtxAudio.AvformatFreeContext()

fmt.Println("-----------------------------------------")

go func() {

_, err = exec.Command("./lib/ffplay.exe", outFilenameAudio).Output()

if err != nil {

fmt.Println("play err = ", err)

}

}()

_, err = exec.Command("./lib/ffplay.exe", outFilenameVideo).Output()

if err != nil {

fmt.Println("play err = ", err)

}

}

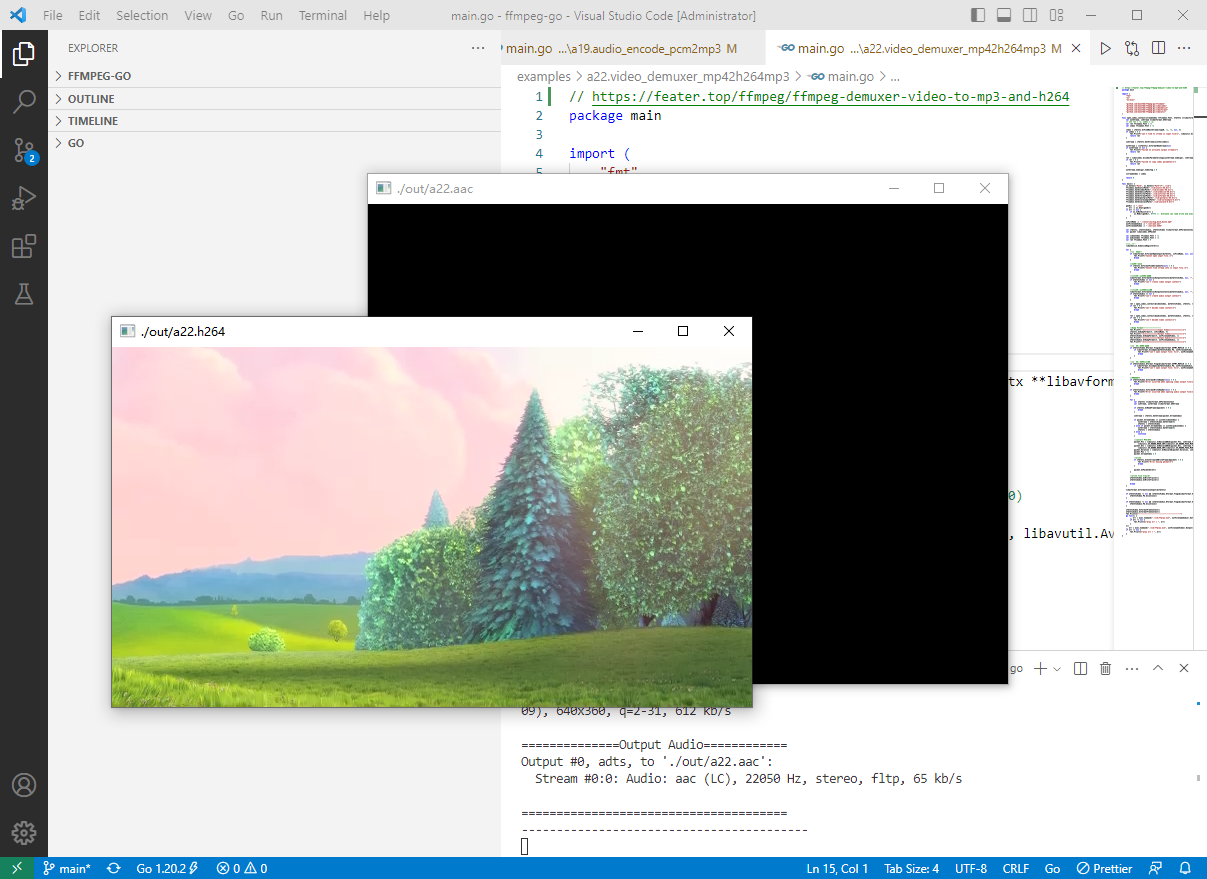

执行结果

执行命令:

go run ./examples/a22.video_demuxer_mp42h264mp3/main.go

2023-03-21:音视频解混合(demuxer)为MP3和H264,用go语言编写。的更多相关文章

- FFmpeg音视频解封装

一 . 解封装用到的函数和结构体 1.av_register_all() : open 一次就调用一次 2.avformat_network_init() : 网络模块初始化 3.avformat_o ...

- Android IOS WebRTC 音视频开发总结(七一)-- H265/H264有何不同

本文整理自自网络,非原创,喜欢相关文章请关注我们的微信公众号:blackerteam H.265 H.265是ITU-TVCEG继H.264之后所制定的新的视频编码标准.H.265标准围绕着现有的视频 ...

- Android硬编码——音频编码、视频编码及音视频混合

视频编解码对许多Android程序员来说都是Android中比较难的一个知识点.在Android 4.1以前,Android并没有提供硬编硬解的API,所以之前基本上都是采用FFMpeg来做视频软件编 ...

- WebRTC 音视频开发

WebRTC 音视频开发 webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译 ...

- 转:Android IOS WebRTC 音视频开发总结 (系列文章集合)

随笔分类 - webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译和整理的,译 ...

- Android 音视频开发(七): 音视频录制流程总结

在前面我们学习和使用了AudioRecord.AudioTrack.Camera.MediaExtractor.MediaMuxer API.MediaCodec. 学习和使用了上述的API之后,相信 ...

- 音视频处理概要 markdown

最近要想办法把录制的音视频进行拼接. 比方说此次录制的视频有三段,通过高清直播编码器录制,录制下的标准为h.264 直接用ffmpeg简单拼接,音频会丢失,所以有了此次解决方案(有可能会繁琐,简单方案 ...

- moviepy音视频剪辑:视频剪辑基类VideoClip的属性及方法详解

☞ ░ 前往老猿Python博文目录 ░ 一.概述 在<moviepy音视频剪辑:moviepy中的剪辑基类Clip详解>和<moviepy音视频剪辑:moviepy中的剪辑基类Cl ...

- Android 音视频开发(六): MediaCodec API 详解

在学习了Android 音视频的基本的相关知识,并整理了相关的API之后,我们应该对基本的音视频有一定的轮廓了. 下面开始接触一个Android音视频中相当重要的一个API: MediaCodec.通 ...

- 音视频入门-11-PNG文件格式详解

* 音视频入门文章目录 * PNG 文件格式解析 PNG 图像格式文件由一个 8 字节的 PNG 文件署名域和 3 个以上的后续数据块(IHDR.IDAT.IEND)组成. PNG 文件包括 8 字节 ...

随机推荐

- 应用和 IPv6

应用和 IPv6 前言 在数据中心网络IPv6协议改造时,我们通常更关注路由交换的部分.对于应用系统适配IPv6 网络确缺少关注,本文旨在更多的讨论应用和IPv6 的关系,帮助个人.公司和组织能够更改 ...

- 记一下Linux环境SpringBoot 用OpenOffice Word转PDF

环境 Windows或者Linux 首先安装 deb方式 tar -xvzf Apache_OpenOffice_XXXX_Linux_x86-64_install-deb_zh-CN.tar.gz ...

- struts 1.x框架记录

strus-config.xml 项目目录最顶层建立配置文件strus-config.xml action 通过type绑定java类,可通过attribute被引用 MyLoginForm.java ...

- ThinkPHP网站安全方案

一.ThinkPHP介绍 ThinkPHP是一款优秀的网站内容管理系统,因其功能强大,操作简单,拥有海量用户和其他CMS一样,安全漏洞也是其无法避免的问题.虽然官方不断发布补丁.升级版本,但安全问题依 ...

- Redis使用ZSET实现消息队列使用总结一

转载请注明出处: 目录 1.zset为什么可以做消息队列 2.zset实现消息队列的步骤 3.使用jedis实现消息队列示例 4.+inf与-inf 5.redis使用list与zset做消息队列有什 ...

- Flutter 2 渲染原理和如何实现视频渲染

7 月 17 日下午,在前端专场巡回沙龙北京站中,声网Agora跨平台开发工程师卢旭辉带来了<Flutter2 渲染原理和如何实现视频渲染>的主题分享,本文是对演讲内容的整理. 本次分享主 ...

- [Python]语音识别媒体中的音频到文本

@ 目录 准备工作 视频转音频 识别音频到文本 音频直接转换文本 准备工作 安装python3环境 申请一个可用的语音转换API,此篇以Microsoft Azure Speech为例 在Micros ...

- INT 21H 指令说明及使用方法 (转载)

转载这篇博客 https://www.cnblogs.com/ynwlgh/archive/2011/12/12/2285017.html 侵删 送张ascii码表 很多初学汇编语言的同学可能会对 ...

- Python学习之爬虫

又被老师要求去搞Python ,曰,,下午回顾了一下Python的基础知识,写了个爬取图片的程序,在此做个分享吧.不喜勿喷 import requests import time from bs4 i ...

- MySQL 更新执行的过程

更多内容,前往 IT-BLOG Select语句的执行过程会经过连接器.分析器.优化器.执行器.存储引擎,同样的 Update语句也会同样走一遍 Select语句的执行过程. 但是和 Select ...