PyTorch 自定义数据集

准备数据

准备 COCO128 数据集,其是 COCO train2017 前 128 个数据。按 YOLOv5 组织的目录:

$ tree ~/datasets/coco128 -L 2

/home/john/datasets/coco128

├── images

│ └── train2017

│ ├── ...

│ └── 000000000650.jpg

├── labels

│ └── train2017

│ ├── ...

│ └── 000000000650.txt

├── LICENSE

└── README.txt

定义 Dataset

torch.utils.data.Dataset 是一个数据集的抽象类。自定义数据集时,需继承 Dataset 并覆盖如下方法:

__len__:len(dataset)获取数据集大小。__getitem__:dataset[i]访问第i个数据。

详见:

自定义实现 YOLOv5 数据集的例子:

import os

from pathlib import Path

from typing import Any, Callable, Optional, Tuple

import numpy as np

import torch

import torchvision

from PIL import Image

class YOLOv5(torchvision.datasets.vision.VisionDataset):

def __init__(

self,

root: str,

name: str,

transform: Optional[Callable] = None,

target_transform: Optional[Callable] = None,

transforms: Optional[Callable] = None,

) -> None:

super(YOLOv5, self).__init__(root, transforms, transform, target_transform)

images_dir = Path(root) / 'images' / name

labels_dir = Path(root) / 'labels' / name

self.images = [n for n in images_dir.iterdir()]

self.labels = []

for image in self.images:

base, _ = os.path.splitext(os.path.basename(image))

label = labels_dir / f'{base}.txt'

self.labels.append(label if label.exists() else None)

def __getitem__(self, idx: int) -> Tuple[Any, Any]:

img = Image.open(self.images[idx]).convert('RGB')

label_file = self.labels[idx]

if label_file is not None: # found

with open(label_file, 'r') as f:

labels = [x.split() for x in f.read().strip().splitlines()]

labels = np.array(labels, dtype=np.float32)

else: # missing

labels = np.zeros((0, 5), dtype=np.float32)

boxes = []

classes = []

for label in labels:

x, y, w, h = label[1:]

boxes.append([

(x - w/2) * img.width,

(y - h/2) * img.height,

(x + w/2) * img.width,

(y + h/2) * img.height])

classes.append(label[0])

target = {}

target["boxes"] = torch.as_tensor(boxes, dtype=torch.float32)

target["labels"] = torch.as_tensor(classes, dtype=torch.int64)

if self.transforms is not None:

img, target = self.transforms(img, target)

return img, target

def __len__(self) -> int:

return len(self.images)

以上实现,继承了 VisionDataset 子类。其 __getitem__ 返回了:

- image: PIL Image, 大小为

(H, W) - target:

dict, 含以下字段:boxes(FloatTensor[N, 4]): 真实标注框[x1, y1, x2, y2],x范围[0,W],y范围[0,H]labels(Int64Tensor[N]): 上述标注框的类别标识

读取 Dataset

dataset = YOLOv5(Path.home() / 'datasets/coco128', 'train2017')

print(f'dataset: {len(dataset)}')

print(f'dataset[0]: {dataset[0]}')

输出:

dataset: 128

dataset[0]: (<PIL.Image.Image image mode=RGB size=640x480 at 0x7F6F9464ADF0>, {'boxes': tensor([[249.7296, 200.5402, 460.5399, 249.1901],

[448.1702, 363.7198, 471.1501, 406.2300],

...

[ 0.0000, 188.8901, 172.6400, 280.9003]]), 'labels': tensor([44, 51, 51, 51, 51, 44, 44, 44, 44, 44, 45, 45, 45, 45, 45, 45, 45, 45,

45, 50, 50, 50, 51, 51, 60, 42, 44, 45, 45, 45, 50, 51, 51, 51, 51, 51,

51, 44, 50, 50, 50, 45])})

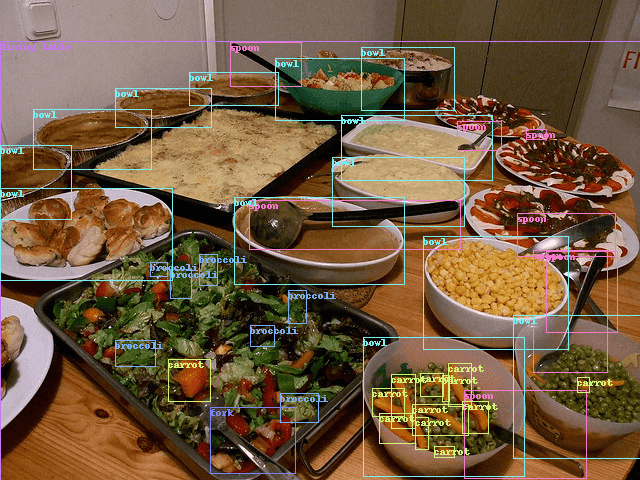

预览:

使用 DataLoader

训练需要批量提取数据,可以使用 DataLoader :

dataset = YOLOv5(Path.home() / 'datasets/coco128', 'train2017',

transform=torchvision.transforms.Compose([

torchvision.transforms.ToTensor()

]))

dataloader = DataLoader(dataset, batch_size=64, shuffle=True,

collate_fn=lambda batch: tuple(zip(*batch)))

for batch_i, (images, targets) in enumerate(dataloader):

print(f'batch {batch_i}, images {len(images)}, targets {len(targets)}')

print(f' images[0]: shape={images[0].shape}')

print(f' targets[0]: {targets[0]}')

输出:

batch 0, images 64, targets 64

images[0]: shape=torch.Size([3, 480, 640])

targets[0]: {'boxes': tensor([[249.7296, 200.5402, 460.5399, 249.1901],

[448.1702, 363.7198, 471.1501, 406.2300],

...

[ 0.0000, 188.8901, 172.6400, 280.9003]]), 'labels': tensor([44, 51, 51, 51, 51, 44, 44, 44, 44, 44, 45, 45, 45, 45, 45, 45, 45, 45,

45, 50, 50, 50, 51, 51, 60, 42, 44, 45, 45, 45, 50, 51, 51, 51, 51, 51,

51, 44, 50, 50, 50, 45])}

batch 1, images 64, targets 64

images[0]: shape=torch.Size([3, 248, 640])

targets[0]: {'boxes': tensor([[337.9299, 167.8500, 378.6999, 191.3100],

[383.5398, 148.4501, 452.6598, 191.4701],

[467.9299, 149.9001, 540.8099, 193.2401],

[196.3898, 142.7200, 271.6896, 190.0999],

[134.3901, 154.5799, 193.9299, 189.1699],

[ 89.5299, 162.1901, 124.3798, 188.3301],

[ 1.6701, 154.9299, 56.8400, 188.3700]]), 'labels': tensor([20, 20, 20, 20, 20, 20, 20])}

源码

参考

APIs:

GoCoding 个人实践的经验分享,可关注公众号!

PyTorch 自定义数据集的更多相关文章

- [转载]pytorch自定义数据集

为什么要定义Datasets: PyTorch提供了一个工具函数torch.utils.data.DataLoader.通过这个类,我们在准备mini-batch的时候可以多线程并行处理,这样可以加快 ...

- Pytorch划分数据集的方法

之前用过sklearn提供的划分数据集的函数,觉得超级方便.但是在使用TensorFlow和Pytorch的时候一直找不到类似的功能,之前搜索的关键字都是"pytorch split dat ...

- pytorch加载语音类自定义数据集

pytorch对一下常用的公开数据集有很方便的API接口,但是当我们需要使用自己的数据集训练神经网络时,就需要自定义数据集,在pytorch中,提供了一些类,方便我们定义自己的数据集合 torch.u ...

- MMDetection 快速开始,训练自定义数据集

本文将快速引导使用 MMDetection ,记录了实践中需注意的一些问题. 环境准备 基础环境 Nvidia 显卡的主机 Ubuntu 18.04 系统安装,可见 制作 USB 启动盘,及系统安装 ...

- Scaled-YOLOv4 快速开始,训练自定义数据集

代码: https://github.com/ikuokuo/start-scaled-yolov4 Scaled-YOLOv4 代码: https://github.com/WongKinYiu/S ...

- torch_13_自定义数据集实战

1.将图片的路径和标签写入csv文件并实现读取 # 创建一个文件,包含image,存放方式:label pokemeon\\mew\\0001.jpg,0 def load_csv(self,file ...

- Tensorflow2 自定义数据集图片完成图片分类任务

对于自定义数据集的图片任务,通用流程一般分为以下几个步骤: Load data Train-Val-Test Build model Transfer Learning 其中大部分精力会花在数据的准备 ...

- Pytorch自定义数据库

1)前言 虽然torchvision.datasets中已经封装了好多通用的数据集,但是我们在使用Pytorch做深度学习任务的时候,会面临着自定义数据库来满足自己的任务需要.如我们要训练一个人脸关键 ...

- [炼丹术]YOLOv5训练自定义数据集

YOLOv5训练自定义数据 一.开始之前的准备工作 克隆 repo 并在Python>=3.6.0环境中安装requirements.txt,包括PyTorch>=1.7.模型和数据集会从 ...

随机推荐

- (31)grep命令详解:查找文件内容

1.grep命令用于不需要列出文件的全部内容,而是从文件中找到包含指定信息的那些行. grep命令能够在一个或多个文件中,搜索某一特定的字符模式(也就是正则表达式),此模式可以是单一的字符.字符串.单 ...

- Educational Codeforces Round 90 (Rated for Div. 2) D. Maximum Sum on Even Positions(dp)

题目链接:https://codeforces.com/contest/1373/problem/D 题意 给出一个大小为 $n$ 的数组 $a$,下标为 $0 \sim n - 1$,可以进行一次反 ...

- 使用eclipse搭建第一个java web应用

一. 首先是eclipse得下载,你要下载Eclipse IDE for Java EE这种类型的,我之前下载的Eclipse IDE for Enterprise Java Developers是官 ...

- 后缀数组Da模板+注释 以及 dc3模板

后缀数组Da模板: 1 /* 2 后缀数组倍增法Da板子 3 */ 4 #include <cstdlib> 5 #include <cstring> 6 #include & ...

- Ubuntu上安装Python3编译器和 Pycharm 集成开发环境

一.安装python3 (Ubuntu上面是自带python编译器的,可以用命令"python -V"来查看版本号.我下面安装的是pyhton3编译器) 一条命令就可以 sudo ...

- streamlink 安装使用

CentOS 安装: pip install streamlink 使用: #查看视频信息 streamlink $URL #下载视频 streamlink $URL best streamlink ...

- codeforces 1077D Cutting Out 【二分】

题目:戳这里 题意:给n个数的数组,要求找k个数满足,这k个数在数组中出现的次数最多. 解题思路:k个数每个数出现次数都要最大化,可以想到二分下限,主要是正确的二分不好写. 附ac代码: 1 #inc ...

- springboot demo(一)快速开始

快速入门 maven构建项目 1.访问http://start.spring.io/ 2.选择构建工具Maven Project.Spring Boot版本2.26以及一些工程基本信息,点击" ...

- 修改jupyter-notebook的python3版本

将默认的kernel修改为对应的python即可: /home/a/.virtualenvs/YOUR_VENV/bin/python -m pip install ipykernel /home/a ...

- Storybook 最新教程

Storybook 最新教程 Storybook is the most popular UI component development tool for React, Vue, and Angul ...