使用selenium再次爬取疫情数据(链接数据库)

爬取网页地址:

数据库连接代码:

def db_connect():

try:

db=pymysql.connect('localhost','root','zzm666','payiqing')

print('database connect success')

return db

except Exception as e:

raise e

return 0

爬取代码:

def pa_website(db):

driver = webdriver.Chrome()

driver.get('https://ncov.dxy.cn/ncovh5/view/pneumonia?from=timeline&isappinstalled=0')

time.sleep(5)#页面渲染等待,保证数据完整性

driver.find_element_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[21]').click()#点击更多数据,页面数据未加载完

divs=driver.find_elements_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[@class="fold___85nCd"]')#找到要爬取的数据上一次代码路径

cursor = db.cursor()

for div in divs:

address=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[1]').text)

confirm_issue=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[2]').text)

all_confirm=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[3]').text)

dead=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[4]').text)

cure=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[5]').text)

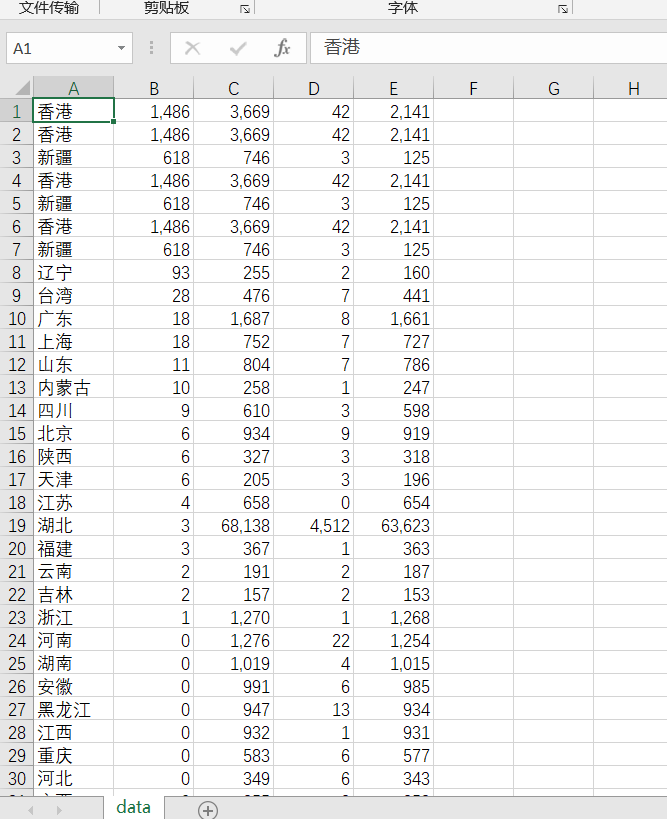

with open('data.csv','a',newline="") as csvfile:#创建data.csv文件,(推荐采用这种方式)

writer=csv.writer(csvfile,delimiter=',')

writer.writerow([address,confirm_issue,all_confirm,dead,cure])

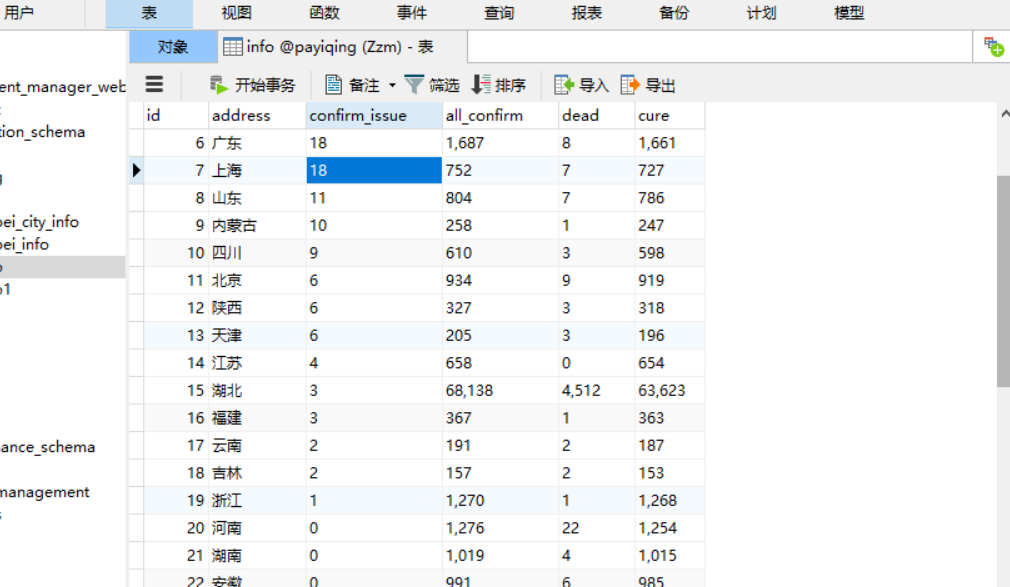

sql="insert into info(id,address,confirm_issue,all_confirm,dead,cure)values ('%d','%s','%s','%s','%s','%s')"%(0,address,confirm_issue,all_confirm,dead,cure)

try:

cursor.execute(sql)

db.commit()

print('数据插入成功')

except Exception as e:

raise e

db.close()

爬取流程:

1.获取目标网址

2.获取上一级目标路径

3.遍历路径下的目标

4.获取数据信息

5.生存csv文件展示(可以省略)

6.插入数据库

7.当数据全部插入后,关闭数据库

附(总源码+程序截图):

import csv import requests

from selenium import webdriver

import pymysql

import time

from selenium.webdriver import ActionChains #动作链,滑动验证码登录

def db_connect():

try:

db=pymysql.connect('localhost','root','zzm666','payiqing')

print('database connect success')

return db

except Exception as e:

raise e

return 0

def pa_website(db):

driver = webdriver.Chrome()

driver.get('https://ncov.dxy.cn/ncovh5/view/pneumonia?from=timeline&isappinstalled=0')

time.sleep(5)

driver.find_element_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[21]').click()

divs=driver.find_elements_by_xpath('//*[@id="root"]/div/div[4]/div[9]/div[@class="fold___85nCd"]')

cursor = db.cursor()

for div in divs:

address=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[1]').text)

confirm_issue=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[2]').text)

all_confirm=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[3]').text)

dead=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[4]').text)

cure=str(div.find_element_by_xpath('.//div[@class="areaBlock1___3qjL7"]/p[5]').text)

with open('data.csv','a',newline="") as csvfile:

writer=csv.writer(csvfile,delimiter=',')

writer.writerow([address,confirm_issue,all_confirm,dead,cure])

sql="insert into info(id,address,confirm_issue,all_confirm,dead,cure)values ('%d','%s','%s','%s','%s','%s')"%(0,address,confirm_issue,all_confirm,dead,cure)

try:

cursor.execute(sql)

db.commit()

print('数据插入成功')

except Exception as e:

raise e

db.close()

def main():

db = db_connect()

pa_website(db)

if __name__=="__main__":

main()

使用selenium再次爬取疫情数据(链接数据库)的更多相关文章

- 爬取疫情数据,以django+pyecharts实现数据可视化web网页

在家呆着也是呆着,不如做点什么消磨时间呗~ 试试用django+pyecharts实现疫情数据可视化web页面 这里要爬疫情数据 来自丁香园.搜狗及百度的疫情实时动态展示页 先看看劳动成果: 导航栏: ...

- selenium爬虫 | 爬取疫情实时动态(二)

'''@author:Billie更新说明:1-28 17:00 项目开始着手,spider方法抓取到第一条疫情数据,save_data_csv方法将疫情数据保存至csv文件1-29 13:12 目标 ...

- python爬取疫情数据详解

首先逐步分析每行代码的意思: 这是要引入的东西: from os import path import requests from bs4 import BeautifulSoup import js ...

- 利用Python爬取疫情数据并使用可视化工具展示

import requests, json from pyecharts.charts import Map, Page, Pie, Bar from pyecharts import options ...

- selenium爬虫 | 爬取疫情实时动态

import csvimport selenium.webdriverfrom selenium.webdriver.chrome.options import Optionsclass spider ...

- python爬取疫情数据存入MySQL数据库

import requests from bs4 import BeautifulSoup import json import time from pymysql import * def mes( ...

- 使用selenium进行爬取掘金前端小册的数据

Selenium 简介 百度百科介绍: Selenium [1] 是一个用于Web应用程序测试的工具.Selenium测试直接运行在浏览器中,就像真正的用户在操作一样.支持的浏览器包括IE(7, 8, ...

- 使用webdriver+urllib爬取网页数据(模拟登陆,过验证码)

urilib是python的标准库,当我们使用Python爬取网页数据时,往往用的是urllib模块,通过调用urllib模块的urlopen(url)方法返回网页对象,并使用read()方法获得ur ...

- [python爬虫] Selenium定向爬取PubMed生物医学摘要信息

本文主要是自己的在线代码笔记.在生物医学本体Ontology构建过程中,我使用Selenium定向爬取生物医学PubMed数据库的内容. PubMed是一个免费的搜寻引擎,提供生物医学方 ...

随机推荐

- requests接口自动化1-json序列化与反序列化

json序列化与反序列化: 序列化:将对象转换为json字符串 反序列化:将json字符串转换为对象,比如转换为python里的字典 import json #定义字典 dict1={'usernam ...

- JVM 专题九:运行时数据区(四)本地方法栈

1. 本地方法栈 2. 什么是本地方法栈? Java虚拟机栈用于管理Java方法的调用,而本地方法栈用于管理本地方法的调用 本地方法栈,也是线程私有的. 允许被实现成固定或者是可动态拓展的内存大小 ...

- 数据可视化之powerBI入门(六)PowerQuery:横向/纵向追加数据

https://zhuanlan.zhihu.com/p/64148432 上一篇文章都是在原表数据基础上的分分合合,但做数据分析的时候还经常需要在原有数据的基础上增加一些辅助数据,比如加入新列.新行 ...

- python 装饰器(三):装饰器实例(一)

示例 7-15 定义了一个装饰器,它会在每次调用被装饰的函数时计时,然后把经过的时间.传入的参数和调用的结果打印出来.示例 7-15 一个简单的装饰器,输出函数的运行时间 import time de ...

- 数据可视化之DAX篇(二十五)PowerBI常用的度量值:累计至今

https://zhuanlan.zhihu.com/p/64999937 经常碰到本年至今.本月至今的数据计算,其实还有一类计算是,从历史最早日期至今的累计计算,比如从开业到现在总共卖出了多少件商品 ...

- HotSpot的对象模型(5)

Java对象通过Oop来表示.Oop指的是 Ordinary Object Pointer(普通对象指针).在 Java 创建对象实例的时候创建,用于表示对象的实例信息.也就是说,在 Java 应用程 ...

- Hangfire实战二——为DashBoard页面添加权限认证

概述 Hangfire Dashboard为我们提供了可视化的对后台任务进行管理的界面,我们可以直接在这个页面上对定时任务进行删除.立即执行等操作,如下图所示: 默认情况下,这个页面只能在部署Hang ...

- JVM垃圾回收(五)

低延迟垃圾收集器 衡量垃圾收集器的三项最重要的指标是: 内存占用(Footprint).吞吐量(Throughput)和延迟(Latency).三者总体的表现会随技术进步而越来越好,但是要在这三个方面 ...

- java 之 实例方法和类方法

类方法:使用static修饰(静态方法),属于整个类的,不是属于某个实例的,只能处理static域或调用static方法: 实例方法:属于对象的方法,由对象来调用. 判断类方法,类方法的前面有stat ...

- 一个有趣的问题, 你知道SqlDataAdapter中的Fill是怎么实现的吗

一:背景 1. 讲故事 最近因为各方面原因换了一份工作,去了一家主营物联柜的公司,有意思的是物联柜上的终端是用 wpf 写的,代码也算是年久失修,感觉技术债还是蛮重的,前几天在调试一个bug的时候,看 ...