Hadoop集群安装压缩工具Snappy,用于Hbase

最近项目中要用到Hadoop和Hbase,为了节省服务器的存储成本,并提高吞吐,安装并开启HBase的数据压缩为Snappy。

主流的HBase压缩方式有GZip | LZO | Snappy,Snappy的压缩比会稍微优于LZO。相比于gzip,Snappy压缩率不如gzip,但是压缩和解压缩速度有很大优势,而且节省cpu资源。

Hadoop默认没有支持snappy压缩,需要我们自己编译 才能支持snappy的压缩。

一、安装包准备

jdk1.8

apache-maven-3.6.1-bin.tar.gz

snappy-1.1.1.tar.gz

protobuf-2.5.0.tar.gz

hadoop-2.7.3-src.tar.gz

二、安装基础软件

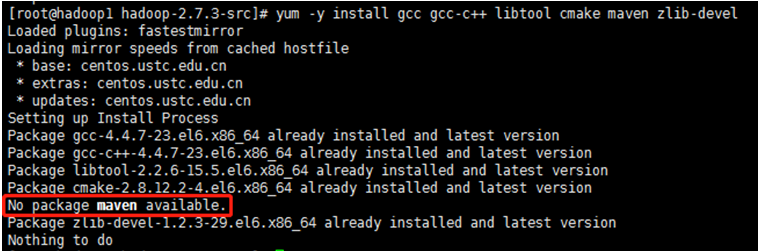

yum -y install gcc gcc-c++ libtool cmake maven zlib-devel

确保以上基础软件都安装成功,如maven出现以上情况,则按下面方法安装maven。

三、安装maven

3.1. 上传解压

上传安装包到/usr/local并解压安装包,用root用户解压maven安装包到/usr/local目录下

cd /usr/local tar -xvf apache-maven-3.6.1-bin.tar

3.2. 配置环境变量

编辑/etc/profile文件,添加如下代码:

MAVEN_HOME=/usr/local/apache-maven-3.6.1

export MAVEN_HOME

export PATH=${PATH}:${MAVEN_HOME}/bin

3.3. 环境变量生效

保存文件,并运行如下命令使环境变量生效:

source /etc/profile

3.4. 验证

在控制台输入如下命令,如果能看到Maven相关版本信息,则说明Maven已经安装成功

mvn –v

四、安装snappy

4.1.上传解压

上传安装包到/usr/local并解压安装包,用root用户解压snappy安装包到/usr/local目录下,并按顺序执行以下命令,进行安装:

cd /usr/local tar -xvf snappy-1.1.1.tar.gz cd snappy-1.1.1 ./configure make && make install

4.2.验证

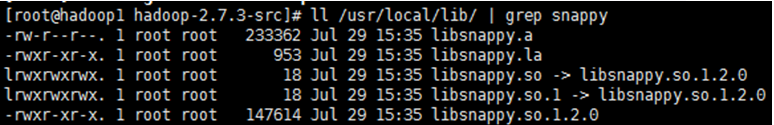

查看snappy是否安装成功

ll /usr/local/lib/ | grep snappy

五、安装protobuf

下载地址:https://github.com/google/protobuf/releases/tag/v2.5.0

5.1.上传解压

上传安装包到/usr/local并解压安装包,用root用户解压protobuf安装包到/usr/local目录下,按顺序执行以下命令,进行安装:

cd /usr/local tar -xvf protobuf-2.5.0.tar.gz cd protobuf-2.5.0 ./configure make && make install

5.2.验证

查看protobuf是否安装完成

protoc –version

六、编译生成hadoop-native-Libraries

hadoop源码下载地址:http://archive.apache.org/dist/hadoop/core/

6.1.上传解压

上传安装包到/usr/local并解压安装包,用root用户解压hadoop安装包到/usr/local目录下,按顺序执行以下命令,进行安装:

cd /usr/local tar -xvf hadoop-2.7.3-src.tar

6.2.编译生成hadoop-native-Libraries

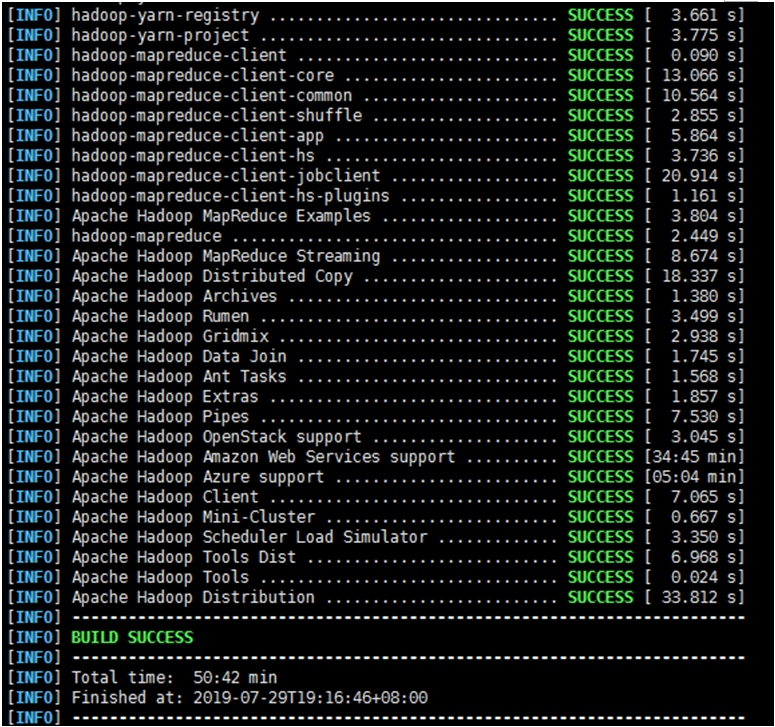

执行以下命令进行编译,因为通过通过mvn安装,会从官方下载相关所需文件,时间漫长,我大概花了3小时左右,如果出现失败终止了,可重新执行以下命令。

注意:为了提高下载速度。可以修改下载源(添加国内阿里的maven仓库)

mvn package -DskipTests -Pdist,native -Dtar -Dsnappy.lib=/usr/local/lib -Dbundle.snappy

6.3.配置Hadoop和Hbase

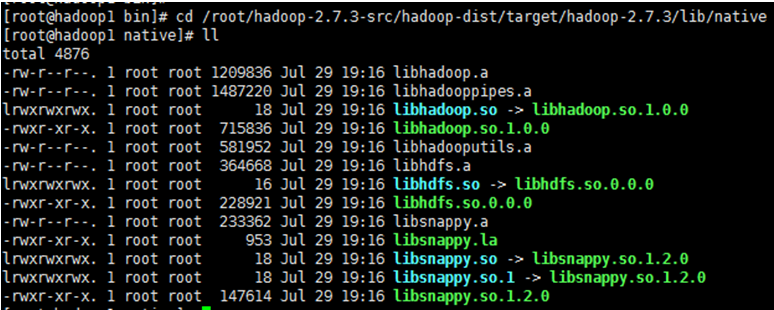

1、 进入/usr/local/hadoop-2.7.3-src/hadoop-dist/target/hadoop-2.7.3/lib/native目录,检查是否存在以下文件:

2、 将以上目录下的文件拷贝到hadoop集群中的hadoop下的lib/native目录,如果没有则新建,集群中的各节点均需拷贝;

3、 将以上目录下的文件拷贝到hbase下的lib/native/Linux-amd64-64目录下,如果没有则新建,集群中的各节点均需拷贝;

4、 进入/usr/local/hadoop-2.7.3/etc/hadoop目录下修改core-site.xml配置文件

vi core-site.xml

在文件中加入如下内容:

<property>

<name>io.compression.codecs</name>

<value>org.apache.hadoop.io.compress.SnappyCodec</value>

</property>

6.4.重启Hadoop和Hbase

在主节点,依次停止:Hbase、Hadoop服务,然后在依次启动Hadoop、Hbase服务。

这里要注意的是:Hbase启动依赖于Hadoop,会去找Hadoop的hdfs,所以要先启动好Hadoop服务

6.5.验证

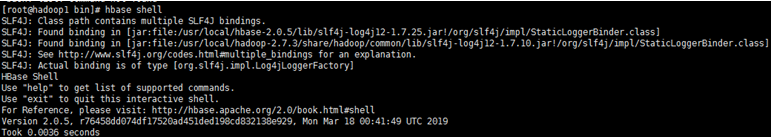

1、 进入安装了Hbase的linux控制台,输入hbase shell 命令进行登陆;

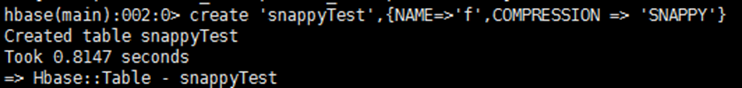

2、 执行以下命令创建表,指定压缩为snappy

create 'snappyTest',{NAME=>'f',COMPRESSION => 'SNAPPY'}

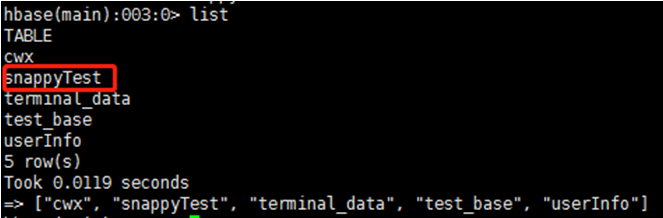

以上提示说明创建成功,可在进一步用list命令查看:

结语

费了好大的劲,终于安装成功,网上各种搜,方法五花八门,真搞不懂安装snappy为什么要这么麻烦,竟然还要配置Hadoop,先在这里记录总结一下,后续有时间在研究吧。

网上还有说要编译安装hadoop-snappy的,查了一下,在hadoop2.x源码已经集成了Snappy压缩了,所以编译安装hadoop-snappy 根本是多余的。

Hadoop集群安装压缩工具Snappy,用于Hbase的更多相关文章

- Apache Hadoop 集群安装文档

简介: Apache Hadoop 集群安装文档 软件:jdk-8u111-linux-x64.rpm.hadoop-2.8.0.tar.gz http://www.apache.org/dyn/cl ...

- 2 Hadoop集群安装部署准备

2 Hadoop集群安装部署准备 集群安装前需要考虑的几点硬件选型--CPU.内存.磁盘.网卡等--什么配置?需要多少? 网络规划--1 GB? 10 GB?--网络拓扑? 操作系统选型及基础环境-- ...

- 1.Hadoop集群安装部署

Hadoop集群安装部署 1.介绍 (1)架构模型 (2)使用工具 VMWARE cenos7 Xshell Xftp jdk-8u91-linux-x64.rpm hadoop-2.7.3.tar. ...

- Apache Hadoop集群安装(NameNode HA + SPARK + 机架感知)

1.主机规划 序号 主机名 IP地址 角色 1 nn-1 192.168.9.21 NameNode.mr-jobhistory.zookeeper.JournalNode 2 nn-2 ).HA的集 ...

- Apache Hadoop集群安装(NameNode HA + YARN HA + SPARK + 机架感知)

1.主机规划 序号 主机名 IP地址 角色 1 nn-1 192.168.9.21 NameNode.mr-jobhistory.zookeeper.JournalNode 2 nn-2 192.16 ...

- 一脸懵逼学习基于CentOs的Hadoop集群安装与配置

1:Hadoop分布式计算平台是由Apache软件基金会开发的一个开源分布式计算平台.以Hadoop分布式文件系统(HDFS)和MapReduce(Google MapReduce的开源实现)为核心的 ...

- 一脸懵逼学习基于CentOs的Hadoop集群安装与配置(三台机器跑集群)

1:Hadoop分布式计算平台是由Apache软件基金会开发的一个开源分布式计算平台.以Hadoop分布式文件系统(HDFS)和MapReduce(Google MapReduce的开源实现)为核心的 ...

- Hadoop集群安装-CDH5(5台服务器集群)

CDH5包下载:http://archive.cloudera.com/cdh5/ 架构设计: 主机规划: IP Host 部署模块 进程 192.168.254.151 Hadoop-NN-01 N ...

- Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS

摘自:http://www.powerxing.com/install-hadoop-cluster/ 本教程讲述如何配置 Hadoop 集群,默认读者已经掌握了 Hadoop 的单机伪分布式配置,否 ...

随机推荐

- 面试题——SSM面试题

树木丛生红火火 树木丛生红火火 微信公众号:Java全栈开发大联盟 原文地址:https://note.youdao.com/ynoteshare1/index.html?id=3f81baea7 ...

- C#实现异步阻塞TCP(Send,Receive,Accept,Connect)

1.类 (1)服务器端操作类 public class TcpServiceSocket { //接收数据事件 public Action<Socket, string> recvMess ...

- Logstash工作原理

Logstash事件处理有三个阶段:inputs → filters → outputs.是一个接收,处理,转发日志的工具.支持系统日志,webserver日志,错误日志,应用日志,总之包括所有可以抛 ...

- Linux的正则练习

grep和 egrep的正则表达式 1.显示三个用户root.wang的UID和默认shell cat /etc/passwd | grep “^\(root\|wang\)” | tr ‘:’ ‘ ...

- C# 通过Process.Start() 打开程序 置顶方法

private void webBrowser1_Navigating(object sender, WebBrowserNavigatingEventArgs e) { try { foreach ...

- 【Android-关闭所有Activity】关闭activity之前的所有activity,重启actibity

Android关闭activity之前的所有activity,重启actibity 直接关闭一个activity之前的所有Activity页面 解决方法:清理activity堆栈 Intent ine ...

- ACM-ICPC 2018 南京赛区网络预赛Sum,线性筛处理积性函数

SUM 题意:f(n)是n可以拆成多少组n=a*b,a和b都是不包含平方因子的方案数目,对于a!=b,n=a*b和n=b*a算两种方案,求∑i=1nf(i) 首先我们可以知道,n=1时f(1)=1, ...

- 【csp模拟赛2】 爆搜 方格加数

[题目描述] xyz1048576正在玩一个关于矩阵的游戏. 一个n*m的矩阵,矩阵中每个数都是[1,12]内的整数.你可以执行下列两个操作任意多次: (1)指定一行,将该行所有数字+1. (2)指定 ...

- Makefile规则介绍

Makefile 一个规则 三要素:目标,依赖,命令 目标:依赖 命令 1.第一条规则是用来生成终极目标的规则 如果规则中的依赖不存在,向下寻找其他的规则 更新机制:比较的是目标文件和 ...

- XCTest-iOS单元测试框架

Xctest 是iOS的单元测试框架,有objective-c和swift两种语言可以选择 Xcuitest 是iOS的UI测试框架 XCTest 官方文档地址:https://devel ...