梯度提升树GBDT算法

转自https://zhuanlan.zhihu.com/p/29802325

本文对Boosting家族中一个重要的算法梯度提升树(Gradient Boosting Decison Tree, 简称GBDT)做一个总结。GBDT有很多简称,有GBT(Gradient Boosting Tree), GTB(Gradient Tree Boosting ), GBRT(Gradient Boosting Regression Tree), MART(Multiple Additive Regression Tree),其实都是指的同一种算法,本文统一简称GBDT。

1 GBDT概述

GBDT也是集成学习Boosting家族的成员,但是却和传统的Adaboost有很大的不同。Adaboost是利用前一轮迭代弱学习器的误差率来更新训练集的权重,这样一轮轮的迭代下去。GBDT也是迭代,使用了前向分布算法,但是弱学习器限定了只能使用CART回归树模型,同时迭代思路和Adaboost也有所不同。

在GBDT的迭代中,假设前一轮迭代得到的强学习器是 ,损失函数是

,本轮迭代的目标是找到一个CART回归树模型的弱学习器

,让本轮的损失函数

最小 。即本轮迭代找到决策树,要让样本的损失尽量变得更小。

GBDT的思想可以用一个通俗的例子解释,假如有个人30岁,我们首先用20岁去拟合,发现损失有10岁,这时我们用6岁去拟合剩下的损失,发现差距还有4岁,第三轮我们用3岁拟合剩下的差距,差距就只有一岁了。如果我们的迭代轮数还没有完,可以继续迭代下面,每一轮迭代,拟合的岁数误差都会减小。

2 GBDT的负梯度拟合

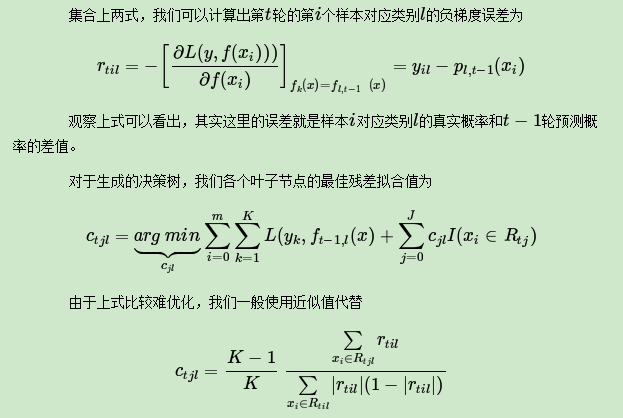

用损失函数的负梯度来拟合本轮损失的近似值,进而拟合一个CART回归树。第t轮的第i个样本的损失函数的负梯度表示为

利用

,可以拟合一棵CART回归树,得到第t棵回归树,其对应的叶结点区域

。其中j为叶结点的个数。

针对每一个叶结点里的样本,求出使损失函数最小,即拟合叶结点最好的输出值

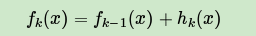

得到本轮的决策树拟合函数

从而本轮最终得到的强学习器表达式如下

通过损失函数的负梯度来拟合,我们找到了一种通用的拟合损失误差的办法,这样无论是分类问题还是回归问题,我们通过其损失函数的负梯度的拟合,就可以用GBDT来解决我们的分类回归问题。区别仅仅在于损失函数不同导致的负梯度不同而已。

3 GBDT回归算法

输入:训练集样本 ,最大迭代次数T,损失函数L。

输出:强学习器

(1)初始化弱学习器

(2)对迭代轮数 t = 1,2,...,T,有

a)对样本i = 1,2,...,m,计算负梯度

b) 利用 ,拟合一棵CART回归树,得到第t棵回归树,其对应的叶结点区域为

。其中j为回归树t的叶结点的个数。

c)对叶子区域 ,计算最佳拟合值

d)更新强学习器

(3)得到强学习器 的表达式

4 GBDT分类算法

GBDT的分类算法从思想上和GBDT的回归算法没有区别,但是由于样本输出不是连续的值,而是离散的类别,导致我们无法直接从输出类别去拟合类别输出的误差。

为了解决这个问题,主要有两个方法,一个是用指数损失函数,此时GBDT退化为Adaboost算法。另一种方法是用类似于逻辑回归的对数似然损失函数的方法。也就是说,我们用的是类别的预测概率值和真实概率值的差来拟合损失。本文仅讨论用对数似然损失函数的GBDT分类。而对于对数似然损失函数,我们又有二元分类和多元分类的区别。

4.1 二元GBDT分类算法

对于二元GBDT,如果用类似于逻辑回归的对数似然损失函数,则损失函数为

其中 。则此时的负梯度误差为

对于生成的决策树,各个叶子节点的最佳残差拟合值为

由于上式比较难优化,一般使用近似值代替

除了负梯度计算和叶子节点的最佳残差拟合的线性搜索,二元GBDT分类和GBDT回归算法过程相同。

4.2 多元GBDT分类算法

多元GBDT要比二元GBDT复杂一些,对应的是多元逻辑回归和二元逻辑回归的复杂度差别。假设类别数为K,则此时我们的对数似然损失函数为

其中如果样本输出类别为K,则 .第k类的概率

的表达式为

除了负梯度计算和叶子节点的最佳残差拟合的线性搜索,多元GBDT分类和二元GBDT分类以及GBDT回归算法过程相同。

5 GBDT常用损失函数

(1)对于分类算法,其损失函数一般有对数损失函数和指数损失函数两种。

a) 如果是指数损失函数,则损失函数表达式为

b) 如果是对数损失函数,分为二元分类和多元分类两种

(2)对于回归算法,常用损失函数有如下4种。

a)均方差,这个是最常见的回归损失函数。

b)绝对损失。

对应负梯度误差为

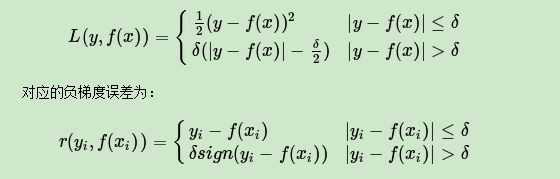

c)Huber损失,它是均方差和绝对损失的折衷产物,对于远离中心的异常点,采用绝对损失,而中心附近的点采用均方差。这个界限一般用分位数点度量。损失函数如下

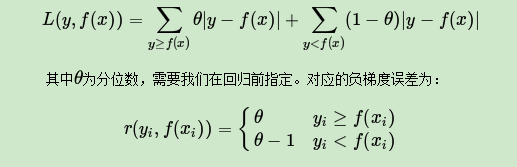

d) 分位数损失。它对应的是分位数回归的损失函数,表达式为

对于Huber损失和分位数损失,主要用于健壮回归,也就是减少异常点对损失函数的影响。

6 GBDT正则化

对GBDT进行正则化,防止过拟合。GBDT的正则化主要有三种方式。

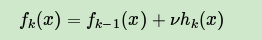

第一种是和Adaboost类似的正则化项,即步长(learning rate)。

定义为ν,对于前面的弱学习器的迭代

如果加上正则化项,则有

v的取值范围为 .对于同样的训练集学习效果,较小的v意味着需要更多的弱学习器的迭代次数。通常用步长和迭代最大次数一起来决定算法的拟合效果。

第二种正则化的方式是通过子采样比例(subsample)。取值为(0,1]。

注意这里的子采样和随机森林不一样,随机森林使用的是放回抽样,而这里是不放回抽样。如果取值为1,则全部样本都使用,等于没有使用子采样。如果取值小于1,则只有一部分样本会去做GBDT的决策树拟合。选择小于1的比例可以减少方差,即防止过拟合,但是会增加样本拟合的偏差,因此取值不能太低。推荐在[0.5, 0.8]之间。

使用了子采样的GBDT有时也称作随机梯度提升树(Stochastic Gradient Boosting Tree, SGBT)。由于使用了子采样,程序可以通过采样分发到不同的任务去做boosting的迭代过程,最后形成新树,从而减少弱学习器难以并行学习的弱点。

第三种是对于弱学习器即CART回归树进行正则化剪枝。

7 GBDT小结

目前GBDT的算法比较好的库是xgboost。scikit-learn也可以。

最后总结下GBDT的优缺点。

GBDT主要的优点有:

(1)可以灵活处理各种类型的数据,包括连续值和离散值。

(2)在相对少的调参时间情况下,预测的准备率也可以比较高。这个是相对SVM来说的。

(3)使用一些健壮的损失函数,对异常值的鲁棒性非常强。比如 Huber损失函数和Quantile损失函数。

GBDT的主要缺点有:

由于弱学习器之间存在依赖关系,难以并行训练数据。不过可以通过自采样的SGBT来达到部分并行。

8 scikit-learn GBDT类库概述

在sacikit-learn中,GradientBoostingClassifier为GBDT的分类类, 而GradientBoosting Regressor为GBDT的回归类。两者的参数类型完全相同,有些参数比如损失函数loss的可选择项并不相同。这些参数中,类似于Adaboost,我们把重要参数分为两类,第一类是Boosting框架的重要参数,第二类是弱学习器即CART回归树的重要参数。

9 GBDT类库boosting框架参数

首先,我们来看boosting框架相关的重要参数。由于GradientBoostingClassifier和GradientBoostingRegressor的参数绝大部分相同,我们下面会一起来讲,不同点会单独指出。

(1) n_estimators: 也就是弱学习器的最大迭代次数,或者说最大的弱学习器的个数。一般来说n_estimators太小,容易欠拟合,n_estimators太大,又容易过拟合,一般选择一个适中的数值。默认是100。在实际调参的过程中,我们常常将n_estimators和下面介绍的参数learning_rate一起考虑。

(2) learning_rate: 即每个弱学习器的权重缩减系数ν,也称作步长,加上了正则化项,我们的强学习器的迭代公式为 。v的取值范围为

.

对于同样的训练集拟合效果,较小的ν意味着我们需要更多的弱学习器的迭代次数。通常我们用步长和迭代最大次数一起来决定算法的拟合效果。所以这两个参数n_estimators和learning_rate要一起调参。一般来说,可以从一个小一点的ν开始调参,默认是1。

(3)subsample: 子采样,取值为(0,1]。注意这里的子采样和随机森林不一样,随机森林使用的是放回抽样,而这里是不放回抽样。如果取值为1,则全部样本都使用,等于没有使用子采样。如果取值小于1,则只有一部分样本会去做GBDT的决策树拟合。选择小于1的比例可以减少方差,即防止过拟合,但是会增加样本拟合的偏差,因此取值不能太低。推荐在[0.5, 0.8]之间,默认是1.0,即不使用子采样。

(4)init: 即我们的初始化的时候的弱学习器,如果不输入,则用训练集样本来做样本集的初始化分类回归预测。否则用init参数提供的学习器做初始化分类回归预测。一般用在我们对数据有先验知识,或者之前做过一些拟合的时候,如果没有的话就不用管这个参数了。

(5)loss: 即我们GBDT算法中的损失函数。分类模型和回归模型的损失函数是不一样的。

对于分类模型,有对数似然损失函数"deviance"和指数损失函数"exponential"两者输入选择。默认是对数似然损失函数"deviance"。一般来说,推荐使用默认的"deviance"。它对二元分离和多元分类各自都有比较好的优化。而指数损失函数等于把我们带到了Adaboost算法。

对于回归模型,有均方差"ls", 绝对损失"lad", Huber损失"huber"和分位数损失“quantile”。默认是均方差"ls"。一般来说,如果数据的噪音点不多,用默认的均方差"ls"比较好。如果是噪音点较多,则推荐用抗噪音的损失函数"huber"。而如果我们需要对训练集进行分段预测的时候,则采用“quantile”。

(6)alpha:这个参数只有GradientBoostingRegressor有,当我们使用Huber损失"huber"和分位数损失“quantile”时,需要指定分位数的值。默认是0.9,如果噪音点较多,可以适当降低这个分位数的值。

10 GBDT类库弱学习器参数

由于GBDT使用了CART回归决策树,因此它的参数基本来源于决策树类,也就是说,和DecisionTreeClassifier和DecisionTreeRegressor的参数基本类似。

(1)划分时考虑的最大特征数max_features: 可以使用很多种类型的值,默认是"None",意味着划分时考虑所有的特征数;如果是"log2"意味着划分时最多考虑 个特征;如果是 "sqrt"或者"auto"意味着划分时最多考虑

个特征。如果是整数,代表考虑的特征绝对数。如果是浮点数,代表考虑特征百分比,即考虑(百分比xN)取整后的特征数。其中N为样本总特征数。一般来说,如果样本特征数不多,比如小于50,我们用默认的"None"就可以了,如果特征数非常多,我们可以灵活使用刚才描述的其他取值来控制划分时考虑的最大特征数,以控制决策树的生成时间。

(2)决策树最大深度max_depth: 默认可以不输入,如果不输入的话,决策树在建立子树的时候不会限制子树的深度。一般来说,数据少或者特征少的时候可以不管这个值。如果模型样本量多,特征也多的情况下,推荐限制这个最大深度,具体的取值取决于数据的分布。常用的可以取值10-100之间。

(3)内部节点再划分所需最小样本数min_samples_split: 这个值限制了子树继续划分的条件,如果某节点的样本数少于min_samples_split,则不会继续再尝试选择最优特征来进行划分。 默认是2.如果样本量不大,不需要管这个值。如果样本量数量级非常大,则推荐增大这个值。

(4)叶子节点最少样本数min_samples_leaf: 这个值限制了叶子节点最少的样本数,如果某叶子节点数目小于样本数,则会和兄弟节点一起被剪枝。 默认是1,可以输入最少的样本数的整数,或者最少样本数占样本总数的百分比。如果样本量不大,不需要管这个值。如果样本量数量级非常大,则推荐增大这个值。

(5)叶子节点最小的样本权重和min_weight_fraction_leaf:这个值限制了叶子节点所有样本权重和的最小值,如果小于这个值,则会和兄弟节点一起被剪枝。 默认是0,就是不考虑权重问题。一般来说,如果我们有较多样本有缺失值,或者分类树样本的分布类别偏差很大,就会引入样本权重,这时我们就要注意这个值了。

(6)最大叶子节点数max_leaf_nodes: 通过限制最大叶子节点数,可以防止过拟合,默认是"None”,即不限制最大的叶子节点数。如果加了限制,算法会建立在最大叶子节点数内最优的决策树。如果特征不多,可以不考虑这个值,但是如果特征分成多的话,可以加以限制,具体的值可以通过交叉验证得到。

(7)节点划分最小不纯度min_impurity_split: 这个值限制了决策树的增长,如果某节点的不纯度(基于基尼系数,均方差)小于这个阈值,则该节点不再生成子节点。即为叶子节点 。一般不推荐改动默认值1e-7。

11 GBDT调参实例

用一个二元分类的例子来讲解下GBDT的调参。这个例子的数据有87000多行,单机跑会比较慢,下面的例子我只选择了它的前面20000行。

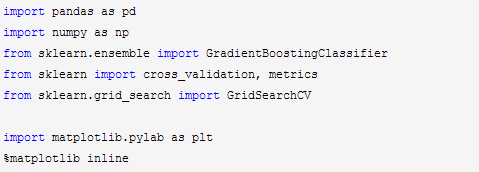

首先,载入需要的类库:

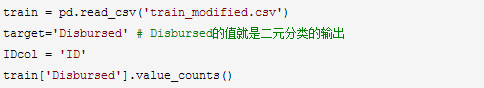

接着,把解压的数据用下面的代码载入,观察数据的类别分布。

可以看到类别输出如下,也就是类别0的占大多数。

0 19680

1 320

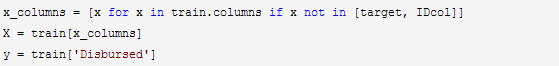

得到训练集,最后一列Disbursed是分类输出。前面的所有列(不考虑ID列)都是样本特征。

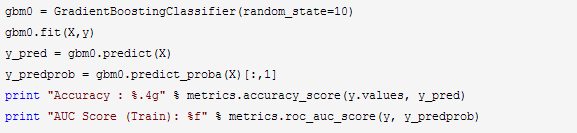

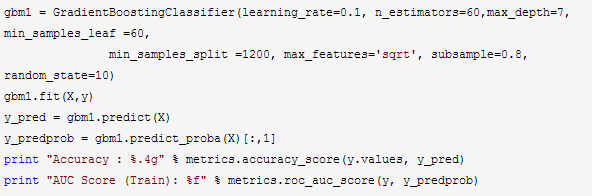

不管任何参数,都用默认的,拟合数据:

输出如下,可见拟合还可以,我们下面看看怎么通过调参提高模型的泛化能力。

Accuracy : 0.9852

AUC Score (Train): 0.900531

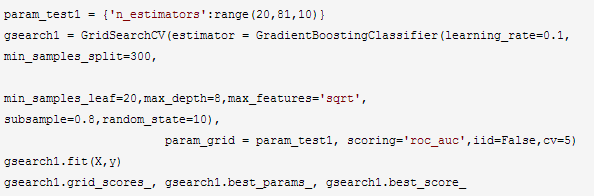

首先我们从步长(learning rate)和迭代次数(n_estimators)入手。一般来说,开始选择一个较小的步长来网格搜索最好的迭代次数。这里,我们将步长初始值设置为0.1。对于迭代次数进行网格搜索如下:

输出如下,可见最好的迭代次数是60。

([mean: 0.81285, std: 0.01967, params: {'n_estimators': 20},

mean: 0.81438, std: 0.01947, params: {'n_estimators': 30},

mean: 0.81451, std: 0.01933, params: {'n_estimators': 40},

mean: 0.81618, std: 0.01848, params: {'n_estimators': 50},

mean: 0.81751, std: 0.01736, params: {'n_estimators': 60},

mean: 0.81547, std: 0.01900, params: {'n_estimators': 70},

mean: 0.81299, std: 0.01860, params: {'n_estimators': 80}],

{'n_estimators': 60},

0.8175146087398375)

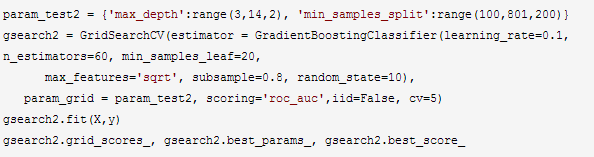

找到了一个合适的迭代次数,现在我们开始对决策树进行调参。首先我们对决策树最大深度max_depth和内部节点再划分所需最小样本数min_samples_split进行网格搜索。

输出如下,可见最好的最大树深度是7,内部节点再划分所需最小样本数是300。

([mean: 0.81199, std: 0.02073, params: {'min_samples_split': 100, 'max_depth': 3},

mean: 0.81267, std: 0.01985, params: {'min_samples_split': 300, 'max_depth': 3},

mean: 0.81238, std: 0.01937, params: {'min_samples_split': 500, 'max_depth': 3},

mean: 0.80925, std: 0.02051, params: {'min_samples_split': 700, 'max_depth': 3},

mean: 0.81846, std: 0.01843, params: {'min_samples_split': 100, 'max_depth': 5},

mean: 0.81630, std: 0.01810, params: {'min_samples_split': 300, 'max_depth': 5},

mean: 0.81315, std: 0.01898, params: {'min_samples_split': 500, 'max_depth': 5},

mean: 0.81262, std: 0.02090, params: {'min_samples_split': 700, 'max_depth': 5},

mean: 0.81807, std: 0.02004, params: {'min_samples_split': 100, 'max_depth': 7},

mean: 0.82137, std: 0.01733, params: {'min_samples_split': 300, 'max_depth': 7},

mean: 0.81703, std: 0.01773, params: {'min_samples_split': 500, 'max_depth': 7},

mean: 0.81383, std: 0.02327, params: {'min_samples_split': 700, 'max_depth': 7},

mean: 0.81107, std: 0.02178, params: {'min_samples_split': 100, 'max_depth': 9},

mean: 0.80944, std: 0.02612, params: {'min_samples_split': 300, 'max_depth': 9},

mean: 0.81476, std: 0.01973, params: {'min_samples_split': 500, 'max_depth': 9},

mean: 0.81601, std: 0.02576, params: {'min_samples_split': 700, 'max_depth': 9},

mean: 0.81091, std: 0.02227, params: {'min_samples_split': 100, 'max_depth': 11},

mean: 0.81309, std: 0.02696, params: {'min_samples_split': 300, 'max_depth': 11},

mean: 0.81713, std: 0.02379, params: {'min_samples_split': 500, 'max_depth': 11},

mean: 0.81347, std: 0.02702, params: {'min_samples_split': 700, 'max_depth': 11},

mean: 0.81444, std: 0.01813, params: {'min_samples_split': 100, 'max_depth': 13},

mean: 0.80825, std: 0.02291, params: {'min_samples_split': 300, 'max_depth': 13},

mean: 0.81923, std: 0.01693, params: {'min_samples_split': 500, 'max_depth': 13},

mean: 0.81382, std: 0.02258, params: {'min_samples_split': 700, 'max_depth': 13}],

{'max_depth': 7, 'min_samples_split': 300},

0.8213724275914632)

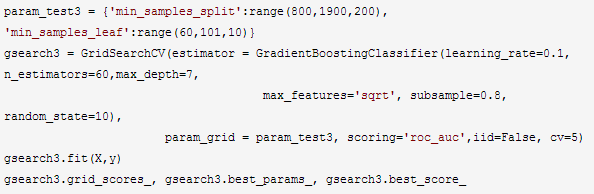

由于决策树深度7是一个比较合理的值,我们把它定下来,对于内部节点再划分所需最小样本数min_samples_split,我们暂时不能一起定下来,因为这个还和决策树其他的参数存在关联。下面我们再对内部节点再划分所需最小样本数min_samples_split和叶子节点最少样本数min_samples_leaf一起调参。

输出结果如下,可见这个min_samples_split在边界值,还有进一步调试小于边界60的必要。由于这里只是例子,所以大家可以自己下来用包含小于60的网格搜索来寻找合适的值。

([mean: 0.81828, std: 0.02251, params: {'min_samples_split': 800, 'min_samples_leaf': 60},

mean: 0.81731, std: 0.02344, params: {'min_samples_split': 1000, 'min_samples_leaf': 60},

mean: 0.82220, std: 0.02250, params: {'min_samples_split': 1200, 'min_samples_leaf': 60},

mean: 0.81447, std: 0.02125, params: {'min_samples_split': 1400, 'min_samples_leaf': 60},

mean: 0.81495, std: 0.01626, params: {'min_samples_split': 1600, 'min_samples_leaf': 60},

mean: 0.81528, std: 0.02140, params: {'min_samples_split': 1800, 'min_samples_leaf': 60},

mean: 0.81590, std: 0.02517, params: {'min_samples_split': 800, 'min_samples_leaf': 70},

mean: 0.81573, std: 0.02207, params: {'min_samples_split': 1000, 'min_samples_leaf': 70},

mean: 0.82021, std: 0.02521, params: {'min_samples_split': 1200, 'min_samples_leaf': 70},

mean: 0.81512, std: 0.01995, params: {'min_samples_split': 1400, 'min_samples_leaf': 70},

mean: 0.81395, std: 0.02081, params: {'min_samples_split': 1600, 'min_samples_leaf': 70},

mean: 0.81587, std: 0.02082, params: {'min_samples_split': 1800, 'min_samples_leaf': 70},

mean: 0.82064, std: 0.02698, params: {'min_samples_split': 800, 'min_samples_leaf': 80},

mean: 0.81490, std: 0.02475, params: {'min_samples_split': 1000, 'min_samples_leaf': 80},

mean: 0.82009, std: 0.02568, params: {'min_samples_split': 1200, 'min_samples_leaf': 80},

mean: 0.81850, std: 0.02226, params: {'min_samples_split': 1400, 'min_samples_leaf': 80},

mean: 0.81855, std: 0.02099, params: {'min_samples_split': 1600, 'min_samples_leaf': 80},

mean: 0.81666, std: 0.02249, params: {'min_samples_split': 1800, 'min_samples_leaf': 80},

mean: 0.81960, std: 0.02437, params: {'min_samples_split': 800, 'min_samples_leaf': 90},

mean: 0.81560, std: 0.02235, params: {'min_samples_split': 1000, 'min_samples_leaf': 90},

mean: 0.81936, std: 0.02542, params: {'min_samples_split': 1200, 'min_samples_leaf': 90},

mean: 0.81362, std: 0.02254, params: {'min_samples_split': 1400, 'min_samples_leaf': 90},

mean: 0.81429, std: 0.02417, params: {'min_samples_split': 1600, 'min_samples_leaf': 90},

mean: 0.81299, std: 0.02262, params: {'min_samples_split': 1800, 'min_samples_leaf': 90},

mean: 0.82000, std: 0.02511, params: {'min_samples_split': 800, 'min_samples_leaf': 100},

mean: 0.82209, std: 0.01816, params: {'min_samples_split': 1000, 'min_samples_leaf': 100},

mean: 0.81821, std: 0.02337, params: {'min_samples_split': 1200, 'min_samples_leaf': 100},

mean: 0.81922, std: 0.02377, params: {'min_samples_split': 1400, 'min_samples_leaf': 100},

mean: 0.81545, std: 0.02221, params: {'min_samples_split': 1600, 'min_samples_leaf': 100},

mean: 0.81704, std: 0.02509, params: {'min_samples_split': 1800, 'min_samples_leaf': 100}],

{'min_samples_leaf': 60, 'min_samples_split': 1200},

0.8222032996697154)

现在我们用新参数拟合数据:

输出如下:

Accuracy : 0.984

AUC Score (Train): 0.908099

对比我们最开始完全不调参的拟合效果,可见精确度稍有下降,主要原理是我们使用了0.8的子采样,20%的数据没有参与拟合。

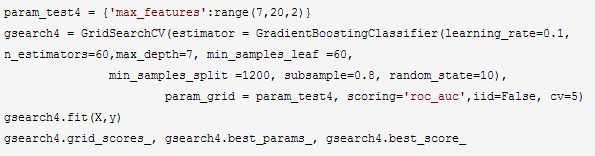

现在我们再对最大特征数max_features进行网格搜索。

输出如下:

([mean: 0.82220, std: 0.02250, params: {'max_features': 7},

mean: 0.82241, std: 0.02421, params: {'max_features': 9},

mean: 0.82108, std: 0.02302, params: {'max_features': 11},

mean: 0.82064, std: 0.01900, params: {'max_features': 13},

mean: 0.82198, std: 0.01514, params: {'max_features': 15},

mean: 0.81355, std: 0.02053, params: {'max_features': 17},

mean: 0.81877, std: 0.01863, params: {'max_features': 19}],

{'max_features': 9},

0.822412506351626)

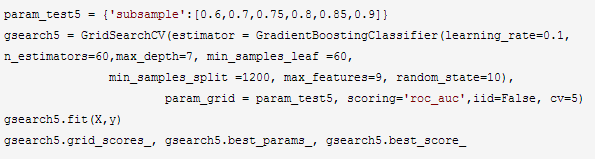

现在我们再对子采样的比例进行网格搜索:

输出如下:

([mean: 0.81828, std: 0.02392, params: {'subsample': 0.6},

mean: 0.82344, std: 0.02708, params: {'subsample': 0.7},

mean: 0.81673, std: 0.02196, params: {'subsample': 0.75},

mean: 0.82241, std: 0.02421, params: {'subsample': 0.8},

mean: 0.82285, std: 0.02446, params: {'subsample': 0.85},

mean: 0.81738, std: 0.02236, params: {'subsample': 0.9}],

{'subsample': 0.7},

0.8234378969766262)

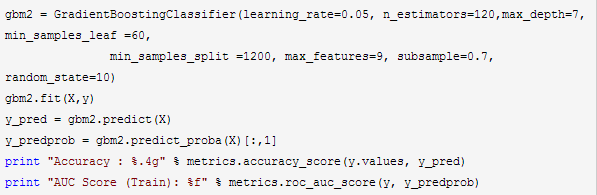

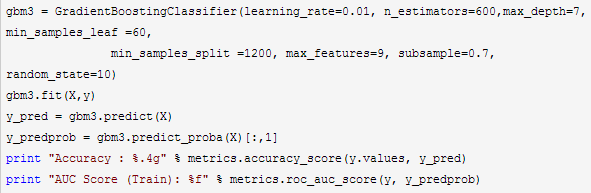

现在我们基本已经得到我们所有调优的参数结果了。这时我们可以减半步长,最大迭代次数加倍来增加我们模型的泛化能力。再次拟合我们的模型:

输出如下:

Accuracy : 0.984

AUC Score (Train): 0.905324

可以看到AUC分数比起之前的版本稍有下降,这个原因是我们为了增加模型泛化能力,为防止过拟合而减半步长,最大迭代次数加倍,同时减小了子采样的比例,从而减少了训练集的拟合程度。

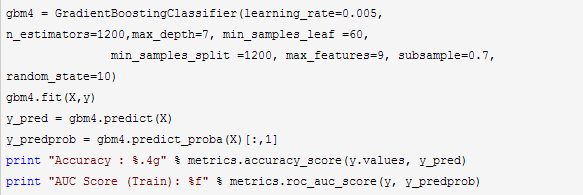

下面我们继续将步长缩小5倍,最大迭代次数增加5倍,继续拟合我们的模型:

输出如下,可见减小步长增加迭代次数可以在保证泛化能力的基础上增加一些拟合程度。

Accuracy : 0.984

AUC Score (Train): 0.908581

最后我们继续步长缩小一半,最大迭代次数增加2倍,拟合我们的模型:

输出如下,此时由于步长实在太小,导致拟合效果反而变差,也就是说,步长不能设置的过小。

Accuracy : 0.984

AUC Score (Train): 0.908232

以上就是GBDT调参的一个总结。

梯度提升树GBDT算法的更多相关文章

- 机器学习 之梯度提升树GBDT

目录 1.基本知识点简介 2.梯度提升树GBDT算法 2.1 思路和原理 2.2 梯度代替残差建立CART回归树 1.基本知识点简介 在集成学习的Boosting提升算法中,有两大家族:第一是AdaB ...

- scikit-learn 梯度提升树(GBDT)调参小结

在梯度提升树(GBDT)原理小结中,我们对GBDT的原理做了总结,本文我们就从scikit-learn里GBDT的类库使用方法作一个总结,主要会关注调参中的一些要点. 1. scikit-learn ...

- 梯度提升树(GBDT)原理小结(转载)

在集成学习值Adaboost算法原理和代码小结(转载)中,我们对Boosting家族的Adaboost算法做了总结,本文就对Boosting家族中另一个重要的算法梯度提升树(Gradient Boos ...

- scikit-learn 梯度提升树(GBDT)调参笔记

在梯度提升树(GBDT)原理小结中,我们对GBDT的原理做了总结,本文我们就从scikit-learn里GBDT的类库使用方法作一个总结,主要会关注调参中的一些要点. 1. scikit-learn ...

- 梯度提升树(GBDT)原理小结

在集成学习之Adaboost算法原理小结中,我们对Boosting家族的Adaboost算法做了总结,本文就对Boosting家族中另一个重要的算法梯度提升树(Gradient Boosting De ...

- 笔记︱决策树族——梯度提升树(GBDT)

每每以为攀得众山小,可.每每又切实来到起点,大牛们,缓缓脚步来俺笔记葩分享一下吧,please~ --------------------------- 本笔记来源于CDA DSC,L2-R语言课程所 ...

- 机器学习(七)—Adaboost 和 梯度提升树GBDT

1.Adaboost算法原理,优缺点: 理论上任何学习器都可以用于Adaboost.但一般来说,使用最广泛的Adaboost弱学习器是决策树和神经网络.对于决策树,Adaboost分类用了CART分类 ...

- 梯度提升树GBDT总结

提升树的学习优化过程中,损失函数平方损失和指数损失时候,每一步优化相对简单,但对于一般损失函数优化的问题,Freidman提出了Gradient Boosting算法,其利用了损失函数的负梯度在当前模 ...

- 机器学习之梯度提升决策树GBDT

集成学习总结 简单易学的机器学习算法——梯度提升决策树GBDT GBDT(Gradient Boosting Decision Tree) Boosted Tree:一篇很有见识的文章 https:/ ...

随机推荐

- ubuntu安装中文输入法必看

ubuntu安装中文输入法必看以下两篇文章,按照顺序来做: http://www.2cto.com/os/201207/144189.html http://www.cnblogs.com/slide ...

- Mac SpotLight无法搜索

在终端运行如下命令: sudo mdutil -i on /

- sprint2(第六天)

昨天休息一天,今天继续做任务. 燃尽图:

- Beta阶段基于NABCD评论作品

组名:杨老师粉丝群 组长:乔静玉 组员:吴奕瑶 刘佳瑞 公冶令鑫 杨磊 刘欣 张宇 卢帝同 一.拉格朗日2018--<飞词> 1.1.NABCD分析 N(Need,需求):该小 ...

- beat冲刺(6/7)

目录 摘要 团队部分 个人部分 摘要 队名:小白吃 组长博客:hjj 作业博客:beta冲刺(6/7) 团队部分 后敬甲(组长) 过去两天完成了哪些任务 ppt制作 视频拍摄 接下来的计划 准备答辩 ...

- Keil MDK中的Code, RO-data , RW-data, ZI-data分别代表什么意思?(转)

一 基础知识 字节 8位半字 16位字 32位 二 解惑 Code, RO-data,RW-data,ZI-data Code为程序代码部分RO-data 表示 程序定义的常量const t ...

- js作用域相关笔记

1.js引擎.编译器.作用域. 引擎:负责JS全过程的编译和执行: 编译器:负责语法分析和代码生成: 作用域:负责收集并维护声明组成的查询,以及当前执行代码对这些变量的访问权限(简言之,作用域就是用于 ...

- C++操作mysql方法总结(3)

C++通过mysql++操作mysql的方式 使用vs2013和64位的msql 5.6.16进行操作 项目中使用的数据库名和表数据请参考C++操作mysql方法总结(1)中的介绍 Mysql ...

- n位格雷曼实现

参考: 格雷码的实现 问题:产生n位元的所有格雷码. 格雷码(Gray Code)是一个数列集合,每个数使用二进位来表示,假设使用n位元来表示每个数字,任两个数之间只有一个位元值不同. 例如以下为 ...

- maven编译,控制台中文乱码解决方案

如下图,在使用maven运行后,在控制台看到中文展示乱码 出现这个的原因是源码使用UTF-8,但是maven编译的时候使用GBK标准,如下图 为了让maven编译的时候使用UTF-8标准,使用在p ...