44.scrapy爬取链家网站二手房信息-2

全面采集二手房数据: 网站二手房总数据量为27650条,但有的参数字段会出现一些问题,因为只给返回100页数据,具体查看就需要去细分请求url参数去请求网站数据。

我这里大概的获取了一下筛选条件参数,一些存在问题也没做细化处理,大致的采集数据量为21096,实际19794条。 看一下执行完成结果:

{'downloader/exception_count': 199,

'downloader/exception_type_count/twisted.internet.error.NoRouteError': 192,

'downloader/exception_type_count/twisted.web._newclient.ResponseNeverReceived': 7,

'downloader/request_bytes': 9878800,

'downloader/request_count': 21096,

'downloader/request_method_count/GET': 21096,

'downloader/response_bytes': 677177525,

'downloader/response_count': 20897,

'downloader/response_status_count/200': 20832,

'downloader/response_status_count/301': 49,

'downloader/response_status_count/302': 11,

'downloader/response_status_count/404': 5,

'dupefilter/filtered': 53,

'finish_reason': 'finished',

'finish_time': datetime.datetime(2018, 11, 12, 8, 49, 42, 371235),

'httperror/response_ignored_count': 5,

'httperror/response_ignored_status_count/404': 5,

'log_count/DEBUG': 21098,

'log_count/ERROR': 298,

'log_count/INFO': 61,

'request_depth_max': 3,

'response_received_count': 20837,

'retry/count': 199,

'retry/reason_count/twisted.internet.error.NoRouteError': 192,

'retry/reason_count/twisted.web._newclient.ResponseNeverReceived': 7,

'scheduler/dequeued': 21096,

'scheduler/dequeued/memory': 21096,

'scheduler/enqueued': 21096,

'scheduler/enqueued/memory': 21096,

'spider_exceptions/TypeError': 298,

'start_time': datetime.datetime(2018, 11, 12, 7, 59, 52, 608383)}

2018-11-12 16:49:42 [scrapy.core.engine] INFO: Spider closed (finished)

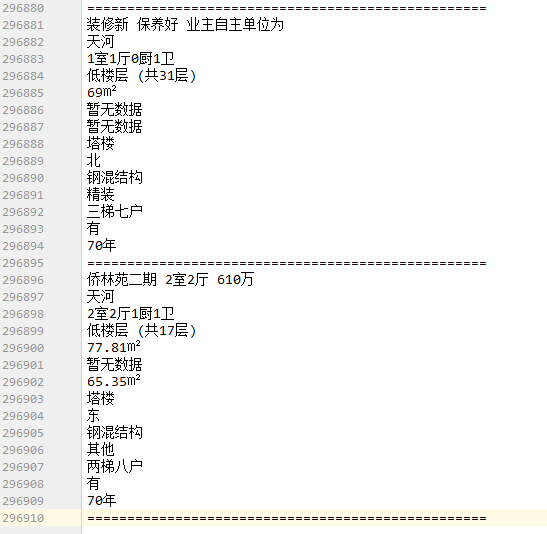

采集数据如图:

num = 296910/15=19794条

2. lianjia.py # -*- coding: utf-8 -*-

import scrapy class LianjiaSpider(scrapy.Spider):

name = 'lianjia'

allowed_domains = ['gz.lianjia.com']

start_urls = ['https://gz.lianjia.com/ershoufang/pg1/']

def parse(self, response):

for i in range(1,8):

for j in range(1,8):

url = 'https://gz.lianjia.com/ershoufang/p{}a{}pg1'.format(i,j)

yield scrapy.Request(url=url,callback=self.parse_detail) def parse_detail(self,response):

# 符合筛选条件的个数

counts = response.xpath("//h2[@class='total fl']/span/text()").extract_first().strip()

# print(counts) if int(counts)%30 >0:

p_num = int(counts)//30+1

# print(p_num)

# 拼接首页url

for k in range(1,p_num+1):

url = response.url

link_url = url.split('pg')[0]+'pg{}/'.format(k)

# print(link_url)

yield scrapy.Request(url=link_url,callback=self.parse_detail2) def parse_detail2(self,response):

#获取当前页面url

link_urls = response.xpath("//div[@class='info clear']/div[@class='title']/a/@href").extract()

for link_url in link_urls:

# print(link_url)

yield scrapy.Request(url=link_url,callback=self.parse_detail3)

# print('*'*100) def parse_detail3(self,response):

title = response.xpath("//div[@class='title']/h1[@class='main']/text()").extract_first()

print('标题: '+ title)

dist = response.xpath("//div[@class='areaName']/span[@class='info']/a/text()").extract_first()

print('所在区域: '+ dist)

contents = response.xpath("//div[@class='introContent']/div[@class='base']")

# print(contents)

house_type = contents.xpath("./div[@class='content']/ul/li[1]/text()").extract_first()

print('房屋户型: '+ house_type)

floor = contents.xpath("./div[@class='content']/ul/li[2]/text()").extract_first()

print('所在楼层: '+ floor)

built_area = contents.xpath("./div[@class='content']/ul/li[3]/text()").extract_first()

print('建筑面积: '+ built_area)

family_structure = contents.xpath("./div[@class='content']/ul/li[4]/text()").extract_first()

print('户型结构: '+ family_structure)

inner_area = contents.xpath("./div[@class='content']/ul/li[5]/text()").extract_first()

print('套内面积: '+ inner_area)

architectural_type = contents.xpath("./div[@class='content']/ul/li[6]/text()").extract_first()

print('建筑类型: '+ architectural_type)

house_orientation = contents.xpath("./div[@class='content']/ul/li[7]/text()").extract_first()

print('房屋朝向: '+ house_orientation)

building_structure = contents.xpath("./div[@class='content']/ul/li[8]/text()").extract_first()

print('建筑结构: '+ building_structure)

decoration_condition = contents.xpath("./div[@class='content']/ul/li[9]/text()").extract_first()

print('装修状况: '+ decoration_condition)

proportion = contents.xpath("./div[@class='content']/ul/li[10]/text()").extract_first()

print('梯户比例: '+ proportion)

elevator = contents.xpath("./div[@class='content']/ul/li[11]/text()").extract_first()

print('配备电梯: '+ elevator)

age_limit =contents.xpath("./div[@class='content']/ul/li[12]/text()").extract_first()

print('产权年限: '+ age_limit)

# try:

# house_label = response.xpath("//div[@class='content']/a/text()").extract_first()

# except:

# house_label = ''

# print('房源标签: ' + house_label)

with open('text2', 'a', encoding='utf-8')as f:

f.write('\n'.join(

[title,dist,house_type,floor,built_area,family_structure,inner_area,architectural_type,house_orientation,building_structure,decoration_condition,proportion,elevator,age_limit]))

f.write('\n' + '=' * 50 + '\n')

print('-'*100)

3.代码还需要细分的话,就多配置url的请求参数,缩小筛选范围,获取页面就更精准,就能避免筛选到过3000的数据类型,可以再去细分。

44.scrapy爬取链家网站二手房信息-2的更多相关文章

- 43.scrapy爬取链家网站二手房信息-1

首先分析:目的:采集链家网站二手房数据1.先分析一下二手房主界面信息,显示情况如下: url = https://gz.lianjia.com/ershoufang/pg1/显示总数据量为27589套 ...

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- python - 爬虫入门练习 爬取链家网二手房信息

import requests from bs4 import BeautifulSoup import sqlite3 conn = sqlite3.connect("test.db&qu ...

- python爬虫:利用BeautifulSoup爬取链家深圳二手房首页的详细信息

1.问题描述: 爬取链家深圳二手房的详细信息,并将爬取的数据存储到Excel表 2.思路分析: 发送请求--获取数据--解析数据--存储数据 1.目标网址:https://sz.lianjia.com ...

- Python的scrapy之爬取链家网房价信息并保存到本地

因为有在北京租房的打算,于是上网浏览了一下链家网站的房价,想将他们爬取下来,并保存到本地. 先看链家网的源码..房价信息 都保存在 ul 下的li 里面 爬虫结构: 其中封装了一个数据库处理模 ...

- Python爬取链家二手房源信息

爬取链家网站二手房房源信息,第一次做,仅供参考,要用scrapy. import scrapy,pypinyin,requests import bs4 from ..items import L ...

- python3 爬虫教学之爬取链家二手房(最下面源码) //以更新源码

前言 作为一只小白,刚进入Python爬虫领域,今天尝试一下爬取链家的二手房,之前已经爬取了房天下的了,看看链家有什么不同,马上开始. 一.分析观察爬取网站结构 这里以广州链家二手房为例:http:/ ...

- Scrapy实战篇(一)之爬取链家网成交房源数据(上)

今天,我们就以链家网南京地区为例,来学习爬取链家网的成交房源数据. 这里推荐使用火狐浏览器,并且安装firebug和firepath两款插件,你会发现,这两款插件会给我们后续的数据提取带来很大的方便. ...

- python爬虫:爬取链家深圳全部二手房的详细信息

1.问题描述: 爬取链家深圳全部二手房的详细信息,并将爬取的数据存储到CSV文件中 2.思路分析: (1)目标网址:https://sz.lianjia.com/ershoufang/ (2)代码结构 ...

随机推荐

- SQL2000服务端配置-如何让外网访问SQL2000

刚刚写了个DEMO,在内网来测试SQL2000后完全正常.现在想测试外网是否正常,毕竟路由器IP不固定,所以选择了路由器+花生壳免费域名(koma.5166.info),所以先安装花生壳客户端软件.下 ...

- Azure SQL Database (22) Azure SQL Database支持中文值

<Windows Azure Platform 系列文章目录> 在笔者之前的文章里,已经介绍了如何使Azure SQL Database支持中文: SQL Azure(七) 在SQL Az ...

- PL/SQL Developer 使用小技巧

1.PL/SQL Developer记住登陆密码 在使用PL/SQL Developer时,为了工作方便希望PL/SQL Developer记住登录Oracle的用户名和密码: 设置方法:tools- ...

- python的Socket网络编程

计算机网络: 多台独立的计算机用网络通信设备连接起来的网络.实现资源共享和数据传递.比如,我们之前的学过的知识可以将D盘的一个文件传到C盘,但如果你想从你的电脑传一个文件到我的电脑上目前是做不到的; ...

- hadoop 完全分布式安装

一个完全的hadoop分布式安装至少需要3个zookeeper,3个journalnode,3个datanode,2个namenode组成. 也就是说需要11个节点,但是我云主机有限,只有3个,所以把 ...

- es6 class函数的用法,及兼容程度

//es6中 class的新特性:面向对象的方式 class name{ fram(){ var div=document.getElementById("div"); div.s ...

- go中redis使用小结

最近做了个关于redis的项目,那么就整理下遇到和未遇到的问题 1.redis的简介安装 2.redis的数据结构 3.Redis基本使用 4.Redis的并发 5.Redis的落地 一.redis的 ...

- BGP属性+13条选路原则(转载)

原文:http://blog.sina.com.cn/s/blog_be409c2f0102x6sg.html BGP(Border Gateway Protocol)边界网关协议 BGP(Borde ...

- idea关闭标签快捷键修改----兼 常用实用快捷键

还有一个快捷键: 自动补全返回值 : ctrl + alt + v alt + enter: 自动添加未定义的方法 idea 原本的关闭快捷键是: ctrl + F4,但是不好用,谁的手指伸这么长 修 ...

- IBM MQ常用命令

常用命令 创建队列管理器crtmqm –q QMgrName-q是指创建缺省的队列管理器删除队列管理器dltmqm QmgrName启动队列管理器strmqm QmgrName如果是启动默认的队列管理 ...