Python爬虫连载2-reponse\parse简介

一、reponse解析

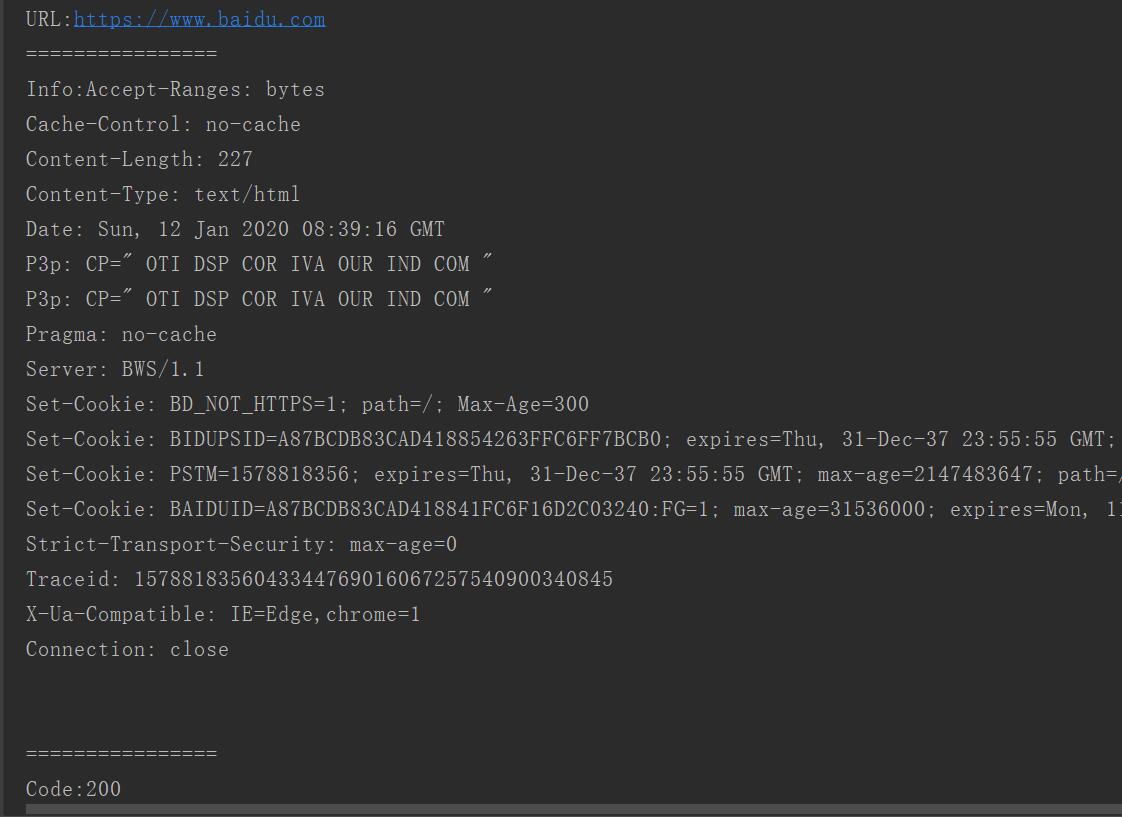

urlopen的返回对象

(1)geturl:返回网页地址

(2)info:请求反馈对象的meta信息

(3)getcode:返回的http code

from urllib import request

import chardet

"""

解析reponse

"""

if __name__ == "__main__":

url = "https://www.baidu.com"

rsp = request.urlopen(url)

print("URL:{0}".format(rsp.geturl()))#网页地址

print("================")

print("Info:{0}".format(rsp.info()))#网页头信息

print("================")

print("Code:{0}".format(rsp.getcode()))#请求后返回的状态码

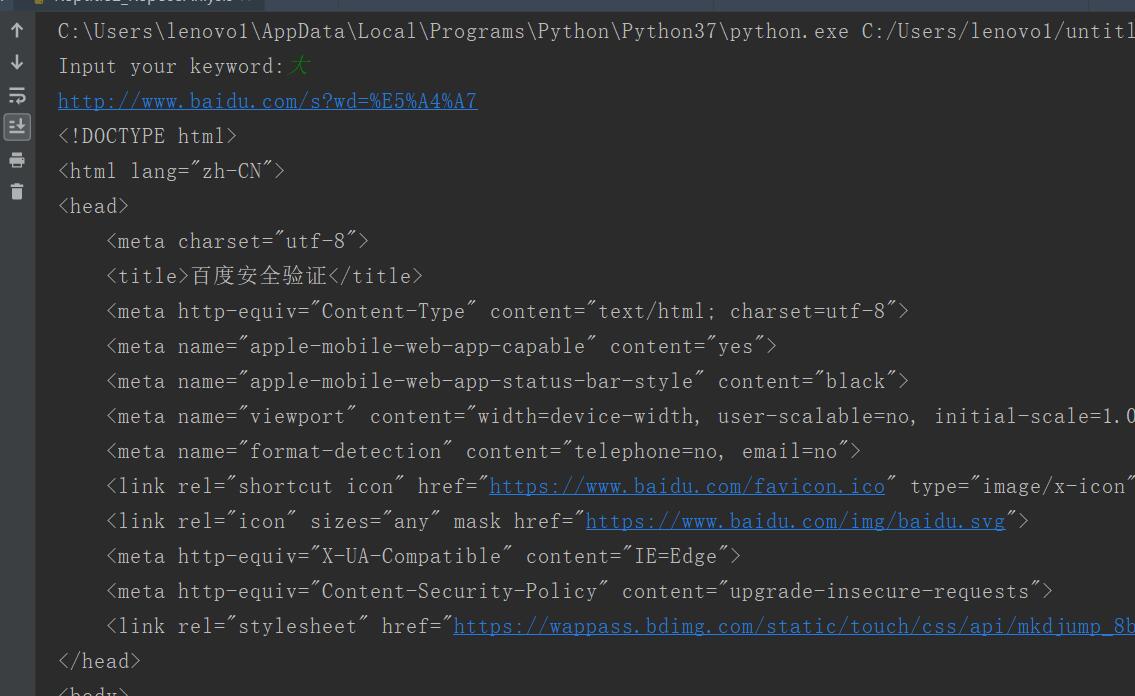

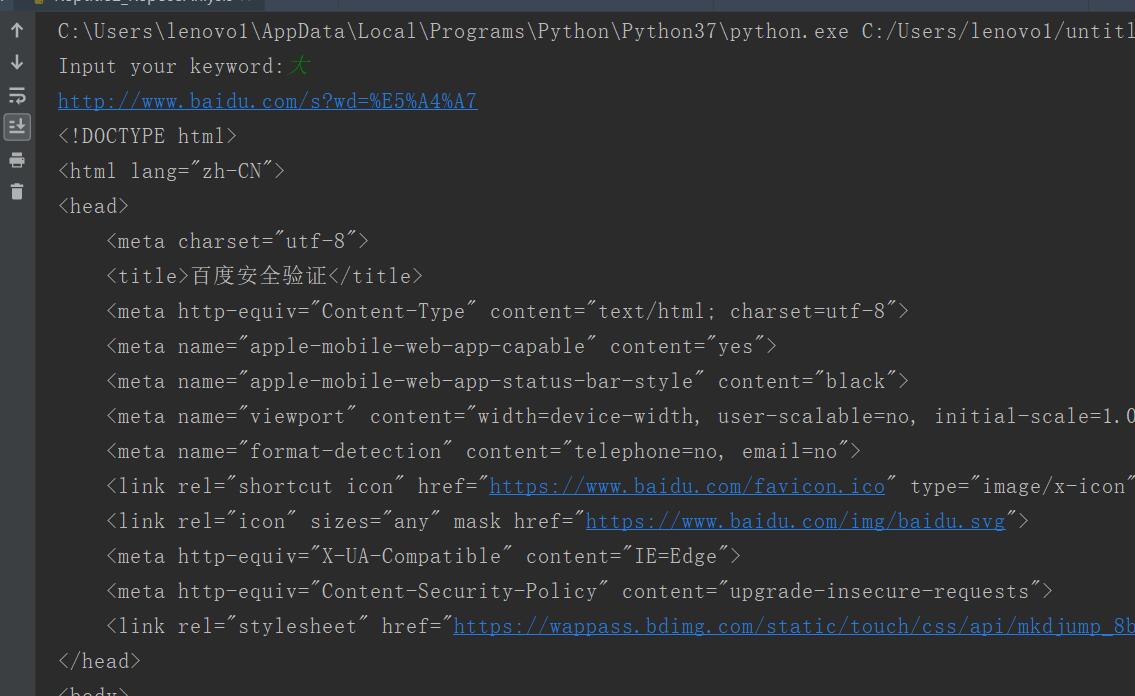

二、parse

1.request.date的使用

访问网络的两种方式

(1)get(2)post

2.url.parse用来解析url

from urllib import request,parse

import chardet

"""

解析reponse

"""

if __name__ == "__main__":

url = "http://www.baidu.com/s?"

wd = input("Input your keyword:")

#要想使用data,需要使用字典结构

qs = {

"wd":wd

}

#转换url编码

qs = parse.urlencode(qs)#对关键字进行编码

fullurl = url + qs#百度搜索传入的地址是基础地址加上关键字的编码形式

print(fullurl)

rsp = request.urlopen(fullurl)

html = rsp.read()

html = html.decode()#解码

#使用get取值保证不会出错

print(html)

三、源码

Reptile2_ReposeAnlysis.py

https://github.com/ruigege66/PythonReptile/blob/master/Reptile2_ReposeAnlysis.py

2.CSDN:https://blog.csdn.net/weixin_44630050(心悦君兮君不知-睿)

3.博客园:https://www.cnblogs.com/ruigege0000/

4.欢迎关注微信公众号:傅里叶变换,个人公众号,仅用于学习交流,后台回复”礼包“,获取大数据学习资料

Python爬虫连载2-reponse\parse简介的更多相关文章

- Python爬虫连载1-urllib.request和chardet包使用方式

一.参考资料 1.<Python网络数据采集>图灵工业出版社 2.<精通Python爬虫框架Scrapy>人民邮电出版社 3.[Scrapy官方教程](http://scrap ...

- Python爬虫连载10-Requests模块、Proxy代理

一.Request模块 1.HTTP for Humans,更简洁更友好 2.继承了urllib所有的特征 3.底层使用的是urllib3 4.开源地址:https://github.com/req ...

- Python爬虫连载9-JS加密之“盐”、ajax请求

一.JS加密之“盐” 1.salt属性“盐":多用于密码学,比如我们的银行卡是六位密码,但是实际上在银行的系统里,我们输入密码后,会给原始的密码添加若干字符,形成更加难以破解的密码.这个过 ...

- Python爬虫连载8-JS加密(一)

一.JS加密 1.有的反爬虫策略采用js对需要传输的数据进行加密处理. 2.经过加密,传输的就是密文 3.加密函数或者过程一定是在浏览器完成,也就是一定会把代码(js代码)暴露给使用者 4.通多阅读加 ...

- Python爬虫连载7-cookie的保存与读取、SSL讲解

一.cookie的保存与读取 1.cookie的保存-FileCookie.Jar from urllib import request,parse from http import cookieja ...

- Python爬虫入门:Urllib parse库使用详解(二)

文字转载:https://www.jianshu.com/p/e4a9e64082ef,转载内容仅供学习 如有侵权,请联系删除 获取url参数 urlparse 和 parse_qs ParseRes ...

- Python爬虫连载3-Post解析、Request类

一.访问网络的两种方法 1.get:利用参数给服务器传递信息:参数为dict,然后parse解码 2.post:一般向服务器传递参数使用:post是把信息自动加密处理:如果想要使用post信息,需要使 ...

- Python爬虫连载6-cookie深入使用实例化实现自动登录

一.使用cookie登录 1.直接把cookie复制下去,然后手动放到请求头 2.http模块包含一些关于cookie的模块,通过他们我们可以自动使用cookie (1)cookieJar 管理存储c ...

- Python爬虫连载5-Proxy、Cookie解析

一.ProxyHandler处理(代理服务器) 1.使用代理IP,是爬虫的常用手段 2.获取代理服务器的地址: www.xicidaili.com www.goubanjia.com 3.代理用来隐藏 ...

随机推荐

- VMware Workstation上新建虚拟机

准备开始,话不多少,直接上图 点击创建新的虚拟机或者在文件上面选择新建虚拟机 点击完成就可以了 后面的步骤,是在公司电脑上完成的,新建了一个CentOs1,步骤同上,后面继续,然后需要更改配置,点击虚 ...

- 一次C语言编程遇到的问题总结

今天用C语言做了一个简单的用户登录注册存取款等功能的系统,发现有很多功能并不会实现,大概是使用Java太多了导致许多C的知识都忘记了,现在把碰到的问题总结如下: 1.字符串复制问题 java等一些编程 ...

- Local-Pref(本地优先属性)路由本地优先术

Local-Pref(本地优先属性)路由本地优先术: ①:抓取感兴趣流量——前缀与访问——prefix and access ②:创建路由地图——router-map ③:第一法则——permit 1 ...

- 五十一、SAP中使程序结构化,模块化

一.我们创建3个引用单元,这3个单元里面分别存放定义相关,执行相关和子程序相关的内容 二.将程序中的各部分都拆分到INCLUDE文件中,DEF文件内容如下 三.INC文件内容 四.MAIN文件中写程序 ...

- JAVA - Intellij IDEA 中去掉mybatis Mapper.xml背景色

JAVA - Intellij IDEA 中去掉mybatis Mapper.xml背景色 1:现在公司中使用mybatis的频率非常高,一般都会用MBG来生成基础的代码文件.在intellij中查看 ...

- kafka源码系列之mysql数据增量同步到kafka

一,架构介绍 生产中由于历史原因web后端,mysql集群,kafka集群(或者其它消息队列)会存在一下三种结构. 1,数据先入mysql集群,再入kafka 数据入mysql集群是不可更改的,如何再 ...

- Day 20:网络编程(1)

什么是计算机网络? 指的是分布在不同地域的计算机,通过外部设备连接起来,实现资源共享与数据传输的计算机系统. 通信三要素: IP: IP地址 Internet上的每台主机(Host)都有一个唯一的IP ...

- python---函数作用域

1.作用域 local:局部作用域 E(Enclosing):闭包函数外的函数中 G(global): 全局作用域 B(Build-in):內建作用域 查找变量的顺序,从上到下 2.函数内的变 ...

- P1012 数字分类

转跳点:

- 76.Python中F表达式详解

F表达式是用来优化ORM操作数据库的. 举个例子:我们做口罩的公司要将所有员工的薪水增加2000元,如果按照正常的流程,应该是先从数据库中提取所有的员工的工资到Python内存中,然后使用Python ...