[js高手之路]Node.js+jade+mongodb+mongoose实现爬虫分离入库与生成静态文件

接着这篇文章[js高手之路]Node.js+jade抓取博客所有文章生成静态html文件继续,在这篇文章中实现了采集与静态文件的生成,在实际的采集项目中, 应该是先入库再选择性的生成静态文件。

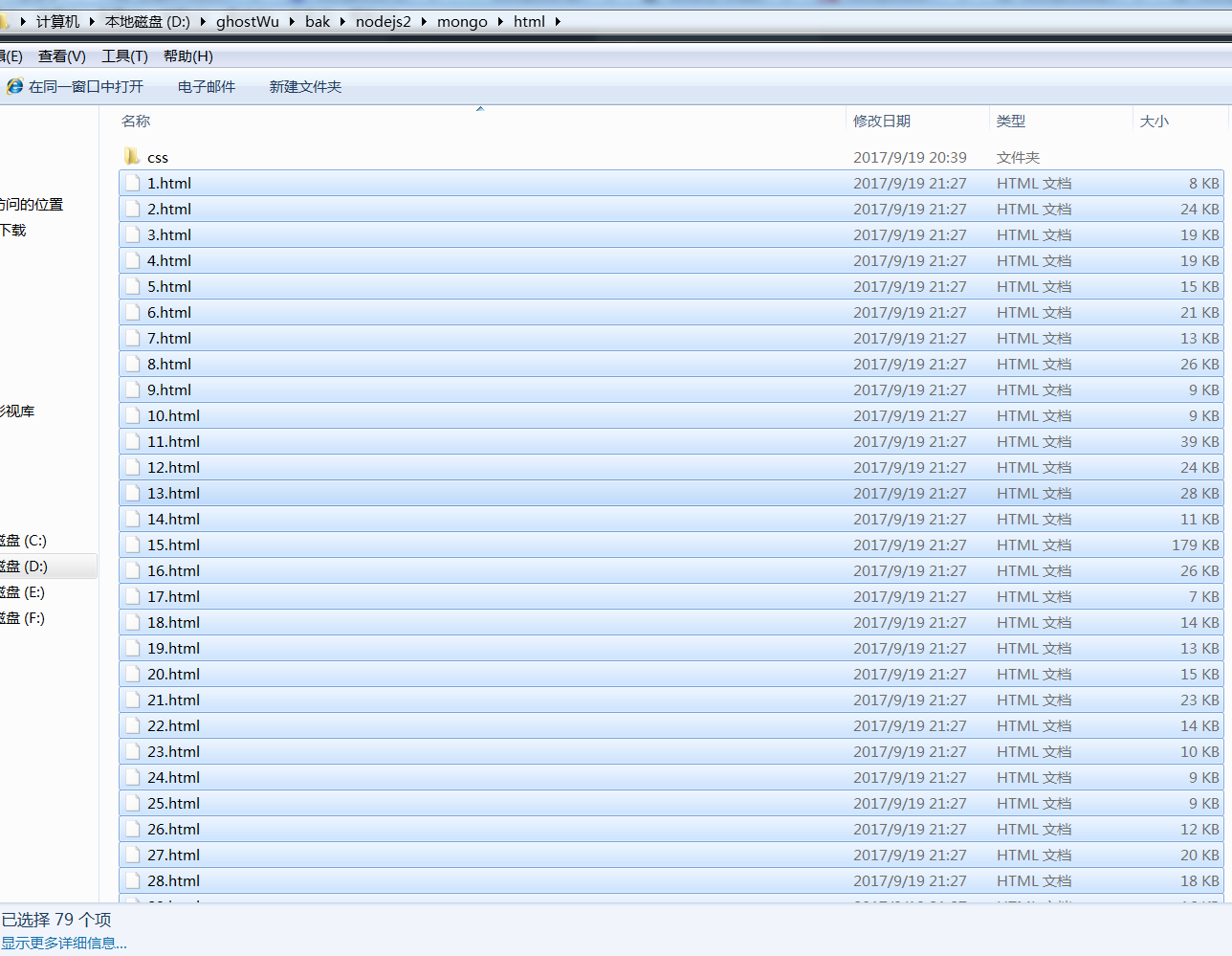

那么我选择的数据库是mongodb,为什么用这个数据库,因为这个数据库是基于集合,数据的操作基本是json,与dom模块cheerio具有非常大的亲和力,cheerio处理过滤出来的数据,可以直接插入mongodb,不需要经过任何的处理,非常的便捷,当然跟node.js的亲和力那就不用说了,更重要的是,性能很棒。这篇文章我就不具体写mongodb的基本用法,到时候会另起文章从0开始写mongodb基本常用用法.先看下入库的效果与生成静态文件的效果:

我在这个阶段,把爬虫分离成2个模块,采集入库( crawler.js ), 生成静态文件(makeHtml.js).

crawler.js:

var http = require('http');

var cheerio = require('cheerio');

var mongoose = require('mongoose');

mongoose.Promise = global.Promise;

var DB_URL = 'mongodb://localhost:27017/crawler';

var aList = []; //博客文章列表信息

var aUrl = []; //博客所有的文章url

var db = mongoose.createConnection(DB_URL);

db.on('connected', function (err) {

if (err) {

console.log(err);

} else {

console.log('db connected success');

}

});

var Schema = mongoose.Schema;

var arcSchema = new Schema({

id: Number, //文章id

title: String, //文章标题

url: String, //文章链接

body: String, //文章内容

entry: String, //摘要

listTime: Date //发布时间

});

var Article = db.model('Article', arcSchema);

function saveArticle(arcInfo) {

var arcModel = new Article(arcInfo);

arcModel.save(function (err, result) {

if (err) {

console.log(err);

} else {

console.log(`${arcInfo['title']} 插入成功`);

}

});

}

function filterArticle(html) {

var $ = cheerio.load(html);

var arcDetail = {};

var title = $("#cb_post_title_url").text();

var href = $("#cb_post_title_url").attr("href");

var re = /\/(\d+)\.html/;

var id = href.match(re)[1];

var body = $("#cnblogs_post_body").html();

return {

id: id,

title: title,

url: href,

body: body

};

}

function crawlerArc(url) {

var html = '';

var str = '';

var arcDetail = {};

http.get(url, function (res) {

res.on('data', function (chunk) {

html += chunk;

});

res.on('end', function () {

arcDetail = filterArticle(html);

saveArticle(arcDetail);

if ( aUrl.length ) {

setTimeout(function () {

if (aUrl.length) {

crawlerArc(aUrl.shift());

}

}, 100);

}else {

console.log( '采集任务完成' );

return;

}

});

});

}

function filterHtml(html) {

var $ = cheerio.load(html);

var arcList = [];

var aPost = $("#content").find(".post-list-item");

aPost.each(function () {

var ele = $(this);

var title = ele.find("h2 a").text();

var url = ele.find("h2 a").attr("href");

ele.find(".c_b_p_desc a").remove();

var entry = ele.find(".c_b_p_desc").text();

ele.find("small a").remove();

var listTime = ele.find("small").text();

var re = /\d{4}-\d{2}-\d{2}\s*\d{2}[:]\d{2}/;

listTime = listTime.match(re)[0];

arcList.push({

title: title,

url: url,

entry: entry,

listTime: listTime

});

});

return arcList;

}

function nextPage(html) {

var $ = cheerio.load(html);

var nextUrl = $("#pager a:last-child").attr('href');

if (!nextUrl) return getArcUrl(aList);

var curPage = $("#pager .current").text();

if (!curPage) curPage = 1;

var nextPage = nextUrl.substring(nextUrl.indexOf('=') + 1);

if (curPage < nextPage) crawler(nextUrl);

}

function crawler(url) {

http.get(url, function (res) {

var html = '';

res.on('data', function (chunk) {

html += chunk;

});

res.on('end', function () {

aList.push(filterHtml(html));

nextPage(html);

});

});

}

function getArcUrl(arcList) {

for (var key in arcList) {

for (var k in arcList[key]) {

aUrl.push(arcList[key][k]['url']);

}

}

crawlerArc(aUrl.shift());

}

var url = 'http://www.cnblogs.com/ghostwu/';

crawler(url);

其他的核心模块没有怎么改动,主要增加了数据库连接,数据库创建,集合创建( 集合相当于关系型数据库中的表 ),Schema( 相当于关系型数据库的表结构 ).

mongoose操作数据库( save:插入数据 ).分离了文件生成模块. makeHtml.js文件

var fs = require('fs');

var jade = require('jade');

var mongoose = require('mongoose');

mongoose.Promise = global.Promise;

var DB_URL = 'mongodb://localhost:27017/crawler';

var allArc = [];

var count = 0;

var db = mongoose.createConnection(DB_URL);

db.on('connected', function (err) {

if (err) {

console.log(err);

} else {

console.log('db connected success');

}

});

var Schema = mongoose.Schema;

var arcSchema = new Schema({

id: Number, //文章id

title: String, //文章标题

url: String, //文章链接

body: String, //文章内容

entry: String, //摘要

listTime: Date //发布时间

});

var Article = db.model('Article', arcSchema);

function makeHtml(arcDetail) {

str = jade.renderFile('./views/layout.jade', arcDetail);

++count;

fs.writeFile('./html/' + count + '.html', str, function (err) {

if (err) {

console.log(err);

}

console.log( `${arcDetail['id']}.html创建成功` + count );

if ( allArc.length ){

setTimeout( function(){

makeHtml( allArc.shift() );

}, 100 );

}

});

}

function getAllArc(){

Article.find( {}, function( err, arcs ){

allArc = arcs;

makeHtml( allArc.shift() );

} ).sort( { 'id' : 1 } );

}

getAllArc();

[js高手之路]Node.js+jade+mongodb+mongoose实现爬虫分离入库与生成静态文件的更多相关文章

- [js高手之路]Node.js+jade+mongoose实战todolist(分页,ajax编辑,删除)

该系列文章索引: [js高手之路]node js系列课程-创建简易web服务器与文件读写 [js高手之路]node js系列课程-图解express+supervisor+ejs用法 [js高手之路] ...

- [js高手之路]Node.js+jade抓取博客所有文章生成静态html文件

这个周末,恶补了一下jade模板引擎,就为生成静态html文件,这篇文章需要知道jade以及看过我的上篇文章,我先给出他们的参考链接: [js高手之路]Node.js模板引擎教程-jade速学与实战1 ...

- [js高手之路]Node.js+jade+express+mongodb+mongoose+promise实现todolist

promise主要是用来解决异步回调问题,其实还有好几种比promise更好的方案,后面再说,这节,我们先用promise来改造下,我以前写的一篇文章[js高手之路]javascript腾讯面试题学习 ...

- [js高手之路]Node.js实现简易的爬虫-抓取博客文章列表信息

抓取目标:就是我自己的博客:http://www.cnblogs.com/ghostwu/ 需要实现的功能: 抓取文章标题,超链接,文章摘要,发布时间 需要用到的库: node.js自带的http库 ...

- [js高手之路]Node.js实现简易的爬虫-抓取博客所有文章列表信息

抓取目标:就是我自己的博客:http://www.cnblogs.com/ghostwu/ 需要实现的功能: 抓取博客所有的文章标题,超链接,文章摘要,发布时间 需要用到的库: node.js自带的h ...

- [js高手之路]Node.js模板引擎教程-jade速学与实战2-流程控制,转义与非转义

一.转义与非转义 jade模板文件代码: doctype html html head meta(charset='utf-8') title jade学习-by ghostwu body h3 转义 ...

- [js高手之路]Node.js模板引擎教程-jade速学与实战1

环境准备: 全局安装jade: npm install jade -g 初始化项目package.json: npm init --yes 安装完成之后,可以使用 jade --help 查看jade ...

- [js高手之路]Node.js模板引擎教程-jade速学与实战1-基本用法

环境准备: 全局安装jade: npm install jade -g 初始化项目package.json: npm init --yes 安装完成之后,可以使用 jade --help 查看jade ...

- [js高手之路]node js系列课程-图解express+supervisor+ejs用法

上文通过node js自带的http模块搭建了一个简易的服务器,实际在开发中,一般用的是express框架,本文我们就来讲讲项目开发中必备不可少的几样东西: 服务器( express ) 路由( ex ...

随机推荐

- Promise与异步

不知道promise,大家现在用了吗?如果还不了解的话,今天就来对了-基础的了解起来- 正文从这开始- 接触过promise的的都知道它的应用场景和用途,Promise可以用来避免异步操作函数里的嵌套 ...

- js与php的区别

1 . PHP拼字符串用的是点. js用+号.2. php文件要放在wamp文件里面的www里面.3. php与js的嵌入方式相同,只是嵌入的标记不一样.4. php输出语法用 ...

- JVM堆内存设置

今天碰到了一个题目,讲的是关于堆内存的问题,题目如下 下面哪种情况会导致持久区jvm堆内存溢出? A.循环上万次的字符串处理 B.在一段代码内申请上百M甚至上G的内存 C.使用CGLib技术直接操 ...

- C/C++ 定义与声明详解(转)

转自:http://blog.csdn.net/xiaoyusmile/article/details/5420252 1. 变量的定义.声明 变量的声明有两种情况: 一种是需要建立存储空间的.例如: ...

- python爬虫之有道翻译

import urllib.request import urllib.parse import json class Translate(): def __init__(self): ...

- fatal error LNK1201:写入程序数据库“***.pdb”时出错;请检查是否是磁盘空间不足、路径无效或权限不够

问题很简单,是因为你的程序正在运行,或者windbg工具在执行dump文件,文件被占用,所以无法写入:

- 【译】StackExchange.Redis中文使用文档

StackExchange.Redis中文使用文档 Intro 最近想深入学习一些 Redis 相关的东西.于是看了看官方的项目StackExchange.Redis,发现里面有一份文档,于是打算翻译 ...

- Django 模板.html中 href参数传入

在Django模板中可能会出现访问多个URL指向同一函数,为减少代码可以利用正则表达式实现 url(r'^remove_userinfo(?P<nid>\d+)/',views.remov ...

- JavaScript 30 - 1 学习笔记

学习JavaScirpt30的笔记! ...虽然英语不是很好,但是跟着来还是学到了一些东西. 1-------> JavaScirpt Drum Kit 功能是这样的 ,敲击键盘上面的按钮, ...

- JS判断当前使用设备是pc端还是web端(转MirageFireFox)

js判断当前设备 最近用bootstrap做自适应,发现仍然很难很好的兼容web端和PC端的现实. 仔细观察百度,淘宝,京东等大型网站,发现这些网站都有对应不同客户端的子站. 站点 PC端url we ...