python_selenium智联搜索

python_selenium智联搜索

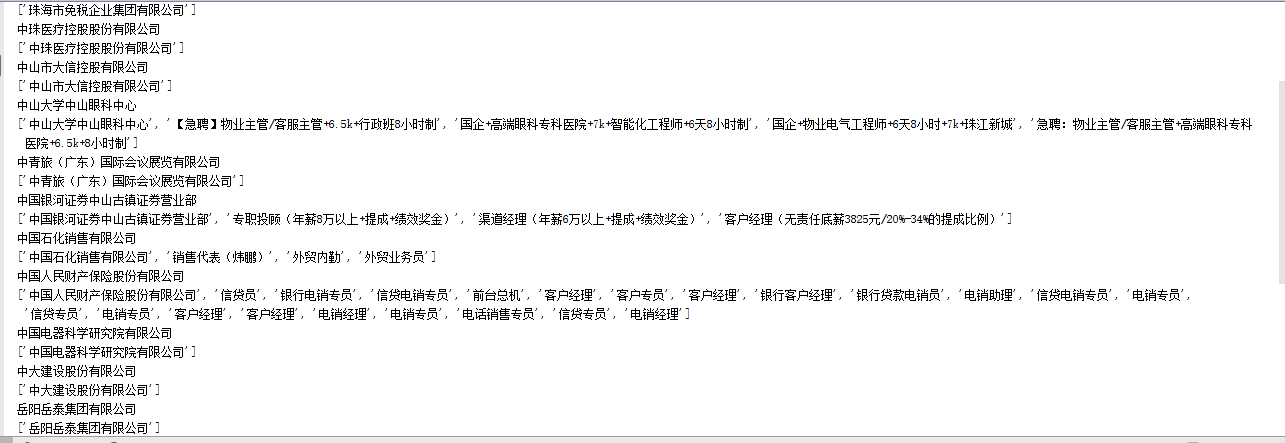

去招聘会工作,奈何网上仅仅提供招聘会的公司名字,没有提供招聘的职位,SO我写了个小代码给别人在智联上面搜索职位,由于时间紧迫,前程的就不写了

#!/usr/bin/python3.4

# -*- coding: utf-8 -*-

from selenium import webdriver

from lxml import etree

import time

# 打开浏览器

def openbrowser(keyword):

global browser

# 打开谷歌浏览器

# Firefox()

# Chrome()

# browser = webdriver.Chrome()

options = webdriver.ChromeOptions()

prefs = {

'profile.default_content_setting_values': {

'images': 2

}

}

options.add_experimental_option('prefs', prefs)

browser = webdriver.Chrome(chrome_options=options)

try:

browser.find_element_by_id("KeyWord_kw2").send_keys(keyword)

browser.find_element_by_class_name("doSearch").click()

time.sleep(5)

htmlcontent = browser.page_source

browser.quit()

except:

url = "http://www.zhaopin.com/"

browser.get(url)

# 打开浏览器时间

# print("等待10秒打开浏览器...")

# time.sleep(10)

browser.find_element_by_id("KeyWord_kw2").send_keys(keyword)

browser.find_element_by_class_name("doSearch").click()

time.sleep(5)

htmlcontent = browser.page_source

browser.quit()

return htmlcontent

def analyzehtml(html):

info = []

page = etree.HTML(html.lower())

hrefs = page.xpath('//a[@style="font-weight: bold"]/text()')

for href in hrefs:

info.append(href)

return info

if __name__ == "__main__":

file = open("../txt/company.txt")

companys = file.readlines()

for keyword in companys:

print(keyword.strip())

html = openbrowser(keyword.strip())

a = analyzehtml(html)

a.insert(0, str(keyword.strip()))

print(a)

b = "&&".join(a)

if len(b)==0:

b = "智联没有找到该公司"

filewrite = open("../txt/qwe.txt", "a")

filewrite.write("\n" + str(b))

filewrite.close()

python_selenium智联搜索的更多相关文章

- 用python抓取智联招聘信息并存入excel

用python抓取智联招聘信息并存入excel tags:python 智联招聘导出excel 引言:前一阵子是人们俗称的金三银四,跳槽的小朋友很多,我觉得每个人都应该给自己做一下规划,根据自己的进步 ...

- python爬虫实战(五)--------智联招聘网

前些天帮同事爬取一些智联招聘网上的关于数据分析的职位信息,他说要做一些数据分析看看,现在已经帮他爬完了.我本来想用Scrapy来爬的,但是不知道为什么爬取的数据和真实搜到的数据不太一样,比如:搜索到的 ...

- Python+selenium爬取智联招聘的职位信息

整个爬虫是基于selenium和Python来运行的,运行需要的包 mysql,matplotlib,selenium 需要安装selenium火狐浏览器驱动,百度的搜寻. 整个爬虫是模块化组织的,不 ...

- Java实例——基于jsoup的简单爬虫实现(从智联获取工作信息)

这几天在学习Java解析xml,突然想到Dom能不能解析html,结果试了半天行不通,然后就去查了一些资料,发现很多人都在用Jsoup解析html文件,然后研究了一下,写了一个简单的实例,感觉还有很多 ...

- python爬取智联招聘职位信息(单进程)

我们先通过百度搜索智联招聘,进入智联招聘官网,一看,傻眼了,需要登录才能查看招聘信息 没办法,用账号登录进去,登录后的网页如下: 输入职位名称点击搜索,显示如下网页: 把这个URL:https://s ...

- 异构智联Wi-Fi+蓝牙模组,连接快、准、稳!

下班回家打开门,电灯.电视.空调.音响.电动窗帘.扫地机器人--一呼百应,有序开工,原本冰冷的房子立刻变成了温暖港湾.可以说,舒适便捷的智能设备已经完全融入了我们的生活中. 从单一场景.单一设备,到现 ...

- 智联招聘 卓聘IM演进过程

1. 卓聘IM开发背景 智联卓聘是智联旗下高端人才招聘平台,成立快4年了,业务增涨每年以100%速度增涨,业务增涨快在开发和上线速度要求也比较高. 2016年6月提出IM开发需求,7月初上线,开发人 ...

- 智联卓聘 卓聘IM(聊聊)开发实践

1. 卓聘IM开发背景 智联卓聘是智联旗下高端人才招聘平台,成立快4年多,业务增涨每年以100%速度增涨快,同时对产品和研发速度都比较高. 2015年提出IM开发,主要用于后选人与猎头及时交流,降低 ...

- node.js 89行爬虫爬取智联招聘信息

写在前面的话, .......写个P,直接上效果图.附上源码地址 github/lonhon ok,正文开始,先列出用到的和require的东西: node.js,这个是必须的 request,然发 ...

随机推荐

- 把一个英语句子中的单词次序颠倒后输出。例如输入“how are you”,输出“you are how”;

import java.util.Scanner; public class Test2 { public void reverse(String str) { String[] wordArray ...

- window10的优缺点

windows10的体验随笔 为了体验科技前沿,前段时间升级了windows10 优点: 首先换了windows10就回不去了, 1.开始菜单的回归是众向所归,而且也加了迷你的一些菜单元素,值得称 ...

- SEO优化

SEO是由英文Search Engine Optimization缩写而来, 中文意译为“搜索引擎优化”.SEO是指从自然搜索结果获得网站流量的技术和过程,是在了解搜索引擎自然排名机制的基础上, 对网 ...

- JMeter 服务器性能监测插件介绍

简介 压力测试过程中,能够随时对负载服务器的健康状况的把控是相当重要的,有了这些数据,我们才能准确分析出服务器负载瓶颈.当你面对的是一个集群的时候,如果能了解到负载是否被正确分发,是不是一件很棒的事情 ...

- Java—工厂模式

工厂模式: public interface Cookie { public abstract void run (); } public abstract class CookieFactory { ...

- JAVA学习遇到的问题:接口实现

引用知乎看到对接口的总结: 接口就是个招牌比如说你饿了,看到前面有个挂着KFC的店,然后你想到可以进去买汉堡了.KFC就是接口,我们看到了这个接口,就知道这个店会卖汉堡(实现接口).那么为什么我们要去 ...

- Tomcat version 7.0 only support J2EE 1.2。。。。。。。

刚开始使用eclipse编程,换了eclipse版本后导入项目,出现下的报错

- sql2000不能远程注册服务器上sql2000的解决方法

1. 开始——cmd——telnet Ip 1433 看1433端口是否打开 2.在服务器上查询分析器中输入select @@version查看sql2000的版本,版本号在8.0.2039以下的都 ...

- LESS用法·

CSS 彻底改变了 Web 页面的设计,但 CSS 仍然是静态的,而且在其句法发展方面受到限制.这些限制是有目的且合乎情理的,鼓励广泛加以实现.但开发人员和设计人员常常发现 CSS 使用起来很单调乏味 ...

- Neo4j批量插入(Batch Insertion)

新建一个maven工程,这里不赘述如何新建maven工程. 添加Neo4j jar到你的工程 有两种方式: 上网站官网下载jar包,根据自己的系统下载不同的压缩包,详细过程不描述,请自行搜索其他博客 ...