Hadoop源码学习笔记之NameNode启动场景流程四:rpc server初始化及启动

老规矩,还是分三步走,分别为源码调用分析、伪代码核心梳理、调用关系图解。

一、源码调用分析

根据上篇的梳理,直接从initialize()方法着手。源码如下,部分代码的功能以及说明,已经在注释阐述了。

protected void initialize(Configuration conf) throws IOException {

// 可以通过找到下面变量名的映射,在hdfs-default.xml中找到对应的配置

if (conf.get(HADOOP_USER_GROUP_METRICS_PERCENTILES_INTERVALS) == null) {

String intervals = conf.get(DFS_METRICS_PERCENTILES_INTERVALS_KEY);

if (intervals != null) {

conf.set(HADOOP_USER_GROUP_METRICS_PERCENTILES_INTERVALS,

intervals);

}

}

......

// 核心代码:启动HttpServer

if (NamenodeRole.NAMENODE == role) {

startHttpServer(conf);

}

this.spanReceiverHost = SpanReceiverHost.getInstance(conf);

// 核心代码:FSNamesystem初始化

loadNamesystem(conf);

// 核心代码:创建一个rpc server实例

rpcServer = createRpcServer(conf);

......

// 核心代码:启动一些服务组件,包括rpc server等

startCommonServices(conf);

}

这段代码涉及到rpc server初始化及启动的核心,有两处:

第一处是rpcServer = createRpcServer(conf); 这个createRpcServer()的功能就是创建了一个rpc server的实例。如下:

protected NameNodeRpcServer createRpcServer(Configuration conf)

throws IOException {

return new NameNodeRpcServer(conf, this);

}

我们继续进去NameNodeRpcServer类的构造方法中看一看,到底里面做了哪些事情:

public NameNodeRpcServer(Configuration conf, NameNode nn)

throws IOException {

this.nn = nn;

this.namesystem = nn.getNamesystem();

this.metrics = NameNode.getNameNodeMetrics(); int handlerCount =

conf.getInt(DFS_NAMENODE_HANDLER_COUNT_KEY,

DFS_NAMENODE_HANDLER_COUNT_DEFAULT); RPC.setProtocolEngine(conf, ClientNamenodeProtocolPB.class,

ProtobufRpcEngine.class);

// ----------1------------

// ---- 下面一堆都是实例化各种协议和服务的对象,所有的服务都是BlockingService接口的实现

// client和namenode之间进行通信需要调用的接口,包括:创建目录、管理block、设置权限等一些操作

ClientNamenodeProtocolServerSideTranslatorPB

clientProtocolServerTranslator = new ClientNamenodeProtocolServerSideTranslatorPB(this);

BlockingService clientNNPbService = ClientNamenodeProtocol.

newReflectiveBlockingService(clientProtocolServerTranslator); // datanode和namenode之间进行通信调用的接口,包括:datanode注册、heartbeatReport、blockReport等接口

DatanodeProtocolServerSideTranslatorPB dnProtoPbTranslator =

new DatanodeProtocolServerSideTranslatorPB(this);

BlockingService dnProtoPbService = DatanodeProtocolService

.newReflectiveBlockingService(dnProtoPbTranslator); // 不同的namenode之间进行通信需要调用的接口

NamenodeProtocolServerSideTranslatorPB namenodeProtocolXlator =

new NamenodeProtocolServerSideTranslatorPB(this);

BlockingService NNPbService = NamenodeProtocolService

.newReflectiveBlockingService(namenodeProtocolXlator); ......

// ---- 以上都是初始化rpc server关键的部分

// 确保供写数据的rpc服务引擎已经初始化,如果没有初始化,

// 则在此方法中调用registerProtocolEngine()从而将WritableRpcEngine引擎加入到内存中的引擎map

WritableRpcEngine.ensureInitialized(); ......

if (serviceRpcAddr != null) {

......

// -----------2----------

// 实例化一个监听datanode请求的rpc server

this.serviceRpcServer = new RPC.Builder(conf)

.setProtocol(org.apache.hadoop.hdfs.protocolPB.ClientNamenodeProtocolPB.class)

.setInstance(clientNNPbService)

.setBindAddress(bindHost)

.setPort(serviceRpcAddr.getPort()).setNumHandlers(serviceHandlerCount)

.setVerbose(false)

.setSecretManager(namesystem.getDelegationTokenSecretManager())

.build();

// 将前面实例化的各种协议service添加到这个监听datanode请求的rpc server

// Add all the RPC protocols that the namenode implements

DFSUtil.addPBProtocol(conf, HAServiceProtocolPB.class, haPbService,

serviceRpcServer);

DFSUtil.addPBProtocol(conf, NamenodeProtocolPB.class, NNPbService,

serviceRpcServer);

......

......

} else {

......

}

......

// -----------3------------

// 实例化一个监听客户端请求的rpc server

this.clientRpcServer = new RPC.Builder(conf)

.setProtocol(

org.apache.hadoop.hdfs.protocolPB.ClientNamenodeProtocolPB.class)

.setInstance(clientNNPbService).setBindAddress(bindHost)

.setPort(rpcAddr.getPort()).setNumHandlers(handlerCount)

.setVerbose(false)

.setSecretManager(namesystem.getDelegationTokenSecretManager()).build();

// 将前面实例化的各种协议service添加到这个监听客户端请求的RPC server

// Add all the RPC protocols that the namenode implements

DFSUtil.addPBProtocol(conf, HAServiceProtocolPB.class, haPbService,

clientRpcServer);

DFSUtil.addPBProtocol(conf, NamenodeProtocolPB.class, NNPbService,

clientRpcServer);

......

......

}

进入到NameNodeRpcServer类的构造方法中,可以看到除了上面几行的一些初始化赋值之外,下面的代码好长啊。其实并不复杂,

根据代码的逻辑划分,主要有三部分:

第一部分,实例化各种通信协议和服务对象,比如:负责创建目录、管理block、设置权限等操作的客户端同NameNode通信的

协议服务——ClientNameNodeProtocolServerSideTranslatorPB、负责datanode的启动时向NameNode注册、发送心跳报告、

block信息报告等操作的datanode同NameNode通信的协议服务——DatanodeProtocolServerSideTranslatorPB。篇幅有限,

后面还有不同NameNode之间通信协议服务、HA高可靠、用户权限管理等不在一一详细说明。

第二部分,实例化了一个监听datanode请求的rpc server,并且将第一部分实例化的各种ProtocolService同此rpc server进行绑定,

用于处理rpc server监听到的来自datanode的各种rpc请求。

第三部分,实例化了一个监听客户端请求的rpc server,并将第一部分实例化的各种ProtocolService同此rpc server进行绑定,用于

处理监听到的来自客户端的rpc请求。

至此,rpc server启动之前相关的准备工作已经完毕,接下来就要开始启动rpc server了。继续回到本篇刚开始的initialize()方法中的最后一处核心,

startCommonServices(); 内容如下:

private void startCommonServices(Configuration conf) throws IOException {

// 核心代码:

namesystem.startCommonServices(conf, haContext);

registerNNSMXBean();

if (NamenodeRole.NAMENODE != role) {

startHttpServer(conf);

httpServer.setNameNodeAddress(getNameNodeAddress());

httpServer.setFSImage(getFSImage());

}

// 启动rpcServer

rpcServer.start();

......

}

在此方法中,直接就启动了rpcServer。

但是在第一行的startCommonServices()方法也是核心之一,里面有很重要的一些服务,比如磁盘检查、安全模式判断等,后续篇幅会跟进。

二、伪代码调用流程梳理

NameNode.main() // 入口函数

|——createNameNode(); // 通过new NameNode()进行实例化

|——initialize(); // 方法进行初始化操作

|——startHttpServer(); // 启动HttpServer

|——loadNamesystem(); // 加载元数据

|——createRpcServer(); // 创建rpc server实例

|——new NameNodeRpcServer();

|——service1 // 各种通信协议service

|——service2 // 各种通信协议service

|——service.... // 各种通信协议service

|——serviceRpcServer = new RPC.builder(); // 实例化一个监听datanode请求的rpc server

|——serviceRpcServer.add(service1...); // 将各种service添加到serviceRpcServer

|——clientRpcServer = new RPC.builder(); // 实例化一个监听客户端请求的rpc server

|——clientRpcServer.add(service2...); // 将各种service添加到clientRpcServer

|——startCommonServices();

|——namesystem.startCommonServices(); // 启动一些磁盘检查、安全模式等一些后台服务及线程

|——rpcServer.start(); // 启动rpcServer

|——join()

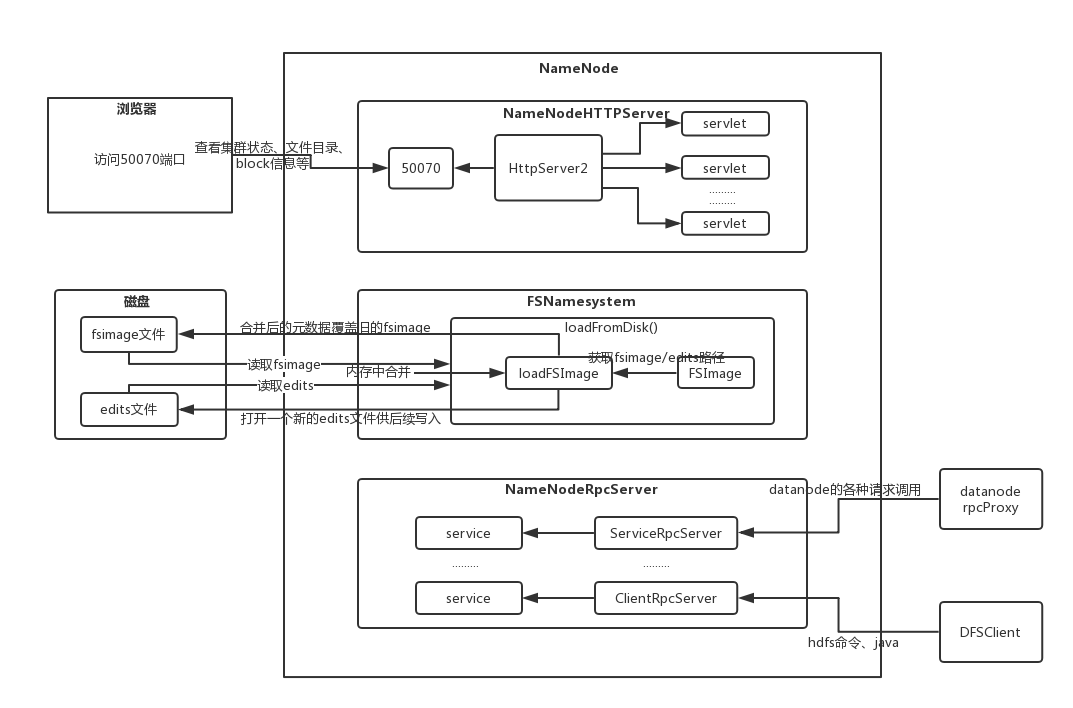

三、rpc server初始化及启动流程图解

Hadoop源码学习笔记之NameNode启动场景流程四:rpc server初始化及启动的更多相关文章

- Hadoop源码学习笔记之NameNode启动场景流程一:源码环境搭建和项目模块及NameNode结构简单介绍

最近在跟着一个大佬学习Hadoop底层源码及架构等知识点,觉得有必要记录下来这个学习过程.想到了这个废弃已久的blog账号,决定重新开始更新. 主要分以下几步来进行源码学习: 一.搭建源码阅读环境二. ...

- Hadoop源码学习笔记之NameNode启动场景流程二:http server启动源码剖析

NameNodeHttpServer启动源码剖析,这一部分主要按以下步骤进行: 一.源码调用分析 二.伪代码调用流程梳理 三.http server服务流程图解 第一步,源码调用分析 前一篇文章已经锁 ...

- Hadoop源码学习笔记之NameNode启动场景流程五:磁盘空间检查及安全模式检查

本篇内容关注NameNode启动之前,active状态和standby状态的一些后台服务及准备工作,即源码里的CommonServices.主要包括磁盘空间检查. 可用资源检查.安全模式等.依然分为三 ...

- Hadoop源码学习笔记之NameNode启动场景流程三:FSNamesystem初始化源码剖析

上篇内容分析了http server的启动代码,这篇文章继续从initialize()方法中按执行顺序进行分析.内容还是分为三大块: 一.源码调用关系分析 二.伪代码执行流程 三.代码图解 一.源码调 ...

- Hadoop源码学习笔记(5) ——回顾DataNode和NameNode的类结构

Hadoop源码学习笔记(5) ——回顾DataNode和NameNode的类结构 之前我们简要的看过了DataNode的main函数以及整个类的大至,现在结合前面我们研究的线程和RPC,则可以进一步 ...

- Hadoop源码学习笔记(6)——从ls命令一路解剖

Hadoop源码学习笔记(6) ——从ls命令一路解剖 Hadoop几个模块的程序我们大致有了点了解,现在我们得细看一下这个程序是如何处理命令的. 我们就从原头开始,然后一步步追查. 我们先选中ls命 ...

- Hadoop源码学习笔记(2) ——进入main函数打印包信息

Hadoop源码学习笔记(2) ——进入main函数打印包信息 找到了main函数,也建立了快速启动的方法,然后我们就进去看一看. 进入NameNode和DataNode的主函数后,发现形式差不多: ...

- Hadoop源码学习笔记(1) ——第二季开始——找到Main函数及读一读Configure类

Hadoop源码学习笔记(1) ——找到Main函数及读一读Configure类 前面在第一季中,我们简单地研究了下Hadoop是什么,怎么用.在这开源的大牛作品的诱惑下,接下来我们要研究一下它是如何 ...

- Hadoop源码学习笔记(4) ——Socket到RPC调用

Hadoop源码学习笔记(4) ——Socket到RPC调用 Hadoop是一个分布式程序,分布在多台机器上运行,事必会涉及到网络编程.那这里如何让网络编程变得简单.透明的呢? 网络编程中,首先我们要 ...

随机推荐

- Redis安装和部署--LINUX

一.安装 1.下载3.0.7稳定版本即可 地址:http://www.redis.cn/download.html 2.将 redis-3.0.7.tar.gz 压缩包拷贝到 opt 目录下 3.解压 ...

- ActiveMQ queue 代码示例

生产者: package com.111.activemq; import javax.jms.Connection; import javax.jms.ConnectionFactory; impo ...

- Docker-commit镜像提交

docker commit:提交容器副本使之成为一个新的镜像 docker commit -a="作者名" -m="提交的描述信息" 容器id 新建的镜像名称: ...

- aspnetcore 认证相关类简要说明一

首先我想要简要说明是AuthenticationScheme类,每次看到Scheme这个单词我就感觉它是一个很高大上的单词,其实简单翻译过来就是认证方案的意思.既然一种方案,那我们就要知道这个方案的名 ...

- 数组list操作,切片

a=range(10) a[11:0:-1] #倒序输出 a[0:9:2] #输出2,4,6,8 a[-3:] #输出7,8,9 a.append(11) #追加一个元素 a.count(11) #统 ...

- Python学习---Django的基础操作180116

Django创建数据库操作 django流程之model实例 settigs.py:更改Django2.0.1的配置,更新为之前的路径配置 'DIRS': [os.path.join(BASE_DIR ...

- php中的雷同方法

php中又很多的可选语法,比如echo 使用echo()和print()都可以输出文本,他们的不同之处在于print()函数有一个返回值1代表输出成功,0代表输出失败,二echo()就没有返回值了. ...

- python选课系统

程序名称: 选课系统 角色:学校.学员.课程.讲师 要求: 1. 创建北京.上海 2 所学校 2. 创建linux , python , go 3个课程 , linux\py 在北京开, go 在上海 ...

- P1314 聪明的质监员

题目描述 小T 是一名质量监督员,最近负责检验一批矿产的质量.这批矿产共有 n 个矿石,从 1 到 n 逐一编号,每个矿石都有自己的重量 \(w_i\) 以及价值 \(v_i\) .检验矿产的流程是 ...

- 【bbs】index、post

列表 奇数行和偶数行设置不同的背景 http://blog.csdn.net/facecrazy/article/details/51252850 实现ul li中的内容上下左右居中,不用设置li宽度 ...