一起学Hadoop——使用IDEA编写第一个MapReduce程序(Java和Python)

上一篇我们学习了MapReduce的原理,今天我们使用代码来加深对MapReduce原理的理解。

wordcount是Hadoop入门的经典例子,我们也不能免俗,也使用这个例子作为学习Hadoop的第一个程序。本文将介绍使用java和python编写第一个MapReduce程序。

本文使用Idea2018开发工具开发第一个Hadoop程序。使用的编程语言是Java。

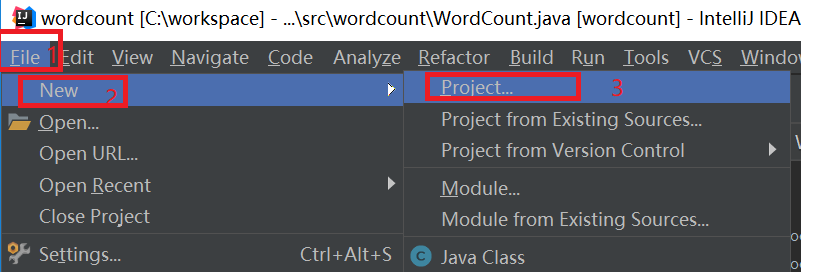

打开idea,新建一个工程,如下图所示:

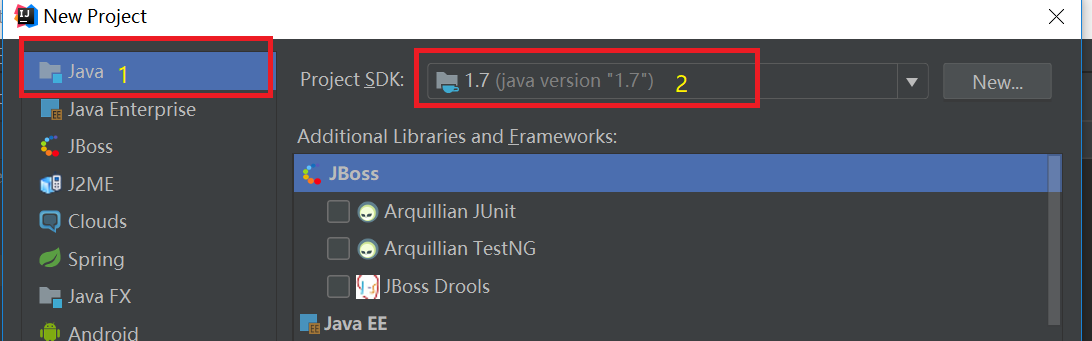

在弹出新建工程的界面选择Java,接着选择SDK,一般默认即可,点击“Next”按钮,如下图:

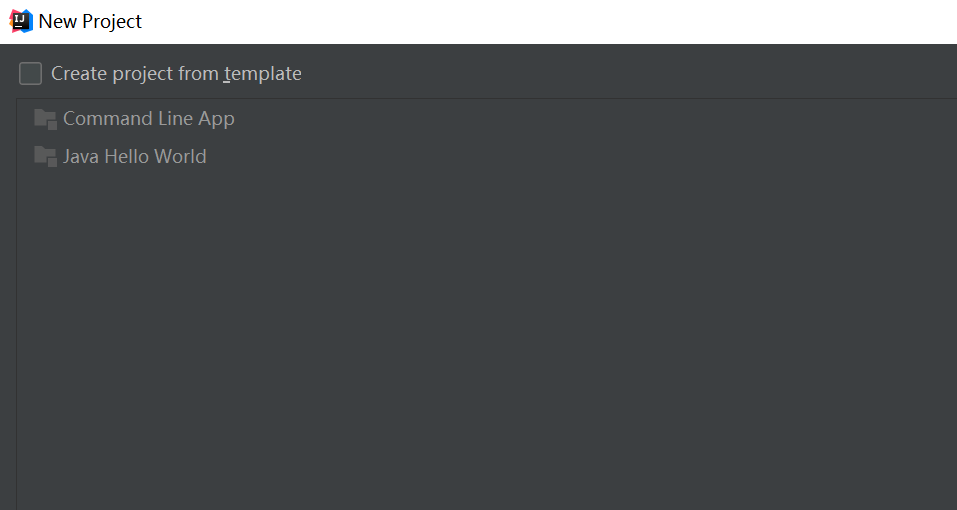

在弹出的选择创建项目的模板页面,不做任何操作,直接点击“Next”按钮。

输入项目名称,点击Finish,就完成了创建新项目的工作,我们的项目名称为:WordCount。如下图所示:

添加依赖jar包,和Eclipse一样,要给项目添加相关依赖包,否则会出错。

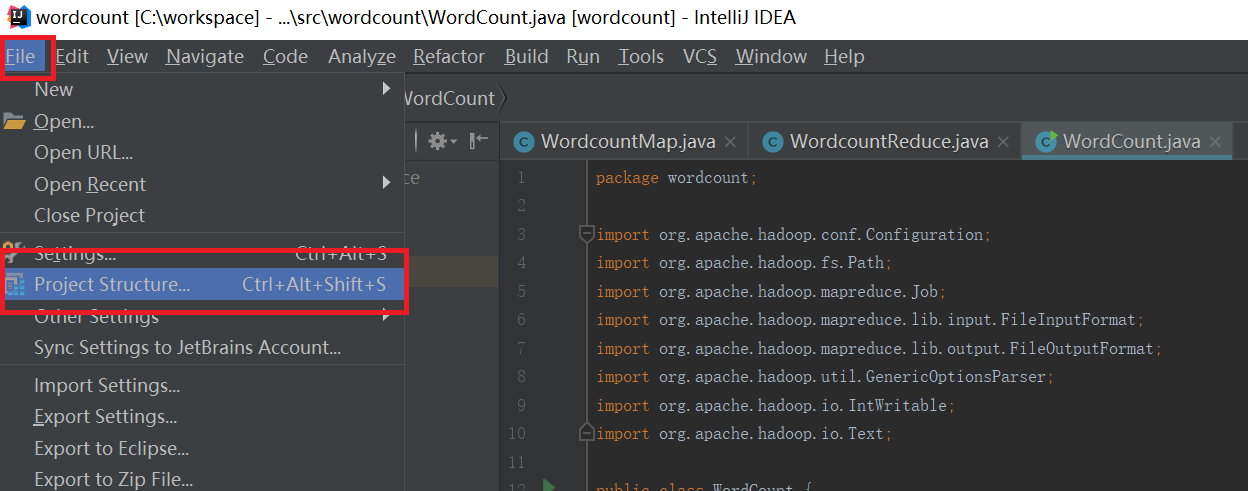

点击Idea的File菜单,然后点击“Project Structure”菜单,如下图所示:

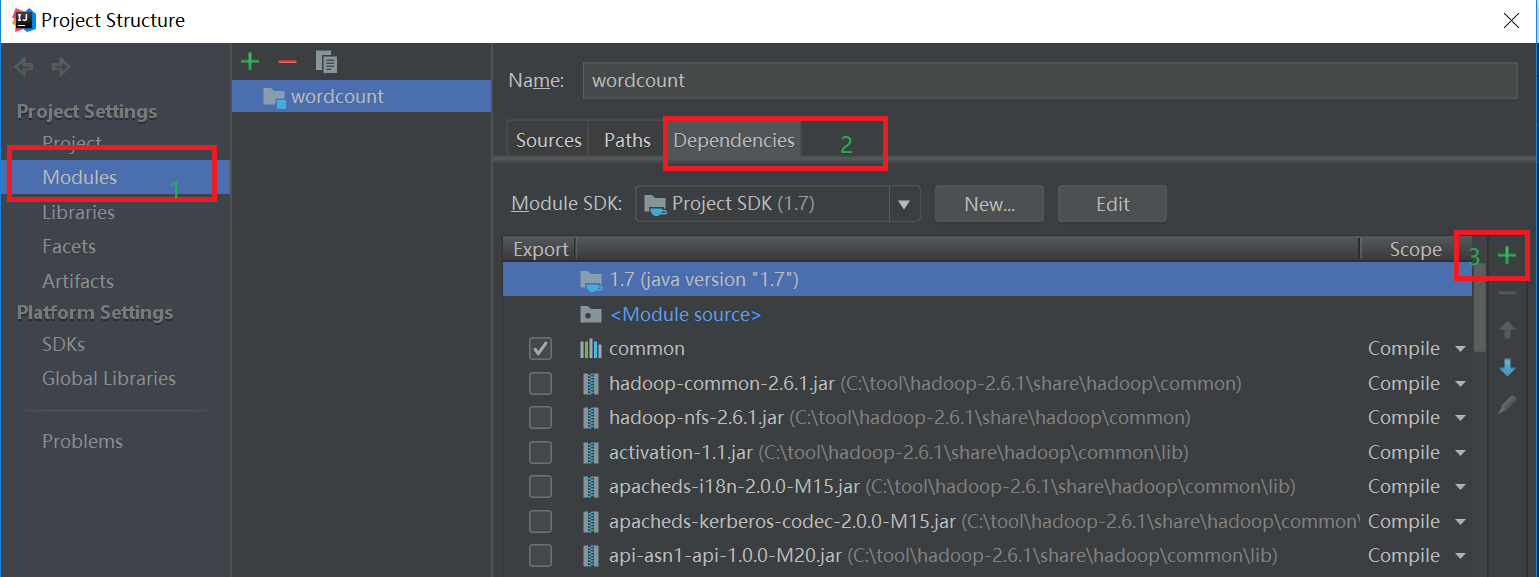

依次点击Modules和Dependencies,然后选择“+”的符号,如下图所示:

选择hadoop的包,我用得是hadoop2.6.1。把下面的依赖包都加入到工程中,否则会出现某个类找不到的错误。

(1)”/usr/local/hadoop/share/hadoop/common”目录下的hadoop-common-2.6.1.jar和haoop-nfs-2.6.1.jar;

(2)/usr/local/hadoop/share/hadoop/common/lib”目录下的所有JAR包;

(3)“/usr/local/hadoop/share/hadoop/hdfs”目录下的haoop-hdfs-2.6.1.jar和haoop-hdfs-nfs-2.7.1.jar;

(4)“/usr/local/hadoop/share/hadoop/hdfs/lib”目录下的所有JAR包。

工程已经创建好,我们开始编写Map类、Reduce类和运行MapReduce的入口类:

JAVA编写MarReduce代码

Map类如下:

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

public class WordcountMap extends Mapper<LongWritable,Text,Text,IntWritable> {

public void map(LongWritable key,Text value,Context context)throws IOException,InterruptedException{

String line = value.toString();//读取一行数据

String str[] = line.split("");//因为英文字母是以“ ”为间隔的,因此使用“ ”分隔符将一行数据切成多个单词并存在数组中

for(String s :str){//循环迭代字符串,将一个单词变成<key,value>形式,及<"hello",1>

context.write(new Text(s),new IntWritable(1));

}

}

}

Reudce类:

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.io.Text;

import java.io.IOException; public class WordcountReduce extends Reducer<Text,IntWritable,Text,IntWritable> {

public void reduce(Text key, Iterable<IntWritable> values,Context context)throws IOException,InterruptedException{

int count = 0;

for(IntWritable value: values) {

count++;

}

context.write(key,new IntWritable(count));

}

}

入口类 :

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text; public class WordCount { public static void main(String[] args)throws Exception{

Configuration conf = new Configuration();

//获取运行时输入的参数,一般是通过shell脚本文件传进来。

String [] otherArgs = new GenericOptionsParser(conf,args).getRemainingArgs();

if(otherArgs.length < 2){

System.err.println("必须输入读取文件路径和输出路径");

System.exit(2);

}

Job job = new Job();

job.setJarByClass(WordCount.class);

job.setJobName("wordcount app"); //设置读取文件的路径,都是从HDFS中读取。读取文件路径从脚本文件中传进来

FileInputFormat.addInputPath(job,new Path(args[0]));

//设置mapreduce程序的输出路径,MapReduce的结果都是输入到文件中

FileOutputFormat.setOutputPath(job,new Path(args[1])); //设置实现了map函数的类

job.setMapperClass(WordcountMap.class);

//设置实现了reduce函数的类

job.setReducerClass(WordcountReduce.class); //设置reduce函数的key值

job.setOutputKeyClass(Text.class);

//设置reduce函数的value值

job.setOutputValueClass(IntWritable.class);

System.exit(job.waitForCompletion(true) ? 0 :1);

}

}

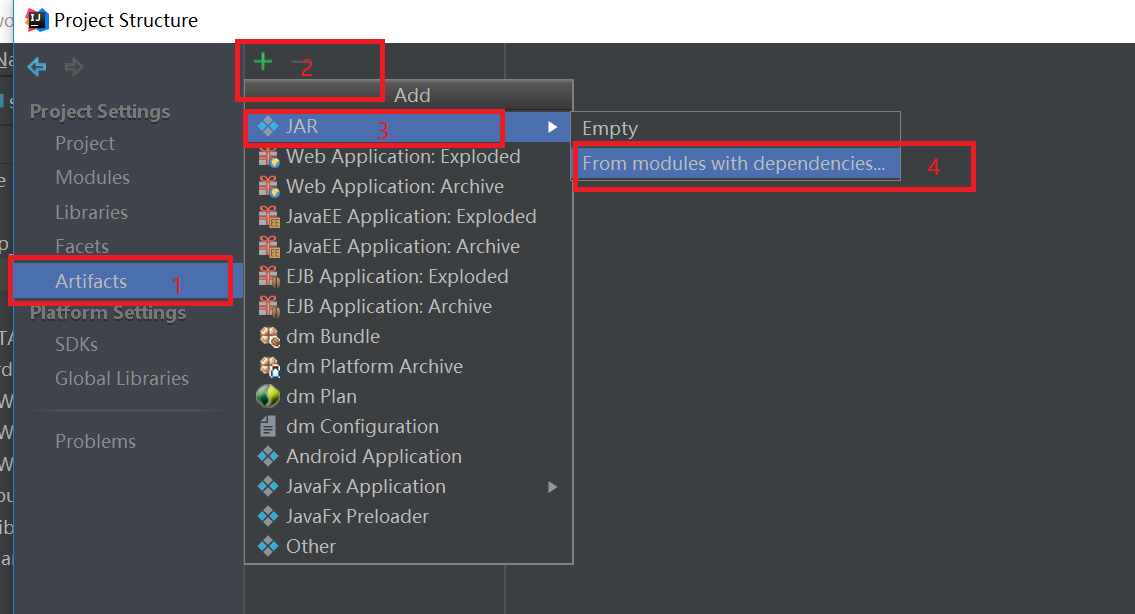

代码写好之后,开始jar包,按照下图打包。点击“File”,然后点击“Project Structure”,弹出如下的界面,

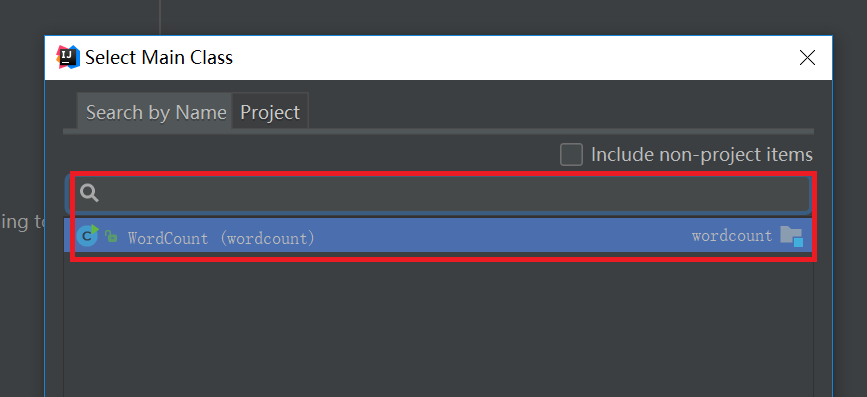

依次点击"Artifacts" -> "+" -> "JAR" -> "From modules with dependencies",然后弹出一个选择入口类的界面,选择刚刚写好的WordCount类,如下图:

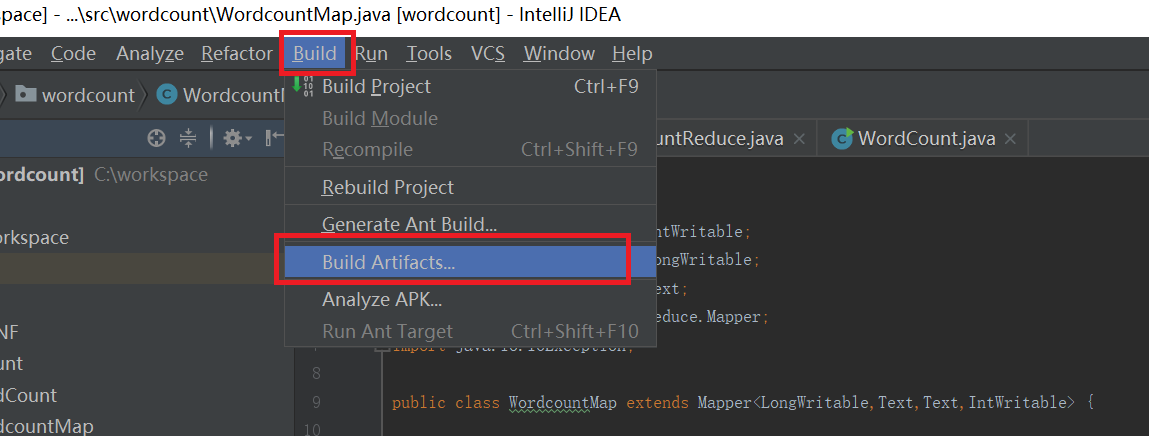

按照上面设置好之后,就开始打jar包,如下图:

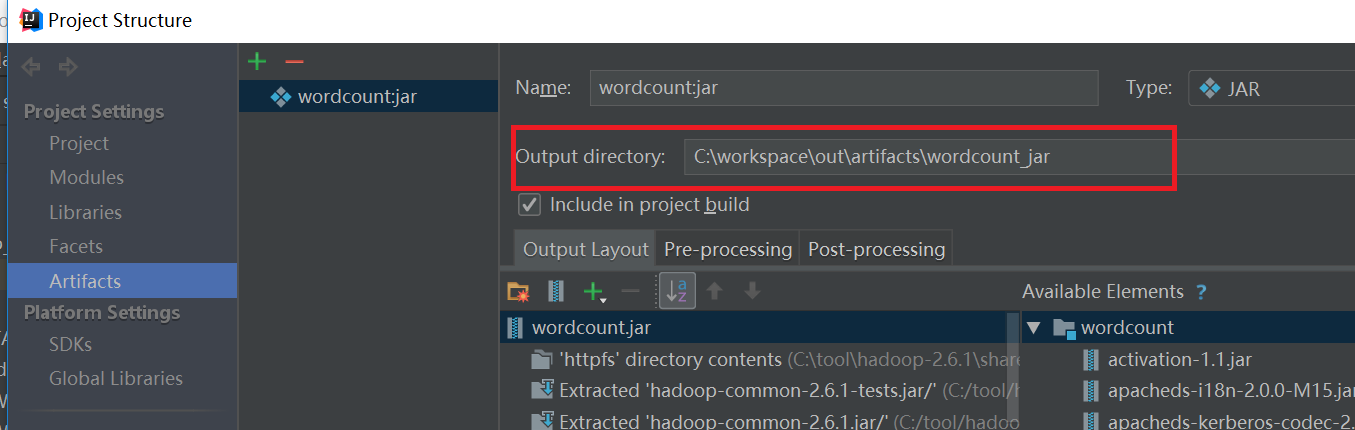

点击上图的“Build”之后就会生成一个jar包。jar的位置看下图,依次点击File->Project Structure->Artifacts就会看到如下的界面:

将打好包的wordcount.jar文件上传到装有hadoop集群的机器中,然后创建shell文件,shell文件内容如下,/usr/local/src/hadoop-2.6.1是hadoop集群中hadoop的安装位置,

/usr/local/src/hadoop-2.6./bin/hadoop jar wordcount.jar \ #执行jar文件的命令以及jar文件名, hdfs://hadoop-master:8020/data/english.txt \ #输入路径 hdfs://hadoop-master:8020/wordcount_output #输出路径

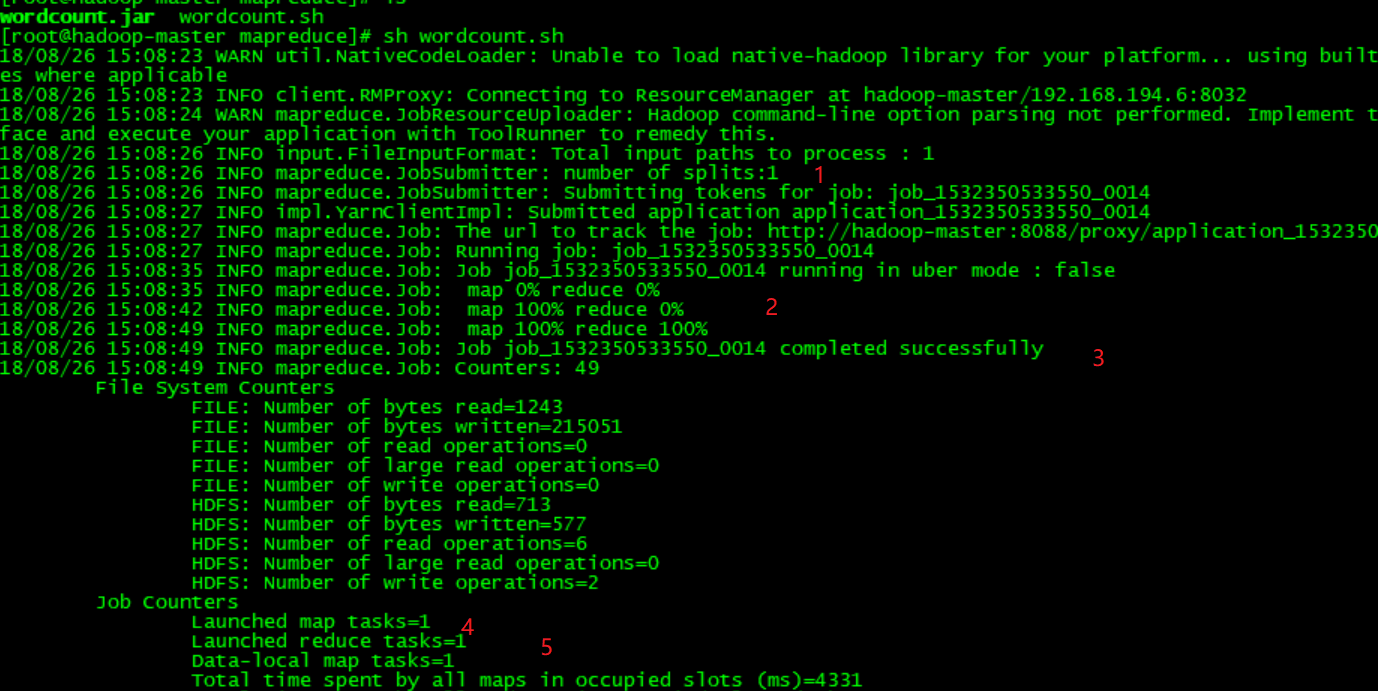

执行shell文件之后,会看到如下的信息,

上图中数字1表示输入分片split的数量,数字2表示map和reduce的进度,数字3表示mapreduce执行成功,数字4表示启动多少个map任务,数字5表示启动多少个reduce任务。

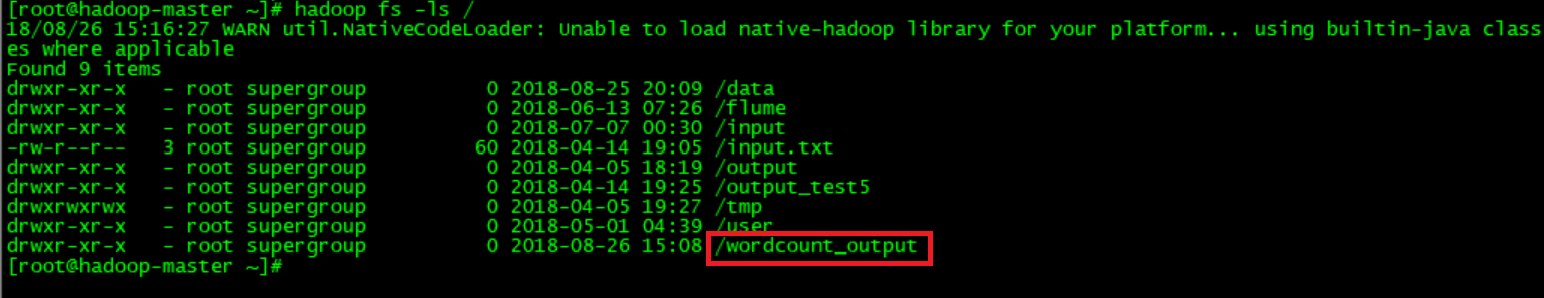

自行成功后在hadoop集群中的hdfs文件系统中会看到一个wordcount_output的文件夹。使用“hadoop fs -ls /”命令查看:

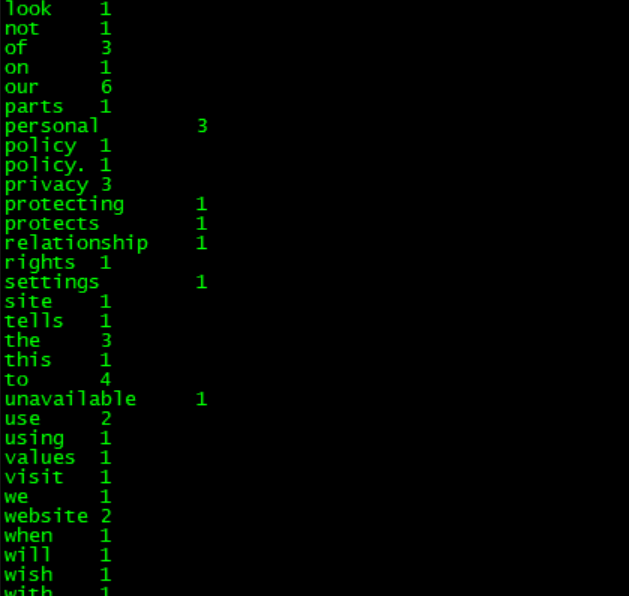

在wordcount_output文件夹中有两个文件,分别是_SUCCESS和part-r-00000,part-r-00000记录着mapreduce的执行结果,使用hadoop fs -cat /wordcount_output/part-r-00000查看part-r-00000的内容:

可以每个英文单词出现的次数。

至此,借助idea 2018工具开发第一个使用java语言编写的mapreduce程序已经成功执行。下面介绍使用python语言编写的第一个mapreduce程序,相对于java,python编写mapreduce会简单很多,因为hadoop提供streaming,streaming是使用Unix标准流作为Hadoop和应用程序之间的接口,所以可以使用任何语言通过标准输入输出来写MapReduce程序。

Python编写MapReduce程序

看代码:

实现了map函数的python程序,命名为map.py:

#!/usr/local/bin/python import sys #导入sys包 for line in sys.stdin: #从标准输入中读取数据

ss = line.strip().split(' ')#读取每一行数据,strip()函数过滤掉空格换行的字符,split(' ')分隔出每个额单词并存放在数组ss中 for s in ss: #读取数组ss中的每个单词

if s.strip() != "":

print "%s\t%s" % (s, 1)#构造以单词为key,1为value的键值对,并写入到标准输出中。

实现了reduce函数的python程序,命名为reduce.py:

import sys

cur_word = None

sum = 0

for line in sys.stdin:

ss = line.strip().split('\t')#从标准输入中读取数据。

if len(ss) != 2:

continue

word,cnt = ss

if cur_word == None:

cur_word = word

#因为从map流转到reduce的数据时按照key排好序的,cur_word记录的是上一个单词,word记 #录的是当前读取的单词,如果两个单词一致,则将sum+1,否则将word和sum值组成一个键值对,##写入到标准输出,同时sum赋值为0,并且将word赋值给cur_word变量。

if cur_word != word:

print '\t'.join([cur_word,str(sum)])

cur_word = word

sum = 0

sum += int(cnt)

print '\t'.join([cur_word,str(sum)])

map和reduce程序已经编写完毕,下面编写shell脚本文件:

HADOOP_CMD="/usr/local/src/hadoop-2.6.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-2.6.1/share/hadoop/tools/lib/hadoop-streaming-2.6.1.jar " INPUT_FILE_PATH_1="/data/english.txt"#输入路径

OUTPUT_PATH="/wordcount_output"#输出路径

$HADOOP_CMD fs -rmr -skipTrash $OUTPUT_PATH#每次执行时都删除输出路径,否则会出错 $HADOOP_CMD jar $STREAM_JAR_PATH \

-input $INPUT_FILE_PATH_1 \#指定输入路径

-output $OUTPUT_PATH \#指定输出路径

-mapper "python map.py" \#指定要执行的map程序

-reducer "python reduce.py" \#指定要执行reduce程序

-file ./map.py \#指定map程序所在的位置

-file ./reduce.py#指定reduce程序所在的位置

到此Java和Python编写第一个MapReduce程序已经完成。

一起学Hadoop——使用IDEA编写第一个MapReduce程序(Java和Python)的更多相关文章

- 编写第一个MapReduce程序—— 统计气温

摘要:hadoop安装完成后,像学习其他语言一样,要开始写一个“hello world!” ,看了一些学习资料,模仿写了个程序.对于一个C#程序员来说,写个java程序,并调用hadoop的包,并跑在 ...

- 编写自已的第一个MapReduce程序

从进入系统学习到现在,貌似我们还没有真正开始动手写程序,估计有些立志成为Hadoop攻城狮的小伙伴们已经有些急了.环境已经搭好,小讲也有些按捺不住了.今天,小讲就和大家一起来动手编写我们的第一个Map ...

- 【C#入门教案-02】用记事本编写第一个C#程序-Hello World

02-用记事本编写第一个C#程序-Hello World 广东职业技术学院 欧浩源 [1]进行.NET程序开发的最基本环境配备 .NET Framework + 代码编辑工具(记事本或Noetpad ...

- HDFS设计思路,HDFS使用,查看集群状态,HDFS,HDFS上传文件,HDFS下载文件,yarn web管理界面信息查看,运行一个mapreduce程序,mapreduce的demo

26 集群使用初步 HDFS的设计思路 l 设计思想 分而治之:将大文件.大批量文件,分布式存放在大量服务器上,以便于采取分而治之的方式对海量数据进行运算分析: l 在大数据系统中作用: 为各类分布式 ...

- 编写简单的Mapreduce程序并部署在Hadoop2.2.0上运行

今天主要来说说怎么在Hadoop2.2.0分布式上面运行写好的 Mapreduce 程序. 可以在eclipse写好程序,export或用fatjar打包成jar文件. 先给出这个程序所依赖的Mave ...

- 使用Playground编写第一个Swift程序

从控制台输出“HelloWorld”是我学习C语言的第一步,也是我人生中非常重要的一步.多年后的今天,我仍希望以HelloWorld作为第一步,与大家共同开启一个神奇.瑰丽的世界——Swift编程. ...

- hadoop在实现kmeans算法——一个mapreduce实施

写mapreduce程序实现kmeans算法.我们的想法可能是 1. 次迭代后的质心 2. map里.计算每一个质心与样本之间的距离,得到与样本距离最短的质心,以这个质心作为key,样本作为value ...

- 编写第一个Qt程序

http://c.biancheng.net/view/1817.html 学习一种编程语言或编程环境,通常会先编写一个“Hello World”程序.我们也用 Qt Creator 编写一个“Hel ...

- 编写第一个JavaScript程序

编写第一个程序 在 HTML 页面中嵌入 JavaScript 脚本需要使用 <script> 标签,用户可以在 <script> 标签中直接编写 JavaScript 代码, ...

随机推荐

- hibernate框架学习之增删改查helloworld

插入数据删除数据修改数据查询单条数据查询多条数据 HelloWorldApp.java package cn.itcast.h3.helloworld; import org.hibernate.Se ...

- Linux root密码忘记了怎么办?

一.找回root密码: 1. 开机出现 Booting Red Hat Enterprise Linux Client (…) in 3 seconds … 按任意键进入menu菜单: 2. 选择当前 ...

- Light Oj 1003

题意 : 给你m个二元关系, 问是否可以确定各个节点的先后关系: 思路: 拓扑排序, 判断是否有环: #include<bits/stdc++.h> using namespace std ...

- Ex3_7无向图二部图_十一次作业

(a) 从图中的某个顶点做深度优先遍历,并将不同层的顶点标记为红黑两种颜色,使得每条树边的两个顶点的颜色都不相同,如果遇到一条回边并且两个顶点的颜色都相同则说明图不是二部图. (b)如果存在一个长度为 ...

- Js操作Array数组

之前写过一篇文章,但是很模糊,不过却给我提供了一个思路,所以没有删除,这次写的是一个完善版本! 因为在很多的时候我们在选中了几行数据,然后存放在Array中,如下图: 看下控制台的数据 我双击了这两个 ...

- js---json对象拆分

var a={ "bb":"world", "a0":1, "a1":2, "b0":4, &quo ...

- Ubuntu16.04配置Tomcat的80端口访问

[问题描述] 在阿里云 ECS 服务器 Ubuntu16.04 下部署 Java Web 应用时,发现配置的 Tomcat 服务启动后 80 端口无法被监听. [问题原因] 出现该问题的主要原因是:非 ...

- Confluence 6 配置校验和识别

校验你的设置 查看你 Confluence 当前使用的设置,请参考 Viewing System Properties 页面中的内容. 识别系统属性 请参考 Recognized System Pro ...

- 用json获取拉钩网的信息

class LaoGo(object): def __init__(self): self.url="http://www.lagou.com/lbs/getAllCitySearchLab ...

- Brup Suite 渗透测试笔记(七)

继续接上次笔记: 1.Burp Intruder的payload类型的子模块(Character blocks)使用一种给出的输入字符,根据指定的设置产生指定大小的字符块,表现形式为生成指定长度的字符 ...