java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

在 windows 上运行 MapReduce 时报如下异常

- Exception in thread "main" java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

- at org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Native Method)

- at org.apache.hadoop.io.nativeio.NativeIO$Windows.access(NativeIO.java:606)

- at org.apache.hadoop.fs.FileUtil.canRead(FileUtil.java:998)

- at org.apache.hadoop.util.DiskChecker.checkAccessByFileMethods(DiskChecker.java:160)

- at org.apache.hadoop.util.DiskChecker.checkDirInternal(DiskChecker.java:100)

- at org.apache.hadoop.util.DiskChecker.checkDir(DiskChecker.java:77)

- at org.apache.hadoop.fs.LocalDirAllocator$AllocatorPerContext.confChanged(LocalDirAllocator.java:315)

- at org.apache.hadoop.fs.LocalDirAllocator$AllocatorPerContext.getLocalPathForWrite(LocalDirAllocator.java:378)

- at org.apache.hadoop.fs.LocalDirAllocator.getLocalPathForWrite(LocalDirAllocator.java:152)

- at org.apache.hadoop.fs.LocalDirAllocator.getLocalPathForWrite(LocalDirAllocator.java:133)

- at org.apache.hadoop.fs.LocalDirAllocator.getLocalPathForWrite(LocalDirAllocator.java:117)

- at org.apache.hadoop.mapred.LocalDistributedCacheManager.setup(LocalDistributedCacheManager.java:124)

- at org.apache.hadoop.mapred.LocalJobRunner$Job.<init>(LocalJobRunner.java:171)

- at org.apache.hadoop.mapred.LocalJobRunner.submitJob(LocalJobRunner.java:760)

- at org.apache.hadoop.mapreduce.JobSubmitter.submitJobInternal(JobSubmitter.java:253)

- at org.apache.hadoop.mapreduce.Job$11.run(Job.java:1570)

- at org.apache.hadoop.mapreduce.Job$11.run(Job.java:1567)

- at java.security.AccessController.doPrivileged(Native Method)

- at javax.security.auth.Subject.doAs(Subject.java:422)

- at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1893)

- at org.apache.hadoop.mapreduce.Job.submit(Job.java:1567)

- at org.apache.hadoop.mapreduce.Job.waitForCompletion(Job.java:1588)

- at test.mapreduce.wordcount.WordcountDriver.main(WordcountDriver.java:56)

搜索相关问题后,已解决

前提:

确保 hadoop/bin 目录下的文件是完整的,直接从 apache 下载的会缺少文件,可以自己编译或从 GitHub 上下载其他人编译好的文件

确保软件 32 位或 64 位,保持一致

解决方法有如下两种

1.手动加载 hadoop.dll,指定 hadoop 目录

- static {

- try {

- // 设置 HADOOP_HOME 目录

- System.setProperty("hadoop.home.dir", "D:/DevelopTools/hadoop-2.9.2/");

- // 加载库文件

- System.load("D:/DevelopTools/hadoop-2.9.2/bin/hadoop.dll");

- } catch (UnsatisfiedLinkError e) {

- System.err.println("Native code library failed to load.\n" + e);

- System.exit(1);

- }

- }

2.覆盖修改源码中的代码

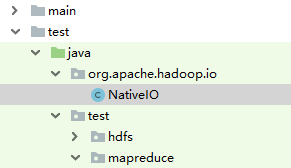

复制 org.apache.hadoop.io.nativeio.NativeIO 到自己的项目,保持和源码包路径一致

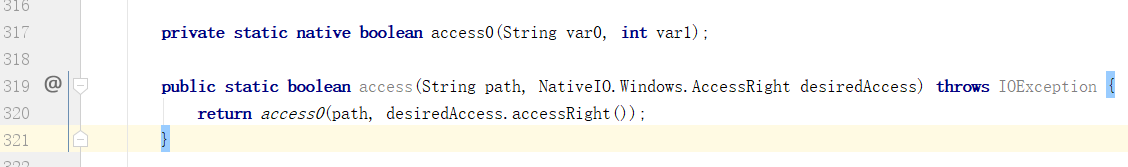

修改 access() 方法返回值,原代码如下

修改成如下,直接返回

- private static native boolean access0(String var0, int var1);

- public static boolean access(String path, NativeIO.Windows.AccessRight desiredAccess) throws IOException {

- return true;

- }

https://blog.csdn.net/cor_twi/article/details/40891393

https://blog.csdn.net/congcong68/article/details/42043093

java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z的更多相关文章

- Exception in thread "main" java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

1.window操作系统的eclipse运行wordcount程序出现如下所示的错误: Exception in thread "main" java.lang.Unsatisfi ...

- Exception in thread "main" java.lang.UnsatisfiedLinkError: org.apache.hadoop.io .nativeio.NativeIO$Windows.createDirectoryWithMode0(Ljava/lang/String;I)V

首先,遇到这个问题的一个原因是windows环境中没有配置hadoophome.配置之后加入winutils工具 第二个原因,pom中执行的hadoop的版本与window环境中的hadoop的版本不 ...

- MapReduce wordcount 输入路径为目录 java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$POSIX.stat(Ljava/lang/String;)Lorg/apache/hadoop/io/nativeio/NativeIO$POSIX$Stat;

之前windows下执行wordcount都正常,今天执行的时候指定的输入路径是文件夹,然后就报了如题的错误,把输入路径改成文件后是正常的,也就是说目前的wordcount无法对多个文件操作 报的异常 ...

- 本地spark报:java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.createFileWithMode0(Ljava/lang/String;JJJI)Ljava/io/FileDescriptor;

我是在运行rdd.saveAsTextFile(fileName)的时候报的错,找了很多说法……最终是跑到hadoop/bin文件夹下删除了hadoop.dll后成功.之前某些说法甚至和这个解决方法自 ...

- [解决]Hadoop 2.4.1 UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0

问题:UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0 我的系统 win7 64位 Hadoop ...

- java.lang.UnsatisfiedLinkError: org.apache.hadoop.util.NativeCrc32.nativeComputeChunkedSumsByteArray(II[BI[BIILjava/lang/String;JZ)V

环境: Spark2.1.0 .Hadoop-2.7.5 代码运行系统:Win 7在运行Spark程序写出文件(savaAsTextFile)的时候,我遇到了这个错误: // :: ERROR U ...

- hadoop.io.native.NativeID$Windows.access0 报错问题解决

系统:win10 hadoop-2.6.0版本 java:1.8 版本32位 wordcount在本地运行时报错: Exception in thread "main" jav ...

- 解决Exception: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

在项目中添加src中添加NativeIO类 /** * Licensed to the Apache Software Foundation (ASF) under one * or more con ...

- Exceptionin thread "main" java.lang.UnsatisfiedLinkError:org.apache.hadoop.util.NativeCrc32.nativeComputeChunkedSumsByteArray(II[BI[BIILjav

在eclipse上运行hadoop报错:Exceptionin thread "main" java.lang.UnsatisfiedLinkError:org.apache.ha ...

随机推荐

- 第五十五天 css基础入门

一.引入css的三种方式 1.行间式 <div style="width: 100px; height: 100px; background-color: red">& ...

- ☆ [POJ2559] Largest Rectangle in a Histogram 「单调栈」

类型:单调栈 传送门:>Here< 题意:给出若干宽度相同的矩形的高度(条形统计图),求最大子矩形面积 解题思路 单调栈的经典题 显然,最终的子矩形高度一定和某一个矩形相等(反证).因此一 ...

- 【BZOJ5020】【THUWC2017】在美妙的数学王国中畅游 LCT 泰勒展开

题目大意 给你一棵树,每个点有一个函数\(f(x)\) 正弦函数 \(\sin(ax+b) (a\in[0,1],b\in[0,\pi],a+b\in[0,\pi])\) 指数函数 \(e^{ax+b ...

- jsp配置

jsp.server.xml <Host name="localhost" appBase="webapps" unpackWARs="true ...

- 洛谷CF809C Find a car(数位DP)

洛谷题目传送门 通过瞪眼法发现,\(a_{i,j}=(i-1)\text{ xor }(j-1)+1\). 二维差分一下,我们只要能求\(\sum\limits_{i=0}^x\sum\limits_ ...

- Hdoj 1087.Super Jumping! Jumping! Jumping!

Problem Description Nowadays, a kind of chess game called "Super Jumping! Jumping! Jumping!&quo ...

- 自学Python之路-django

自学Python之路-django 自学Python之路[第一回]:1.11.2 1.3

- Haproxy Nginx cluster构建

-----client---------haproxy-------nginx1---------nginx2------192.168.1.250 192.168.1.1 192.168.1.10 ...

- [POI2012]STU-Well(二分答案+神仙操作)

给定一个非负整数序列A,每次操作可以选择一个数然后减掉1,要求进行不超过m次操作使得存在一个Ak=0且max{|Ai−Ai+1|}最小,输出这个最小lk以及最小值. Solution 最大值最小,显然 ...

- NOIP引水入城(dfs)

为了使居民们都尽可能饮用到清澈的湖水,现在要在某些城市建造水利设施.水利设施有两种,分别为蓄水厂和输水站.蓄水厂的功能是利用水泵将湖泊中的水抽取到所在城市的蓄水池中. 因此,只有与湖泊毗邻的第1 行的 ...