Python 爬虫-Requests库入门

2017-07-25 10:38:30

response = requests.get(url, params=None, **kwargs)

- url : 拟获取页面的url链接∙ params : url中的额外参数,字典或字节流格式,可选

- params参数是字典或字节序列,作为参数增加到url中

kv = {'key1': 'value1', 'key2': 'value2'}

>>> r = requests.request('GET', 'http://python123.io/ws', params=kv)

>>> print(r.url)

http://python123.io/ws?key1=value1&key2=value2

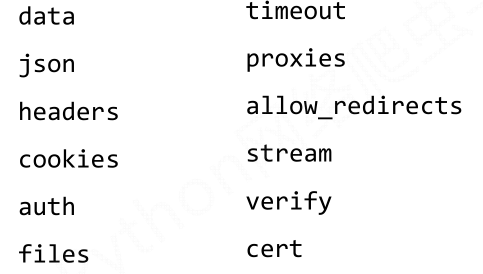

- **kwargs: 12个控制访问的参数

headers:字典,HTTP定制头

hd = {'user‐agent': 'Chrome/10'}

r = requests.request('POST', 'http://python123.io/ws', headers=hd)

timeout : 设定超时时间,秒为单位

r = requests.request('GET', 'http://www.baidu.com', timeout=10)

proxies : 字典类型,设定访问代理服务器,可以增加登录认证

>>> pxs = { 'http': 'http://user:pass@10.10.10.1:1234'

'https': 'https://10.10.10.1:4321' }

>>> r = requests.request('GET', 'http://www.baidu.com', proxies=pxs)

使用举例:

import requests # r:response 右侧get: requests

r = requests.get('http://jwc.seu.edu.cn/')

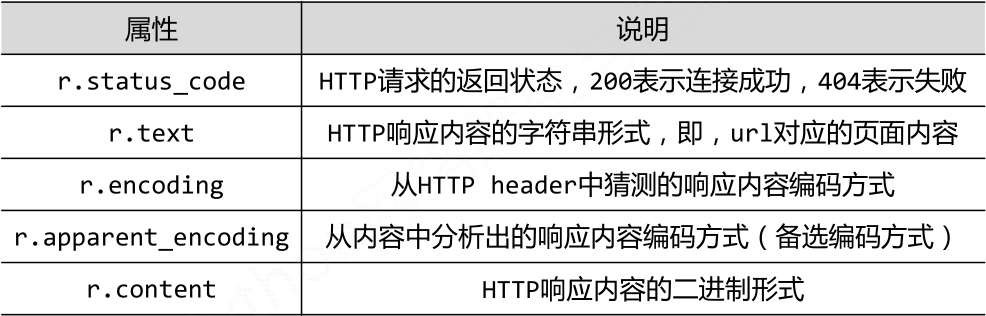

一、返回值Response对象的属性

二、爬取网页的通用代码框架

import requests def gethtml(url):

# 打开网页有风险,需要使用try-except语句进行风险控制

try:

r = requests.get(url)

r.raise_for_status() # 如果打开失败,则会抛出一个HttpError异常

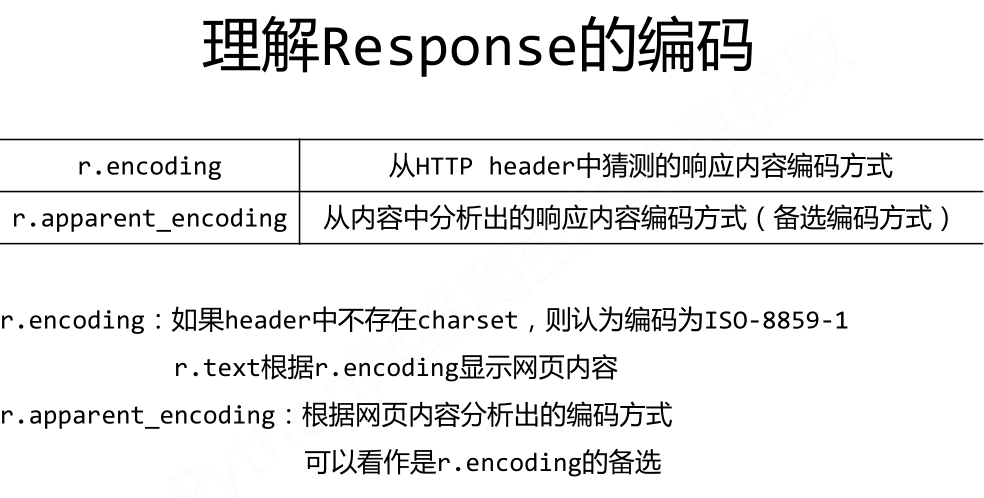

# encoding是从header中分析出来的编码方式,apparent_encoding是 从内容分析出的编码方式

r.encoding=r.apparent_encoding

return r.text

except:

print("打开失败")

三、requests库的方法和HTTP协议

- HTTP协议:超文本传输协议

HTTP是一个基于“请求与响应”模式的、无状态的应用层协议。

HTTP协议采用URL作为定位网络资源的标识,URL格式如下:http://host[:port][path]

HTTP协议对资源的操作方法:

其中get,head方法是从服务器取回数据,post,put,patch,delete方法是向服务器写入或者修改数据。

patch 和 put 的区别:patch 是局部更新,而put 是全部更新。patch节省网络带宽,是HTTP协议改良后的新增指令。

HTTP的指令和requests 的方法一一对应。

- Requests 的七个主要方法

Python 爬虫-Requests库入门的更多相关文章

- Python爬虫—requests库get和post方法使用

目录 Python爬虫-requests库get和post方法使用 1. 安装requests库 2.requests.get()方法使用 3.requests.post()方法使用-构造formda ...

- Python爬虫--Requests库

Requests Requests是用python语言基于urllib编写的,采用的是Apache2 Licensed开源协议的HTTP库,requests是python实现的最简单易用的HTTP库, ...

- 【Python成长之路】Python爬虫 --requests库爬取网站乱码(\xe4\xb8\xb0\xe5\xa)的解决方法【华为云分享】

[写在前面] 在用requests库对自己的CSDN个人博客(https://blog.csdn.net/yuzipeng)进行爬取时,发现乱码报错(\xe4\xb8\xb0\xe5\xaf\x8c\ ...

- Python爬虫 requests库基础

requests库简介 requests是使用Apache2 licensed 许可证的HTTP库. 用python编写. 比urllib2模块更简洁. Request支持HTTP连接保持和连接池,支 ...

- python爬虫---requests库的用法

requests是python实现的简单易用的HTTP库,使用起来比urllib简洁很多 因为是第三方库,所以使用前需要cmd安装 pip install requests 安装完成后import一下 ...

- Python爬虫---requests库快速上手

一.requests库简介 requests是Python的一个HTTP相关的库 requests安装: pip install requests 二.GET请求 import requests # ...

- python爬虫——requests库使用代理

在看这篇文章之前,需要大家掌握的知识技能: python基础 html基础 http状态码 让我们看看这篇文章中有哪些知识点: get方法 post方法 header参数,模拟用户 data参数,提交 ...

- Python爬虫的简单入门(一)

Python爬虫的简单入门(一) 简介 这一系列教学是基于Python的爬虫教学在此之前请确保你的电脑已经成功安装了Python(本教程使用的是Python3).爬虫想要学的精通是有点难度的,尤其是遇 ...

- python爬虫---selenium库的用法

python爬虫---selenium库的用法 selenium是一个自动化测试工具,支持Firefox,Chrome等众多浏览器 在爬虫中的应用主要是用来解决JS渲染的问题. 1.使用前需要安装这个 ...

随机推荐

- 018-DNS解析过程与配置DNS服务

- Trove系列(八)——Trove的配置管理相关的功能介绍

概述MySQL 配置管理功能允许Trove 用户重载由Trove服务的操作者提供的缺省MySQL配置环境.这是通过影响MySQL 的includedir 命令来实现的.这些MySQL 的include ...

- [转载]INNER JOIN连接两个表、三个表、五个表的SQL语句

SQL INNER JOIN关键字表示在表中存在至少一个匹配时,INNER JOIN 关键字返回行. 1.连接两个数据表的用法: FROM Member INNER JOIN MemberSort O ...

- 计算概论(A)/基础编程练习1(8题)/7:奇数求和

#include<stdio.h> int main() { // 输入非负整数 int m, n; scanf("%d %d", &m, &n); / ...

- 动态规划(Dynamic Programming)

introduction 大部分书籍介绍"动态规划"时,都会从"菲波纳切数列"讲起. 菲波纳切数列 递归解法 C++ 代码如下 unsigned long in ...

- 07: Django 使用ldap登录、注销等

目录:Django其他篇 01:Django基础篇 02:Django进阶篇 03:Django数据库操作--->Model 04: Form 验证用户数据 & 生成html 05:Mo ...

- 20145317 网络对抗技术 逆向与Bof基础

20145317 网络对抗技术 逆向与Bof基础 实践要求 1. 掌握NOP,JNE,JE,JMP,CMP汇编指令的机器码 2. 掌握反汇编与十六进制编程器 3. 能正确修改机器指令改变程序执行流程 ...

- JAVA I/O(三)内存映射文件

<Java编程思想>中对内存映射文件有详细的介绍,此处仅做简单记录和总结.内存映射文件允许创建和修改因为太大而不能放入内存的文件. 1. 内存映射文件简单实例 import java.io ...

- javascript 构造函数类和原型 prototyp e定义的属性和方法的区别

1.把方法写在原型中比写在构造函数中消耗的内存更小,因为在内存中一个类的原型只有一个,写在原型中的行为可以被所有实例共享,实例化的时候并不会在实例的内存中再复制一份而写在类中的方法,实例化的时候会在每 ...

- 【Git安装】centos安装git

1 yum install git 安装后的默认存放地点/usr/bin/git