Large Margin Softmax Loss for Speaker Verification

【INTERSPEECH 2019接收】

链接:https://arxiv.org/pdf/1904.03479.pdf

这篇文章在会议的speaker session中。本文主要讨论了说话人验证中的损失函数large margin softmax loss(结合了softmax和margins的losses)。

本文从x-vector中提取speaker embedding。

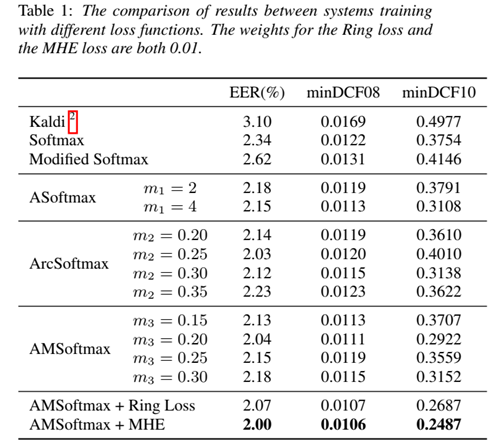

这篇文章在一个公式中统一了多种margin项:

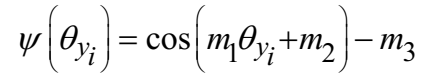

其中N表示训练样本数目,C表示训练集中的说话人数目,s是尺度因子。m1, m2, m3是可以分开使用的margins,则角函数定义为:

并引入两种辅助损失:Ring Loss[1]来约束embedding模值;MHE[2]使weight尽可能在超球面中均匀分布,从而提升类间可分性。

在VoCeleb数据集上运行实验。训练集包括VoxCeleb1 dev part and VoxCeleb2,验证集为VoxCeleb1 test part。训练过程中,特征采用30维的MFCCs(经过谱均值归一化)。采用基于能量的VAD方法。

三种margins单独使用,分别得到losses为:angular softmax (ASoftmax), additive angular margin softmax (ArcSoftmax) and additive margin softmax loss (AMSoftmax)。见图1:

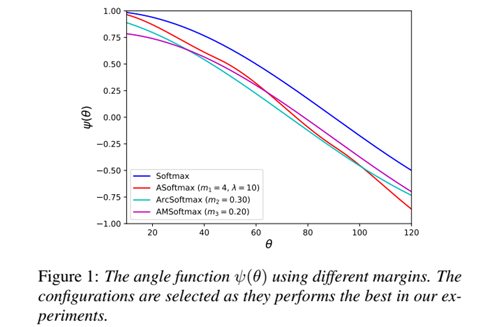

实验表明采用AMSoftmax的性能最佳。见表1,该研究在Kaldi recipe for VoxCeleb的基础上得到了EER 2%的显著性能提升:

深度学习为说话人技术带来了前所未有的机遇,而研究者们在不断拓展新算法的边界的同时,也在回顾传统方法仍然具备的价值。当然说话人技术目前也逐渐暴露出与人脸识别同样的易受攻击的问题。因此,ASVspoof这样的Challenge从2015年起就开始关注声纹反作弊问题。

[1] Ring loss,一种简单的深层网络特征归一化方法,用于增强诸如Softmax之类的标准损失函数。论文(Ring loss: Convex Feature Normalization for Face Recognition)被CVPR 2018接收。

[2] 最小化超球面能量准则(Minimum Hyperspherical Energy

criterion),具体见论文Learning towards Minimum Hyperspherical

Energy(NIPS 2018接收)。

Large Margin Softmax Loss for Speaker Verification的更多相关文章

- 基于Caffe的Large Margin Softmax Loss的实现(中)

小喵的唠叨话:前一篇博客,我们做完了L-Softmax的准备工作.而这一章,我们开始进行前馈的研究. 小喵博客: http://miaoerduo.com 博客原文: http://www.miao ...

- 基于Caffe的Large Margin Softmax Loss的实现(上)

小喵的唠叨话:在写完上一次的博客之后,已经过去了2个月的时间,小喵在此期间,做了大量的实验工作,最终在使用的DeepID2的方法之后,取得了很不错的结果.这次呢,主要讲述一个比较新的论文中的方法,L- ...

- cosface: large margin cosine loss for deep face recognition

目录 概 主要内容 Wang H, Wang Y, Zhou Z, et al. CosFace: Large Margin Cosine Loss for Deep Face Recognition ...

- Generalized end-to-end loss for speaker verification

论文题目:2018_说话人验证的广义端到端损失 论文代码:https://google.github.io/speaker-id/publications/GE2E/ 地址:https://www.c ...

- Large-Margin Softmax Loss for Convolutional Neural Networks

paper url: https://arxiv.org/pdf/1612.02295 year:2017 Introduction 交叉熵损失与softmax一起使用可以说是CNN中最常用的监督组件 ...

- 损失函数 hinge loss vs softmax loss

1. 损失函数 损失函数(Loss function)是用来估量你模型的预测值 f(x) 与真实值 Y 的不一致程度,它是一个非负实值函数,通常用 L(Y,f(x)) 来表示. 损失函数越小,模型的鲁 ...

- Derivative of Softmax Loss Function

Derivative of Softmax Loss Function A softmax classifier: \[ p_j = \frac{\exp{o_j}}{\sum_{k}\exp{o_k ...

- 卷积神经网络系列之softmax,softmax loss和cross entropy的讲解

我们知道卷积神经网络(CNN)在图像领域的应用已经非常广泛了,一般一个CNN网络主要包含卷积层,池化层(pooling),全连接层,损失层等.虽然现在已经开源了很多深度学习框架(比如MxNet,Caf ...

- softmax,softmax loss和cross entropy的区别

版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog.csdn.net/u014380165/article/details/77284921 我们知道卷积神经网络(CNN ...

随机推荐

- Note | PyTorch

目录 0. 教程和笔记 1. 模型操作 2. 网络设计 卷积图示 填充(padding) 升采样 全连接层 3. 损失函数 交叉熵 4. 系统或环境交互 模型加载 5. 犯过的错误 损失异常 测试显存 ...

- jquery ajax 重写

(function($){ //备份jquery的ajax方法 var _ajax=$.ajax; //重写jquery的ajax方法 $.ajax=function(opt){ //备份opt中er ...

- angular修改端口号port

报错:Port 4200 is already in use. Use '--port' to specify a different port. 因为4200端口已被使用,请使用“--port”修改 ...

- css样式重置 移动端适配

css 默认样式重置 @charset "utf-8"; *{margin:0;padding:0;} img {border:none; display:block;} em, ...

- 转 推荐 33 个 IDEA 最牛配置,写代码太爽了!

本文由 简悦 SimpRead 转码, 原文地址 https://mp.weixin.qq.com/s/neyvJouuG1Rmxn3BwfRXVg 作者:琦彦 blog.csdn.net/fly91 ...

- JVM的监控工具之jvisual

VisualVM(All-in-One Java Trouble shootingTool)是到目前为止随JDK发布的功能最强大的运行监视和故障处理程序,并且可以预见在未来一段时间内都是官方主力发展的 ...

- Blazor应用程序基于策略的授权

原文:https://chrissainty.com/securing-your-blazor-apps-configuring-policy-based-authorization-with-bla ...

- yii2 HeadersAlreadySentException 报错

An Error occurred while handling another error:exception 'yii\web\HeadersAlreadySentException' with ...

- 在js中==和===的区别

“==”:叫相等运算符 “===”:叫严格运算符 它们两有什么区别呢? == :表示值相等则都为true ===:表示 不仅要值相等,双方类型也要相等才为true 例子如下: js代码如下: // “ ...

- Tomcat 配置介绍

参数说明: maxThreads: 最大可以创建请求的线程数 minSpareThreads: 服务启动时创建的处理请求的进程数 Connector中的port: 创建服务器端的端口号,此端口监听用户 ...