hive操作 -- zeppelin安装及配置

当时写hive用的是zeppelin,这个工具可以直接在页面上写sql语句,操作服务器上的hive库,还挺方便的

通过zeppelin实现hive的查询结果的可视化

启动过程中会报错:User: tong is not allowed to impersonate root

修改hadoop的配置文件core-site.xml,增加如下内容:

其中livy修改成自己的用户名

<property>

<name>hadoop.proxyuser.livy.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.livy.hosts</name>

<value>*</value>

</property>

下载好了以后拖拽到用户的home文件夹下打开终端cd到用户home文件夹下,解压缩

tar -zxvf zeppelin-0.7.3-bin-all.tgz

↓

进入到zeppelin的配置文件夹下

cd ~/zeppelin-0.7.3-bin-all/conf

编辑配置文件

cp zeppelin-env.sh.template zeppelin-env.sh

vi zeppelin-env.sh

在文件末尾添加代码段

JAVA_HOME为你的Java jdk路径

HADOOP_CONF_DIR是你的Hadoop的配置文件目录

(Hadoop2的配置文件目录一般在安装目录的etc的Hadoop目录下)

export JAVA_HOME=/usr/java/jdk1.7.0_71/

export HADOOP_CONF_DIR=~/hadoop-2.5.2/etc/hadoop

↓

如果hive没有登录用户则需在配置文件中添加,并把你的hive的配置文件 hive-site.xml 复制到zeppelin的conf配置文件夹下,hive的安装可以看之前的文章

cd ~/apache-hive-0.13.1-bin/conf

gedit hive-site.xml

添加代码

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hadoop</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hadoop</value>

</property>

其中 hadoop 是新建的用户名和密码

cp ~/apache-hive-0.13.1-bin/conf/hive-site.xml ~/zeppelin-0.7.3-bin-all/conf

↓

打开一个单独的终端,进入hive的安装目录(我这里是在apache-hive-0.13.1-bin目录),开启metastore和hiveserver2服务,关闭服务时直接 Ctrl+c 。开启的时候可能会有些延时。

./bin/hive --service metastore &

./bin/hiveserver2 &

↓

打开一个新的终端,进入zeppelin的bin目录下,开启程序

cd ~/zeppelin-0.7.3-bin-all/bin

./zeppelin-daemon.sh start 开启程序

./zeppelin-daemon.sh stop 停止程序

./zeppelin-daemon.sh restart 重启程序

↓

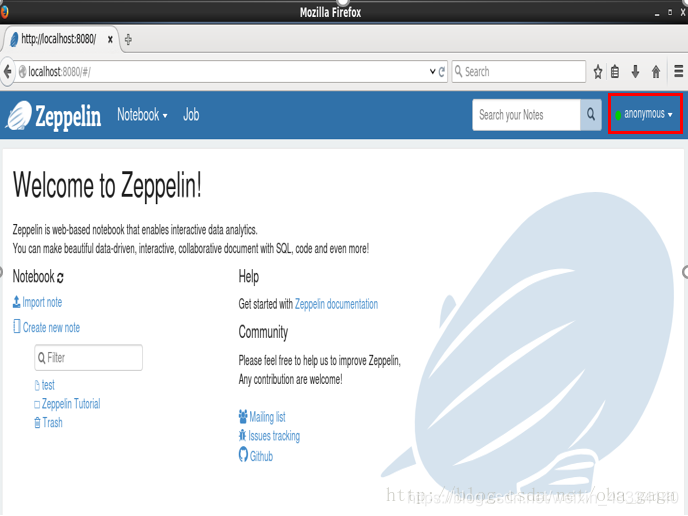

打开浏览器,输入URL ,出现下图界面则为成功,请确保你的电脑可以联网,并且8080端口没有被占用,如果被占用可以更改配置目录conf下,zeppelin-env.sh的参数

http://localhost:8080/

↓

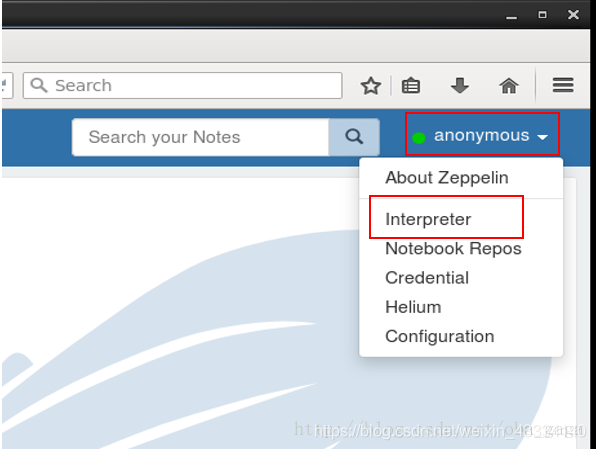

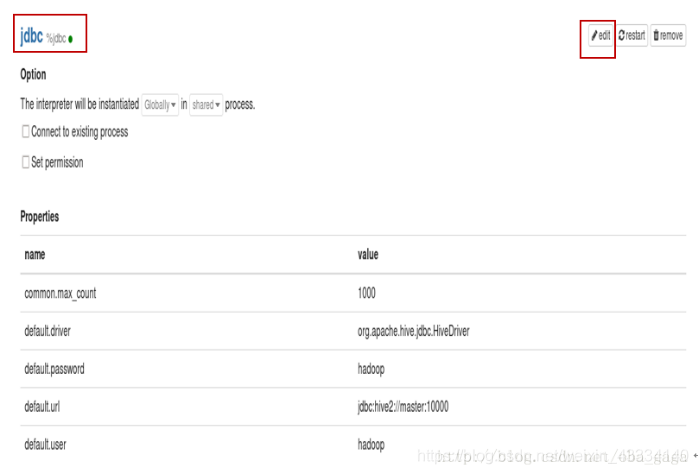

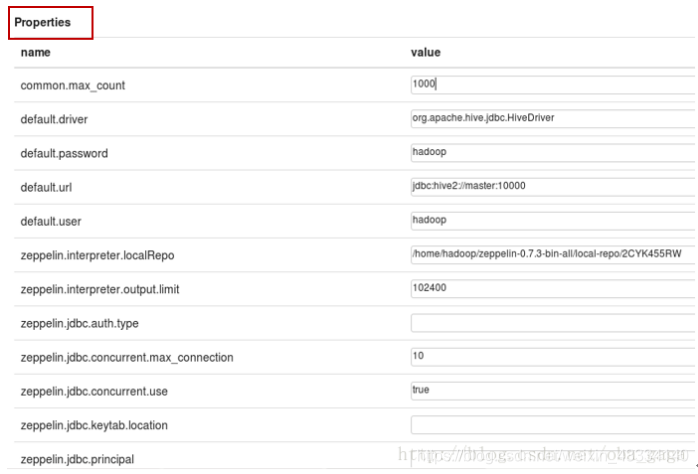

编辑通用编辑器 jdbc

需要修改的地方

default.driver org.apache.hive.jdbc.HiveDriver

default.url jdbc:hive2://master:10000

default.user 你的hive的用户名

default.password 你的hive的用户密码

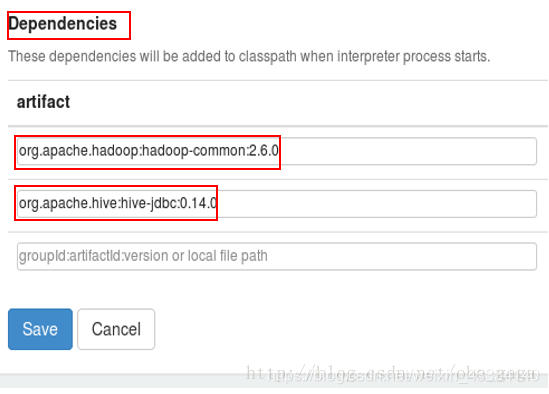

添加两个依赖包

org.apache.hadoop:hadoop-common:2.6.0(注意修改成自己Hadoop的版本)

org.apache.hive:hive-jdbc:0.14.0(注意修改成自己hive的版本)

注意Hadoop和hibe的版本

修改完以后保存并重启一下jdbc,可能会有些延迟。

启动完成后如果出先权限报错。查看hdfs dfs -ls / 修改文件权限

以后每次进入程序

1、打开Hadoop

start-all.sh 开启

stop-all.sh 关闭

2、进入hive安装目录,开启hiveserver2服务

./bin/hiveserver2 &

ctrl+c 关闭

3、进入zeppelin安装目录,运行zeppelin程序

./zeppelin-daemon.sh start

./zeppelin-daemon.sh stop

关机前把程序全部关闭。

hive操作 -- zeppelin安装及配置的更多相关文章

- Hive 教程(一)-安装与配置解析

安装就安装 ,不扯其他的 hive 依赖 在 hive 安装前必须具备如下条件 1. 一个可连接的关系型数据库,如 Mysql,postgresql 等,用于存储元数据 2. hadoop,并启动 h ...

- zeppelin安装及配置

1.下载安装包,zepplin下载地址:http://zeppelin.apache.org/download.html #创建解压目录 mkdir -p /opt/software #解压 tar ...

- 安装和配置hive

1.上传hive.mysql.mysql driver到服务器/mnt目录下: [root@chavin mnt]# ll mysql-5.6.24-linux-glibc2.5-x86_64.tar ...

- 【Hive一】Hive安装及配置

Hive安装及配置 下载hive安装包 此处以hive-0.13.1-cdh5.3.6版本的为例,包名为:hive-0.13.1-cdh5.3.6.tar.gz 解压Hive到安装目录 $ tar - ...

- Ubuntu16.04下Hive的安装与配置

一.系统环境 os : Ubuntu 16.04 LTS 64bit jdk : 1.8.0_161 hadoop : 2.6.4mysql : 5.7.21 hive : 2.1.0 在配置hive ...

- CentOS6安装各种大数据软件 第八章:Hive安装和配置

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- Hive安装、配置和使用

Hive概述 Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类SQL查询功能. Hive本质是:将HQL转化成MapReduce程序. Hive处理的数据存储 ...

- Spark2.0集成Hive操作的相关配置与注意事项

前言 已完成安装Apache Hive,具体安装步骤请参照,Linux基于Hadoop2.8.0集群安装配置Hive2.1.1及基础操作 补充说明 Hive中metastore(元数据存储)的三种方式 ...

- 基于Hadoop集群搭建Hive安装与配置(yum插件安装MySQL)---linux系统《小白篇》

用到的安装包有: apache-hive-1.2.1-bin.tar.gz mysql-connector-java-5.1.49.tar.gz 百度网盘链接: 链接:https://pan.baid ...

- 本地电脑安装和配置Redis操作客户端

下载需要的文件:http://pan.baidu.com/s/1gdfQePl 把这个下载下来解压就可以了,如图所示 第一步(配置本地服务) 点击run这个DOS执行命令 因为是自己的电脑测试 ...

随机推荐

- Odoo 基于Win10搭建基于Win10搭建odoo14开发环境搭建

实践环境 win10 Python 3.6.2 odoo_14.0.latest.tar.gz 下载地址: https://download.odoocdn.com/download/14/src?p ...

- MFC 关于按键状态获取

alt键会阻断消息? moousemovealt键无法判断,按下一次 并松开一次状态改变一次#define KeyState GetAsyncKeyState BOOL bCtrlDown = (Ke ...

- JWT浅了解

JWT通过数字签名的方式(让我想起了软考),以json对象为载体,在不同的服务终端之间安全传输信息 是一种授权认证 生成token的原理:通过header的加密方式,对payload进行加密.然后把h ...

- PyCharm配置Miniconda3

打开PyCharm,点击"File"(文件)菜单,选择"Settings"(设置) 选择python interpreter中的配置 选择add 选择Conda ...

- 从.net开发做到云原生运维(三)——.net core的学习路线

1. 前言 前面几篇文章主要讲了.net技术相关的基本概念和一些涉及的项目什么,本身也没讲太多底层的技术,这篇文章依旧不讲具体的技术,主要介绍.net技术的学习路线.学习路线也是我18年毕业的时候看到 ...

- Google的Jax框架的JAX-Triton目前只能成功运行在TPU设备上(使用Pallas为jax编写kernel扩展)—— GPU上目前无法正常运行,目前正处于 experimental 阶段

使用Pallas为jax编写kernel扩展,需要使用JAX-Triton扩展包.由于Google的深度学习框架Jax主要是面向自己的TPU进行开发的,虽然也同时支持NVIDIA的GPU,但是支持力度 ...

- Mybatis-Plus系统化学习之环境准备与简单使用

1.背景 平时在开发中会经常用到单表的CRUD操作 其实,这些单表的CRUD,完全不需要我们写sql,可以使用mybatis-plus自动生成,不但高效而且不容用出错! 2.mybatis-plus的 ...

- NuminaMath 是如何荣膺首届 AIMO 进步奖的?

今年,Numina 和 Hugging Face 合作角逐 AI 数学奥林匹克 (AI Math Olympiad,AIMO) 的首届进步奖.此次比赛旨在对开放 LLM 进行微调,以使其能解决高中难度 ...

- VideoGeneration

Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets 主要贡献:设计了一套数据清洗策略来清洗大 ...

- “vscode #include 错误”的问题解决办法

确定gcc没问题的情况下 打开这个文件 把linux下的文件直接复制过来 然后加上路径就OK了