Pytorch迁移学习

环境:

Pytorch1.1,Python3.6,win10/ubuntu18,GPU

正文

- Pytorch构建ResNet18模型并训练,进行真实图片分类;

- 利用预训练的ResNet18模型进行Fine tune,直接进行图片分类;站在巨人的肩膀上,使用已经在ImageNet上训练好的模型,除了最后一层全连接层,中间层的参数全部迁移到目标模型上,如下图所示

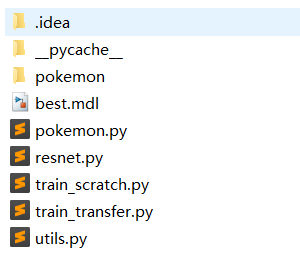

项目结构如下所示

pokemon里面存放数据,分别是五个文件夹,其中每个文件夹分别存放一定数量的图片,总共1000多张图片;

best.mdl是保存下来的模型,可以直接加载进行分类

resnet.py是自己搭建的ResNet18模型

train_scratch.py利用resnet.py中的ResNet18模型进行图片分类

train_transfer.py利用下载的ResNet18模型进行图片分类

接下来进入正题:

pokemon.py:

import torch

import os, glob

import random, csv from torch.utils.data import Dataset, DataLoader from torchvision import transforms

from PIL import Image class Pokemon(Dataset): def __init__(self, root, resize, mode):

super(Pokemon, self).__init__() self.root = root

self.resize = resize self.name2label = {} # "sq...":0

for name in sorted(os.listdir(os.path.join(root))):

if not os.path.isdir(os.path.join(root, name)):

continue self.name2label[name] = len(self.name2label.keys()) # print(self.name2label) # image, label

self.images, self.labels = self.load_csv('images.csv') if mode=='train': # 60%

self.images = self.images[:int(0.6*len(self.images))]

self.labels = self.labels[:int(0.6*len(self.labels))]

elif mode=='val': # 20% = 60%->80%

self.images = self.images[int(0.6*len(self.images)):int(0.8*len(self.images))]

self.labels = self.labels[int(0.6*len(self.labels)):int(0.8*len(self.labels))]

else: # 20% = 80%->100%

self.images = self.images[int(0.8*len(self.images)):]

self.labels = self.labels[int(0.8*len(self.labels)):] def load_csv(self, filename): if not os.path.exists(os.path.join(self.root, filename)):

images = []

for name in self.name2label.keys():

# 'pokemon\\mewtwo\\00001.png

images += glob.glob(os.path.join(self.root, name, '*.png'))

images += glob.glob(os.path.join(self.root, name, '*.jpg'))

images += glob.glob(os.path.join(self.root, name, '*.jpeg')) # 1167, 'pokemon\\bulbasaur\\00000000.png'

print(len(images), images) random.shuffle(images)

with open(os.path.join(self.root, filename), mode='w', newline='') as f:

writer = csv.writer(f)

for img in images: # 'pokemon\\bulbasaur\\00000000.png'

name = img.split(os.sep)[-2]

label = self.name2label[name]

# 'pokemon\\bulbasaur\\00000000.png', 0

writer.writerow([img, label])

print('writen into csv file:', filename) # read from csv file

images, labels = [], []

with open(os.path.join(self.root, filename)) as f:

reader = csv.reader(f)

for row in reader:

# 'pokemon\\bulbasaur\\00000000.png', 0

img, label = row

label = int(label) images.append(img)

labels.append(label) assert len(images) == len(labels) return images, labels def __len__(self): return len(self.images) def denormalize(self, x_hat): mean = [0.485, 0.456, 0.406]

std = [0.229, 0.224, 0.225] # x_hat = (x-mean)/std

# x = x_hat*std = mean

# x: [c, h, w]

# mean: [3] => [3, 1, 1]

mean = torch.tensor(mean).unsqueeze(1).unsqueeze(1)

std = torch.tensor(std).unsqueeze(1).unsqueeze(1)

# print(mean.shape, std.shape)

x = x_hat * std + mean return x def __getitem__(self, idx):

# idx~[0~len(images)]

# self.images, self.labels

# img: 'pokemon\\bulbasaur\\00000000.png'

# label: 0

img, label = self.images[idx], self.labels[idx] tf = transforms.Compose([

lambda x:Image.open(x).convert('RGB'), # string path= > image data

transforms.Resize((int(self.resize*1.25), int(self.resize*1.25))),

transforms.RandomRotation(15),

transforms.CenterCrop(self.resize),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225])

]) img = tf(img)

label = torch.tensor(label) return img, label def main(): import visdom

import time

import torchvision viz = visdom.Visdom() # tf = transforms.Compose([

# transforms.Resize((64,64)),

# transforms.ToTensor(),

# ])

# db = torchvision.datasets.ImageFolder(root='pokemon', transform=tf)

# loader = DataLoader(db, batch_size=32, shuffle=True)

#

# print(db.class_to_idx)

#

# for x,y in loader:

# viz.images(x, nrow=8, win='batch', opts=dict(title='batch'))

# viz.text(str(y.numpy()), win='label', opts=dict(title='batch-y'))

#

# time.sleep(10) db = Pokemon('pokemon', 224, 'train') x,y = next(iter(db))

print('sample:', x.shape, y.shape, y) viz.image(db.denormalize(x), win='sample_x', opts=dict(title='sample_x')) loader = DataLoader(db, batch_size=32, shuffle=True, num_workers=8) for x,y in loader:

viz.images(db.denormalize(x), nrow=8, win='batch', opts=dict(title='batch'))

viz.text(str(y.numpy()), win='label', opts=dict(title='batch-y')) time.sleep(10) if __name__ == '__main__':

main()

注释:Pokemon类功能是对数据集进行解析,把文件夹中的图片分成train,val,test三个集合

Pytorch迁移学习的更多相关文章

- Pytorch迁移学习实现驾驶场景分类

Pytorch迁移学习实现驾驶场景分类 源代码:https://github.com/Dalaska/scene_clf 1.安装 pytorch 直接用官网上的方法能装上但下载很慢.通过换源安装发现 ...

- PyTorch迁移学习-私人数据集上的蚂蚁蜜蜂分类

迁移学习的两个主要场景 微调CNN:使用预训练的网络来初始化自己的网络,而不是随机初始化,然后训练即可 将CNN看成固定的特征提取器:固定前面的层,重写最后的全连接层,只有这个新的层会被训练 下面修改 ...

- pytorch 迁移学习[摘自官网]

迁移学习包含两种:微调和特征提取器. 微调:对整个网络进行训练,更新所有参数 特征提取器:只对最后的输出层训练,其他层的权重保持不变 当然,二者的共性就是需要加载训练好的权重,比如在ImageNet上 ...

- 修改pytorch官方实例适用于自己的二分类迁移学习项目

本demo从pytorch官方的迁移学习示例修改而来,增加了以下功能: 根据AUC来迭代最优参数: 五折交叉验证: 输出验证集错误分类图片: 输出分类报告并保存AUC结果图片. import os i ...

- PyTorch基础——迁移学习

一.介绍 内容 使机器能够"举一反三"的能力 知识点 使用 PyTorch 的数据集套件从本地加载数据的方法 迁移训练好的大型神经网络模型到自己模型中的方法 迁移学习与普通深度学习 ...

- 使用PyTorch进行迁移学习

概述 迁移学习可以改变你建立机器学习和深度学习模型的方式 了解如何使用PyTorch进行迁移学习,以及如何将其与使用预训练的模型联系起来 我们将使用真实世界的数据集,并比较使用卷积神经网络(CNNs) ...

- PyTorch专栏(五):迁移学习

专栏目录: 第一章:PyTorch之简介与下载 PyTorch简介 PyTorch环境搭建 第二章:PyTorch之60分钟入门 PyTorch入门 PyTorch自动微分 PyTorch神经网络 P ...

- pytorch 测试 迁移学习

训练源码: 源码仓库:https://github.com/pytorch/tutorials 迁移学习测试代码:tutorials/beginner_source/transfer_learning ...

- [PyTorch入门]之迁移学习

迁移学习教程 来自这里. 在本教程中,你将学习如何使用迁移学习来训练你的网络.在cs231n notes你可以了解更多关于迁移学习的知识. 在实践中,很少有人从头开始训练整个卷积网络(使用随机初始化) ...

随机推荐

- token和sign

前言 在app开放接口api的设计中,避免不了的就是安全性问题,因为大多数接口涉及到用户的个人信息以及一些敏感的数据,所以对这些接口需要进行身份的认证,那么这就需要用户提供一些信息,比如用户名密码等, ...

- linux就该这么学.pdf

链接:https://pan.baidu.com/s/1mhYIqgg 密码:ay0j

- redis中如何存储java对象

根据redis的存储原理,Redis的key和value都支持二进制安全的字符串 1.利用序列化和反序列化的方式 存储java对象我们可以通过对象的序列化与反序列化完成存储于取出,这样就可以使用red ...

- C# 、Java数组申明、初始化区别

一.数组申明 int[] a1 int a2[] C# 支持 不支持 Java 支持 支持 二.数组申明且初始化 int[] a1 = new int[] { 2, 31 } int a1[ ...

- Zabbix4.x安装部署

zabbix监控的重要性就不用再赘述了.直接上干货. 1.环境背景: Linux:CentOS 7.x, Database:MySQL zabbix server 和 zabbix mysql 安装在 ...

- mybatis config 配置设置说明

<!– 配置设置 –> 2. <settings> 3. <!– 配置全局性 cache 的 ( 开 / 关) defau ...

- ubuntu1604-Python35-cuda9-cudnn7-gpu-dockerfile

一,在某目录下有如下文件: -rw-r--r-- 1 root root 1643293725 9月 2 11:46 cuda_9.0.176_384.81_linux.run -rw-r--r-- ...

- #420 Div2 Problem B Okabe and Banana Trees (math && 暴力枚举)

题目链接 :http://codeforces.com/contest/821/problem/B 题意 :给出 m 和 b 表示在坐标轴上的一条直线 要求你在这条直线和x.y轴围成的区域中找出一个 ...

- c++11相关特性

前言 发现好多情况下都会用到c++11的新特性啊. 所以稍稍总结一下,只会粗略的说,不会详细的讲…… upd.csp-s可能不是c++11标准,请慎用.(博主考试CE后的善意提醒) 1.auto&am ...

- CSV文件在Python中的几种处理方式

Comma Separated Values,简称CSV,它是一种以逗号分隔数值的文件类型.在数据库或电子表格中,它是最常见的导入导出格式,它以一种简单而明了的方式存储和共享数据,CSV文件通常以纯文 ...