目标检测之Faster-RCNN的pytorch代码详解(模型训练篇)

本文所用代码gayhub的地址:https://github.com/chenyuntc/simple-faster-rcnn-pytorch (非本人所写,博文只是解释代码)

好长时间没有发博客了,感觉也没啥人读我的博客,不过我不能放弃啊,总会有人发现它的价值的,哈哈!最近一直在生啃目标检测的几篇论文,距离成为我想象中的大神还有很远的一段距离啊,刚啃完Faster-RCNN的论文的时候,觉得可能是语言的关系,自己看得一直是似懂非懂的,感觉没有掌握到里面的精髓,于是我决定撸代码来看,据说Ross Girshick大神的代码很健壮,看了下是基于caffe/caffe2写的,自己不太熟悉caffe的框架和环境,于是就心血来潮在网上找基于pytorch的Faster-RCNN的代码,最后还真被我找到了陈云写的simple-faster-rcnn-pytorch-master,能从头撸出Faster-RCNN的实现真的是十分的不容易,我光读就读了一个星期,真是惭愧,差距还是很大的!simple-faster-RCNN顾名思义就是简化版的faster-rcnn,作者说代码除去注释只有2000行左右,但是能达到和rgb大神差不多的精度,真的是很了不起了!为此我还特意买了作者一本书,就当是付费看代码吧~

具体的实现精度和相关的环境建议大家仔细阅读作者的README文件,上面讲的很清楚,本篇博客主要负责解释代码,以备日后重新读不用这么费力气。

本篇博客是整个Faster-rcnn系列的第四篇文章,主要解释/simple-faster-rcnn-pytorch-master/train.py 以及/simple-faster-rcnn-pytorch-master/trainer.py

前三章地址在:

1 Faster-RCNN的数据读取及预处理部分:(对应于代码的/simple-faster-rcnn-pytorch-master/data文件夹)

2 Faster-RCNN的模型准备部分:(对应于代码目录/simple-faster-rcnn-pytorch-master/model/utils/文件夹)

3 Faster-RCNN的模型正式介绍:(对应于代码目录/simple-faster-rcnn-pytorch-master/model/文件夹)

下面正式开始介绍Faster-rcnn的训练部分的代码

一:trainer.py部分代码:

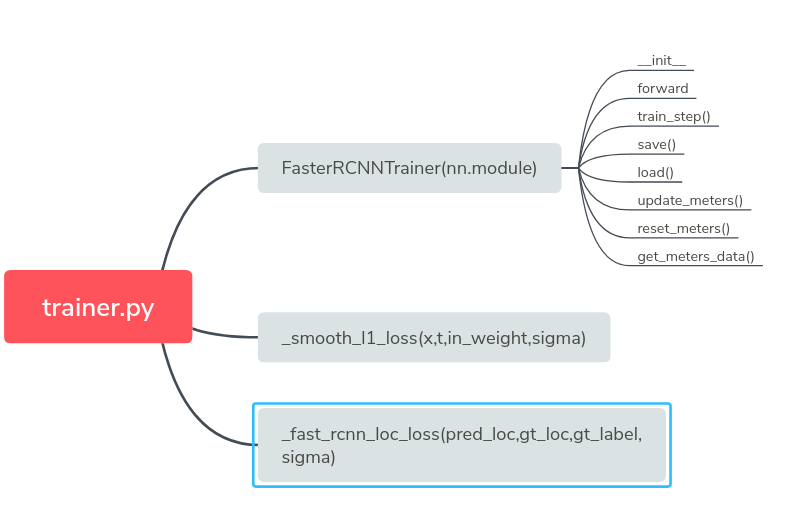

首先来看trainer.py,因为trainer.py里面实现了很多函数供train.py调用,trainer.py文件里函数结构如下图:

然后我们开始一个函数一个函数的进行剖析,可能读着读着你就会发现原来晦涩难懂的问题突然就变得很直觉了!

1 __init__函数 代码如下:

- def __init__(self, faster_rcnn):

- super(FasterRCNNTrainer, self).__init__()

- self.faster_rcnn = faster_rcnn

- self.rpn_sigma = opt.rpn_sigma

- self.roi_sigma = opt.roi_sigma

- # target creator create gt_bbox gt_label etc as training targets.

- self.anchor_target_creator = AnchorTargetCreator()

- self.proposal_target_creator = ProposalTargetCreator()

- self.loc_normalize_mean = faster_rcnn.loc_normalize_mean

- self.loc_normalize_std = faster_rcnn.loc_normalize_std

- self.optimizer = self.faster_rcnn.get_optimizer()

- # visdom wrapper

- self.vis = Visualizer(env=opt.env)

- # indicators for training status

- self.rpn_cm = ConfusionMeter(2)

- self.roi_cm = ConfusionMeter(21)

- self.meters = {k: AverageValueMeter() for k in LossTuple._fields}

__init__

__init__ Faster_RCNNTrainer的初始化函数,其父类是nn.module,主要是一些变量的初始化部分,定义了self.faster_rcnn = faster_rcnn,而这个rpn_sigma和roi_sigma是在_faster_rcnn_loc_loss调用用来计算位置损失函数用到的超参数,

之后定义了十分重要的两个函数,AnchorTargetCreator()和ProposalTargetCreator(),它们一个用于从20000个候选anchor中产生256个anchor进行二分类和位置回归,也就是为rpn网络产生的预测位置和预测类别提供真正的ground_truth标准

用于rpn网络的自我训练,自我提高,提升产生ROIs的精度!具体的筛选过程和准则看前面几篇文章,而ProposalTargetCreator()的作用是从2000个筛选出的ROIS中再次选出128个ROIs用于训练,它的作用和前面的anchortargetCreator类似,不过它们服务的网络是不同的,前面anchortargetCreator服务的是RPN网络,而我们的proposaltargetCreator服务的是ROIHearder的网络,ROIheader的作用就是真正产生ROI__loc和ROI_cls的网络,它完成了目标检测最重要的预测目标位置和类别!之后定义了位置信息的均值方差,因为送入到网络训练的位置信息全部是归一化处理的,需要用到相关的均值和方差数据,接下来是优化器数据,用的是faster_rcnn文件里的get_optimizer()数据,里面决定了是使用Adam还是SGD等等,以及衰减率的设置之类,最后是可视化部分的一些设置,rpn_cm是混淆矩阵,就是验证预测值与真实值精确度的矩阵ConfusionMeter(2)括号里的参数指的是类别数,所以rpn_cm =2,而roi_cm =21因为roi的类别有21种(20个object类+1个background)

2 def forward(self,imgs,bboxes,labels,scale)函数 代码如下:

- def forward(self, imgs, bboxes, labels, scale):

- """Forward Faster R-CNN and calculate losses.

- Here are notations used.

- * :math:`N` is the batch size.

- * :math:`R` is the number of bounding boxes per image.

- Currently, only :math:`N=1` is supported.

- Args:

- imgs (~torch.autograd.Variable): A variable with a batch of images.

- bboxes (~torch.autograd.Variable): A batch of bounding boxes.

- Its shape is :math:`(N, R, 4)`.

- labels (~torch.autograd..Variable): A batch of labels.

- Its shape is :math:`(N, R)`. The background is excluded from

- the definition, which means that the range of the value

- is :math:`[0, L - 1]`. :math:`L` is the number of foreground

- classes.

- scale (float): Amount of scaling applied to

- the raw image during preprocessing.

- Returns:

- namedtuple of 5 losses

- """

- n = bboxes.shape[0]

- if n != 1:

- raise ValueError('Currently only batch size 1 is supported.')

- _, _, H, W = imgs.shape

- img_size = (H, W)

- features = self.faster_rcnn.extractor(imgs)

- rpn_locs, rpn_scores, rois, roi_indices, anchor = \

- self.faster_rcnn.rpn(features, img_size, scale)

- # Since batch size is one, convert variables to singular form

- bbox = bboxes[0]

- label = labels[0]

- rpn_score = rpn_scores[0]

- rpn_loc = rpn_locs[0]

- roi = rois

- # Sample RoIs and forward

- # it's fine to break the computation graph of rois,

- # consider them as constant input

- sample_roi, gt_roi_loc, gt_roi_label = self.proposal_target_creator(

- roi,

- at.tonumpy(bbox),

- at.tonumpy(label),

- self.loc_normalize_mean,

- self.loc_normalize_std)

- # NOTE it's all zero because now it only support for batch=1 now

- sample_roi_index = t.zeros(len(sample_roi))

- roi_cls_loc, roi_score = self.faster_rcnn.head(

- features,

- sample_roi,

- sample_roi_index)

- # ------------------ RPN losses -------------------#

- gt_rpn_loc, gt_rpn_label = self.anchor_target_creator(

- at.tonumpy(bbox),

- anchor,

- img_size)

- gt_rpn_label = at.totensor(gt_rpn_label).long()

- gt_rpn_loc = at.totensor(gt_rpn_loc)

- rpn_loc_loss = _fast_rcnn_loc_loss(

- rpn_loc,

- gt_rpn_loc,

- gt_rpn_label.data, #定位损失为什么加label大概是因为负例不参与定位损失吧

- self.rpn_sigma)

- # NOTE: default value of ignore_index is -100 ...

- rpn_cls_loss = F.cross_entropy(rpn_score, gt_rpn_label.cuda(), ignore_index=-1)

- _gt_rpn_label = gt_rpn_label[gt_rpn_label > -1]

- _rpn_score = at.tonumpy(rpn_score)[at.tonumpy(gt_rpn_label) > -1]

- self.rpn_cm.add(at.totensor(_rpn_score, False), _gt_rpn_label.data.long())

- # ------------------ ROI losses (fast rcnn loss) -------------------#

- n_sample = roi_cls_loc.shape[0]

- roi_cls_loc = roi_cls_loc.view(n_sample, -1, 4)

- roi_loc = roi_cls_loc[t.arange(0, n_sample).long().cuda(), \

- at.totensor(gt_roi_label).long()]

- gt_roi_label = at.totensor(gt_roi_label).long()

- gt_roi_loc = at.totensor(gt_roi_loc)

- roi_loc_loss = _fast_rcnn_loc_loss(

- roi_loc.contiguous(),

- gt_roi_loc,

- gt_roi_label.data,

- self.roi_sigma)

- roi_cls_loss = nn.CrossEntropyLoss()(roi_score, gt_roi_label.cuda())

- self.roi_cm.add(at.totensor(roi_score, False), gt_roi_label.data.long())

- losses = [rpn_loc_loss, rpn_cls_loss, roi_loc_loss, roi_cls_loss]

- losses = losses + [sum(losses)]

- return LossTuple(*losses)

forward()

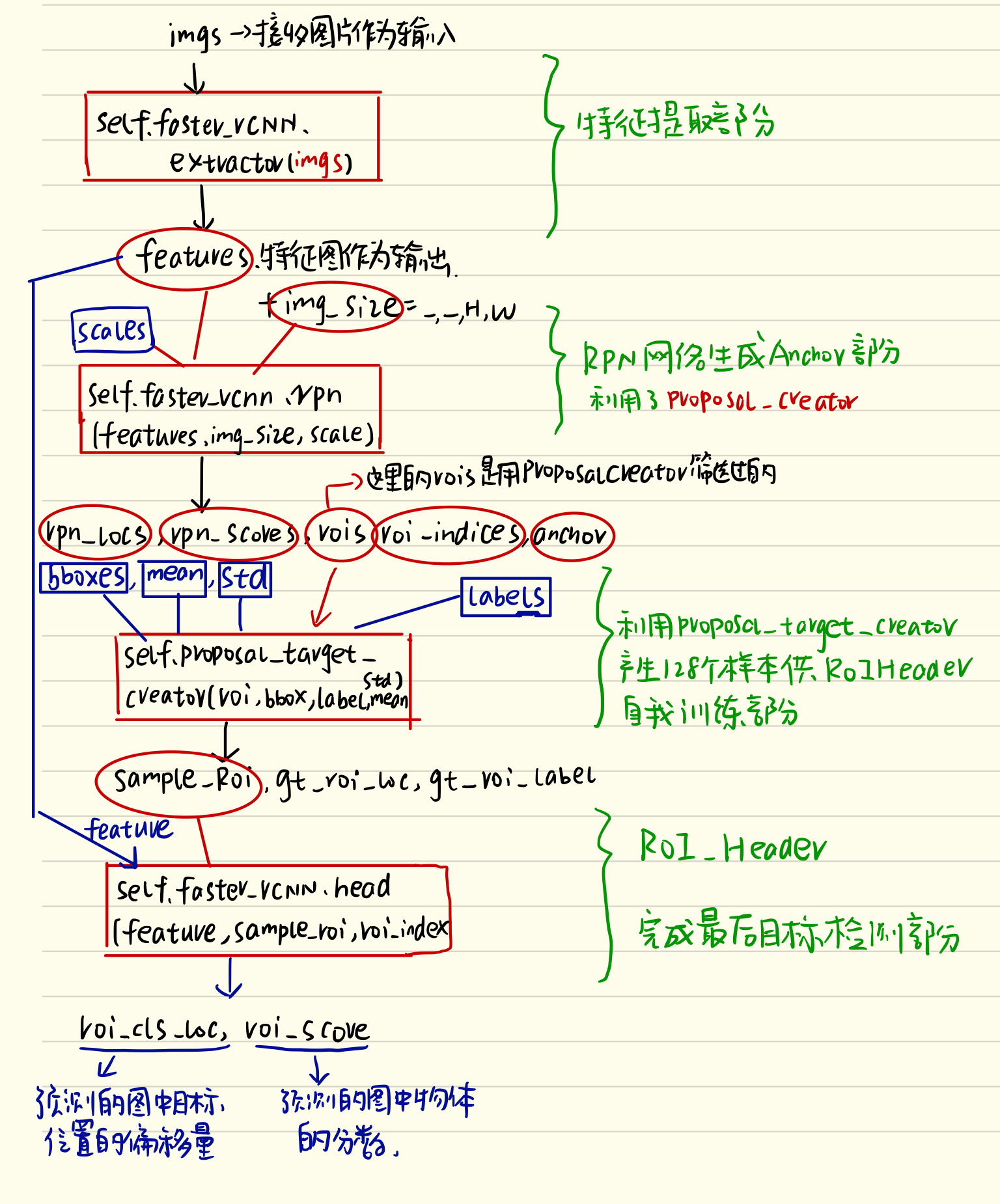

这段函数该是整个文件的精髓,画一张流程图出来描述整个网络的运作过程:

整幅图片描述在求损失之前训练过程经历了什么!不准确的说是一个伪正向传播的过程,为啥说是伪正向传播呢,因为过程中调用了proposal_target_creator(),而这个函数的作用其实是为了训练ROI_Header网络而提供所谓的128张sample_roi以及它的ground_truth的位置和label用的!所以它的根本目的是为了训练网络,在测试的时候是用不到的!流程图中红色圆框代表的是网络运行过程中产生的参数,而蓝色框代表的是网络定义的时候就有的参数!仔细看整个流程图,网络的运作结构就一目了然了!下面解释下代码:

n= bboxes.shape[0]首先获取batch个数,如果不等于就报错,因为本程序只支持batch_size=1,接着读取图片的高和宽,这里解释下,不论图片还是bbox,它们的数据格式都是形如n,c,hh,ww这种,所以H,W就可以获取到图片的尺寸,紧接着用self.faster_rcnn.extractor(imgs)提取图片的特征,然后放到rpn网络里面self.faster_rcnn.rpn(feature,img_size,scale)提取出rpn_locs,rpn_scores,rois,roi_indices,anchor来,下一步就是经过proposal_target_creator网络产生采样过后的sample_roi,以及其对应的gt_cls_loc和gt_score,最后经过head网络,完成整个的预测过程!流程图中的结构是一模一样的!

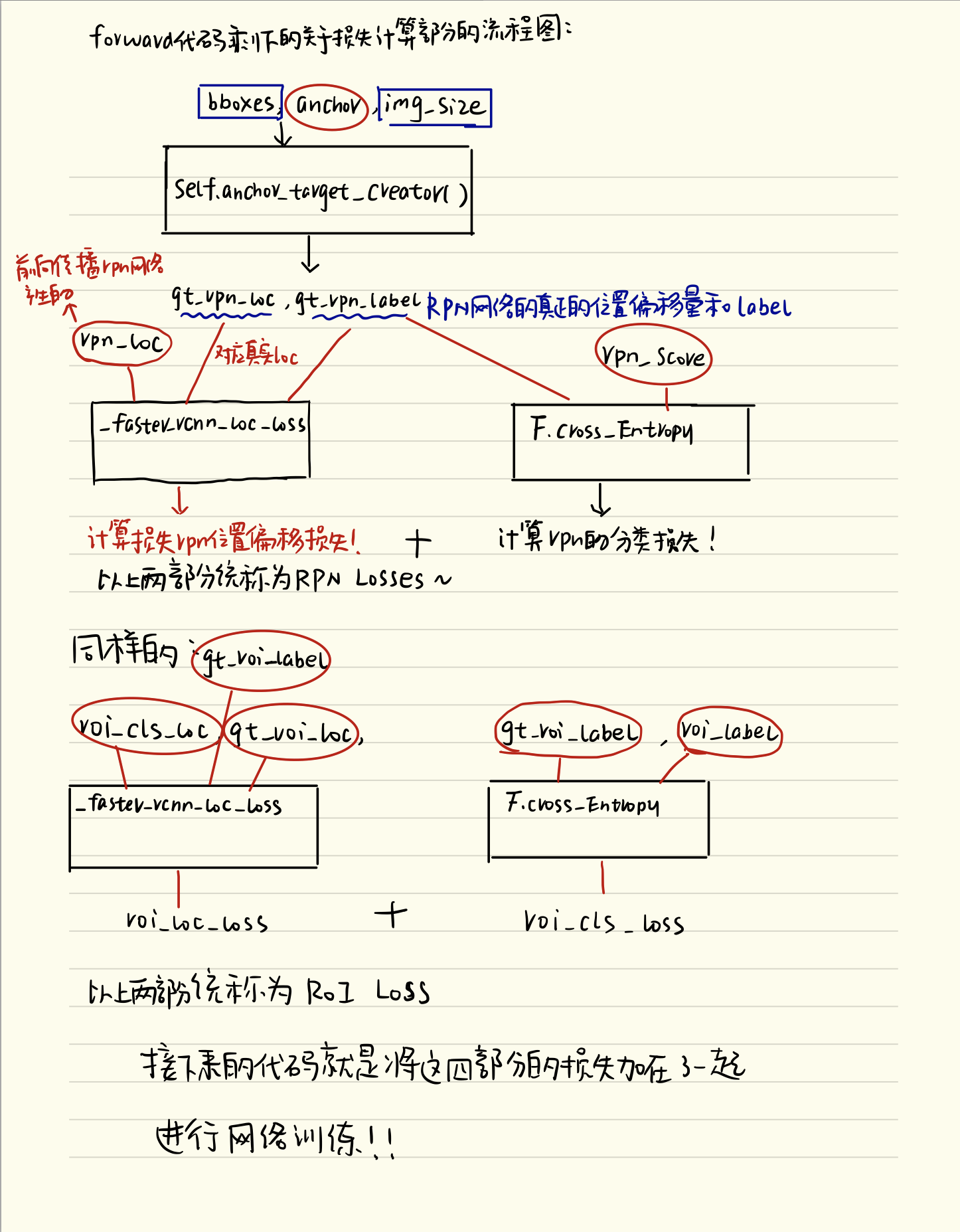

但是这个文件之所以叫trainer就是因为不仅仅有正向的运作过程,肯定还有反向的传播,包括了损失计算等等,没错,接下来我们看下面的损失计算部分的流程图:

如上图所示,其实剩下的代码就是计算了两部分的损失,一个是RPN_losses,一个是ROI_Losses,为啥要这样做呢?大家考虑一下,这个Faster-rcnn的网络,哪些地方应用到了网络呢?一个是提取proposal的过程,在faster-rcnn里创造性的提出了anchor,用网络来产生proposals,所以rpn_losses就是为了计算这部分的损失,从而使用梯度下降的办法来提升提取prososal的网络的性能,另一个使用到网络的地方就是ROI_header,没错就是在利用特征图和ROIs来预测目标检测的类别以及位置的偏移量的时候再一次使用到了网络,那这部分预测网络的性能如何保证呢?ROI_losses就是计算这部分的损失函数,从而用梯度下降的办法来继续提升网络的性能啊兄弟!这样一来,这两部分的网络的损失都记算出来了!forward函数也就介绍完了!这个地方需要特别注意的一点就是rpn_cm和roi_cm这两个对象应该是Confusion matrix也就是混淆矩阵啦,作用就是用于后续的数据可视化,不是本文重点介绍的内容啦!

3 def train_step(self,imgs,bboxes,labels,scale)函数,代码如下:

- def train_step(self, imgs, bboxes, labels, scale):

- self.optimizer.zero_grad()

- losses = self.forward(imgs, bboxes, labels, scale)

- losses.total_loss.backward()

- self.optimizer.step()#进行一次参数优化过程

- self.update_meters(losses)

- return losses

train_step

整个函数实际上就是进行了一次参数的优化过程,首先self.optimizer.zero_grad()将梯度数据全部清零,然后利用刚刚介绍的self.forward(imgs,bboxes,labels,scales)函数将所有的损失计算出来,接着进行依次losses.total_loss.backward()反向传播计算梯度,self.optimizer.step()进行一次参数更新过程,self.update_meters(losses)就是将所有损失的数据更新到可视化界面上,最后将losses返回!

4 def save() def load() def update_meters(),def reset_meters() def get_meter_data()函数

这几个函数不想仔细展开解释了,顾名思义,save和load就是根据传入的参数来选择保存model模型或者说config设置或者是other_info其他参数vis_info可视化参数等等

而update_meters,reset_meters以及get_meter_data()就是负责将数据向可视化界面更新传输获取以及重置的函数,基本上也和主要代码没什么太大的关系!

5 def _smooth_l1_loss(x,t,in_weight,sigma)函数,代码如下:

- def _smooth_l1_loss(x, t, in_weight, sigma):

- sigma2 = sigma ** 2

- diff = in_weight * (x - t)

- abs_diff = diff.abs()

- flag = (abs_diff.data < (1. / sigma2)).float()

- y = (flag * (sigma2 / 2.) * (diff ** 2) +

- (1 - flag) * (abs_diff - 0.5 / sigma2))

- return y.sum()

_smooth_l1_loss

这个函数其实就是写了一个smooth_l1损失函数的计算公式,这个公式里面的x,t就是代表预测和实际的两个变量,in_weight代表的是权重,因为在计算损失函数的过程中被标定为背景的那一类其实是不计算损失函数的,所以说可以巧妙地将对应的权重设置为0,这样就完成了忽略背景类的目的,这也就是为什么计算位置的损失函数还要传入ground_truth的label作为参数的原因,sigma是一个因子,在前面的__init__函数里有定义好!

6 def _fast_rcnn_loc_loss(pred_loc,gt_loc,gt_label,sigma)函数,代码如下:

- def _fast_rcnn_loc_loss(pred_loc, gt_loc, gt_label, sigma):

- in_weight = t.zeros(gt_loc.shape).cuda()

- # Localization loss is calculated only for positive rois.

- # NOTE: unlike origin implementation,

- # we don't need inside_weight and outside_weight, they can calculate by gt_label

- in_weight[(gt_label > 0).view(-1, 1).expand_as(in_weight).cuda()] = 1

- loc_loss = _smooth_l1_loss(pred_loc, gt_loc, in_weight.detach(), sigma)

- # Normalize by total number of negtive and positive rois.

- loc_loss /= ((gt_label >= 0).sum().float()) # ignore gt_label==-1 for rpn_loss

- return loc_loss

_faster_rcnn_loc_loss()

这个函数完成的任务就是我刚刚在前面说的,用in_weight来作为权重,只将那些不是背景的anchor/ROIs的位置加入到损失函数的计算中来,方法就是只给不是背景的anchor/ROIs的in_weight设置为1,这样就可以完成loc_loss的求和计算,最后进行返回就完成了计算位置损失的任务!

二:train.py部分代码:

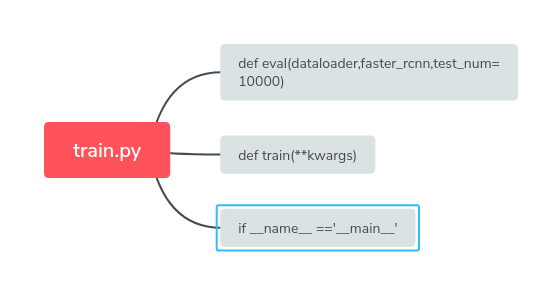

接下来就是train.py部分的代码了,同样的先将程序框图送上:

看这程序框图仿佛发现这个文件好像根本没啥东西啊,不着急我们慢慢展开来介绍:

1 def eval(dataloader,faster_rcnn,test_num=10000)函数,代码如下:

- def eval(dataloader, faster_rcnn, test_num=10000):

- pred_bboxes, pred_labels, pred_scores = list(), list(), list()

- gt_bboxes, gt_labels, gt_difficults = list(), list(), list()

- for ii, (imgs, sizes, gt_bboxes_, gt_labels_, gt_difficults_) in tqdm(enumerate(dataloader)):

- sizes = [sizes[0][0].item(), sizes[1][0].item()]

- pred_bboxes_, pred_labels_, pred_scores_ = faster_rcnn.predict(imgs, [sizes])

- gt_bboxes += list(gt_bboxes_.numpy())

- gt_labels += list(gt_labels_.numpy())

- gt_difficults += list(gt_difficults_.numpy())

- pred_bboxes += pred_bboxes_

- pred_labels += pred_labels_

- pred_scores += pred_scores_

- if ii == test_num: break

- result = eval_detection_voc(

- pred_bboxes, pred_labels, pred_scores,

- gt_bboxes, gt_labels, gt_difficults,

- use_07_metric=True)

- return result

eval()

eval()顾名思义,就是一个评估预测结果好坏的函数,展开来看果不其然,首先pred_bboxes,pred_labels,pred_scores ,gt_bboxes,gt_labels,gt_difficults 一开始就定义了这么多的list列表!它们分别是预测框的位置,预测框的类别和分数以及相应的真实值的类别分数等等!

接下来就是一个for循环,从 enumerate(dataloader)里面依次读取数据,读取的内容是: imgs图片,sizes尺寸,gt_boxes真实框的位置 gt_labels真实框的类别以及gt_difficults这些

然后利用faster_rcnn.predict(imgs,[sizes]) 得出预测的pred_boxes_,pred_labels_,pred_scores_预测框位置,预测框标记以及预测框的分数等等!这里的predict是真正的前向传播过程!完成真正的预测目的!

之后将pred_bbox,pred_label,pred_score ,gt_bbox,gt_label,gt_difficult预测和真实的值全部依次添加到开始定义好的列表里面去,如果迭代次数等于测试test_num,那么就跳出循环!调用 eval_detection_voc函数,接收上述的六个列表参数,完成预测水平的评估!得到预测的结果!这个eval_detection_voc后面会解释!

2 def train(**kwargs)函数,代码如下:

- def train(**kwargs):

- opt._parse(kwargs)

- dataset = Dataset(opt)

- print('load data')

- dataloader = data_.DataLoader(dataset, \

- batch_size=1, \

- shuffle=True, \

- # pin_memory=True,

- num_workers=opt.num_workers)

- testset = TestDataset(opt)

- test_dataloader = data_.DataLoader(testset,

- batch_size=1,

- num_workers=opt.test_num_workers,

- shuffle=False, \

- pin_memory=True

- )

- faster_rcnn = FasterRCNNVGG16()

- print('model construct completed')

- trainer = FasterRCNNTrainer(faster_rcnn).cuda()

- if opt.load_path:

- trainer.load(opt.load_path)

- print('load pretrained model from %s' % opt.load_path)

- trainer.vis.text(dataset.db.label_names, win='labels')

- best_map = 0

- lr_ = opt.lr

- for epoch in range(opt.epoch):

- trainer.reset_meters()

- for ii, (img, bbox_, label_, scale) in tqdm(enumerate(dataloader)):

- scale = at.scalar(scale)

- img, bbox, label = img.cuda().float(), bbox_.cuda(), label_.cuda()

- trainer.train_step(img, bbox, label, scale)#进行一次参数优化过程

- if (ii + 1) % opt.plot_every == 0:

- if os.path.exists(opt.debug_file):

- ipdb.set_trace()

- # plot loss

- trainer.vis.plot_many(trainer.get_meter_data())

- # plot groud truth bboxes

- ori_img_ = inverse_normalize(at.tonumpy(img[0]))

- gt_img = visdom_bbox(ori_img_,

- at.tonumpy(bbox_[0]),

- at.tonumpy(label_[0]))

- trainer.vis.img('gt_img', gt_img)

- # plot predicti bboxes

- _bboxes, _labels, _scores = trainer.faster_rcnn.predict([ori_img_], visualize=True)

- pred_img = visdom_bbox(ori_img_,

- at.tonumpy(_bboxes[0]),

- at.tonumpy(_labels[0]).reshape(-1),

- at.tonumpy(_scores[0]))

- trainer.vis.img('pred_img', pred_img)

- # rpn confusion matrix(meter)

- trainer.vis.text(str(trainer.rpn_cm.value().tolist()), win='rpn_cm')

- # roi confusion matrix

- trainer.vis.img('roi_cm', at.totensor(trainer.roi_cm.conf, False).float())

- eval_result = eval(test_dataloader, faster_rcnn, test_num=opt.test_num)

- trainer.vis.plot('test_map', eval_result['map'])

- lr_ = trainer.faster_rcnn.optimizer.param_groups[0]['lr']

- log_info = 'lr:{}, map:{},loss:{}'.format(str(lr_),

- str(eval_result['map']),

- str(trainer.get_meter_data()))

- trainer.vis.log(log_info)

- if eval_result['map'] > best_map:

- best_map = eval_result['map']

- best_path = trainer.save(best_map=best_map)

- if epoch == 9:

- trainer.load(best_path)

- trainer.faster_rcnn.scale_lr(opt.lr_decay)

- lr_ = lr_ * opt.lr_decay

- if epoch == 13:

- break

train(**kwargs)

这个函数是这篇文章的重点部分,也是整个网络的训练部分,首先来看下代码:

首先是 opt._parse(**kwargs) + dataset = Dataset(opt) 我认为这个地方就是将调用函数时候附加的参数用config.py文件里面的opt._parse()进行解释,然后获取其数据存储的路径,之后放到Dataset里面!Dataset完成的任务见第一篇博客数据预处理部分,这里简单解释一下,就是用VOCBboxDataset作为数据读取库,然后依次从样例数据库中读取图片出来,还调用了Transform(object)函数,完成图像的调整和随机反转工作!

然后是dataloader = data_.DataLoader(dataset,batch_size=1,shuffle=True,num_workers=opt.num_workers) 将数据装载到dataloader中,shuffle=True允许数据打乱排序,num_workers是设置数据分为几批处理,同样的将测试数据集也进行同样的处理,然后装载到test_dataloader中!接下来定义faster_rcnn=FasterRCNNVGG16()定义好模型!FasterRCNNVGG16()的参数模型见系列博客的第三篇模型介绍,之后是设置trainer = FasterRCNNTrainer(faster_rcnn).cuda()将FasterRCNNVGG16作为fasterrcnn的模型送入到FasterRCNNTrainer中并设置好GPU加速,接下来判断opt.load_path是否存在,如果存在,直接从opt.load_path读取预训练模型,然后将训练数据的label进行可视化操作,之后用一个for循环开始训练过程,而训练迭代的次数opt.epoch也在config.py文件中都预先定义好,属于超参数,接下来看for循环体:

1首先在可视化界面重设所有数据

2然后从训练数据中枚举dataloader,设置好缩放范围,将img,bbox,label,scale全部设置为可gpu加速

3调用trainer.py中的函数trainer.train_step(img,bbox,label,scale)进行一次参数迭代优化过程!

4 判断数据读取次数是否能够整除plot_every(是否达到了画图次数),如果达到判断debug_file是否存在,用ipdb工具设置断点,调用trainer中的trainer.vis.plot_many(trainer.get_meter_data())将训练数据读取并上传完成可视化!

5将每次迭代读取的图片用dataset文件里面的inverse_normalize()函数进行预处理,将处理后的图片调用Visdom_bbox(ori_img_,at_tonumpy(_bboxes[0]),at.tonumpy(_labels[0].reshape(-1)),at.tonumpy(_scores[0]))

6调用trainer.vis.img('pred_img',pred_img)将迭代读取原始数据中的原图,bboxes框架,labels标签在可视化工具下显示出来

7调用 _bboxes,_labels,_socres = trainer.faster_rcnn.predict([ori_img_],visualize=True)调用faster_rcnn的predict函数进行预测,预测的结果保留在以_下划线开头的对象里面

8利用同样的方法将原始图片以及边框类别的预测结果同样在可视化工具中显示出来!

9调用train.vis.text(str(trainer.rpn_cm.value().tolist),win='rpn_cm')将rpn_cm也就是RPN网络的混淆矩阵在可视化工具中显示出来

10调用trainer.vis.img('roi_cm', at.totensor(trainer.roi_cm.conf, False).float())将Roi_cm将roi的可视化矩阵以图片的形式显示出来

===============接下来是测试阶段的代码=============================================================

11 调用eval_result = eval(test_dataloader, faster_rcnn, test_num=opt.test_num)将测试数据调用eval()函数进行评价,存储在eval_result中

12 trainer.vis.plot('test_map', eval_result['map']) 将eval_result['map']在可视化工具中进行显示

13 lr_ = trainer.faster_rcnn.optimizer.param_groups[0]['lr'] 设置学习的learning rate

14log_info = 'lr:{}, map:{},loss:{}'.format(str(lr_),str(eval_result['map']),str(trainer.get_meter_data())) + trainer.vis.log(log_info) 将损失学习率以及map等信息及时显示更新

15 用if判断语句永远保存效果最好的map!

16 if判断语句如果学习的epoch达到了9就将学习率*0.1变成原来的十分之一

17 判断epoch==13结束训练验证过程

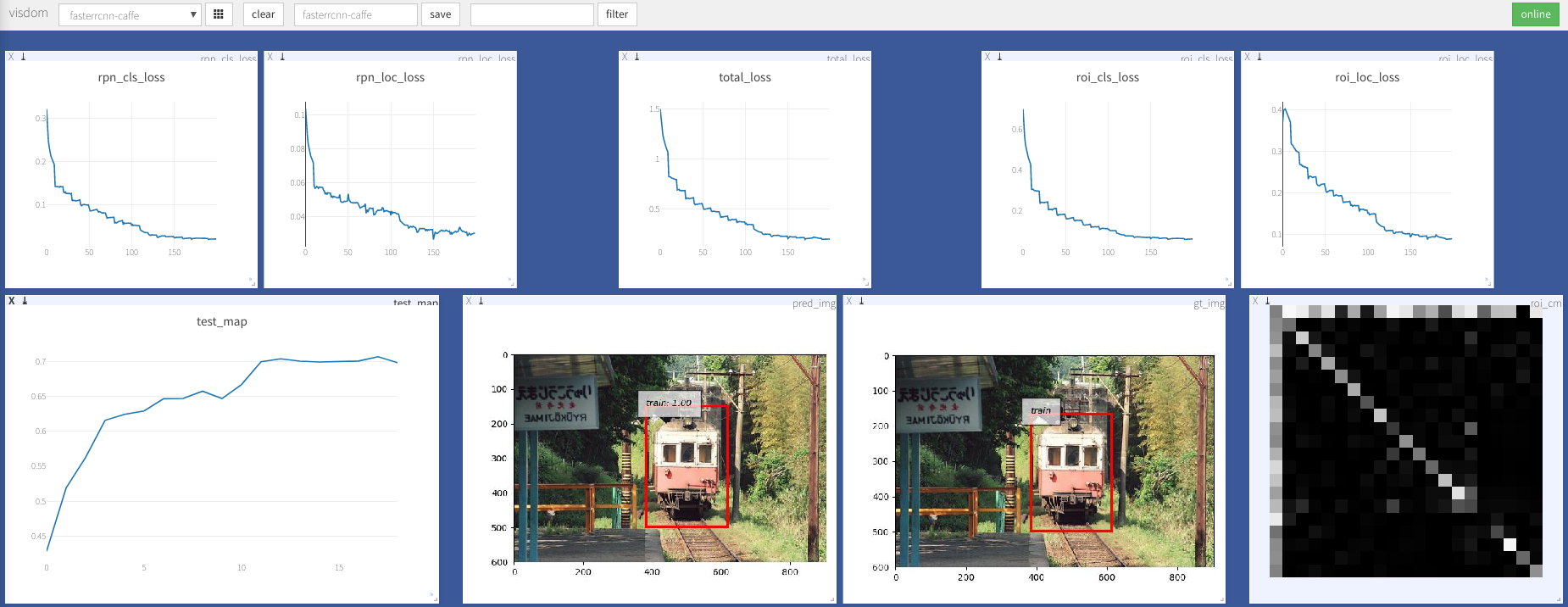

可以看出,其实train.py文件里大多数都是为可视化部分做了详细的设置,代码基本上都是围绕着可视化来进行的,最后,作为本篇博客的结束,贴一个作者运行时可视化的截图吧!

可以更好的方便大家理解为什么要这么设置,代码对应的可视化部分都有哪些:

至此,Faster-RCNN的pytorch简化版本的整个训练过程的代码就解释完了,如果对你还有点启发的话就写个留言鼓励一下吧~如果觉得哪里有问题,欢迎留言指出哦!纯手打,难免有误,多多包含谢谢大家!

目标检测之Faster-RCNN的pytorch代码详解(模型训练篇)的更多相关文章

- 目标检测之Faster-RCNN的pytorch代码详解(模型准备篇)

十月一的假期转眼就结束了,这个假期带女朋友到处玩了玩,虽然经济仿佛要陷入危机,不过没关系,要是吃不上饭就看书,吃精神粮食也不错,哈哈!开个玩笑,是要收收心好好干活了,继续写Faster-RCNN的代码 ...

- 目标检测之Faster-RCNN的pytorch代码详解(数据预处理篇)

首先贴上代码原作者的github:https://github.com/chenyuntc/simple-faster-rcnn-pytorch(非代码作者,博文只解释代码) 今天看完了simple- ...

- 【目标检测】Faster RCNN算法详解

Ren, Shaoqing, et al. “Faster R-CNN: Towards real-time object detection with region proposal network ...

- 目标检测算法Faster R-CNN

一:Faster-R-CNN算法组成: 1.PRN候选框提取模块: 2.Fast R-CNN检测模块. 二:Faster-R-CNN框架介绍 三:RPN介绍 3.1训练步骤:1.将图片输入到VGG或Z ...

- 【目标检测】SSD+Tensorflow 300&512 配置详解

SSD_300_vgg和SSD_512_vgg weights下载链接[需要科学上网~]: Model Training data Testing data mAP FPS SSD-300 VGG-b ...

- (原)faster rcnn的tensorflow代码的理解

转载请注明出处: https://www.cnblogs.com/darkknightzh/p/10043864.html 参考网址: 论文:https://arxiv.org/abs/1506.01 ...

- 目标检测(三) Fast R-CNN

引言 之前学习了 R-CNN 和 SPPNet,这里做一下回顾和补充. 问题 R-CNN 需要对输入进行resize变换,在对大量 ROI 进行特征提取时,需要进行卷积计算,而且由于 ROI 存在重复 ...

- 深度学习与CV教程(12) | 目标检测 (两阶段,R-CNN系列)

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/37 本文地址:http://www.showmeai.tech/article-det ...

- faster RCNN(keras版本)代码讲解(3)-训练流程详情

转载:https://blog.csdn.net/u011311291/article/details/81121519 https://blog.csdn.net/qq_34564612/artic ...

随机推荐

- 一个nginx反向代理, 负载均衡的例子

#/etc/nginx/conf.d/master.conf #区分大小写 #设定负载均衡的服务器列表 upstream master.balancing { #weigth参数表示权值,权值越高被分 ...

- JS高阶函数与函数柯里化

高阶函数 满足下列条件之一的函数: 函数作为参数被传递(如回调函数): 函数可以作为返回值输出: 一些内置高阶函数的例子: Array.prototype.map map()方法通过调用对输入数组中的 ...

- c#项目总结

写了将近10年代码了,最后休息,回想了下,感觉什么都没有. 所以打算写一些总结性的文章,先写几个项目,用于c#各个方向的封装使用 最后汇总成一个完善的解决方案.所有项目都在一个解决方案FastAIFr ...

- js中的throw err的作用

1.阻止程序的运行 2.把错误消息打到控制台

- c c++面试c工程开发之宏定义和条件编译

多数c语言的初学者对c工程开发过程各个阶段的作用理解不到位,而这方面的的知识又是实际开发过程中经常用到的技能点,所以就成为面试考察中一个重要的考察方面.例如:头文件的作用.头文件的内容:链接的作用和意 ...

- 剑指offer—从头到尾打印链表

输入一个链表,按链表值从尾到头的顺序返回一个ArrayList. 递归添加...不为空就加 import java.util.ArrayList; public class Solution { pu ...

- Eclipse中各种文件的注释与取消注释的快捷键

Eclipse中各种文件的注释与取消注释的快捷键 Java文件: 注释和取消注释的快捷键都是:CTRL + / 或 Shift+Ctrl+C JS文件: 注释和取消注释的快捷键都是:CTRL + / ...

- SSM框架理解搭建(虽然是网上拼的,但是实际按照搭建是可以的)——

SpringSpring就像是整个项目中装配bean的大工厂,在配置文件中可以指定使用特定的参数去调用实体类的构造方法来实例化对象.Spring的核心思想是IoC(控制反转),即不再需要程序员去显式地 ...

- maven-认识

1.认识maven maven是强大的项目构建工具,也是依赖管理工具 使用maven前提是安装JDK maven非常重要配置文件:setting.xml 3.maven工程 maven工程的约束: 主 ...

- Java : JPA相关以及常用注解

SpringDataJPA自定义的查询方法 定义规范 And 并且 Or 或 Is,Equals 等于 Between 两者之间 LessThan 小于 LessThanEqual ...