Hadoop(21)-数据清洗(ELT)简单版

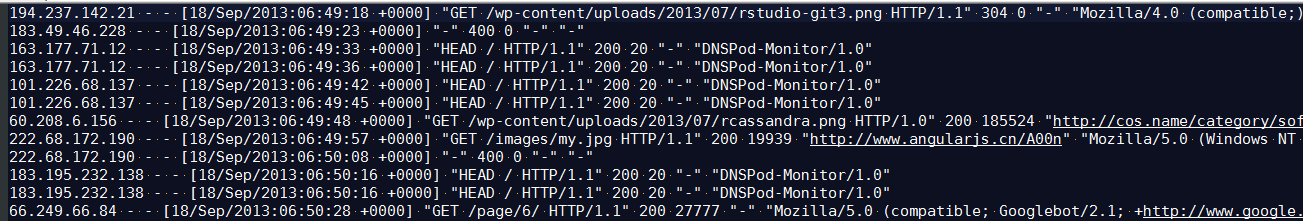

有一个诸如这样的log日志

去除长度不合法,并且状态码不正确的记录

LogBean

- package com.nty.elt;

- /**

- * author nty

- * date time 2018-12-14 15:27

- */

- public class Log {

- private String remote_addr;// 记录客户端的ip地址

- private String remote_user;// 记录客户端用户名称,忽略属性"-"

- private String time_local;// 记录访问时间与时区

- private String request;// 记录请求的url与http协议

- private String status;// 记录请求状态;成功是200

- private String body_bytes_sent;// 记录发送给客户端文件主体内容大小

- private String http_referer;// 用来记录从那个页面链接访问过来的

- private String http_user_agent;// 记录客户浏览器的相关信息

- private boolean valid = true;// 判断数据是否合法

- public String getRemote_addr() {

- return remote_addr;

- }

- public Log setRemote_addr(String remote_addr) {

- this.remote_addr = remote_addr;

- return this;

- }

- public String getRemote_user() {

- return remote_user;

- }

- public Log setRemote_user(String remote_user) {

- this.remote_user = remote_user;

- return this;

- }

- public String getTime_local() {

- return time_local;

- }

- public Log setTime_local(String time_local) {

- this.time_local = time_local;

- return this;

- }

- public String getRequest() {

- return request;

- }

- public Log setRequest(String request) {

- this.request = request;

- return this;

- }

- public String getStatus() {

- return status;

- }

- public Log setStatus(String status) {

- this.status = status;

- return this;

- }

- public String getBody_bytes_sent() {

- return body_bytes_sent;

- }

- public Log setBody_bytes_sent(String body_bytes_sent) {

- this.body_bytes_sent = body_bytes_sent;

- return this;

- }

- public String getHttp_referer() {

- return http_referer;

- }

- public Log setHttp_referer(String http_referer) {

- this.http_referer = http_referer;

- return this;

- }

- public String getHttp_user_agent() {

- return http_user_agent;

- }

- public Log setHttp_user_agent(String http_user_agent) {

- this.http_user_agent = http_user_agent;

- return this;

- }

- public boolean isValid() {

- return valid;

- }

- public Log setValid(boolean valid) {

- this.valid = valid;

- return this;

- }

- @Override

- public String toString() {

- StringBuilder sb = new StringBuilder();

- sb.append(this.valid);

- sb.append("\001").append(this.remote_addr);

- sb.append("\001").append(this.remote_user);

- sb.append("\001").append(this.time_local);

- sb.append("\001").append(this.request);

- sb.append("\001").append(this.status);

- sb.append("\001").append(this.body_bytes_sent);

- sb.append("\001").append(this.http_referer);

- sb.append("\001").append(this.http_user_agent);

- return sb.toString();

- }

- }

Mapper类

- package com.nty.elt;

- import org.apache.hadoop.io.LongWritable;

- import org.apache.hadoop.io.NullWritable;

- import org.apache.hadoop.io.Text;

- import org.apache.hadoop.mapreduce.Mapper;

- import java.io.IOException;

- /**

- * author nty

- * date time 2018-12-14 15:28

- */

- public class LogMapper extends Mapper<LongWritable, Text, Text, NullWritable> {

- private Text logKey = new Text();

- @Override

- protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

- //分割一行数据

- String[] fields = value.toString().split(" ");

- Log result = parseLog(fields);

- if (!result.isValid()) {

- return;

- }

- logKey.set(result.toString());

- // 3 输出

- context.write(logKey, NullWritable.get());

- }

- private Log parseLog(String[] fields) {

- Log log = new Log();

- if (fields.length > 11) {

- log.setRemote_addr(fields[0])

- .setRemote_user(fields[1])

- .setTime_local(fields[3].substring(1))

- .setRequest(fields[6])

- .setStatus(fields[8])

- .setBody_bytes_sent(fields[9])

- .setHttp_referer(fields[10]);

- if (fields.length > 12) {

- log.setHttp_user_agent(fields[11] + " " + fields[12]);

- } else {

- log.setHttp_user_agent(fields[11]);

- }

- // 大于400,HTTP错误

- if (Integer.parseInt(log.getStatus()) >= 400) {

- log.setValid(false);

- }

- } else {

- log.setValid(false);

- }

- return log;

- }

- }

Driver

- package com.nty.elt;

- import org.apache.hadoop.conf.Configuration;

- import org.apache.hadoop.fs.Path;

- import org.apache.hadoop.io.NullWritable;

- import org.apache.hadoop.io.Text;

- import org.apache.hadoop.mapreduce.Job;

- import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

- import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

- /**

- * author nty

- * date time 2018-12-14 15:40

- */

- public class LogDriver {

- public static void main(String[] args) throws Exception {

- // 1 获取job信息

- Configuration conf = new Configuration();

- Job job = Job.getInstance(conf);

- // 2 加载jar包

- job.setJarByClass(LogDriver.class);

- // 3 关联map

- job.setMapperClass(LogMapper.class);

- // 4 设置最终输出类型

- job.setOutputKeyClass(Text.class);

- job.setOutputValueClass(NullWritable.class);

- // 5 设置输入和输出路径

- FileInputFormat.setInputPaths(job, new Path("d:\\Hadoop_test"));

- FileOutputFormat.setOutputPath(job, new Path("d:\\Hadoop_test_out"));

- // 6 提交

- job.waitForCompletion(true);

- }

- }

结果

Hadoop(21)-数据清洗(ELT)简单版的更多相关文章

- 小米抢购(简单版v0.1)-登录并验证抢购权限,以及获取真实抢购地址

小米(简单版)-登录并验证抢购权限,以及获取真实抢购地址! 并不是复制到浏览器就行了的 还得传递所需要的参数 这里只是前部分 后面的自己发挥了 { "stime": 1389 ...

- Hadoop on Mac with IntelliJ IDEA - 10 陆喜恒. Hadoop实战(第2版)6.4.1(Shuffle和排序)Map端 内容整理

下午对着源码看陆喜恒. Hadoop实战(第2版)6.4.1 (Shuffle和排序)Map端,发现与Hadoop 1.2.1的源码有些出入.下面作个简单的记录,方便起见,引用自书本的语句都用斜体表 ...

- Hadoop介绍及最新稳定版Hadoop 2.4.1下载地址及单节点安装

Hadoop介绍 Hadoop是一个能对大量数据进行分布式处理的软件框架.其基本的组成包括hdfs分布式文件系统和可以运行在hdfs文件系统上的MapReduce编程模型,以及基于hdfs和MapR ...

- JavaMail简单版实验测试

前言: 最近由于实现web商城的自动发送邮件功能的需求,故涉猎的邮箱协议的内部原理.现将简单版的Java Mail实例做个代码展示,并附上其中可能出现的bug贴出,方便感兴趣的读者进行测试! 1.载入 ...

- Java实现简单版SVM

Java实现简单版SVM 近期的图像分类工作要用到latent svm,为了更加深入了解svm,自己动手实现一个简单版的. 之所以说是简单版,由于没实用到拉格朗日,对偶,核函数等等.而 ...

- MySQL数据库执行计划(简单版)

+++++++++++++++++++++++++++++++++++++++++++标题:MySQL数据库执行计划简单版时间:2019年2月25日内容:MySQL数据库执行计划简单版重点:MySQL ...

- 红警大战JAVA简单版

代码结构: 相关源码: 武器类: 属性:武器,攻击力,子弹数量. 方法:给属性赋值(set属性()方法) 获取属性值(get属性()方法) package 红警大战简单版; public class ...

- TOJ 3973 Maze Again && TOJ 3128 简单版贪吃蛇

TOJ3973传送门:http://acm.tzc.edu.cn/acmhome/problemdetail.do?&method=showdetail&id=3973 时间限制(普通 ...

- 模板】AC自动机(简单版)

模板]AC自动机(简单版) https://www.luogu.org/problemnew/show/P3808 这是一道简单的AC自动机模板题. 用于检测正确性以及算法常数. 为了防止卡OJ,在保 ...

随机推荐

- java面试题之----spring与struts2的比较

我们从以下几个维度来区分两者的概念: 1. 机制:spring mvc的入口是servlet,而struts2是filter. 补充几点知识: < Filter 实现javax ...

- nginx下的nagios pnp4nagios

#Spawn-FCGI 一个通用的FastCGI管理服务器,它是lighttpd中的一部份,很多人都用Lighttpd的Spawn-FCGI进行FastCGI模式下的管理工作 #fcgiwrap(Si ...

- (原创)攻击方式学习之(3) - 缓冲区溢出(Buffer Overflow)

堆栈溢出 堆栈溢出通常是所有的缓冲区溢出中最容易进行利用的.了解堆栈溢出之前,先了解以下几个概念: 缓冲区 简单说来是一块连续的计算机内存区域,可以保存相同数据类型的多个实例. 堆栈 堆 栈是 ...

- 在centos7中安装redis,并通过node.js操作redis

引言 最近在学习node.js 连接redis的模块,所以尝试了一下在虚拟机中安装cent OS7,并安装redis,并使用node.js 操作redis.所以顺便做个笔记. 如有不对的地方,欢迎大家 ...

- 最简单的docker教程:在docker里运行nginx服务器

命令行docker search nginx搜索名为nginx的docker image,返回结果的第一个,github上有10293个star,这就是我们想要搜索的结果: 使用命令docker pu ...

- http中COOKIE和SESSION有什么区别?(转知乎)

作者:知乎用户链接:https://www.zhihu.com/question/19786827/answer/28752144来源:知乎著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注 ...

- 计算次数,POJ(1207)

题目链接:http://poj.org/problem?id=1207 #include <stdio.h> #include <algorithm> using namesp ...

- [USACO17JAN]Subsequence Reversal

嘟嘟嘟 这题刚开始是什么思路也没有,关键是不知道怎么解决序列反转的问题. 然后我就想到如果暴力反转一个序列的话,实际上就是不断交换数组中的两个数ai和aj,同时要满足交换的数不能交叉. 然后又看了一眼 ...

- Hashtable详细介绍(源码解析)和使用示例

第1部分 Hashtable介绍 Hashtable 简介 和HashMap一样,Hashtable 也是一个散列表,它存储的内容是键值对(key-value)映射. Hashtable 继承于Dic ...

- genil层

genil 层将底层的业务逻辑封装成一个接口(例如 get_dynamic_result这种),供ui层调用(ui点击 search dynamic result按钮,会调用 get_dynamic_ ...