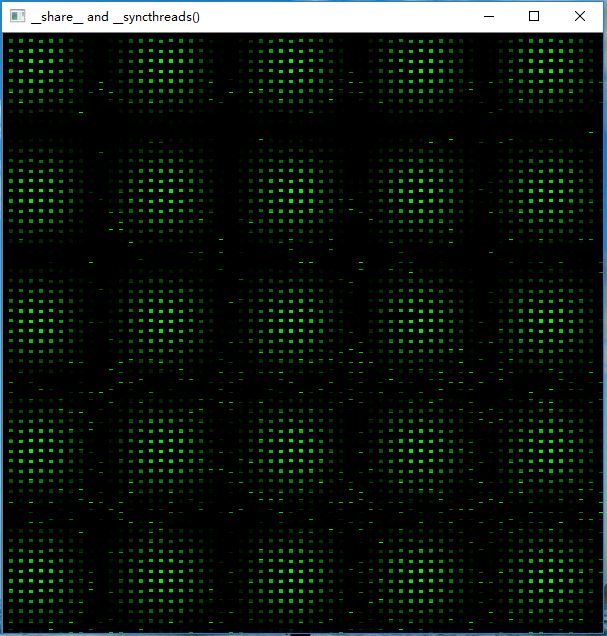

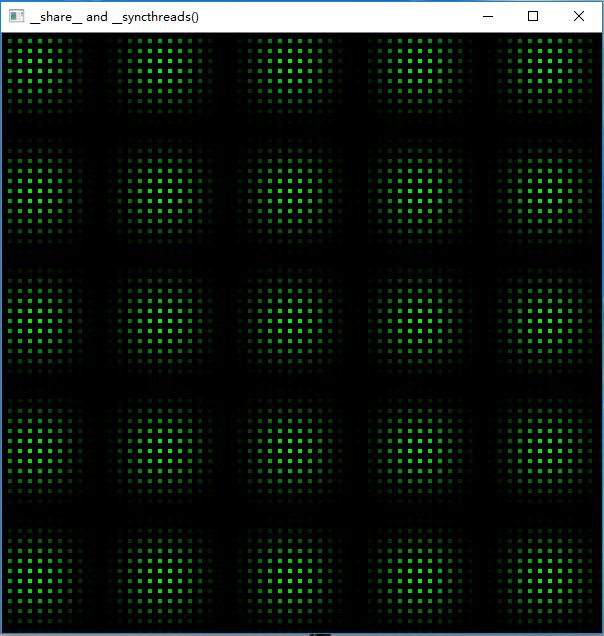

CUDA线程协作之共享存储器“__shared__”&&“__syncthreads()”

共享内存“__share__”

- 位于线程块的共享存储器空间中

- 与线程块具有相同的生命周期

- 仅可通过块内的所有线程访问

线程同步机制“__syncthreads()”

#include "cuda_runtime.h"

#include <highgui.hpp>

using namespace cv;

#define DIM 600 //图像长宽

#define PI 3.1415926535897932f

__global__ void kernel(unsigned char *ptr)

{

// map from blockIdx to pixel position

int x = threadIdx.x + blockIdx.x * blockDim.x;

int y = threadIdx.y + blockIdx.y * blockDim.y;

int offset = x + y * blockDim.x * gridDim.x;

__shared__ float sharedMem[16][16];

const float period = 128.0f;

sharedMem[threadIdx.x][threadIdx.y] =

255 * (sinf(x*2.0f*PI / period) + 1.0f) *

(sinf(y*2.0f*PI / period) + 1.0f) / 4.0f;

__syncthreads();

ptr[offset * 3 + 0] = 0;

ptr[offset * 3 + 1] = sharedMem[15 - threadIdx.x][15 - threadIdx.y];

ptr[offset * 3 + 2] = 0;

}

// globals needed by the update routine

struct DataBlock

{

unsigned char *dev_bitmap;

};

int main(void)

{

DataBlock data;

cudaError_t error;

Mat image = Mat(DIM, DIM, CV_8UC3, Scalar::all(0));

data.dev_bitmap = image.data;

unsigned char *dev_bitmap;

error = cudaMalloc((void**)&dev_bitmap, 3 * image.cols*image.rows);

data.dev_bitmap = dev_bitmap;

dim3 grid(DIM / 10, DIM / 10);

dim3 block(10, 10);

//DIM*DIM个线程块

kernel << <grid, block >> > (dev_bitmap);

error = cudaMemcpy(image.data, dev_bitmap,

3 * image.cols*image.rows,

cudaMemcpyDeviceToHost);

error = cudaFree(dev_bitmap);

imshow("__share__ and __syncthreads()", image);

waitKey();

}

CUDA线程协作之共享存储器“__shared__”&&“__syncthreads()”的更多相关文章

- GPU编程自学5 —— 线程协作

深度学习的兴起,使得多线程以及GPU编程逐渐成为算法工程师无法规避的问题.这里主要记录自己的GPU自学历程. 目录 <GPU编程自学1 -- 引言> <GPU编程自学2 -- CUD ...

- 基于 Java 2 运行时安全模型的线程协作--转

在 Java 2 之前的版本,运行时的安全模型使用非常严格受限的沙箱模型(Sandbox).读者应该熟悉,Java 不受信的 Applet 代码就是基于这个严格受限的沙箱模型来提供运行时的安全检查.沙 ...

- java线程系列之三(线程协作)

本文来自:高爽|Coder,原文地址:http://blog.csdn.net/ghsau/article/details/7433673,转载请注明. 上一篇讲述了线程的互斥(同步),但是在很多情况 ...

- JAVA并发-线程协作

这段时间有点忙,技术博客更新的比较少,今天更新一下相关并发的常用线程协作的类吧. ExecutorService 线程池,用于创造和复用线程,他有几种模式. 我举一个自定义线程池数量的例子如下 Exe ...

- Java多线程之线程协作

Java多线程之线程协作 一.前言 上一节提到,如果有一个线程正在运行synchronized 方法,那么其他线程就无法再运行这个方法了.这就是简单的互斥处理. 假如我们现在想执行更加精确的控制,而不 ...

- 第41天学习打卡(死锁 Lock synchronized与Lock的对比 线程协作 使用线程池)

死锁 多个线程各自占有一些共享资源,并且互相等待其他线程占有的资源才能运行,而导致两个或者多个线程都在等待对方释放资源,都停止执行的情形.某一个同步块同时拥有"两个以上对象的锁"时 ...

- GPU(CUDA)学习日记(十一)------ 深入理解CUDA线程层次以及关于设置线程数的思考

GPU线程以网格(grid)的方式组织,而每个网格中又包含若干个线程块,在G80/GT200系列中,每一个线程块最多可包含512个线程,Fermi架构中每个线程块支持高达1536个线程.同一线程块中的 ...

- CUDA线程

建议先看看前言中关于存储器的介绍:点击打开链接 线程 首先介绍进程,进程是程序的一次执行,线程是进程内的一个相对独立的可执行的单元.若把进程称为任务的话,那么线程则是应用中的一个子任务的执行.举个简单 ...

- 【并行计算-CUDA开发】CUDA线程、线程块、线程束、流多处理器、流处理器、网格概念的深入理解

GPU的硬件结构,也不是具体的硬件结构,就是与CUDA相关的几个概念:thread,block,grid,warp,sp,sm. sp: 最基本的处理单元,streaming processor 最 ...

随机推荐

- 8.3 Android灯光系统_编写HAL_lights.c

注意在led-classes.c中定义的led_class_attrs[]所建立的文件的属性应该改为0666,否则应用程序无权操作它 同时ledtrig-time.c里面对应新建的那几个delay_o ...

- 【习题 5-8 UVA - 230】Borrowers

[链接] 我是链接,点我呀:) [题意] 在这里输入题意 [题解] 用map+set写个模拟就好. 3个区域 书架.桌子.别人的手上. 其中前两个区域的书都能借出去. [代码] #include &l ...

- 【Codeforces Round #435 (Div. 2) C】Mahmoud and Ehab and the xor

[链接]h在这里写链接 [题意] 让你组成一个n个数的集合,使得这n个数的异或和为x; x<=1e5 每个数最大1e6; [题解] 1e5<=2^17<=2^18<=1e6的 ...

- 【BZOJ 4199】 [Noi2015]品酒大会

[链接]h在这里写链接 [题意] 给你一个长度为n的字符串s; 标志了每一杯酒; 以及n个数字,表示每一杯酒的美味度ai. 两杯酒(i,j)称为r相似 当且仅当 ...

- UVA Bandwidth

题目例如以下: Bandwidth Given a graph (V,E) where V is a set of nodes and E is a set of arcsin VxV, and a ...

- 6 、字符编码笔记:ASCII,Unicode和UTF-8

1. ASCII码 我们知道,在计算机内部,所有的信息最终都表示为一个二进制的字符串.每一个二进制位(bit)有0和1两种状态,因此八个二进制位就可以组合出 256种状态,这被称为一个字节(byte) ...

- 魔兽争霸war3心得体会(一):UD的冰甲蜘蛛流

玩war3好几年了,之前都是打打电脑,随便玩玩的.刚刚在浩方等平台上和人玩的时候,各种被虐,很难赢一局.从去年开始,才认真玩.思考下各种战术. 最初,使用的是兽族orc,后来觉得兽族不够厉害,玩到对战 ...

- 得到INI文件所有Section(所有节点名称)

char SectionNames[MAX_PATH],*pSectionName; ZeroMemory(SectionNames,MAX_PATH); GetPrivateProfileSecti ...

- js进阶 12-4 jquery键盘事件如何使用

js进阶 12-4 jquery键盘事件如何使用 一.总结 一句话总结:键盘和鼠标都是外设输入设备,所以函数很像,所以使用就像鼠标事件click一样 1.jquery键盘事件有哪三个? 1(up和do ...

- matplotlib学习之函数积分图

# coding:utf-8 import numpy as np from matplotlib import pyplot as plt from matplotlib.patches impor ...