生产调优1 HDFS-核心参数

1 HFDS核心参数

搭建HFDS集群时必须要参考的参数

1.1 NameNode 内存生产配置

问题描述

1) NameNode 内存计算

每个文件块大概占用 150byte,一台服务器 128G 内存为例,能存储多少文件块呢?

128 * 1024 * 1024 * 1024 / 150Byte ≈ 9.1 亿

2) Hadoop3.x 系列,配置 NameNode 内存

/opt/module/hadoop-3.1.3/etc/hadoop路径下的hadoop-env.sh 中描述 Hadoop 的内存是动态分配的

# The maximum amount of heap to use (Java -Xmx). If no unit

# is provided, it will be converted to MB. Daemons will

# prefer any Xmx setting in their respective _OPT variable.

# There is no default; the JVM will autoscale based upon machine //如果没有设置该参数,会按照服务器内存赋值

# memory size.

# export HADOOP_HEAPSIZE_MAX=

# The minimum amount of heap to use (Java -Xms). If no unit

# is provided, it will be converted to MB. Daemons will

# prefer any Xms setting in their respective _OPT variable.

# There is no default; the JVM will autoscale based upon machine

# memory size.

# export HADOOP_HEAPSIZE_MIN=

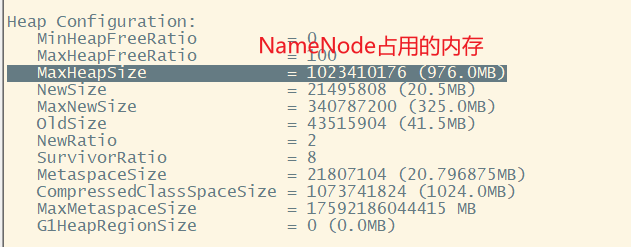

查看 NameNode 占用内存

[ranan@hadoop102 hadoop]$ jpsall

=============== hadoop102 ===============

15473 JobHistoryServer

15268 NodeManager

14933 DataNode

15560 Jps

14749 NameNode

=============== hadoop103 ===============

13969 Jps

13218 DataNode

13717 NodeManager

13479 ResourceManager

=============== hadoop104 ===============

13012 Jps

12869 NodeManager

12572 DataNode

12750 SecondaryNameNode

[ranan@hadoop102 hadoop]$ jmap -heap 14749

Heap Configuration:

MaxHeapSize = 1023410176 (976.0MB)

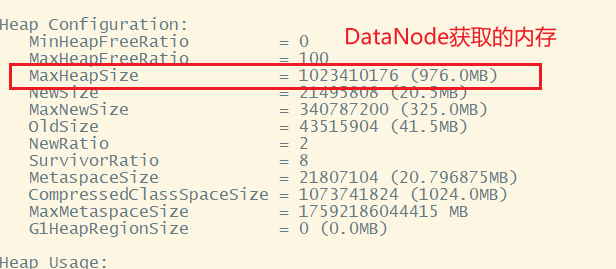

查看 DataNode 占用内存

[ranan@hadoop102 hadoop]$ jmap -heap 14749

MaxHeapSize = 1023410176 (976.0MB)

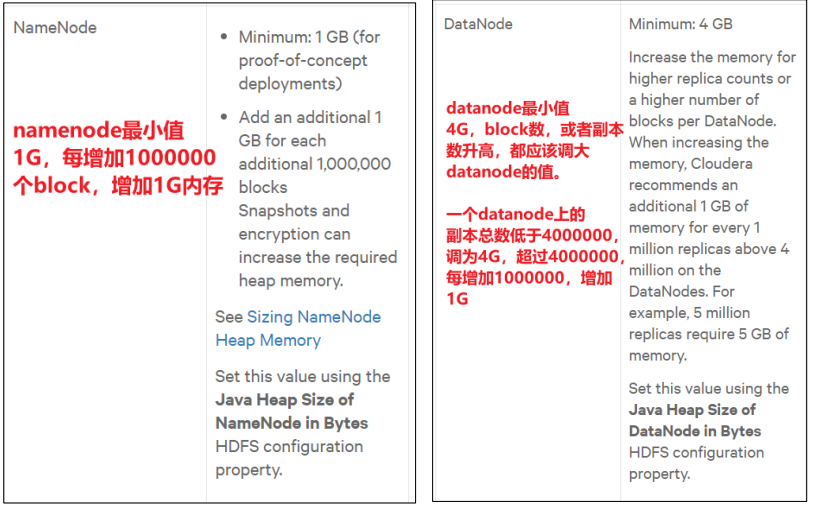

查看发现 hadoop102 上的 NameNode 和 DataNode 占用内存都是自动分配的,且相等。如果两者同时达到上限(系统也就是976M),明明内存不足了还显示有,就会抢占linux系统内存,不合理。所以需要手动配置。

hadoop-env.sh中配置

经验:

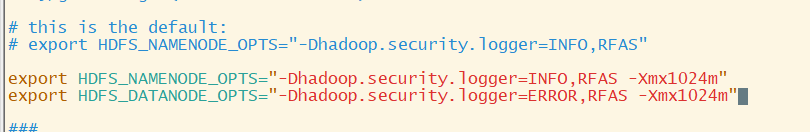

具体修改: hadoop-env.sh

[ranan@hadoop102 hadoop]$ vim hadoop-env.sh

[ranan@hadoop102 hadoop]$ vim hadoop-env.sh

//不修改默认配置信息,选择拼接。 - Xmx1024m进行拼接

export HDFS_NAMENODE_OPTS="-Dhadoop.security.logger=INFO,RFAS -Xmx1024m"

export HDFS_DATANODE_OPTS="-Dhadoop.security.logger=ERROR,RFAS -Xmx1024m"

[ranan@hadoop102 hadoop]$ xsync hadoop-env.sh

重启集群

[ranan@hadoop102 hadoop]$ myhadoop.sh stop

[ranan@hadoop102 hadoop]$ myhadoop.sh start

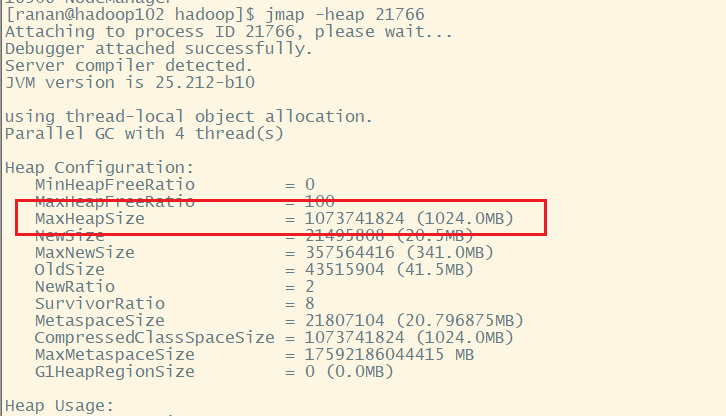

查看NameNode内存

[ranan@hadoop103 hadoop]$ jpsall

=============== hadoop102 ===============

22292 NodeManager

22500 JobHistoryServer

21957 DataNode

21766 NameNode

22598 Jps

=============== hadoop103 ===============

19041 Jps

18531 ResourceManager

18824 NodeManager

18314 DataNode

=============== hadoop104 ===============

16787 SecondaryNameNode

16602 DataNode

16906 NodeManager

17069 Jps

[ranan@hadoop102 hadoop]$ jmap -heap 21766

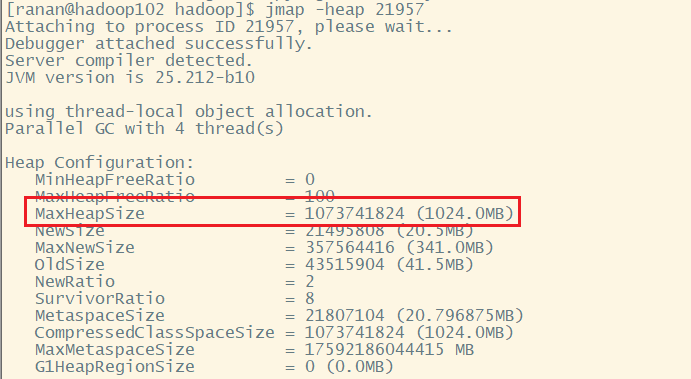

查看DataNode内存

[ranan@hadoop102 hadoop]$ jmap -heap 21957

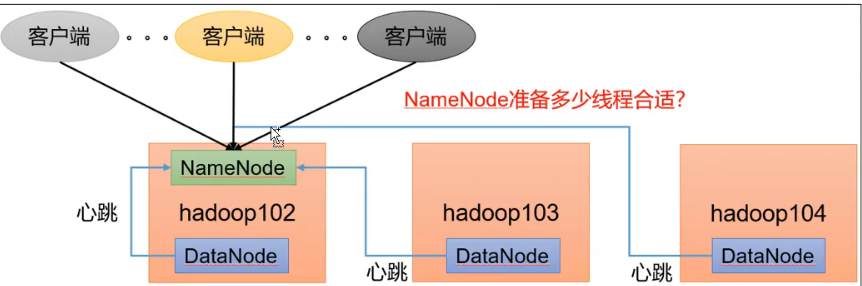

1.2 NameNode 心跳并发配置

DataNode启动后告诉NameNode本机的块信息(块是否完好),并周期性(默认6个小时)上报所有块消息(块是否完好)。

如果DataNode数量很多,NameNode会准备线程来处理汇报,同时客户端也有可能向NameNode请求。

问题:NameNode准备多少线程合适?

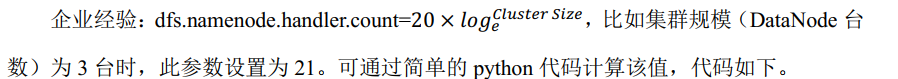

修改hdfs-site.xml配置

NameNode有一个工作线程池,用来处理不同DataNode的并发心跳以及客户端并发的元数据操作。

参数dfs.namenode.hakdler.count,默认时10

[ranan@hadoop102 ~]$ sudo yum install -y python

[ranan@hadoop102 ~]$ python

Python 2.7.5 (default, Apr 11 2018, 07:36:10)

[GCC 4.8.5 20150623 (Red Hat 4.8.5-28)] on linux2

Type "help", "copyright", "credits" or "license" for more

information.

>>> import math

>>> print int(20*math.log(3))

21

>>> quit()

hdfs-site.xml新增

[ranan@hadoop102 hadoop]$ vim hdfs-site.xml

<!-- 新增 -->

<property>

<name>dfs.namenode.handler.count</name>

<value>21</value>

</property>

1.3 开启回收站配置

开启回收站功能,可以将删除的文件在不超时的情况下,回复原数据,起到防止误删除、备份的等作用。默认是禁用的。

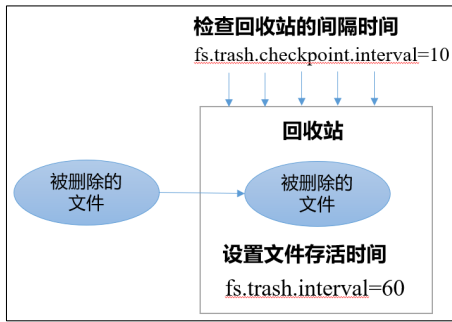

回收站机制

假设文件存活时间设置为fs.trash,interval = 6060min,每过10min检查回收站里的文件存活时间fs.trash,checkpoint.interval=10,如果不设置则和文件存活时间间隔一致,每60min检查一次

开启回收站功能参数说明

(1)默认值 fs.trash.interval = 0, 0 表示禁用回收站; 其他值表示设置文件的存活时间。

(2) 默认值 fs.trash.checkpoint.interval = 0,检查回收站的间隔时间。如果该值为 0,则该值设置和 fs.trash.interval 的参数值相等。

(3) 要求 fs.trash.checkpoint.interval <= fs.trash.interval。

启动回收站-修改core-site.xml

修改 core-site.xml, 配置垃圾回收时间为 1 分钟。

<!--新增-->

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

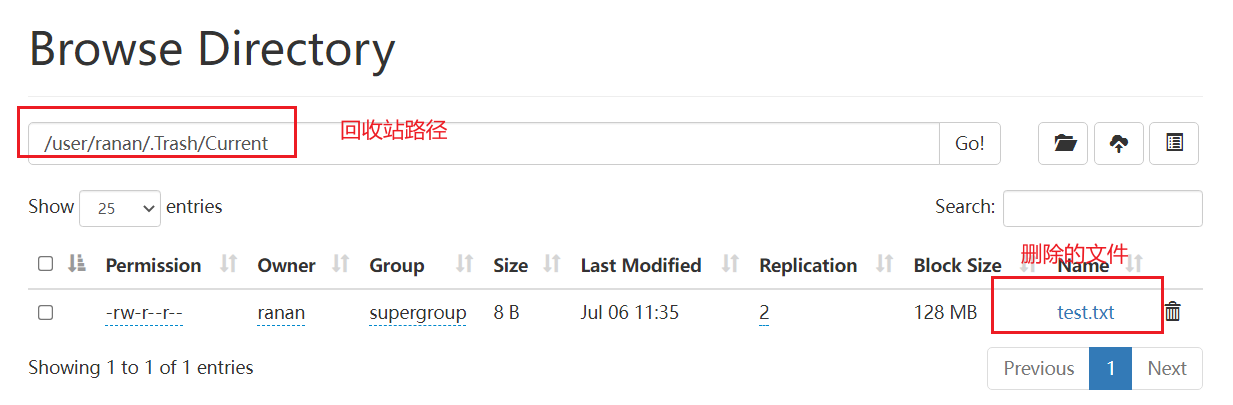

查看回收站

回收站目录在HDFS集群中的路径:/user/ranan/.Trash/...

注意:通过网页上直接删除是不走回收站的

通过程序删除的文件不会经过回收站,需要调用 moveToTrash()才进入回收站

Trash trash = New Trash(conf);

trash.moveToTrash(path); //删除之后添加到回收站

只有在命令行利用 hadoop fs -rm 命令删除的文件才会走回收站。

[ranan@hadoop102 hadoop]$ hadoop fs -rm /test.txt

2021-11-04 16:25:53,705 INFO fs.TrashPolicyDefault: Moved: 'hdfs://hadoop102:8020/test.txt' to trash at: hdfs://hadoop102:8020/user/ranan/.Trash/Current/test.txt

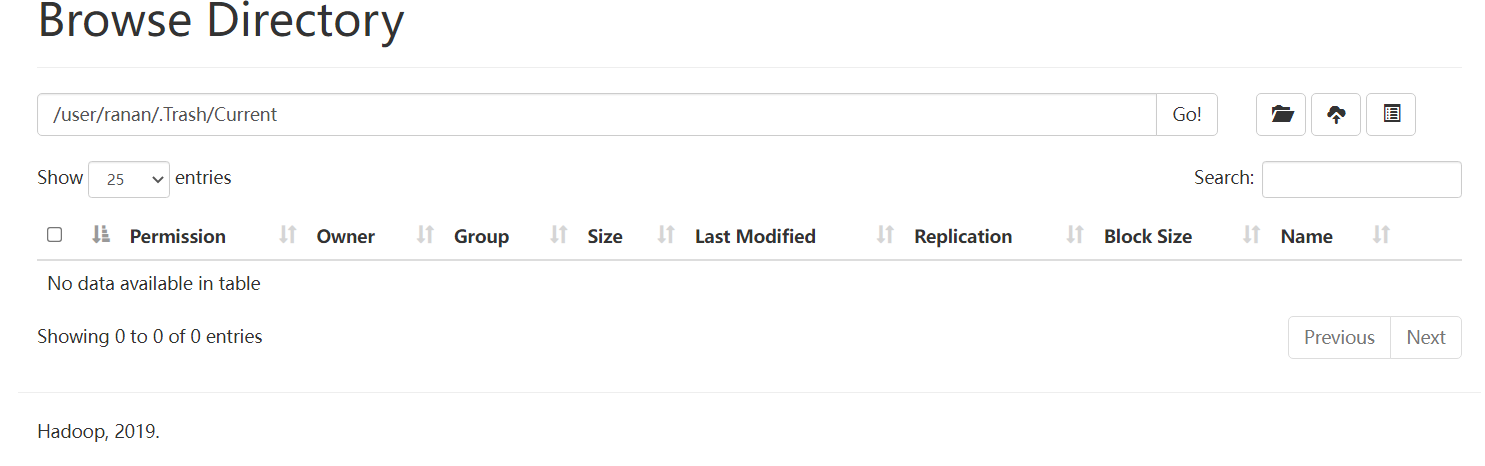

恢复回收站数据

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -mv /user/ranan/.Trash/Current/test.txt /

生产调优1 HDFS-核心参数的更多相关文章

- hive 调优(二)参数调优汇总

在hive调优(一) 中说了一些常见的调优,但是觉得参数涉及不多,补充如下 1.设置合理solt数 mapred.tasktracker.map.tasks.maximum 每个tasktracker ...

- (转)/etc/sysctl.conf 调优 & 优化Linux内核参数

/etc/sysctl.conf 调优 & 优化Linux内核参数 from: http://apps.hi.baidu.com/share/detail/15652067 http://ke ...

- 【深度学习篇】--神经网络中的调优一,超参数调优和Early_Stopping

一.前述 调优对于模型训练速度,准确率方面至关重要,所以本文对神经网络中的调优做一个总结. 二.神经网络超参数调优 1.适当调整隐藏层数对于许多问题,你可以开始只用一个隐藏层,就可以获得不错的结果,比 ...

- JVM调优之Tomcat启动参数配置及详解

开发项目中会遇到Tomcat内存溢出(java.lang.OutOfMemoryError: PermGen space)的问题,通过查找资料找到是通过设置Tomcat 启动堆空间大小.年轻代大小.每 ...

- JVM调优(一)——参数查询和问题排查

JVM的参数类型 标准参数 -help -server -client -version -showversion -cp -classpath X参数 -Xint: 解释执行 -Xcomp:第一次使 ...

- 生产调优4 HDFS-集群扩容及缩容(含服务器间数据均衡)

目录 HDFS-集群扩容及缩容 添加白名单 配置白名单的步骤 二次配置白名单 增加新服务器 需求 环境准备 服役新节点具体步骤 问题1 服务器间数据均衡 问题2 105是怎么关联到集群的 服务器间数据 ...

- 生产调优3 HDFS-多目录配置

目录 HDFS-多目录配置 NameNode多目录配置 1.修改hdfs-site.xml 2.格式化NameNode DataNode多目录配置(重要) 1.修改hdfs-site.xml 2.测试 ...

- /etc/sysctl.conf 调优 & 优化Linux内核参数

from: http://apps.hi.baidu.com/share/detail/15652067 http://keyknight.blog.163.com/blog/static/36637 ...

- 生产调优2 HDFS-集群压测

目录 2 HDFS-集群压测 2.1 测试HDFS写性能 测试1 限制网络 1 向HDFS集群写10个128M的文件 测试结果分析 测试2 不限制网络 1 向HDFS集群写10个128M的文件 2 测 ...

随机推荐

- 精准测试系列分享之一:JaCoCo 企业级应用的优缺点分析

一.JaCoCo简介 JaCoCo是Eclipse平台下的开源产品,以小型,轻量化著称,常见集成在Eclipse Workbench中,除此之外的启动方式包括对接Ant和Maven,或是命令行的方式进 ...

- Forest v1.5.12 发布,声明式 HTTP 框架,已超过 1.6k star

Forest介绍 Forest 是一个开源的 Java HTTP 客户端框架,它能够将 HTTP 的所有请求信息(包括 URL.Header 以及 Body 等信息)绑定到您自定义的 Interfac ...

- spring-cloud-square源码速读(retrofit + okhttp篇)

欢迎访问我的GitHub 这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos spring-cloud-square系列文章 五分钟 ...

- GoLang设计模式14 - 状态模式

状态模式,顾名思义,是一种基于有限状态机制的设计模式.在这种设计模式中,行为是由相应的状态来决定的.接下来我们会用一个售卖机的例子来说明下状态模式.为了便于说明,我们把场景简化一下,假设有一台售卖机只 ...

- 大白话讲解Mybatis的plugin(Interceptor)的使用

mybatis提供了一个入口,可以让你在语句执行过程中的某一点进行拦截调用.官方称之为插件plugin,但是在使用的时候需要实现Interceptor接口,默认情况下,MyBatis 允许使用插件来拦 ...

- pytest-allure测试报告

该类型的警告大多属于版本更新时,所使用的方法过时的原因,可以在该方法的说明出查找替换的方法 1.安装allure a)下载allure.zip https://github.com/allure-fr ...

- web页面自动化总结。selenium

web自动化测试终篇:总结我理解的ui自动化,整理归纳: https://blog.csdn.net/CCGGAAG/article/details/89669592 web页面自动化知识点 1.we ...

- Highcharts › 自由绘图

... <!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title ...

- tomcat隐藏版本号

默认报错页面信息会暴露出版本号 进入tomcat的lib目录找到catalina.jar文件 unzip catalina.jar之后会多出两个文件夹 进入org/apache/catalina/ut ...

- 13-Semi-supervised Learning

半监督学习(semi-supervised learning) 1.introduction 2.Semi-supervised Learning for Generative Model 3.Low ...