[特征工程] encoding

参考:An Overview of Encoding Techniques | Kaggle

Method 1: Label encoding

给每个类别以一个数字label,作为分类。将类别映射到自然数数值空间上

from sklearn.preprocessing import LabelEncoder

train=pd.DataFrame()

label=LabelEncoder()

for c in X.columns:

if(X[c].dtype=='object'):

train[c]=label.fit_transform(X[c])

else:

train[c]=X[c]

Method 2 : One hot encoding

即独热码,每一个category对应特征向量中的一位,对应位置是否为1判定是否为该类。

可以使用pd.get_dummies()或sklearn.preprocessing中OneHotEncoder

from sklearn.preprocessing import OneHotEncoder

one=OneHotEncoder(

one.fit(X)

train=one.transform(X)

Method 3 : Feature Hashing/Hashing Trick

一个“one hot encoding style” 的编码方式,将数据编入特定维数的散度矩阵中,降维中使用了hash方法。

from sklearn.feature_extraction import FeatureHasher

X_train_hash=X.copy()

for c in X.columns:

X_train_hash[c]=X[c].astype('str')

hashing=FeatureHasher(input_type='string')

train=hashing.transform(X_train_hash.values)

Method 4 :Encoding categories with dataset statistics

尝试为模型提供较低维的每个类别的表示,且其中类似的类别的表示相近。 最简单的方法是将每个类别替换为我们在数据集中看到它的次数,即用出现频率作为他们的embedding。

X_train_stat=X.copy()

for c in X_train_stat.columns:

if(X_train_stat[c].dtype=='object'):

X_train_stat[c]=X_train_stat[c].astype('category')

counts=X_train_stat[c].value_counts()

counts=counts.sort_index()

counts=counts.fillna(0)

counts += np.random.rand(len(counts))/1000

X_train_stat[c].cat.categories=counts

对于循环出现的特征,例如日期,星期等,常用sin\cos将其转为二维空间中的数据。这是基于“循环”的性质,类似于对圆进行分割。

X_train_cyclic=X.copy()

columns=['day','month']

for col in columns:

X_train_cyclic[col+'_sin']=np.sin((2*np.pi*X_train_cyclic[col])/max(X_train_cyclic[col]))

X_train_cyclic[col+'_cos']=np.cos((2*np.pi*X_train_cyclic[col])/max(X_train_cyclic[col]))

X_train_cyclic=X_train_cyclic.drop(columns,axis=1)

one=OneHotEncoder()

one.fit(X_train_cyclic)

train=one.transform(X_train_cyclic)

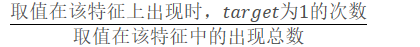

Method 5 : Target encoding

Target encoding 通过目标数据对类别变量进行编码,使用目标对应概率或平均概率替换该类别,即出现频次相近的被视为同一类(大城市,热门项等)。这个方法比较依赖训练集与测试集合的分布,要求他们数据分布一致。另外,这种方法可能会导致过拟合。

X_target=df_train.copy()

X_target['day']=X_target['day'].astype('object')

X_target['month']=X_target['month'].astype('object')

for col in X_target.columns:

if (X_target[col].dtype=='object'):

target= dict ( X_target.groupby(col)['target'].agg('sum')/X_target.groupby(col)['target'].agg('count'))

X_target[col]=X_target[col].replace(target).values

为了减轻过拟合可能带来的影响,可以使用K-Fold Validation ,每次对一份样本进行目标编码时,使用的都是其他K-1份数据之中的数据。

X['target']=y

cols=X.drop(['target','id'],axis=1).columns

%%time

X_fold=X.copy()

X_fold[['ord_0','day','month']]=X_fold[['ord_0','day','month']].astype('object')

X_fold[['bin_3','bin_4']]=X_fold[['bin_3','bin_4']].replace({'Y':1,'N':0,'T':1,"F":0})

kf = KFold(n_splits = 5, shuffle = False, random_state=2019)

for train_ind,val_ind in kf.split(X):

for col in cols:

if(X_fold[col].dtype=='object'):

replaced=dict(X.iloc[train_ind][[col,'target']].groupby(col)['target'].mean())

X_fold.loc[val_ind,col]=X_fold.iloc[val_ind][col].replace(replaced).values

此外,在对特征进行编码前也需要进行特征种类的区分。常分为:

- 0-1数值:只有两种取值,可映射到0,1

- 类别数值:多个类别,这也是最常见的数据。

- 时序数据:时间戳等,隐含了顺序信息,可以反应趋势。

[特征工程] encoding的更多相关文章

- 机器学习-特征工程-Missing value和Category encoding

好了,大家现在进入到机器学习中的一块核心部分了,那就是特征工程,洋文叫做Feature Engineering.实际在机器学习的应用中,真正用于算法的结构分析和部署的工作只占很少的一部分,相反,用于特 ...

- 特征工程(Feature Engineering)

一.什么是特征工程? "Feature engineering is the process of transforming raw data into features that bett ...

- 机器学习-特征工程-Feature generation 和 Feature selection

概述:上节咱们说了特征工程是机器学习的一个核心内容.然后咱们已经学习了特征工程中的基础内容,分别是missing value handling和categorical data encoding的一些 ...

- 【Python数据挖掘】第六篇--特征工程

一.Standardization 方法一:StandardScaler from sklearn.preprocessing import StandardScaler sds = Standard ...

- AI学习笔记:特征工程

一.概述 Andrew Ng:Coming up with features is difficult, time-consuming, requires expert knowledge. &quo ...

- Alink漫谈(十) :特征工程 之 特征哈希/标准化缩放

Alink漫谈(十) :特征工程之特征哈希/标准化缩放 目录 Alink漫谈(十) :特征工程之特征哈希/标准化缩放 0x00 摘要 0x01 相关概念 1.1 特征工程 1.2 特征缩放(Scali ...

- 使用sklearn做单机特征工程

目录 1 特征工程是什么?2 数据预处理 2.1 无量纲化 2.1.1 标准化 2.1.2 区间缩放法 2.1.3 标准化与归一化的区别 2.2 对定量特征二值化 2.3 对定性特征哑编码 2.4 缺 ...

- 特征工程(Feature Enginnering)学习记要

最近学习特征工程(Feature Enginnering)的相关技术,主要包含两块:特征选取(Feature Selection)和特征抓取(Feature Extraction).这里记录一些要点 ...

- 【转】使用sklearn做单机特征工程

这里是原文 说明:这是我用Markdown编辑的第一篇随笔 目录 1 特征工程是什么? 2 数据预处理 2.1 无量纲化 2.1.1 标准化 2.1.2 区间缩放法 2.1.3 无量纲化与正则化的区别 ...

随机推荐

- Effective C++ 总结笔记(一)

一.让自己习惯C++ 01.视C++为一个语言联邦 c++是多重范型编程 语言,视c++包括4种次语言: 1:C 2:Object-Oreinted C++: 3:Template C++: 4:ST ...

- 100_第一个vue-cli项目

目录 什么是vue-cli 主要的功能 需要的环境 Node.js : http://nodejs.cn/download/ Git : https://git-scm.com/downloads 安 ...

- WPF仿Tabcontrol加载切换多个不同View

在同一块区域显示不同的视图内容,直接使用Tabcontrol,可能要重写TabItem的控件模板,最直接的方法通过按钮的切换,控制一个ContentControl的Content值,实现切换不同的视图 ...

- [luogu5654]基础函数练习题

答案即区间$[l,r]$的笛卡尔树上,左右子树有一个为空的点到根路径和(定义此为的该点答案)的max, 对求区间笛卡尔树复杂度为$o(n)$,无法通过,因此在全局笛卡尔树中考虑此问题 设$k$为$l$ ...

- Qt5 connect 重载信号和槽

转载文章超哥的经验之谈---Qt5 connect使用之"重载信号和槽" 在Qt4中,关联信号与槽是要使用到SIGNAL()和SLOT()这两个宏. QLabel *label = ...

- 模版 动态 dp

模版 动态 dp 终于来写这个东西了.. LG 模版:给定 n 个点的数,点有点权, $ m $ 次修改点权,求修改完后这个树的最大独立集大小. 我们先来考虑朴素的最大独立集的 dp \[dp[u][ ...

- Codeforces Gym 101175F - Machine Works(CDQ 分治维护斜率优化)

题面传送门 首先很明显我们会按照 \(d_i\) 的顺序从小到大买这些机器,故不管三七二十一先将所有机器按 \(d_i\) 从小到大排序. 考虑 \(dp\),\(dp_i\) 表示在时刻 \(d_i ...

- Bedtools genomecov 计算覆盖度

简单说明: 从2.28.0版开始,bedtools使用htslib库支持CRAM格式 除了BAM文件,bedtools默认所有的输入文件都以TAB键分割 除非使用-sorted选项,bedtools默 ...

- 毕业设计之zabbix=[web检测

网站对一个公司来说非常重要,里边包含了公司的业务,介绍和订单等相关信息,网站的宕掉了对公司的影响非常重大,所以要很好的对网站的页面进行监控 创建web场景 各部分介绍: Name:唯一的scenari ...

- nginx_日志

192.168.31.250 - - [13/Nov/2019:08:38:07 +0800] "GET /aa HTTP/1.1" 404 571 "-" & ...