Pytorch系列:(七)模型初始化

为什么要进行初始化

首先假设有一个两层全连接网络,第一层的第一个节点值为 \(H_{11}= \sum_{i=0}^n X_i*W_{1i}\),

这个时候,方差为 \(D(H_{11}) = \sum_{i=0}^n D(X_i) * D(W_{1i})\), 这个时候,输入\(X_i\)一般会做归一化,那么其方差为1,而权重W如果不进行归一化的话,H的方差就会变得很大,然后多层累计,下一次的输入会越来越大,使得网络不好收敛,如果权重W进行了初始化,使得其方差保持在1/n附近,那么方差H则会收敛在1附近,从而使得网络变得更好优化。 很多初始化都是使用的这个原理,控制每一层的输出,使其保持在一定的范围内。

一些常见初始化方法

Xavier

Xavier初始化也是类似的原理, 假设输入X 以及做了归一化,其方差为1 ,那么Xavier所希望的就是上述公式D(H) 保持在1左右,那么就可以得到公式

\]

其中n1 和 n2 为网络层的输入输出节点数量,一般情况下,输入输出是不一样的,为了均衡考虑,可以做一个平均操作,于是变得到 \(D(W) = \frac{2}{n_1+n_2}\)

这个时候,我们假设 W服从均匀分布 \(U[-a, a]\), 那么在这个条件下,

\]

推出\(a = \frac{\sqrt{6}}{\sqrt{n_1+n_2+1}}\),从而得到:

\]

这样就可以得到Xavier初始化,在pytorch中使用Xavier初始化方式如下,值得注意的是,Xavier对于sigmoid和tanh比较好,对于其他的可能效果就不是那么好了

nn.init.xavier_uniform_(m.weight.data)

Kaiming

Kaiming 初始化比较适合ReLU激活函数,其原理也跟上述差不多,也是希望将权重的方差保持在一定的范围内,使得正反向传播的值得到有效的控制,在kaiming初始化中,主要将权重的方差设置为 \(D(w) = \frac{2}{ni}\),由于考虑到ReLU激活函数,将方差调整为\(D(w)= \frac{2}{(1+a^2)*n_i}\), 这里的a是ReLU的斜率。

在pytorch中使用Kaiming初始化

nn.init.kaiming_normal_(m.weight.data)

LSTM初始化

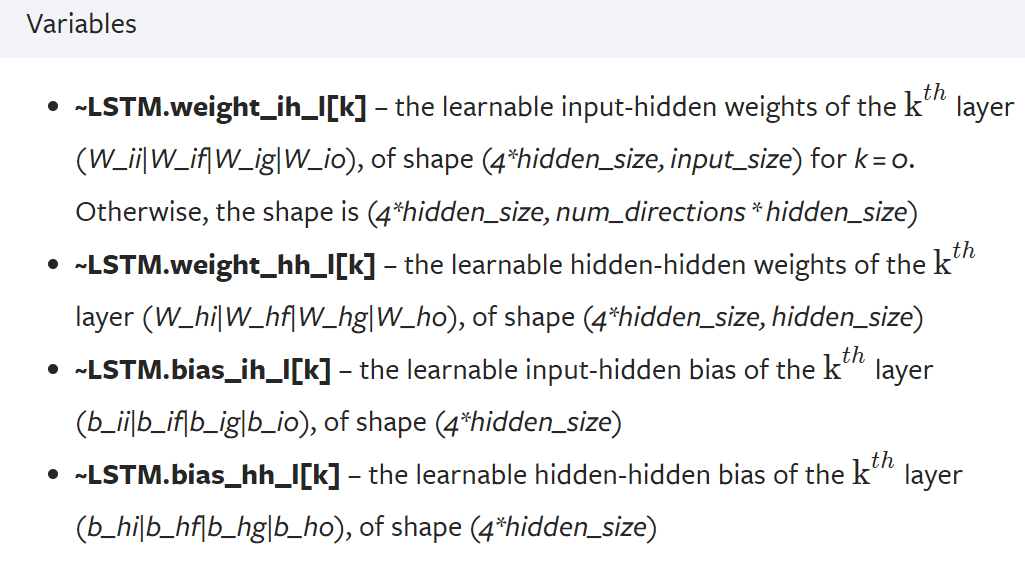

LSTM中,公式和参数值的设定如下所示

在LSTM中,由于很多门控的权重尺寸是一样的,所以可以使用如下方法进行初始化

def _init_lstm(self, weight):

for w in weight.chunk(4, 0):

init.xavier_uniform(w)

self._init_lstm(self.lstm.weight_ih_l0)

self._init_lstm(self.lstm.weight_hh_l0)

self.lstm.bias_ih_l0.data.zero_()

self.lstm.bias_hh_l0.data.zero_()

Embedding进行初始化

self.embedding = nn.Embedding(embedding_tokens, embedding_features, padding_idx=0)

init.xavier_uniform(self.embedding.weight)

其他通用初始化方法

遍历初始化

for name, param in net.named_parameters():

if 'weight' in name:

init.normal_(param, mean=0, std=0.01)

print(name, param.data)

for name, param in net.named_parameters():

if 'bias' in name:

init.constant_(param, val=0)

print(name, param.data)

## 通过instance 初始化

for m in self.children():

if isinstance(m, nn.Linear):

nn.init.constant_(m.weight, 1)

nn.init.constant_(m.bias, -100)

# 也可以判断是否为conv2d,使用相应的初始化方式

elif isinstance(m, nn.Conv2d):

nn.init.kaiming_normal_(m.weight, mode='fan_out', nonlinearity='relu')

elif isinstance(m, nn.BatchNorm2d):

nn.init.constant_(m.weight.item(), 1)

nn.init.constant_(m.bias.item(), 0)

直接使用pytorch内置初始化

from torch.nn import init

init.normal_(net[0].weight, mean=0, std=0.01)

init.constant_(net[0].bias, val=0)

自带初始化方法中,会自动消除梯度反向传播,但是手动情况下必须自己设定

def no_grad_uniform(tensor, a, b):

with torch.no_grad():

return tensor.uniform_(a, b)

使用apply进行初始化

批量初始化方法,注意net里面的apply函数,可以作用网络的所有module

def weights_init(m): # 1

classname = m.__class__.__name__ # 2

if classname.find('Conv') != -1: # 3

nn.init.kaiming_normal_(m.weight.data) # 4

elif classname.find('BatchNorm') != -1: # 5

nn.init.normal_(m.weight.data, 1.0, 0.02) # 6

nn.init.constant_(m.bias.data, 0) # 7

net.apply(weights_init)

Pytorch系列:(七)模型初始化的更多相关文章

- 计算广告CTR预估系列(七)--Facebook经典模型LR+GBDT理论与实践

计算广告CTR预估系列(七)--Facebook经典模型LR+GBDT理论与实践 2018年06月13日 16:38:11 轻春 阅读数 6004更多 分类专栏: 机器学习 机器学习荐货情报局 版 ...

- Alamofire源码解读系列(七)之网络监控(NetworkReachabilityManager)

Alamofire源码解读系列(七)之网络监控(NetworkReachabilityManager) 本篇主要讲解iOS开发中的网络监控 前言 在开发中,有时候我们需要获取这些信息: 手机是否联网 ...

- [Asp.net MVC]Asp.net MVC5系列——在模型中添加验证规则

目录 概述 在模型中添加验证规则 自定义验证规则 伙伴类的使用 总结 系列文章 [Asp.net MVC]Asp.net MVC5系列——第一个项目 [Asp.net MVC]Asp.net MVC5 ...

- WCF编程系列(七)信道及信道工厂

WCF编程系列(七)信道及信道工厂 信道及信道栈 前面已经提及过,WCF中客户端与服务端的交互都是通过消息来进行的.消息从客户端传送到服务端会经过多个处理动作,在WCF编程模型中,这些动作是按层 ...

- Asp.net MVC]Asp.net MVC5系列——在模型中添加

目录 概述 在模型中添加验证规则 自定义验证规则 伙伴类的使用 总结 系列文章 [Asp.net MVC]Asp.net MVC5系列——第一个项目 [Asp.net MVC]Asp.net MVC5 ...

- iOS流布局UICollectionView系列七——三维中的球型布局

摘要: 类似标签云的球状布局,也类似与魔方的3D布局 iOS流布局UICollectionView系列七——三维中的球型布局 一.引言 通过6篇的博客,从平面上最简单的规则摆放的布局,到不规则的瀑 ...

- [源码解析] PyTorch分布式(6) -------- DistributedDataParallel -- 初始化&store

[源码解析] PyTorch分布式(6) ---DistributedDataParallel -- 初始化&store 目录 [源码解析] PyTorch分布式(6) ---Distribu ...

- Keil MDK STM32系列(七) STM32F4基于HAL的PWM和定时器

Keil MDK STM32系列 Keil MDK STM32系列(一) 基于标准外设库SPL的STM32F103开发 Keil MDK STM32系列(二) 基于标准外设库SPL的STM32F401 ...

- SQL Server 2008空间数据应用系列七:基于Bing Maps(Silverlight) 的空间数据展现

原文:SQL Server 2008空间数据应用系列七:基于Bing Maps(Silverlight) 的空间数据展现 友情提示,您阅读本篇博文的先决条件如下: 1.本文示例基于Microsoft ...

随机推荐

- ST为飞行时间传感器增加了多目标测距

ST为飞行时间传感器增加了多目标测距 ST adds multi-object ranging to time-of-flight sensors STMicroelectronics已经扩展了其Fl ...

- 正则表达式re模块的基础及简单应用

一.re的简介 re模块是python独有的匹配字符串的模块 该模块中的很多功能是基于正则表达式实现 二.正则表达式的基础语法 元字符 匹配内容说明 . 匹配除换行符以外的任意字符 \w 匹配字母或数 ...

- postgresql无序uuid性能测试

无序uuid对数据库的影响 由于最近在做超大表的性能测试,在该过程中发现了无序uuid做主键对表插入性能有一定影响.结合实际情况发现当表的数据量越大,对表插入性能的影响也就越大. 测试环境 Postg ...

- selenium常用方法集合

一.selenium定位元素的8种方法: 1.find_element_by_id() 2.find_element_by_name() 3.find_element_by_css() 4.find_ ...

- Task02:基础查询与排序

2.1 SELECT语句基础 2.1.1 从表中选取数据 SELECT语句 从表中选取数据时需要使用SELECT语句,也就是只从表中选出(SELECT)必要数据的意思.通过SELECT语句查询并选取出 ...

- 开关电源(1)之BUCK降压变换器工作原理及Multisim实例仿真

开关电源(Switching Mode Power Supply)即开关稳压电源,是相对于线性稳压电源的一种的新型稳压电源电路,它通过对输出电压实时监测并动态控制开关管导通与断开的时间比值来稳定 ...

- ANDROID开发 Fatal signal 11(SIGSEGV) at 0x问题解决方案

最近做ANDROID开发,也遇到了很多程序员遇到的一个问题:FATAL SIGNAL 11(SIGSEGV) at 0xxxxx,自然是各种搜索是否有人已然解决,虽然搜索出来的已有案例不少,基本都是内 ...

- Kubernetes使用Keda进行弹性伸缩,更合理利用资源

我最新最全的文章都在南瓜慢说 www.pkslow.com,欢迎大家来喝茶! 1 简介 Kubernetes自带的HPA是只支持CPU/MEM的,很多时候我们并不根据这两项指标来进行伸缩资源.比如消费 ...

- ACM、OI、OJ题目常用代码模板

仓库源码地址:https://github.com/richenyunqi/code-templates 本仓库主要提供 ACM.OI.OJ.PAT.CSP 题目中常见算法和数据结构的实现,它们都以基 ...

- .net获取项目根目录方法集合

这篇文章是别的博客复下来,收藏的: 编写程序的时候,经常需要用的项目根目录.自己总结如下 1.取得控制台应用程序的根目录方法 方法1.Environment.CurrentDirectory ...