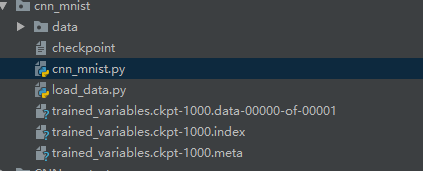

tensorflow模型的保存与恢复

1.tensorflow中模型的保存

创建tf.train.saver,使用saver进行保存:

saver = tf.train.Saver()

saver.save(sess, './trained_variables.ckpt', global_step=1000)

1.1.在保存时需要注意参数在创建时需要传入name参数,读取参数时凭借name属性读取。

def weight_variable(shape, name):

initial = tf.truncated_normal(shape, stddev=0.1, name=name)

return tf.Variable(initial) W_conv1 = weight_variable([5, 5, 1, 32], name='W_conv1')

1.2例子

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data mnist = input_data.read_data_sets('data/', one_hot=True) def weight_variable(shape, name):

initial = tf.truncated_normal(shape, stddev=0.1, name=name)

return tf.Variable(initial) def bias_variable(shape, name):

initial = tf.constant(0.1, shape=shape, name=name)

return tf.Variable(initial) def conv2d(x, W):

return tf.nn.conv2d(x, W, strides=[1, 1, 1, 1], padding='SAME') def max_pool_2x2(x):

return tf.nn.max_pool(x, ksize=[1, 2, 2, 1], strides=[1, 2, 2, 1], padding='SAME') x = tf.placeholder(tf.float32, [None, 784])

y_ = tf.placeholder(tf.float32, [None, 10])

x_image = tf.reshape(x, [-1, 28, 28, 1]) W_conv1 = weight_variable([5, 5, 1, 32], name='W_conv1')

b_conv1 = bias_variable([32], name='b_conv1')

h_conv1 = tf.nn.relu(conv2d(x_image, W_conv1) + b_conv1)

h_pool1 = max_pool_2x2(h_conv1) W_conv2 = weight_variable([5, 5, 32, 64], name='W_conv2')

b_conv2 = bias_variable([64], name='b_conv2')

h_conv2 = tf.nn.relu(conv2d(h_pool1, W_conv2) + b_conv2)

h_pool2 = max_pool_2x2(h_conv2) W_fc1 = weight_variable([7*7*64, 1024], name='W_fc1')

b_fc1 = bias_variable([1024], name='b_fc1')

h_pool2_flat = tf.reshape(h_pool2, [-1, 7*7*64])

h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat, W_fc1) + b_fc1) keep_prob = tf.placeholder(tf.float32)

h_fc1_drop = tf.nn.dropout(h_fc1, keep_prob) W_fc2 = weight_variable([1024, 10], name='W_fc2')

b_fc2 = bias_variable([10], name='b_fc2')

y_conv = tf.nn.softmax(tf.matmul(h_fc1_drop, W_fc2) + b_fc2) cross_entropy = tf.reduce_sum(tf.nn.softmax_cross_entropy_with_logits(logits=y_conv, labels=y_)) # cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_ * tf.log(y_conv), reduction_indices=[1]))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy) correct_prediction = tf.equal(tf.argmax(y_conv, 1), tf.argmax(y_, 1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) sess = tf.Session()

sess.run(tf.global_variables_initializer()) for i in range(500): batch = mnist.train.next_batch(100) train_step.run(session=sess, feed_dict={x: batch[0], y_: batch[1], keep_prob: 0.5})

if i % 100 == 0:

train_accuracy = accuracy.eval(session=sess, feed_dict={x: batch[0], y_: batch[1], keep_prob: 1.0})

print('step %d, training accuracy %g' % (i, train_accuracy)) print("!!!!!")

print('test accuracy %g' % accuracy.eval(session=sess, feed_dict={

x: mnist.test.images, y_: mnist.test.labels, keep_prob: 1.0

})) saver = tf.train.Saver()

saver.save(sess, './trained_variables.ckpt', global_step=1000) # with tf.Session() as sess:

# new_saver = tf.train.import_meta_graph('my_test_model-1000.meta')

# new_saver.restore(sess, tf.train.latest_checkpoint('./')) # print(sess.run(W_conv1))

效果:

2.模型的恢复

2.1.开始会话-->找到参数存放的文件,使用import_meta_graph方法导入文件-->恢复参数:

sess = tf.Session()

new_saver = tf.train.import_meta_graph('trained_variables.ckpt-1000.meta')

new_saver.restore(sess, tf.train.latest_checkpoint('./'))

2.2创建恢复的graph对象:

graph = tf.get_default_graph()

2.3按照模型保存时的参数名来重新加载参数:

W_conv1 = graph.get_tensor_by_name("W_conv1:0")

b_conv1 = graph.get_tensor_by_name("b_conv1:0")

2.4例子

import tensorflow as tf sess = tf.Session()

new_saver = tf.train.import_meta_graph('trained_variables.ckpt-1000.meta')

new_saver.restore(sess, tf.train.latest_checkpoint('./')) graph = tf.get_default_graph()

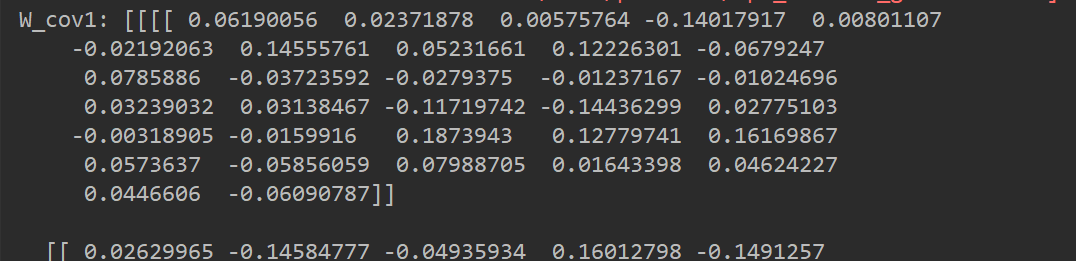

W_conv1 = graph.get_tensor_by_name("W_conv1:0")

b_conv1 = graph.get_tensor_by_name("b_conv1:0")

print('W_cov1:', sess.run(W_conv1))

效果:

tensorflow模型的保存与恢复的更多相关文章

- [翻译] Tensorflow模型的保存与恢复

翻译自:http://cv-tricks.com/tensorflow-tutorial/save-restore-tensorflow-models-quick-complete-tutorial/ ...

- tensorflow模型的保存与恢复,以及ckpt到pb的转化

转自 https://www.cnblogs.com/zerotoinfinity/p/10242849.html 一.模型的保存 使用tensorflow训练模型的过程中,需要适时对模型进行保存,以 ...

- tensorflow 1.0 学习:模型的保存与恢复(Saver)

将训练好的模型参数保存起来,以便以后进行验证或测试,这是我们经常要做的事情.tf里面提供模型保存的是tf.train.Saver()模块. 模型保存,先要创建一个Saver对象:如 saver=tf. ...

- tensorflow 1.0 学习:模型的保存与恢复

将训练好的模型参数保存起来,以便以后进行验证或测试,这是我们经常要做的事情.tf里面提供模型保存的是tf.train.Saver()模块. 模型保存,先要创建一个Saver对象:如 saver=tf. ...

- TensorFlow笔记-模型的保存,恢复,实现线性回归

模型的保存 tf.train.Saver(var_list=None,max_to_keep=5) •var_list:指定将要保存和还原的变量.它可以作为一个 dict或一个列表传递. •max_t ...

- Tensorflow模型变量保存

Tensorflow:模型变量保存 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献Tensorflow实战Google深度学习框架 实验平台: Tensorflow1.4.0 pyt ...

- 三、TensorFlow模型的保存和加载

1.模型的保存: import tensorflow as tf v1 = tf.Variable(1.0,dtype=tf.float32) v2 = tf.Variable(2.0,dtype=t ...

- 超详细的Tensorflow模型的保存和加载(理论与实战详解)

1.Tensorflow的模型到底是什么样的? Tensorflow模型主要包含网络的设计(图)和训练好的各参数的值等.所以,Tensorflow模型有两个主要的文件: a) Meta graph: ...

- tensorflow模型的保存与加载

模型的保存与加载一般有三种模式:save/load weights(最干净.最轻量级的方式,只保存网络参数,不保存网络状态),save/load entire model(最简单粗暴的方式,把网络所有 ...

随机推荐

- Swift5 语言参考(六) 声明

一个声明引入了一个新的名称或构建到你的程序.例如,您使用声明来引入函数和方法,引入变量和常量,以及定义枚举,结构,类和协议类型.您还可以使用声明来扩展现有命名类型的行为,并将符号导入到其他地方声明的程 ...

- markdown的学习记录

一.markdown用处: 写博客,写微信公众号等等 二.准备工作: 工具使用:由于代码经常使用idea,所以继续使用idea编写markdown,但需要安装插件:MarkDown Navigator ...

- redis常用命令(二)

一.集合(set) 单值多value,vaue不能重复 sadd/smembers/sismember 添加数据/获取set所有数据/判断是否存在某个值 scard 获取集合里面的元素个数 srem ...

- odoo开发笔记 -- 官方模块一览表

模块名称 技术名称 作者 电子发票管理 account OpenERP SA 会计与财务 account_accountant OpenERP SA 合同管理 account_analytic_ana ...

- 解决Navicat Premium终端操作mysql ONLY_FULL_GROUP_BY错误

解决navicate终端操作mysql ONLY_FULL_GROUP_BY错误 问题描述: [Err] 1055 - Expression #1 of SELECT list is not ...

- How To Scan QRCode For UWP (3)

这一节主要介绍如何去设置MediaCapture拍照的分辨率. MediaCapture 包含一个 VideoDeviceController对象,凭借它可以控制摄像头的很多设置,其中包括设置拍照的分 ...

- (转)python通过paramiko实现,ssh功能

python通过paramiko实现,ssh功能 1 import paramiko 2 3 ssh =paramiko.SSHClient()#创建一个SSH连接对象 4 ssh.set_missi ...

- Fragment中启动一个新的Activity

最近遇到一个小问题,就是我在主界面中用的是Fragment,其中四个Fragment,然后打算在其中一个里边,写一个TextView(准确地说是Linearout)的单击事件,然后跳转到另外一个Act ...

- Docker概念学习系列之Docker与传统虚拟机差异(4)

不多说,直接上干货! 见[博主]撰写的https://mp.weixin.qq.com/s/YihjPONUcUi4b_7RC8oLYw 传统虚拟化是在硬件层面实现虚拟化,需要有额外的虚拟机管理应 ...

- JLS中表达式的所有文法

3.8. Identifiers Identifier: IdentifierChars but not a Keyword or BooleanLiteral or NullLiteral Iden ...