Deep Learning学习随记(二)Vectorized、PCA和Whitening

接着上次的记,前面看了稀疏自编码。按照讲义,接下来是Vectorized, 翻译成向量化?暂且这么认为吧。

Vectorized:

这节是老师教我们编程技巧了,这个向量化的意思说白了就是利用已经被优化了的数值运算来编程,矩阵的操作

尽量少用for循环,用已有的矩阵运算符来操作。这里只是粗略的看了下,有些小技巧还是不错的。

PCA:

PCA这个以前都接触过了,简单说就是两步:

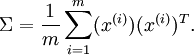

1.协方差矩阵 其中x(i)是输入样本(假设已经均值化)。

其中x(i)是输入样本(假设已经均值化)。

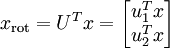

2.SVD分解,得出U向量。其中U向量的每列就是样本的新的方向向量。前面的是主方向。然后用U'*x得到

PCA后的样本值xrot:

Whitening:

我们已经了解了如何使用PCA降低数据维度。在一些算法中还需要一个与之相关的预处理步骤,这个预处理过程称为whitening(一些文献中也叫shpering)。举例来说,假设训练数据是图像,由于图像中相邻像素之间具有很强的相关性,如果用原始图像数据作为输入的话,输入是冗余的。whitening的目的就是降低输入的冗余性;更正式的说,我们希望通过whitening过程使得学习算法的输入具有如下性质:(i)特征之间相关性较低;(ii)所有特征具有相同的方差。

由于PCA以后已经满足了第一个条件(特征之间不相关的),因此需要满足第二个条件。讲义提到了两种whitening方法:

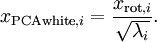

1)PCA whitening:

为了使每个输入特征具有单位方差,我们可以直接使用1/ √λi 来缩放每个特征,

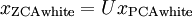

2)ZCA whitening:

由于使数据的协方差矩阵变为单位矩阵的方式不唯一,如假设R是正交矩阵(RTR=RRT=I),那么RxPCAwhite仍然具有单位协方差。取R = U,

则是ZCA whitening,

.

.

注:考虑到λi某些时候会很小,接近于0,在除的时候要进行正则化,加上一个很小的ε(一般取值为10-5).

另外讲义中提到关于ZCAwhitening一点有意思的就是:事实证明这也是一种对生物眼睛(视网膜)处理图像的粗糙的模型。眼睛感知图像时,由于一幅图像中相邻的部分在亮度上十分相关,大多数临近的“像素”在眼中被感知为相近的值。人眼如果分别传输每个像素(通过视觉神经)到大脑中,会非常不划算。取而代之的是,视网膜进行一个与ZCA中相似的去相关操作 (这是由视网膜上的ON-型和OFF-型光感受器细胞将光信号转变为神经信号完成的)。由此得到对输入图像的更低冗余的表示,并将它传输到大脑。

实现:

这里也是看了tornadomeet的代码:http://www.cnblogs.com/tornadomeet/archive/2013/03/21/2973631.html,代码挺简单的,看了这些,matlab有所了解了,以后也尝试着自己先写一下了。

close all %%================================================================

%% Step : Load data

% We have provided the code to load data from pcaData.txt into x.

% x is a * matrix, where the kth column x(:,k) corresponds to

% the kth data point.Here we provide the code to load natural image data into x.

% You do not need to change the code below. x = load('pcaData.txt','-ascii');

figure();

scatter(x(, :), x(, :));

title('Raw data'); %%================================================================

%% Step 1a: Implement PCA to obtain U

% Implement PCA to obtain the rotation matrix U, which is the eigenbasis

% sigma. % -------------------- YOUR CODE HERE --------------------

u = zeros(size(x, )); % You need to compute this

[n m] = size(x);

%x = x-repmat(mean(x,),,m);%预处理,均值为0

sigma = (1.0/m)*x*x';

[u s v] = svd(sigma); % --------------------------------------------------------

hold on

plot([ u(,)], [ u(,)]);%画第一条线

plot([ u(,)], [ u(,)]);%第二条线

scatter(x(, :), x(, :));

hold off %%================================================================

%% Step 1b: Compute xRot, the projection on to the eigenbasis

% Now, compute xRot by projecting the data on to the basis defined

% by U. Visualize the points by performing a scatter plot. % -------------------- YOUR CODE HERE --------------------

xRot = zeros(size(x)); % You need to compute this

xRot = u'*x; % -------------------------------------------------------- % Visualise the covariance matrix. You should see a line across the

% diagonal against a blue background.

figure();

scatter(xRot(, :), xRot(, :));

title('xRot'); %%================================================================

%% Step : Reduce the number of dimensions from to .

% Compute xRot again (this time projecting to dimension).

% Then, compute xHat by projecting the xRot back onto the original axes

% to see the effect of dimension reduction % -------------------- YOUR CODE HERE --------------------

k = ; % Use k = and project the data onto the first eigenbasis

xHat = zeros(size(x)); % You need to compute this

m_u = u(:,);

xx = [u(:,),zeros(n,)];

xxx = [u(:,),zeros(n,)]'*x; xHat = u*([u(:,),zeros(n,)]'*x); % --------------------------------------------------------

figure();

scatter(xHat(, :), xHat(, :));

title('xHat'); %%================================================================

%% Step : PCA Whitening

% Complute xPCAWhite and plot the results. epsilon = 1e-;

% -------------------- YOUR CODE HERE --------------------

xPCAWhite = zeros(size(x)); % You need to compute this

xPCAWhite = diag(./sqrt(diag(s)+epsilon))*u'*x; % --------------------------------------------------------

figure();

scatter(xPCAWhite(, :), xPCAWhite(, :));

title('xPCAWhite'); %%================================================================

%% Step : ZCA Whitening

% Complute xZCAWhite and plot the results. % -------------------- YOUR CODE HERE --------------------

xZCAWhite = zeros(size(x)); % You need to compute this

xZCAWhite = u*diag(./sqrt(diag(s)+epsilon))*u'*x; % --------------------------------------------------------

figure();

scatter(xZCAWhite(, :), xZCAWhite(, :));

title('xZCAWhite'); %% Congratulations! When you have reached this point, you are done!

% You can now move onto the next PCA exercise. :)

Deep Learning学习随记(二)Vectorized、PCA和Whitening的更多相关文章

- Deep Learning学习随记(一)稀疏自编码器

最近开始看Deep Learning,随手记点,方便以后查看. 主要参考资料是Stanford 教授 Andrew Ng 的 Deep Learning 教程讲义:http://deeplearnin ...

- Deep Learning 学习随记(六)Linear Decoder 线性解码

线性解码器(Linear Decoder) 前面第一章提到稀疏自编码器(http://www.cnblogs.com/bzjia-blog/p/SparseAutoencoder.html)的三层网络 ...

- Deep Learning 学习随记(五)深度网络--续

前面记到了深度网络这一章.当时觉得练习应该挺简单的,用不了多少时间,结果训练时间真够长的...途中debug的时候还手贱的clear了一下,又得从头开始运行.不过最终还是调试成功了,sigh~ 前一篇 ...

- Deep Learning 学习随记(五)Deep network 深度网络

这一个多周忙别的事去了,忙完了,接着看讲义~ 这章讲的是深度网络(Deep Network).前面讲了自学习网络,通过稀疏自编码和一个logistic回归或者softmax回归连接,显然是3层的.而这 ...

- Deep Learning 学习随记(四)自学习和非监督特征学习

接着看讲义,接下来这章应该是Self-Taught Learning and Unsupervised Feature Learning. 含义: 从字面上不难理解其意思.这里的self-taught ...

- Deep Learning 学习随记(三)Softmax regression

讲义中的第四章,讲的是Softmax 回归.softmax回归是logistic回归的泛化版,先来回顾下logistic回归. logistic回归: 训练集为{(x(1),y(1)),...,(x( ...

- Deep Learning 学习随记(八)CNN(Convolutional neural network)理解

前面Andrew Ng的讲义基本看完了.Andrew讲的真是通俗易懂,只是不过瘾啊,讲的太少了.趁着看完那章convolution and pooling, 自己又去翻了翻CNN的相关东西. 当时看讲 ...

- Deep Learning 学习随记(七)Convolution and Pooling --卷积和池化

图像大小与参数个数: 前面几章都是针对小图像块处理的,这一章则是针对大图像进行处理的.两者在这的区别还是很明显的,小图像(如8*8,MINIST的28*28)可以采用全连接的方式(即输入层和隐含层直接 ...

- Deep Learning 学习随记(三)续 Softmax regression练习

上一篇讲的Softmax regression,当时时间不够,没把练习做完.这几天学车有点累,又特别想动动手自己写写matlab代码 所以等到了现在,这篇文章就当做上一篇的续吧. 回顾: 上一篇最后给 ...

随机推荐

- python2.7中使用mysql (windows XP)

一.首先下载mysql—python模块,下载完毕之后会有一个MySQL-python-1.2.3.win32-py2.7.exe文件,点击安装一路next,ok. 二.编辑配置文件(setting. ...

- SVN 修改URL路径|SVN 项目路径修改

在svn的根目录下面右键 输入要修改的地址: 点击ok 搞定... ~~~

- 关于Android4.2后WebView的js方法需要加@JavascriptInterface

解读: targetSdkVersion>=17时,需要加上@JavascriptInterface,否则报错Uncaught TypeError: Object [object Object] ...

- Resharper中注释代码的快捷键

Resharper中 Visual Studio中 注释代码 Ctrl+Alt+/ Ctrl+E+C 取消注释 Ctrl+Alt+/ ...

- WordPress 开放重定向漏洞

漏洞名称: WordPress 开放重定向漏洞 CNNVD编号: CNNVD-201309-167 发布时间: 2013-09-13 更新时间: 2013-09-13 危害等级: 高危 漏洞类型: ...

- 数据结构(分块):[HZOI 2015]easy seq

[题目描述] 给定一个序列,下标从0开始,分别为a0,a1,a2...an−1,有m个询问,每次给出l和r,求满足ai=aj且l<=i<=j<=r时j−i的最大值 本题强制在线,l和 ...

- 关于 all-delete-orphan

当关联双方存在父子关系,就可以在 set 处设定 cascade 为 all-delete-orphan 所谓父子关系,即指由父方控制子方的持久化圣明周期,子方对象必须和一个父方对象关联.如果删除父方 ...

- 锐浪应用小插曲,asp.net下的使用

下午提前完成了今天的工作内容,整了下bs中的应用,嘿嘿,其中遇到不少问题,接下来说下大概会遇到哪些问题,1:grid++ 6.0插件下载安装之后ie浏览器无法打开,居然什么都没有显示,奇葩啊,系统版本 ...

- 最常用的 Eclipse 快捷键总结

本文是一些最实用.最齐全.最省时间的 Eclipse 快捷键总结,这些快捷键可以让帮助你完成工作中的任何一个操作.欢迎参考. 1. ctrl+shift+r:打开资源 这可能是所有快捷键组合中最省时间 ...

- 转 :hdoj 4857 逃生【反向拓扑】

逃生 Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others)Total Submissi ...