007.Kubernetes二进制部署Flannel

一 部署flannel

1.1 安装flannel

1 [root@k8smaster01 ~]# cd /opt/k8s/work/

2 [root@k8smaster01 work]# mkdir flannel

3 [root@k8smaster01 work]# wget https://github.com/coreos/flannel/releases/download/v0.11.0/flannel-v0.11.0-linux-amd64.tar.gz

4 [root@k8smaster01 work]# tar -xzvf flannel-v0.11.0-linux-amd64.tar.gz -C flannel

1.2 分发flannel

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 scp flannel/{flanneld,mk-docker-opts.sh} root@${master_ip}:/opt/k8s/bin/

7 ssh root@${master_ip} "chmod +x /opt/k8s/bin/*"

8 done

1.3 创建flannel证书和密钥

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# cat > flanneld-csr.json <<EOF

3 {

4 "CN": "flanneld",

5 "hosts": [],

6 "key": {

7 "algo": "rsa",

8 "size": 2048

9 },

10 "names": [

11 {

12 "C": "CN",

13 "ST": "Shanghai",

14 "L": "Shanghai",

15 "O": "k8s",

16 "OU": "System"

17 }

18 ]

19 }

20 EOF

21 #创建flanneld的CA证书请求文件

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# cfssl gencert -ca=/opt/k8s/work/ca.pem \

3 -ca-key=/opt/k8s/work/ca-key.pem -config=/opt/k8s/work/ca-config.json \

4 -profile=kubernetes flanneld-csr.json | cfssljson -bare flanneld #生成CA密钥(ca-key.pem)和证书(ca.pem)

1.4 分发证书和私钥

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 ssh root@${master_ip} "mkdir -p /etc/flanneld/cert"

7 scp flanneld*.pem root@${master_ip}:/etc/flanneld/cert

8 done

1.5 写入集群 Pod 网段信息

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# etcdctl \

4 --endpoints=${ETCD_ENDPOINTS} \

5 --ca-file=/opt/k8s/work/ca.pem \

6 --cert-file=/opt/k8s/work/flanneld.pem \

7 --key-file=/opt/k8s/work/flanneld-key.pem \

8 mk ${FLANNEL_ETCD_PREFIX}/config '{"Network":"'${CLUSTER_CIDR}'", "SubnetLen": 21, "Backend": {"Type": "vxlan"}}'

1.6 创建flanneld的systemd

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# cat > flanneld.service << EOF

4 [Unit]

5 Description=Flanneld overlay address etcd agent

6 After=network.target

7 After=network-online.target

8 Wants=network-online.target

9 After=etcd.service

10 Before=docker.service

11

12 [Service]

13 Type=notify

14 ExecStart=/opt/k8s/bin/flanneld \\

15 -etcd-cafile=/etc/kubernetes/cert/ca.pem \\

16 -etcd-certfile=/etc/flanneld/cert/flanneld.pem \\

17 -etcd-keyfile=/etc/flanneld/cert/flanneld-key.pem \\

18 -etcd-endpoints=${ETCD_ENDPOINTS} \\

19 -etcd-prefix=${FLANNEL_ETCD_PREFIX} \\

20 -iface=${IFACE} \\

21 -ip-masq

22 ExecStartPost=/opt/k8s/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/docker

23 Restart=always

24 RestartSec=5

25 StartLimitInterval=0

26

27 [Install]

28 WantedBy=multi-user.target

29 RequiredBy=docker.service

30 EOF

1.7 分发flannel systemd

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 scp flanneld.service root@${master_ip}:/etc/systemd/system/

7 done

二 启动并验证

2.1 启动flannel

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# for master_ip in ${MASTER_IPS[@]}

3 do

4 echo ">>> ${master_ip}"

5 ssh root@${master_ip} "systemctl daemon-reload && systemctl enable flanneld && systemctl restart flanneld"

6 done

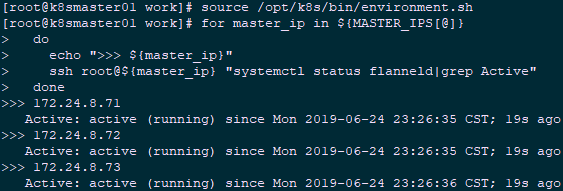

2.2 检查flannel启动

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# for master_ip in ${MASTER_IPS[@]}

3 do

4 echo ">>> ${master_ip}"

5 ssh root@${master_ip} "systemctl status flanneld|grep Active"

6 done

2.3 检查pod网段信息

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# etcdctl \

3 --endpoints=${ETCD_ENDPOINTS} \

4 --ca-file=/etc/kubernetes/cert/ca.pem \

5 --cert-file=/etc/flanneld/cert/flanneld.pem \

6 --key-file=/etc/flanneld/cert/flanneld-key.pem \

7 get ${FLANNEL_ETCD_PREFIX}/config #查看集群 Pod 网段(/16)

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# etcdctl \

3 --endpoints=${ETCD_ENDPOINTS} \

4 --ca-file=/etc/kubernetes/cert/ca.pem \

5 --cert-file=/etc/flanneld/cert/flanneld.pem \

6 --key-file=/etc/flanneld/cert/flanneld-key.pem \

7 ls ${FLANNEL_ETCD_PREFIX}/subnets #查看已分配的 Pod 子网段列表(/24)

8 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

9 [root@k8smaster01 ~]# etcdctl \

10 --endpoints=${ETCD_ENDPOINTS} \

11 --ca-file=/etc/kubernetes/cert/ca.pem \

12 --cert-file=/etc/flanneld/cert/flanneld.pem \

13 --key-file=/etc/flanneld/cert/flanneld-key.pem \

14 get ${FLANNEL_ETCD_PREFIX}/subnets/172.30.32.0-21 #查看某一 Pod 网段对应的节点 IP 和 flannel 接口地址

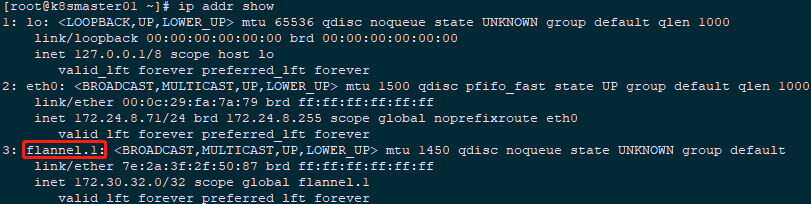

2.4 检查flannel网络信息

1 [root@k8smaster01 ~]# ip addr show

1 [root@k8smaster01 ~]# ip route show |grep flannel.1

2 172.30.128.0/21 via 172.30.128.0 dev flannel.1 onlink

3 172.30.208.0/21 via 172.30.208.0 dev flannel.1 onlink

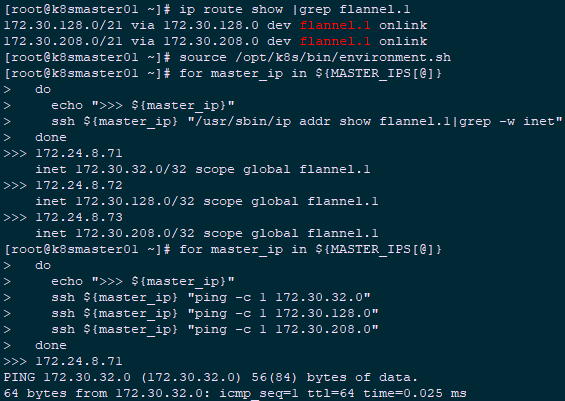

2.5 验证各节点flannel

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# for master_ip in ${MASTER_IPS[@]}

3 do

4 echo ">>> ${master_ip}"

5 ssh ${master_ip} "/usr/sbin/ip addr show flannel.1|grep -w inet"

6 done

1 >>> 172.24.8.71

2 inet 172.30.32.0/32 scope global flannel.1

3 >>> 172.24.8.72

4 inet 172.30.128.0/32 scope global flannel.1

5 >>> 172.24.8.73

6 inet 172.30.208.0/32 scope global flannel.1

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# for master_ip in ${MASTER_IPS[@]}

3 do

4 echo ">>> ${master_ip}"

5 ssh ${master_ip} "ping -c 1 172.30.32.0"

6 ssh ${master_ip} "ping -c 1 172.30.128.0"

7 ssh ${master_ip} "ping -c 1 172.30.208.0"

8 done

007.Kubernetes二进制部署Flannel的更多相关文章

- Kubernetes 二进制部署(一)单节点部署(Master 与 Node 同一机器)

0. 前言 最近受“新冠肺炎”疫情影响,在家等着,入职暂时延后,在家里办公和学习 尝试通过源码编译二进制的方式在单一节点(Master 与 Node 部署在同一个机器上)上部署一个 k8s 环境,整理 ...

- 012.Kubernetes二进制部署worker节点Flannel

一 部署flannel 1.1 安装flannel kubernetes 要求集群内各节点(包括 master 节点)能通过 Pod 网段互联互通.flannel 使用 vxlan 技术为各节点创建一 ...

- Kubernetes 二进制部署(二)集群部署(多 Master 节点通过 Nginx 负载均衡)

0. 前言 紧接上一篇,本篇文章我们尝试学习多节点部署 kubernetes 集群 并通过 haproxy+keepalived 实现 Master 节点的负载均衡 1. 实验环境 实验环境主要为 5 ...

- kubernetes二进制部署k8s-master集群controller-manager服务unhealthy问题

一.问题现象 我们使用二进制部署k8s的高可用集群时,在部署多master时,kube-controller-manager服务提示Unhealthy [root@ceph-01 system]# k ...

- k8s1.13.0二进制部署-flannel网络(二)

Flannel容器集群网络部署 Overlay Network:覆盖网络,在基础网络上叠加的一种虚拟网络技术模式,该网络中的主机通过虚拟链路连接起来.VXLAN:将源数据包封装到UDP中,并使用基础网 ...

- 003.Kubernetes二进制部署准备

一 前置准备 1.1 前置条件 相应的充足资源的Linux服务器: 设置相应的主机名,参考命令: hostnamectl set-hostname k8smaster Mac及UUID唯一: 若未关闭 ...

- 008.Kubernetes二进制部署Nginx实现高可用

一 Nginx代理实现kube-apiserver高可用 1.1 Nginx实现高可用 基于 nginx 代理的 kube-apiserver 高可用方案. 控制节点的 kube-controller ...

- 013.Kubernetes二进制部署worker节点Nginx实现高可用

一 Nginx代理实现kube-apiserver高可用 1.1 Nginx实现高可用 基于 nginx 代理的 kube-apiserver 高可用方案. 控制节点的 kube-controller ...

- 015.Kubernetes二进制部署所有节点kubelet

一 部署 kubelet kubelet 运行在每个 worker 节点上,接收 kube-apiserver 发送的请求,管理 Pod 容器,执行交互式命令,如 exec.run.logs 等. k ...

随机推荐

- COGS 2510. 拯救紫萱学姐

[题目描述] 其实在开考前半个小时题面并不是这样的. 由于明天要考试,同学们要把抽屉里的书都搬空,书很多而且办了走读不能回寝室的学长一眼就看到了回班撩他的学姐,于是就把学姐当学长用♂了:“帮我把这摞书 ...

- Arouter核心思路和源码详解

前言 阅读本文之前,建议读者: 对Arouter的使用有一定的了解. 对Apt技术有所了解. Arouter是一款Alibaba出品的优秀的路由框架,本文不对其进行全面的分析,只对其最重要的功能进行源 ...

- RF中for循环

robotframework支持FOR循环语句,语法和Python的语法基本相同,但robotframework中,“FOR”关键字前面需要增加一个“:”,写成“:FOR”,其它与Python的语法相 ...

- Linux下聊天和文件传输软件

全平台聊天软件 米聊 官网地址: http://www.miliao.com 潮信 官网地址: https://www.chaoxin.com

- 代码审计准备之Thinkphp3

0x01环境部署: 下载: 获取ThinkPHP的方式很多,官方网站(http://thinkphp.cn)是最好的下载和文档获取来源. 官网提供了稳定版本的下载:http://thinkphp.cn ...

- [Luogu2967] 视频游戏的麻烦Video Game Troubles

农夫约翰的奶牛们游戏成瘾!本来约翰是想要按照调教兽的做法拿她们去电击戒瘾的,可是 后来他发现奶牛们玩游戏之后比原先产更多的奶.很明显,这是因为满足的牛会产更多的奶. 但是,奶牛们在哪个才是最好的游 ...

- Rancher 2.1平台搭建及使用

一.概述 1.1.什么是Rancher Rancher是一套容器管理平台,它可以帮助组织在生产环境中轻松快捷的部署和管理容器. Rancher可以轻松地管理各种环境的Kubernetes,满足IT需求 ...

- 【Spring Cloud】服务容错保护:Hystrix(四)

一.雪崩效应 在微服务架构中,由于服务和服务之间可以互相调用,一项工作的完成可能会依赖调用多个微服务模块,但由于网络原因或者自身的原因,服务并不能保证100%可用,如果单个服务出现问题,调用这个服务就 ...

- kubernetes kubelet组件中cgroup的层层"戒备"

cgroup是linux内核中用于实现资源使用限制和统计的模块,docker的风靡一时少不了cgroup等特性的支持.kubernetes作为容器编排引擎,除了借助docker进行容器进程的资源管理外 ...

- 在Mac OSX上运行Windows应用程序

在Mac OSX中,借助wine,不需要安装虚拟机也可以运行Window应用程序. wine是一个在Linux和UNIX之上的,WIndows3.x和Windows APIs的实现.是运用API转换技 ...