Mongodb副本集+分片集群环境部署

前面详细介绍了mongodb的副本集和分片的原理,这里就不赘述了。下面记录Mongodb副本集+分片集群环境部署过程:

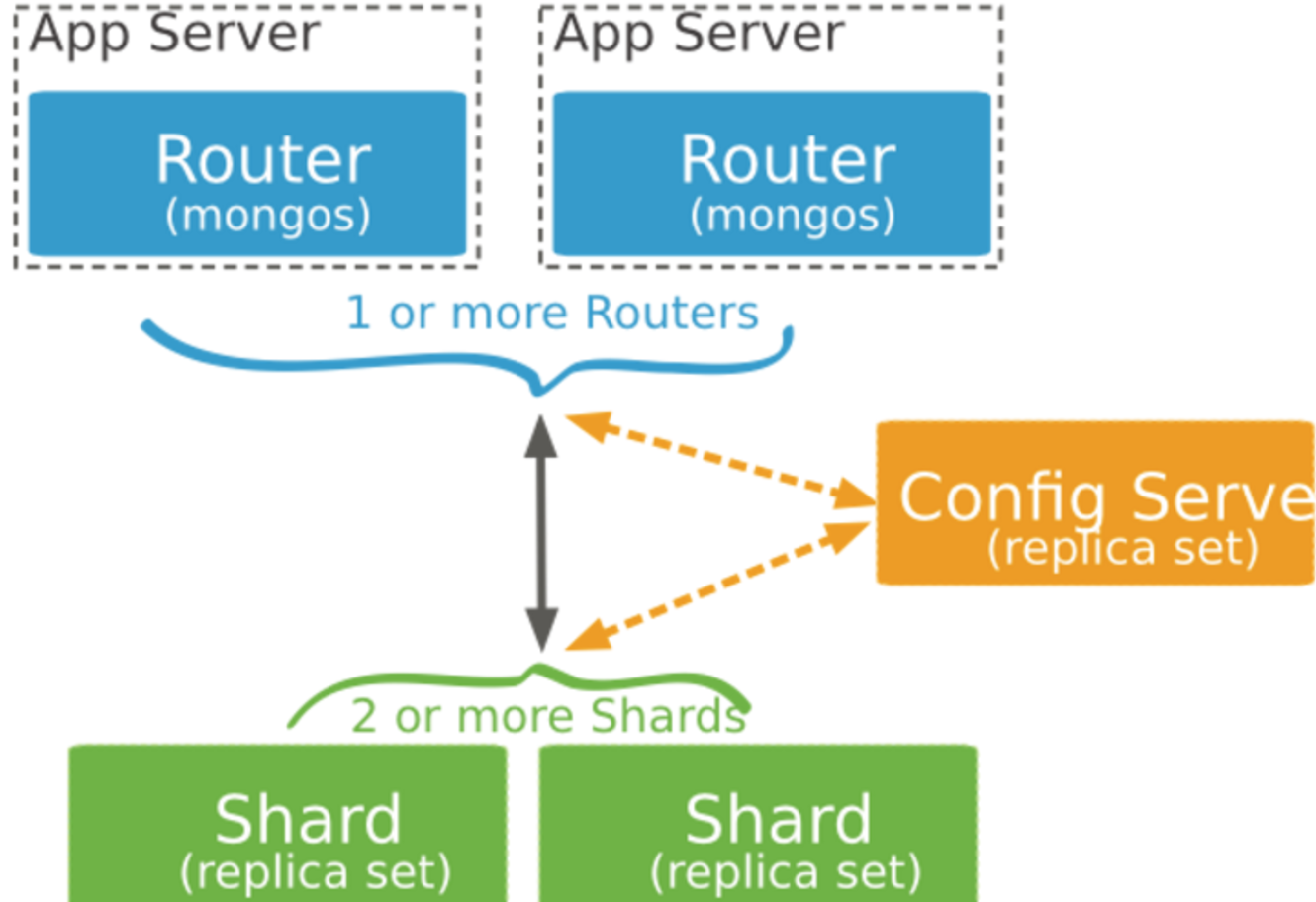

MongoDB Sharding Cluster,需要三种角色:

Shard Server: mongod 实例,用于存储实际的数据块,实际生产环境中一个shard server角色可由几台机器组个一个relica set承担,防止主机单点故障

Config Server: mongod 实例,存储了整个 Cluster Metadata,其中包括 chunk 信息。

Route Server: mongos 实例,前端路由,客户端由此接入,且让整个集群看上去像单一数据库,前端应用可以透明使用。

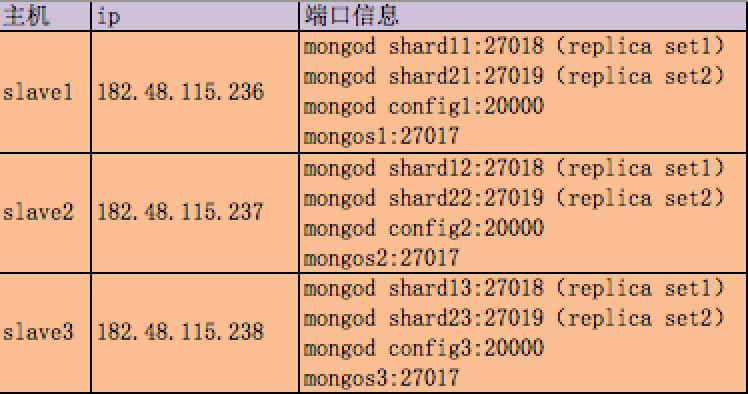

机器信息:

分别在3台机器运行一个mongod实例(称为mongod shard11,mongod shard12,mongod shard13)组织replica set1,作为cluster的shard1

分别在3台机器运行一个mongod实例(称为mongod shard21,mongod shard22,mongod shard23)组织replica set2,作为cluster的shard2

每台机器运行一个mongod实例,作为3个config server

每台机器运行一个mongos进程,用于客户端连接

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

293

294

295

296

297

298

299

300

301

302

303

304

305

306

307

308

309

310

311

312

313

314

315

316

317

318

319

320

321

322

323

324

325

326

327

328

329

330

331

332

333

334

335

336

337

338

339

340

341

342

343

344

345

346

347

348

349

350

351

352

353

354

355

356

357

358

359

360

361

362

363

364

365

366

367

368

369

370

371

372

|

1)安装mongodb (3台机器都要操作)下载地址:https://pan.baidu.com/s/1hsoVcpQ 提取密码:6zp4[root@slave1 src]# cd[root@slave1 ~]# cd /usr/local/src/[root@slave1 src]# ll mongodb-linux-x86_64-rhel62-3.0.6.tgz[root@slave1 src]# tar -zvxf mongodb-linux-x86_64-rhel62-3.0.6.tgz[root@slave1 src]# mv mongodb-linux-x86_64-rhel62-3.0.6 mongodb 2)创建sharding数据目录根据本例sharding架构图所示,在各台sever上创建shard数据文件目录slave1[root@slave1 src]# mkdir /home/services/[root@slave1 src]# mv mongodb /home/services/[root@slave1 src]# cd /home/services/mongodb/[root@slave1 mongodb]# mkdir -p data/shard11[root@slave1 mongodb]# mkdir -p data/shard21 slave2[root@slave2 src]# mkdir /home/services/[root@slave2 src]# mv mongodb /home/services/[root@slave2 src]# cd /home/services/mongodb/[root@slave2 mongodb]# mkdir -p data/shard12[root@slave2 mongodb]# mkdir -p data/shard22 slave3[root@slave3 src]# mkdir /home/services/[root@slave3 src]# mv mongodb /home/services/[root@slave3 src]# cd /home/services/mongodb/[root@slave3 mongodb]# mkdir -p data/shard13[root@slave3 mongodb]# mkdir -p data/shard23 3)配置relica sets3.1)配置shard1所用到的replica sets 1:slave1[root@slave1 ~]# /home/services/mongodb/bin/mongod --shardsvr --replSet shard1 --port 27018 --dbpath /home/services/mongodb/data/shard11 --oplogSize 100 --logpath /home/services/mongodb/data/shard11.log --logappend --fork slave2[root@slave2 ~]# /home/services/mongodb/bin/mongod --shardsvr --replSet shard1 --port 27018 --dbpath /home/services/mongodb/data/shard12 --oplogSize 100 --logpath /home/services/mongodb/data/shard12.log --logappend --fork slave3[root@slave3 ~]# /home/services/mongodb/bin/mongod --shardsvr --replSet shard1 --port 27018 --dbpath /home/services/mongodb/data/shard13 --oplogSize 100 --logpath /home/services/mongodb/data/shard13.log --logappend --fork 检车各个机器上的mongod进程是否正常起来了(ps -ef|grep mongod),27018端口是否正常起来了 3.2)初始化replica set 1从3台机器中任意找一台,连接mongod[root@slave1 ~]# /home/services/mongodb/bin/mongo --port 27018......> config = {"_id" : "shard1","members" : [{"_id" : 0,"host" : "182.48.115.236:27018"},{"_id" : 1,"host" : "182.48.115.237:27018"},{"_id" : 2,"host" : "182.48.115.238:27018"}]}{ "_id" : "shard1", "members" : [ { "_id" : 0, "host" : "182.48.115.236:27018" }, { "_id" : 1, "host" : "182.48.115.237:27018" }, { "_id" : 2, "host" : "182.48.115.238:27018" } ]}> rs.initiate(config);{ "ok" : 1 } 3.3)配置shard2所用到的replica sets 2:slave1[root@slave1 ~]# /home/services/mongodb//bin/mongod --shardsvr --replSet shard2 --port 27019 --dbpath /home/services/mongodb/data/shard21 --oplogSize 100 --logpath /home/services/mongodb/data/shard21.log --logappend --fork slave2[root@slave2 ~]# /home/services/mongodb//bin/mongod --shardsvr --replSet shard2 --port 27019 --dbpath /home/services/mongodb/data/shard22 --oplogSize 100 --logpath /home/services/mongodb/data/shard22.log --logappend --fork slave3[root@slave3 ~]# /home/services/mongodb//bin/mongod --shardsvr --replSet shard2 --port 27019 --dbpath /home/services/mongodb/data/shard23 --oplogSize 100 --logpath /home/services/mongodb/data/shard23.log --logappend --fork 3.4)初始化replica set 2从3台机器中任意找一台,连接mongod[root@slave1 ~]# /home/services/mongodb/bin/mongo --port 27019......> config = {"_id" : "shard2","members" : [{"_id" : 0,"host" : "182.48.115.236:27019"},{"_id" : 1,"host" : "182.48.115.237:27019"},{"_id" : 2,"host" : "182.48.115.238:27019"}]}{ "_id" : "shard2", "members" : [ { "_id" : 0, "host" : "182.48.115.236:27019" }, { "_id" : 1, "host" : "182.48.115.237:27019" }, { "_id" : 2, "host" : "182.48.115.238:27019" } ]}> rs.initiate(config);{ "ok" : 1 } 4)配置三台config serverslave1[root@slave1 ~]# mkdir -p /home/services/mongodb/data/config[root@slave1 ~]# /home/services/mongodb//bin/mongod --configsvr --dbpath /home/services/mongodb/data/config --port 20000 --logpath /home/services/mongodb/data/config.log --logappend --fork slave2[root@slave2 ~]# mkdir -p /home/services/mongodb/data/config[root@slave2 ~]# /home/services/mongodb//bin/mongod --configsvr --dbpath /home/services/mongodb/data/config --port 20000 --logpath /home/services/mongodb/data/config.log --logappend --fork slave3[root@slave3 ~]# mkdir -p /home/services/mongodb/data/config[root@slave3 ~]# /home/services/mongodb//bin/mongod --configsvr --dbpath /home/services/mongodb/data/config --port 20000 --logpath /home/services/mongodb/data/config.log --logappend --fork 5)配置mongs在三台机器上分别执行:slave1[root@slave1 ~]# /home/services/mongodb/bin/mongos --configdb 182.48.115.236:20000,182.48.115.237:20000,182.48.115.238:20000 --port 27017 --chunkSize 5 --logpath /home/services/mongodb/data/mongos.log --logappend --fork slave2[root@slave2 ~]# /home/services/mongodb/bin/mongos --configdb 182.48.115.236:20000,182.48.115.237:20000,182.48.115.238:20000 --port 27017 --chunkSize 5 --logpath /home/services/mongodb/data/mongos.log --logappend --fork slave3[root@slave3 ~]# /home/services/mongodb/bin/mongos --configdb 182.48.115.236:20000,182.48.115.237:20000,182.48.115.238:20000 --port 27017 --chunkSize 5 --logpath /home/services/mongodb/data/mongos.log --logappend --fork 注意:新版版的mongodb的mongos命令里就不识别--chunkSize参数了6)配置分片集群(Configuring the Shard Cluster)从3台机器中任意找一台,连接mongod,并切换到admin数据库做以下配置6.1)连接到mongs,并切换到admin[root@slave1 ~]# /home/services/mongodb/bin/mongo 182.48.115.236:27017/admin......mongos> dbadminmongos>6.2)加入shards分区如里shard是单台服务器,用"db.runCommand( { addshard : “[:]” } )"这样的命令加入如果shard是replica sets,用"replicaSetName/[:port][,serverhostname2[:port],…]"这样的格式表示,例如本例执行:mongos> db.runCommand( { addshard:"shard1/182.48.115.236:27018,182.48.115.237:27018,182.48.115.238:27018",name:"s1",maxsize:20480});{ "shardAdded" : "s1", "ok" : 1 }mongos> db.runCommand( { addshard:"shard2/182.48.115.236:27019,182.48.115.237:27019,182.48.115.238:27019",name:"s2",maxsize:20480});{ "shardAdded" : "s2", "ok" : 1 }注意:可选参数Name:用于指定每个shard的名字,不指定的话系统将自动分配maxSize:指定各个shard可使用的最大磁盘空间,单位megabytes6.3)Listing shardsmongos> db.runCommand( { listshards : 1 } ){ "shards" : [ { "_id" : "s1", "host" : "shard1/182.48.115.236:27018,182.48.115.237:27018,182.48.115.238:27018" }, { "_id" : "s2", "host" : "shard2/182.48.115.236:27019,182.48.115.237:27019,182.48.115.238:27019" } ], "ok" : 1}mongos>上面命令列出了以上二个添加的shards,表示shards已经配置成功6.4)激活数据库分片命令:db.runCommand( { enablesharding : “” } );通过执行以上命令,可以让数据库跨shard,如果不执行这步,数据库只会存放在一个shard,一旦激活数据库分片,数据库中不同的collection将被存放在不同的shard上,但一个collection仍旧存放在同一个shard上,要使单个collection也分片,还需单独对collection作些操作Collecton分片要使单个collection也分片存储,需要给collection指定一个分片key,通过以下命令操作:db.runCommand( { shardcollection : “”,key : });注意:a)分片的collection系统会自动创建一个索引(也可用户提前创建好)b)分片的collection只能有一个在分片key上的唯一索引,其它唯一索引不被允许本案例:mongos> db.runCommand({enablesharding:"test2"});{ "ok" : 1 }mongos> db.runCommand( { shardcollection : "test2.books", key : { id : 1 } } );{ "collectionsharded" : "test2.books", "ok" : 1 }mongos> use test2switched to db test2mongos> db.stats();{ "raw" : { "shard1/182.48.115.236:27018,182.48.115.237:27018,182.48.115.238:27018" : { "db" : "test2", "collections" : 3, "objects" : 6, "avgObjSize" : 69.33333333333333, "dataSize" : 416, "storageSize" : 20480, "numExtents" : 3, "indexes" : 2, "indexSize" : 16352, "fileSize" : 67108864, "nsSizeMB" : 16, "extentFreeList" : { "num" : 0, "totalSize" : 0 }, "dataFileVersion" : { "major" : 4, "minor" : 22 }, "ok" : 1, "$gleStats" : { "lastOpTime" : Timestamp(0, 0), "electionId" : ObjectId("586286596422d63aa9f9f000") } }, "shard2/182.48.115.236:27019,182.48.115.237:27019,182.48.115.238:27019" : { "db" : "test2", "collections" : 0, "objects" : 0, "avgObjSize" : 0, "dataSize" : 0, "storageSize" : 0, "numExtents" : 0, "indexes" : 0, "indexSize" : 0, "fileSize" : 0, "ok" : 1 } }, "objects" : 6, "avgObjSize" : 69, "dataSize" : 416, "storageSize" : 20480, "numExtents" : 3, "indexes" : 2, "indexSize" : 16352, "fileSize" : 67108864, "extentFreeList" : { "num" : 0, "totalSize" : 0 }, "ok" : 1}mongos> db.books.stats();{ "sharded" : true, "paddingFactorNote" : "paddingFactor is unused and unmaintained in 3.0. It remains hard coded to 1.0 for c ompatibility only.", "userFlags" : 1, "capped" : false, "ns" : "test2.books", "count" : 0, "numExtents" : 1, "size" : 0, "storageSize" : 8192, "totalIndexSize" : 16352, "indexSizes" : { "_id_" : 8176, "id_1" : 8176 }, "avgObjSize" : 0, "nindexes" : 2, "nchunks" : 1, "shards" : { "s1" : { "ns" : "test2.books", "count" : 0, "size" : 0, "numExtents" : 1, "storageSize" : 8192, "lastExtentSize" : 8192, "paddingFactor" : 1, "paddingFactorNote" : "paddingFactor is unused and unmaintained in 3.0. It remains hard co ded to 1.0 for compatibility only.", "userFlags" : 1, "capped" : false, "nindexes" : 2, "totalIndexSize" : 16352, "indexSizes" : { "_id_" : 8176, "id_1" : 8176 }, "ok" : 1, "$gleStats" : { "lastOpTime" : Timestamp(0, 0), "electionId" : ObjectId("586286596422d63aa9f9f000") } } }, "ok" : 1}7)测试mongos> for (var i = 1; i <= 20000; i++) db.books.save({id:i,name:"12345678",sex:"male",age:27,value:"test"});WriteResult({ "nInserted" : 1 })mongos> db.books.stats();{ "sharded" : true, "paddingFactorNote" : "paddingFactor is unused and unmaintained in 3.0. It remains hard coded to 1.0 for compatibility only.", "userFlags" : 1, "capped" : false, "ns" : "test2.books", "count" : 20000, "numExtents" : 10, "size" : 2240000, "storageSize" : 5586944, "totalIndexSize" : 1250928, "indexSizes" : { "_id_" : 670432, "id_1" : 580496 }, "avgObjSize" : 112, "nindexes" : 2, "nchunks" : 5, "shards" : { "s1" : { "ns" : "test2.books", "count" : 12300, "size" : 1377600, "avgObjSize" : 112, "numExtents" : 5, "storageSize" : 2793472, "lastExtentSize" : 2097152, "paddingFactor" : 1, "paddingFactorNote" : "paddingFactor is unused and unmaintained in 3.0. It remains hard coded to 1.0 for compatibility only.", "userFlags" : 1, "capped" : false, "nindexes" : 2, "totalIndexSize" : 760368, "indexSizes" : { "_id_" : 408800, "id_1" : 351568 }, "ok" : 1, "$gleStats" : { "lastOpTime" : Timestamp(0, 0), "electionId" : ObjectId("586286596422d63aa9f9f000") } }, "s2" : { "ns" : "test2.books", "count" : 7700, "size" : 862400, "avgObjSize" : 112, "numExtents" : 5, "storageSize" : 2793472, "lastExtentSize" : 2097152, "paddingFactor" : 1, "paddingFactorNote" : "paddingFactor is unused and unmaintained in 3.0. It remains hard coded to 1.0 for compatibility only.", "userFlags" : 1, "capped" : false, "nindexes" : 2, "totalIndexSize" : 490560, "indexSizes" : { "_id_" : 261632, "id_1" : 228928 }, "ok" : 1, "$gleStats" : { "lastOpTime" : Timestamp(0, 0), "electionId" : ObjectId("58628704f916bb05014c5ea7") } } }, "ok" : 1} |

Mongodb副本集+分片集群环境部署的更多相关文章

- 关于MongoDB副本集和分片集群有关用户和权限的说明分析

1.MongoDB副本集 可以先创建超管用户,然后再关闭服务,创建密钥文件,修改配置文件,启动服务,使用超管用户登录验证,然后创建普通用户 2.MongoDB分片集群 先关闭服务,创建密钥文件,修改配 ...

- Mongodb副本集+分片集群环境部署记录

前面详细介绍了mongodb的副本集和分片的原理,这里就不赘述了.下面记录Mongodb副本集+分片集群环境部署过程: MongoDB Sharding Cluster,需要三种角色: Shard S ...

- mongoDB副本集+分片集群

首先搭建一个副本集(三台机器) 主,从,仲裁 然后搭建分片shard1,在每台机子上启用shard1(这里就写一个分片吧!!如果写多了怕初学者会混乱,先写一个.然后可以按照同样的方法写第二个,第三个) ...

- 【七】MongoDB管理之分片集群介绍

分片是横跨多台主机存储数据记录的过程,它是MongoDB针对日益增长的数据需求而采用的解决方案.随着数据的快速增长,单台服务器已经无法满足读写高吞吐量的需求.分片通过水平扩展的方式解决了这个问题.通过 ...

- MySQL+MGR 单主模式和多主模式的集群环境 - 部署手册 (Centos7.5)

MySQL Group Replication(简称MGR)是MySQL官方于2016年12月推出的一个全新的高可用与高扩展的解决方案.MGR是MySQL官方在5.7.17版本引进的一个数据库高可用与 ...

- kafka 基础知识梳理及集群环境部署记录

一.kafka基础介绍 Kafka是最初由Linkedin公司开发,是一个分布式.支持分区的(partition).多副本的(replica),基于zookeeper协调的分布式消息系统,它的最大的特 ...

- Centos7下ELK+Redis日志分析平台的集群环境部署记录

之前的文档介绍了ELK架构的基础知识,日志集中分析系统的实施方案:- ELK+Redis- ELK+Filebeat - ELK+Filebeat+Redis- ELK+Filebeat+Kafka+ ...

- centos6.5环境下zookeeper-3.4.6集群环境部署及单机部署详解

centos6.5环境下Zookeeper-3.4.6集群环境部署 [系统]Centos 6.5 集群部署 [软件]准备好jdk环境,此次我们的环境是open_jdk1.8.0_101 zookeep ...

- kubernetes学习与实践篇(二) kubernetes1.5 的安装和集群环境部署

kubernetes 1.5 的安装和集群环境部署 文章转载自:http://www.cnblogs.com/tynia/p/k8s-cluster.html 简介: Docker:是一个开源的应用容 ...

随机推荐

- SQL SERVER 2008 bug

我把一个数据的数据导入的到另外一个数据库 作为 测试库使用. 发现里面设置为唯一标识ID 自动增长的表 全部默认是否. 最后只能手动一个个 表全部改过来. 弄了好久才发现这个问题.浪费了我几个小时的 ...

- P1194 买礼物

题目描述 又到了一年一度的明明生日了,明明想要买B样东西,巧的是,这B样东西价格都是A元. 但是,商店老板说最近有促销活动,也就是: 如果你买了第I样东西,再买第J样,那么就可以只花K[I,J]元,更 ...

- 《c程序设计语言》-3.2 字符串转换

#include <stdio.h> #define Num 1000 int main() { int i = 0,j,k,count2 = 0; char s[Num] = {'\0' ...

- 通过CLI命令将ESXi主机进入维护模式

将主机置于维护模式# vimsh -n -e /hostsvc/maintenance_mode_enter # vim-cmd /hostsvc/maintenance_mode_enter 退出维 ...

- ajax数据读取和绑定

如何进行ajax数据读取和绑定呢? 首先创建一个AJAX对象 实现数据绑定 实现隔行变色 编写表格排序的方法(实现按照年龄这一列进行排序) 通过文档碎片,把排序后的最新顺序,重新添加到tBody中(通 ...

- BZOJ 1492 [NOI2007] - cash

Description 最初你有 S 块钱, 有 N 天给你来兑换货币, 求最大获利. 一共只有两种货币 A , B . 对于每一天, 给定 3 个系数 A[i], B[i], Rate[i] A[i ...

- 知问前端——对话框UI(二)

dialog()方法的事件 除了属性设置外,dialog()方法也提供了大量的事件,这些事件可以给各种不同状态时的对话框提供回调函数,这些回调函数中的this值等于对话框内容的div对象,不是整个对话 ...

- C# 技巧收藏

IIS HTTP Error 500.21 - Internal Server Error 原因:在安装Framework v4.0之后,再启用IIS,导致Framework没有完全安装 解决:开始- ...

- 《Linux命令行与shell脚本编程大全 第3版》Shell脚本编程基础---57

以下为阅读<Linux命令行与shell脚本编程大全 第3版>的读书笔记,为了方便记录,特地与书的内容保持同步,特意做成一节一次随笔,特记录如下:

- UVA 10985 Rings'n'Ropes

最短路 参考了Staingger的博客 感觉DP的状态记录还是有毛病.可以DFS寻找结果也. #include <map> #include <set> #include &l ...