demo1 spark streaming 接收 kafka 数据java代码WordCount示例

1. 首先启动zookeeper

windows上的安装见zk 02之 Windows安装和使用zookeeper

启动后见:

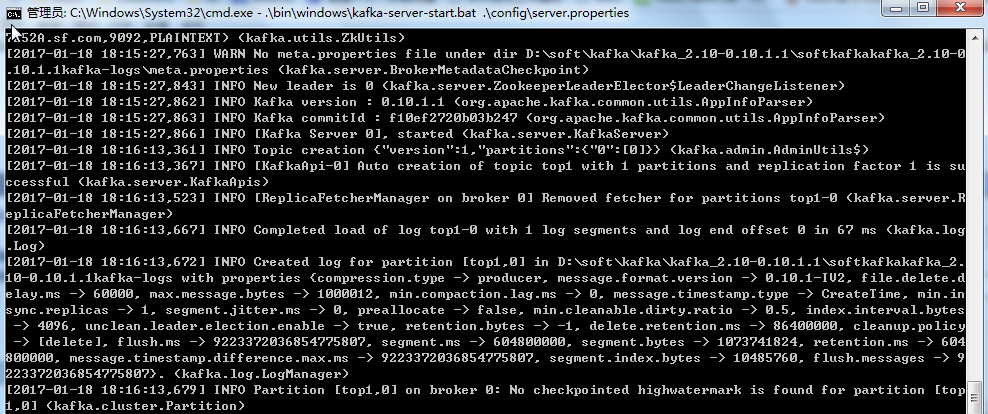

2. 启动kafka

windows的安装kafka见Windows上搭建Kafka运行环境,启动后如下图:

3. 核心代码

生产者生产消息的java代码,生成要统计的单词

package com.sf.omcstest; import java.util.Properties; import kafka.javaapi.producer.Producer;

import kafka.producer.KeyedMessage;

import kafka.producer.ProducerConfig; public class MyProducer { public static void main(String[] args) {

Properties props = new Properties();

props.setProperty("metadata.broker.list","localhost:9092");

props.setProperty("serializer.class","kafka.serializer.StringEncoder");

props.put("request.required.acks","1");

ProducerConfig config = new ProducerConfig(props);

//创建生产这对象

Producer<String, String> producer = new Producer<String, String>(config);

//生成消息

KeyedMessage<String, String> data1 = new KeyedMessage<String, String>("top1","test kafka");

KeyedMessage<String, String> data2 = new KeyedMessage<String, String>("top2","hello world");

try {

int i =1;

while(i < 1000){

//发送消息

producer.send(data1);

producer.send(data2);

System.out.println("put in kafka " + i);

i++;

Thread.sleep(1000);

}

} catch (Exception e) {

e.printStackTrace();

}

producer.close();

}

}

在SparkStreaming中接收指定话题的数据,对单词进行统计

package com.sf;

import java.util.HashMap;

import java.util.Iterator;

import java.util.Map;

import java.util.regex.Pattern; import org.apache.spark.*;

import org.apache.spark.api.java.function.*;

import org.apache.spark.streaming.*;

import org.apache.spark.streaming.api.java.JavaDStream;

import org.apache.spark.streaming.api.java.JavaPairDStream;

import org.apache.spark.streaming.api.java.JavaPairReceiverInputDStream;

import org.apache.spark.streaming.api.java.JavaStreamingContext;

import org.apache.spark.streaming.kafka.KafkaUtils; import scala.Tuple2; import com.google.common.collect.Lists;

public class KafkaStreamingWordCount { public static void main(String[] args) throws InterruptedException {

//设置匹配模式,以空格分隔

final Pattern SPACE = Pattern.compile(" ");

//接收数据的地址和端口

String zkQuorum = "localhost:2181";

//话题所在的组

String group = "1";

//话题名称以“,”分隔

String topics = "top1,top2";

//每个话题的分片数

int numThreads = 2; //Spark Streaming程序以StreamingContext为起点,其内部维持了一个SparkContext的实例。

// 这里我们创建一个带有两个本地线程(local[2])的StreamingContext,并设置批处理间隔为1秒

SparkConf sparkConf = new SparkConf().setAppName("KafkaWordCount").setMaster("local[2]");

JavaStreamingContext jssc = new JavaStreamingContext(sparkConf, new Duration(10000)); // 在一个Spark应用中默认只允许有一个SparkContext,默认地spark-shell已经为我们创建好了

// SparkContext,名为sc。因此在spark-shell中应该以下述方式创建StreamingContext,以

// 避免创建再次创建SparkContext而引起错误:

// val ssc = new StreamingContext(sc, Seconds(1)) //jssc.checkpoint("checkpoint"); //设置检查点

//存放话题跟分片的映射关系

Map<String, Integer> topicmap = new HashMap<>();

String[] topicsArr = topics.split(",");

int n = topicsArr.length;

for(int i=0;i<n;i++){

topicmap.put(topicsArr[i], numThreads);

}

//从Kafka中获取数据转换成RDD

JavaPairReceiverInputDStream<String, String> lines = KafkaUtils.createStream(jssc, zkQuorum, group, topicmap);

//从话题中过滤所需数据

JavaDStream<String> words = lines.flatMap(new FlatMapFunction<Tuple2<String, String>, String>() { @Override

public Iterator<String> call(Tuple2<String, String> arg0)

throws Exception {

return Lists.newArrayList(SPACE.split(arg0._2)).iterator();

}

});

//对其中的单词进行统计

JavaPairDStream<String, Integer> wordCounts = words.mapToPair(

new PairFunction<String, String, Integer>() {

@Override

public Tuple2<String, Integer> call(String s) {

return new Tuple2<String, Integer>(s, 1);

}

}).reduceByKey(new Function2<Integer, Integer, Integer>() {

@Override

public Integer call(Integer i1, Integer i2) {

return i1 + i2;

}

});

//打印结果

wordCounts.print(); // 执行完上面代码,Spark Streaming并没有真正开始处理数据,而只是记录需在数据上执行的操作。

// 当我们设置好所有需要在数据上执行的操作以后,我们就可以开始真正地处理数据了。如下:

jssc.start(); // 开始计算

jssc.awaitTermination(); // 等待计算终止 } }

结果:

017-01-18 18:32:27,800 WARN org.apache.spark.storage.BlockManager.logWarning(Logging.scala:66) - Block input-0-1484735547600 replicated to only 0 peer(s) instead of 1 peers

2017-01-18 18:32:28,801 WARN org.apache.spark.storage.BlockManager.logWarning(Logging.scala:66) - Block input-0-1484735548600 replicated to only 0 peer(s) instead of 1 peers

2017-01-18 18:32:29,801 WARN org.apache.spark.storage.BlockManager.logWarning(Logging.scala:66) - Block input-0-1484735549600 replicated to only 0 peer(s) instead of 1 peers

-------------------------------------------

Time: 1484735550000 ms

-------------------------------------------

(hello,10)

(kafka,10)

(test,10)

(world,10)

master URL

配置conf/spark-env.sh 是配置spark的standalone环境,类似于hadoop配置hdfs环境一样。但是部署程序时仍然需要指定master的位置。

如果选择的部署模式是standalone且部署到你配置的这个集群上,可以指定 MASTER=spark://ubuntu:7070

下面解答spark在那里指定master URL的问题:

1.通过spark shell,执行后进入交互界面

MASTER=spark://IP:PORT ./bin/spark-shell

2.程序内指定(可以通过参数传入)

val conf = new SparkConf()

.setMaster(...)

val sc = new SparkContext(conf)

传递给spark的master url可以有如下几种:

local 本地单线程

local[K] 本地多线程(指定K个内核)

local[*] 本地多线程(指定所有可用内核)

spark://HOST:PORT 连接到指定的 Spark standalone cluster master,需要指定端口。

mesos://HOST:PORT 连接到指定的 Mesos 集群,需要指定端口。

yarn-client客户端模式 连接到 YARN 集群。需要配置 HADOOP_CONF_DIR。

yarn-cluster集群模式 连接到 YARN 集群 。需要配置 HADOOP_CONF_DIR。

spark1.0起的版本在提交程序到集群有很大的不同,需要注意:

./bin/spark-submit \

--class <main-class>

--master <master-url> \

--deploy-mode <deploy-mode> \

... # other options

<application-jar> \

[application-arguments]

例如:

# Run application locally on 8 cores

./bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[] \

/path/to/examples.jar \

100 # Run on a Spark standalone cluster

./bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://207.184.161.138:7077 \

--executor-memory 20G \

--total-executor-cores 100 \

/path/to/examples.jar \

1000 # Run on a YARN cluster

export HADOOP_CONF_DIR=XXX

./bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn-cluster \ # can also be `yarn-client` for client mode

--executor-memory 20G \

--num-executors 50 \

/path/to/examples.jar \

1000 # Run a Python application on a cluster

./bin/spark-submit \

--master spark://207.184.161.138:7077 \

examples/src/main/python/pi.py \

1000

更多关于spark-submit见《spark提交模式》

demo1 spark streaming 接收 kafka 数据java代码WordCount示例的更多相关文章

- spark streaming 接收 kafka 数据java代码WordCount示例

http://www.cnblogs.com/gaopeng527/p/4959633.html

- Spark Streaming接收Kafka数据存储到Hbase

Spark Streaming接收Kafka数据存储到Hbase fly spark hbase kafka 主要参考了这篇文章https://yq.aliyun.com/articles/60712 ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十二)Spark Streaming接收流数据及使用窗口函数

官网文档:<http://spark.apache.org/docs/latest/streaming-programming-guide.html#a-quick-example> Sp ...

- spark streaming 接收kafka消息之四 -- 运行在 worker 上的 receiver

使用分布式receiver来获取数据使用 WAL 来实现 exactly-once 操作: conf.set("spark.streaming.receiver.writeAheadLog. ...

- spark streaming 接收kafka消息之五 -- spark streaming 和 kafka 的对接总结

Spark streaming 和kafka 处理确保消息不丢失的总结 接入kafka 我们前面的1到4 都在说 spark streaming 接入 kafka 消息的事情.讲了两种接入方式,以及s ...

- spark streaming 接收kafka消息之二 -- 运行在driver端的receiver

先从源码来深入理解一下 DirectKafkaInputDStream 的将 kafka 作为输入流时,如何确保 exactly-once 语义. val stream: InputDStream[( ...

- spark streaming 接收kafka消息之一 -- 两种接收方式

源码分析的spark版本是1.6. 首先,先看一下 org.apache.spark.streaming.dstream.InputDStream 的 类说明: This is the abstrac ...

- Spark Streaming与kafka整合实践之WordCount

本次实践使用kafka console作为消息的生产者,Spark Streaming作为消息的消费者,具体实践代码如下 首先启动kafka server .\bin\windows\kafka-se ...

- spark streaming 接收kafka消息之三 -- kafka broker 如何处理 fetch 请求

首先看一下 KafkaServer 这个类的声明: Represents the lifecycle of a single Kafka broker. Handles all functionali ...

随机推荐

- 【P1369】矩形(贪心)

蒟蒻现在连DP都做不出来了,就只能做一些XJB贪心题,这个题题目向非常友好,100的数据范围一看就是让你跑O(n^4)的做法的,然而实际上并不是那么多,大约是,额,反正要快不少. 没什么好说的,直接枚 ...

- CF697E && CF696C PLEASE

题意:给你三个杯子,一开始钥匙放在中间的杯子里,然后每一回合等概率将左右两个杯子中的一个与中间杯子交换.求n回合之后钥匙在中间杯子的概率.这里要求概率以分数形式输出,先化成最简,然后对1e9 + 7取 ...

- Caused by: org.apache.ibatis.reflection.ReflectionException: There is no getter for property named 'company' in 'class java.lang.String'

Caused by: org.apache.ibatis.reflection.ReflectionException: There is no getter for property named ' ...

- odl v2 driver

networking-odl项目的目的/用途就是sync odl和neutron的资源数据库和状态 v1中对于每个neutron的资源操作都相应的调用odl restfu api来同步odl,但问题有 ...

- iOS音频掌柜-- AVAudioSession

音频输出作为硬件资源,对于iOS系统来说是唯一的,那么要如何协调和各个App之间对这个稀缺的硬件持有关系呢? iOS给出的解决方案是"AVAudioSession" ,通过它可以实 ...

- 51nod 1732 LCS变形

http://www.51nod.com/onlineJudge/questionCode.html#!problemId=1732 1732 51nod婚姻介绍所 题目来源: 原创 基准时间限制:1 ...

- Amazon EMR(Elastic MapReduce):亚马逊Hadoop托管服务运行架构&Hadoop云服务之战:微软vs.亚马逊

http://s3tools.org/s3cmd Amazon Elastic MapReduce (Amazon EMR)简介 Amazon Elastic MapReduce (Amazon EM ...

- 强大的表格控件handsometable,结合vue

handsontable handsontable是目前在前端界最接近excel的插件,可以执行编辑,复制粘贴,插入删除行列,排序等复杂操作.jQuery.react.ng和vue版本,功能强大,是复 ...

- python3.x学习笔记2018-02-05更新

前言:python3.x部分学习笔记,有意交流学习者可加wechat:YWNlODAyMzU5MTEzMTQ=.如果笔记内容有错,请指出来. 对数据类型的操作 可变数据类型:列表,集合,字典 列表: ...

- sass语法(1)

文件后缀名 sass有两种后缀名文件:一种后缀名为sass,不使用大括号和分号:另一种就是我们这里使用的scss文件,这种和我们平时写的css文件格式差不多,使用大括号和分号 //文件后缀名为sass ...