003.Ceph扩展集群

一 基础准备

二 扩展集群

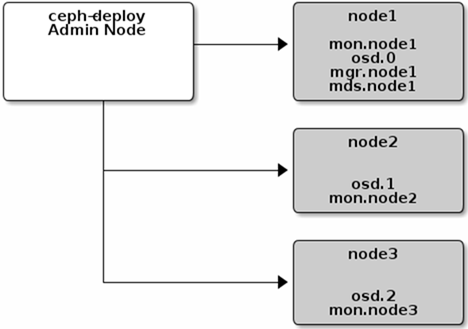

2.1 扩展架构

2.2 添加元数据(metadata)服务器

[manager@deploy my-cluster]$ ceph-deploy mds create node1

2.3 添加监视(Monitor)服务器

[manager@deploy my-cluster]$ ceph-deploy mon add node2

[manager@deploy my-cluster]$ ceph-deploy mon add node3

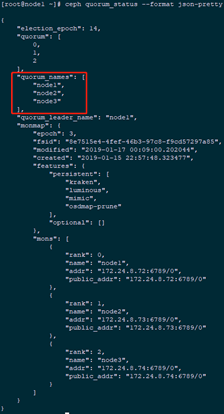

[root@node1 ~]# ceph quorum_status --format json-pretty #查看仲裁(quorum)状态信息

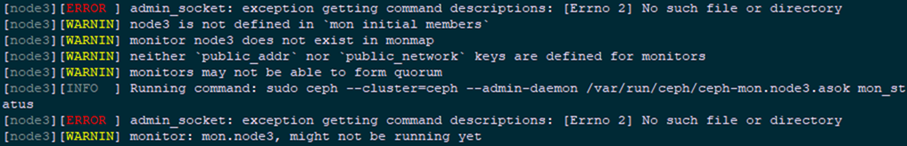

[manager@deploy my-cluster]$ vi ceph.conf

[global]

#……

public_network = 172.24.8.0/24

[manager@deploy my-cluster]$ ceph-deploy --overwrite-conf mon add node2

[manager@deploy my-cluster]$ ceph-deploy --overwrite-conf mon add node3

2.4 添加管理员

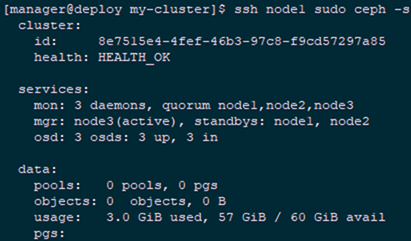

[manager@deploy my-cluster]$ ceph-deploy mgr create node2 node3

[manager@deploy my-cluster]$ ssh node1 sudo ceph -s #查看验证

2.5 添加RGW

[manager@deploy my-cluster]$ ceph-deploy rgw create node1

三 客户端存储示例

3.1 创建pool

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd pool create mytest 64

[manager@deploy my-cluster]$ ssh node1 sudo rados lspools

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd lspools

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd dump | grep pool

3.2 客户端模拟

[root@node3 ~]# echo 'This is my test file!' >> test.txt #创建模拟文件

[root@node3 ~]# rados put test-object-1 test.txt --pool=mytest

3.3 查看确认

[manager@deploy my-cluster]$ ssh node1 sudo rados -p mytest ls #查看存储的对

test-object-1

3.4 定位对象

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd map mytest test-object-1 #定位对象到相应的归置组

osdmap e30 pool 'mytest' (5) object 'test-object-1' -> pg 5.74dc35e2 (5.22) -> up ([2,1,0], p2) acting ([2,1,0], p2)

3.5 删除对象

[manager@deploy my-cluster]$ ssh node1 sudo rados rm test-object-1 --pool=mytest

3.6 删除pool

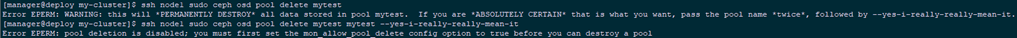

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd pool delete mytest

[manager@deploy my-cluster]$ ssh node1 sudo ceph osd pool delete mytest mytest --yes-i-really-really-mean-it

pool 'mytest' removed

[manager@deploy my-cluster]$ vi ceph.conf

[global]

#……

[mon]

mon allow pool delete = true #添加此行

[manager@deploy my-cluster]$ ceph-deploy --overwrite-conf config push node1 node2 node3 #重推一次配置文件

[root@node1 ~]# systemctl restart ceph-mon.target #所有节点均需要重启一次该服务

003.Ceph扩展集群的更多相关文章

- Ceph 存储集群

Ceph 存储集群 Ceph 作为软件定义存储的代表之一,最近几年其发展势头很猛,也出现了不少公司在测试和生产系统中使用 Ceph 的案例,尽管与此同时许多人对它的抱怨也一直存在.本文试着整理作者了解 ...

- 002.RHCS-配置Ceph存储集群

一 前期准备 [kiosk@foundation0 ~]$ ssh ceph@serverc #登录Ceph集群节点 [ceph@serverc ~]$ ceph health #确保集群状态正常 H ...

- Ceph 存储集群 - 搭建存储集群

目录 一.准备机器 二.ceph节点安装 三.搭建集群 四.扩展集群(扩容) 一.准备机器 本文描述如何在 CentOS 7 下搭建 Ceph 存储集群(STORAGE CLUSTER). 一共4 ...

- Ceph 存储集群5-数据归置

一.数据归置概览 Ceph 通过 RADOS 集群动态地存储.复制和重新均衡数据对象.很多不同用户因不同目的把对象存储在不同的存储池里,而它们都坐落于无数的 OSD 之上,所以 Ceph 的运营需要些 ...

- Ceph 存储集群1-配置:硬盘和文件系统、配置 Ceph、网络选项、认证选项和监控器选项

所有 Ceph 部署都始于 Ceph 存储集群.基于 RADOS 的 Ceph 对象存储集群包括两类守护进程: 1.对象存储守护进程( OSD )把存储节点上的数据存储为对象: 2.Ceph 监视器( ...

- ceph存储集群的应用

1.ceph存储集群的访问接口 1.1ceph块设备接口(RBD) ceph块设备,也称为RADOS块设备(简称RBD),是一种基于RADOS存储系统支持超配(thin-provisioned). ...

- Ceph 存储集群第一部分:配置和部署

内容来源于官方,经过个人实践操作整理,官方地址:http://docs.ceph.org.cn/rados/ 所有 Ceph 部署都始于 Ceph 存储集群. 基于 RADOS 的 Ceph 对象存储 ...

- Ceph 存储集群 - 搭建存储集群---教程走到osd激活这一步执行不下去了,报错

目录 一.准备机器 [1. 修改主机名](所有节点)(https://www.cnblogs.com/zengzhihua/p/9829472.html#1-修改主机名) [2. 修改hosts文件] ...

- Redis复制与可扩展集群搭建

抄自:http://www.infoq.com/cn/articles/tq-redis-copy-build-scalable-cluster 讨论了Redis的常用数据类型与存储机制,本文会讨论一 ...

随机推荐

- Confluence 6 管理协同编辑 - 最大编辑者的限制

我们限制为最多 12 个用户可以同时对一个页面进行编辑.这个意味着当一个页面已经有 12 个用户正在编辑了,13 个用户是不能进入编辑界面的,直到 12 个用户中有一个用户已经离开了. 系统管理员可以 ...

- Django框架第一篇基础

一个小问题: 什么是根目录:就是没有路径,只有域名..url(r'^$') 补充一张关于wsgiref模块的图片 一.MTV模型 Django的MTV分别代表: Model(模型):和数据库相关的,负 ...

- LeetCode(105):从前序与中序遍历序列构造二叉树

Medium! 题目描述: 根据一棵树的前序遍历与中序遍历构造二叉树. 注意:你可以假设树中没有重复的元素. 例如,给出 前序遍历 preorder = [3,9,20,15,7] 中序遍历 inor ...

- Vue 导入文件import、路径@和.的区别

***import: html文件中,通过script标签引入js文件.而vue中,通过import xxx from xxx路径的方式导入文件,不光可以导入js文件. from前的:“xxx”指的是 ...

- Django中各目录文件的作用

一般的项目结构如下(大同小异) my_site是一个项目,blog是项目下的应用之一,可以使用创建命令创建更多的应用. 最上层的django文件夹: 自己手动创建,名字随意. 第二层my_site文件 ...

- Appium Desired Capabilities

Appium Desired Capabilities Desired Capabilities 是由 keys 和 values 组成的 JSON 对象. 举个简单例子: { "platf ...

- RabbitMQ疑惑释义

MQ全称为Message Queue, 消息队列(MQ)是一种应用程序对应用程序的通信方法.应用程序通过读写出入队列的消息(针对应用程序的数据)来通信,而无需专用连接来链接它们.消息传递指的是程序之间 ...

- 纯css3实现的switch开关按钮

效果如图 <p> <label><input class="mui-switch mui-switch-anim" type="checkb ...

- Caused by: java.lang.ClassNotFoundException: Didn't find class "io.grpc.helloworldexample.HelloworldActivity" on path: DexPathList

FAQ: Android app 编译好后安装到手机,运行时闪退,报如下错误: java.lang.RuntimeException: Unable to instantiate activity ...

- 调整Windows操作系统下时间同步的频率

今天发现时间不对,同步时间后看到Windows系统默认是一周才同步一次时间,频率太低了.查找了一下资料,找到了两种调整Win7时间同步频率的方法. 方法一:注册表法 这种方法是通过修改注册表中的键值来 ...