Hadoop日志文件分析系统

Hadoop日志分析系统

项目需求:

需要统计一下线上日志中某些信息每天出现的频率,举个简单的例子,统计线上每天的请求总数和异常请求数。线上大概几十台

服务器,每台服务器大概每天产生4到5G左右的日志,假设有30台,每台5G的,一天产生的日志总量为150G。

处理方案:

方案1:传统的处理方式,写个JAVA日志分析代码,部署到每台服务器进行处理,这种方式部署起来耗时费力,又不好维护。

方案2:采用Hadoop分布式处理,日志分析是Hadoop集群系统的拿手好戏。150G每天的日志也算是比较大的数据量了,搭个简

单的Hadoop集群来处理这些日志是再好不过的了。

Hadoop集群的搭建:

参见这两篇文章:http://www.cnblogs.com/cstar/archive/2012/12/16/2820209.html

http://www.cnblogs.com/cstar/archive/2012/12/16/2820220.html

我们这里的集群就采用了两台机器,配置每台8核,32G内存,500G磁盘空间。

日志准备工作:

由于日志分散在各个服务器,所以我们先需要将所有的日志拷贝到我们的集群系统当中,这个可以通过linux服务器下rsync或者scp

服务来执行。这里我们通过scp服务来拷贝,由于都是内网的机器,所以拷贝几个G的日志可以很快就完成。下面是拷贝日志的脚本,脚本

还是有一些需要注意的地方,我们只需要拷贝前一天的数据,实际保存的数据可能是好几天的,所以我们只要把我们需要的这一天的数据

SCP过去就可以了。

#!/bin/sh

workdir=/home/myproj/bin/log/

files=`ls $workdir`

pre1date=`date +"%Y%m%d" -d "-1 days"`

pre1date1=`date +"%Y-%m-%d" -d "-1 days"`

curdate=`date +"%Y%m%d"`

hostname=`uname -n`

echo $pre1date $curdate

uploadpath="/home/hadoop/hadoop/mytest/log/"$pre1date1"/"$hostname

echo $uploadpath

cd $workdir

mintime=240000

secondmintime=0

for file in $files;do

filedate=`stat $file | grep Modify| awk '{print $2}' |sed -e 's/-//g'`

filetime=`stat $file | grep Modify| awk '{print $3}' |cut -d"." -f1 | sed -e 's/://g'| sed 's/^0\+//'`

if [ $filedate -eq $curdate ]; then

if [ $filetime -lt $mintime ]; then

secondmintime=$mintime

mintime=$filetime

fi

fi

done

echo "mintime:"$mintime

step=1000

mintime=`expr $mintime + $step`

echo "mintime+1000:"$mintime

for file in $files;do

filedate=`stat $file | grep Modify| awk '{print $2}' |sed -e 's/-//g'`

filetime=`stat $file | grep Modify| awk '{print $3}' |cut -d"." -f1 | sed -e 's/://g'| sed 's/^0\+//'`

filename=`echo $file | cut -c 1-8`

startchars="info.log"

#echo $filename

if [ $filename == $startchars ]; then

if [ $filedate -eq $pre1date ]; then

scp -rp $file dir@antix2:$uploadpath

#echo $file

elif [ $filedate -eq $curdate ]; then

if [ $filetime -lt $mintime ]; then

scp -rp $file dir@antix2:$uploadpath

#echo $file

fi

fi

fi

#echo $filedate $filetime

done

MapReduce代码

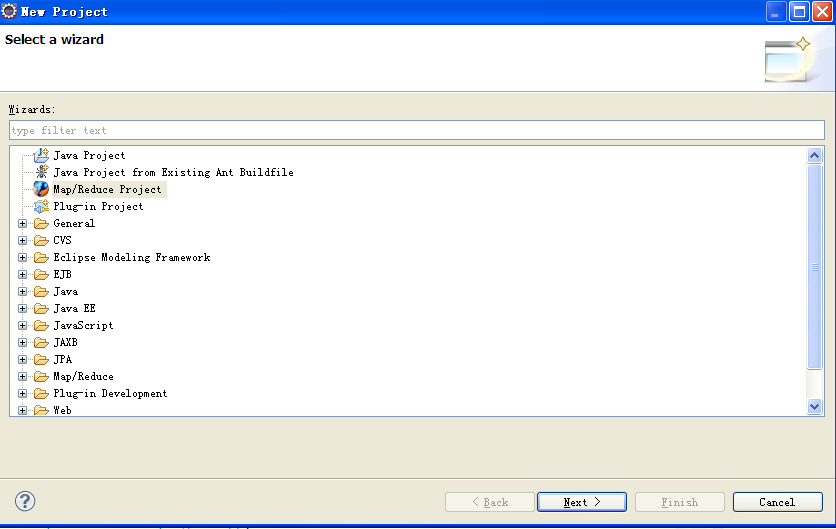

接下来就是编写MapReduce的代码了。使用Eclipse环境来编写,需要安装hadoop插件,我们hadoop机器采用的是1.1.1版本,所以插

件使用hadoop-eclipse-plugin-1.1.1.jar,将插件拷贝到eclipse的plugins目录下就可以了。然后新建一个MapReduce项目:

工程新建好了然后我们就可以编写我们的MapReduce代码了。

import java.io.IOException;

import java.text.SimpleDateFormat;

import java.util.Date; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser; public class LogAnalysis { public static class LogMapper

extends Mapper<LongWritable, Text, Text, IntWritable>{ private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

private Text hourWord = new Text();

public void map(LongWritable key, Text value, Context context

) throws IOException, InterruptedException {

String line = value.toString();

SimpleDateFormat formatter2 = new SimpleDateFormat("yy-MM-dd");

java.util.Date d1 =new Date();

d1.setTime(System.currentTimeMillis()-1*24*3600*1000);

String strDate =formatter2.format(d1);

if(line.contains(strDate)){

String[] strArr = line.split(",");

int len = strArr[0].length();

String time = strArr[0].substring(1,len-1); String[] timeArr = time.split(":");

String strHour = timeArr[0];

String hour = strHour.substring(strHour.length()-2,strHour.length());

String hourKey = "";

if(line.contains("StartASocket")){

word.set("SocketCount");

context.write(word, one);

hourKey = "SocketCount:" + hour;

hourWord.set(hourKey);

context.write(hourWord, one);

word.clear();

hourWord.clear();

}

if(line.contains("SocketException")){

word.set("SocketExceptionCount");

context.write(word, one);

hourKey = "SocketExceptionCount:" + hour;

hourWord.set(hourKey);

context.write(hourWord, one);

word.clear();

hourWord.clear();

}

}

} public static class LogReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static int run(String[] args) throws Exception{ Configuration conf = new Configuration();

String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs();

if (otherArgs.length != 2) {

System.err.println("Usage: loganalysis <in> <out>");

System.exit(2);

}

FileSystem fileSys = FileSystem.get(conf);

String inputPath = "input/" + args[0];

fileSys.copyFromLocalFile(new Path(args[0]), new Path(inputPath));//将本地文件系统的文件拷贝到HDFS中

Job job = new Job(conf, "loganalysis");

job.setJarByClass(LogAnalysis.class);

job.setMapperClass(LogMapper.class);

job.setCombinerClass(LogReducer.class);

job.setReducerClass(LogReducer.class);

// 设置输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(inputPath));

FileOutputFormat.setOutputPath(job, new Path(otherArgs[1])); Date startTime = new Date();

System.out.println("Job started: " + startTime);

int ret = job.waitForCompletion(true)? 0 : 1;

fileSys.copyToLocalFile(new Path(otherArgs[1]), new Path(otherArgs[1]));

fileSys.delete(new Path(inputPath), true);

fileSys.delete(new Path(otherArgs[1]), true); Date end_time = new Date();

System.out.println("Job ended: " + end_time);

System.out.println("The job took " + (end_time.getTime() - startTime.getTime()) /1000 + " seconds.");

return ret;

} public static void main(String[] args)

{

try

{

int ret = run(args);

System.exit(ret);

} catch (Exception e)

{

e.printStackTrace();

System.out.println(e.getMessage());

}

}

}

部署到Hadoop集群:

代码完成后测试没有问题后,部署到集群当中去执行,我们有几十台服务器,所以每台的服务器的日志当成一个任务来执行。

workdir="/home/hadoop/hadoop/mytest"

cd $workdir

pre1date=`date +"%Y-%m-%d" -d "-1 days"`

servers=(mach1 mach2 mach3 )

for i in ${servers[@]};do

inputPath="log/"$pre1date"/"$i

outputPath="output/log/"$pre1date"/"$i

echo $inputPath $outputPath

echo "start job "$i" date:"`date`

hadoop jar LogAnalysis.jar loganalysis $inputPath $outputPath

echo "end job "$i" date:"`date`

done

Hadoop日志文件分析系统的更多相关文章

- [转载]mysql慢日志文件分析处理

原文地址:mysql慢日志文件分析处理作者:maxyicha mysql有一个功能就是可以log下来运行的比较慢的sql语句,默认是没有这个log的,为了开启这个功能,要修改my.cnf或者在mysq ...

- /VAR/LOG/各个日志文件分析

/VAR/LOG/各个日志文件分析 author:headsen chen 2017-10-24 18:00:24 部分内容取自网上搜索,部分内容为自己整理的,特此声明. 1. /v ...

- 用ELK搭建简单的日志收集分析系统【转】

缘起 在微服务开发过程中,一般都会利用多台服务器做分布式部署,如何能够把分散在各个服务器中的日志归集起来做分析处理,是一个微服务服务需要考虑的一个因素. 搭建一个日志系统 搭建一个日志系统需要考虑一下 ...

- Linux下日志文件监控系统Logwatch的使用记录

Linux下日志文件监控系统Logwatch的使用记录 原文:http://www.cnblogs.com/kevingrace/p/6519504.html 在维护Linux服务器时,经常需要查看系 ...

- Kubernetes-20:日志聚合分析系统—Loki的搭建与使用

日志聚合分析系统--Loki 什么是Loki? Loki 是 Grafana Labs 团队最新的开源项目,是一个水平可扩展,高可用性,多租户的日志聚合系统.它的设计非常经济高效且易于操作,因为它不会 ...

- Hadoop日志文件

初学者运行MapReduce作业时,经常会遇到各种错误,往往不知所云,一般直接将终端打印的错误贴到搜索引擎上查找,以借鉴前人的经验. 对于hadoop而言,当遇到错误时,第一时间应是查看日志,日志里通 ...

- Linux日志文件分析

---恢复内容开始--- 日志保存位置 默认 var/log目录下 主要日志文件 内核及公共消息日志:message 计划任务日志:cron 系统殷桃日志:demsg 邮件系统日志:maillog 用 ...

- 2018年ElasticSearch6.2.2教程ELK搭建日志采集分析系统(教程详情)

章节一 2018年 ELK课程计划和效果演示1.课程安排和效果演示 简介:课程介绍和主要知识点说明,ES搜索接口演示,部署的ELK项目演示 es: localhost:9200 k ...

- zipkin+elk微服务日志收集分析系统

docker安装elk日志分析系统 在win10上安装docker环境 tip:win7/8 win7.win8 系统 win7.win8 等需要利用 docker toolbox 来安装,国内可以使 ...

随机推荐

- org.hibernate.hql.ast.QuerySyntaxException: XXX is not mapped

因为 String sql2 = "select s from Student s where s.clazz.name=:name"; 此处的 Student 应该为类名.hql ...

- oracle 学习摘录

(1)oracle插入回车换行符 SQL>insert into A t(t.name) values('aaaaa'||chr(10)||chr(13)||'ccccc'); 已创建 1 行. ...

- hdu 小希的迷宫

真是被这道并查集的水题给坑哭了...忘记给uset数组初始化我也是醉了. 题目意思是找到判断是不是连通无环的图,首先想到的就是并查集. 1判断成环的时候,只要判断输入边的两个点.有一个共同的父节点,那 ...

- JS的Touch事件们,触屏时的js事件

丫的,终于找到了JS在平板电脑上的事件!!! iphone.ipod Touch.ipad触屏时的js事件 1.Touch事件简介 pc上的web页面鼠标会产生onmousedown.on ...

- 矩形的个数-nyoj206

描述在一个3*2的矩形中,可以找到6个1*1的矩形,4个2*1的矩形3个1*2的矩形,2个2*2的矩形,2个3*1的矩形和1个3*2的矩形,总共18个矩形.给出A,B,计算可以从中找到多少个矩形. ...

- //sql过滤关键字

//sql过滤关键字 public static bool CheckKeyWord(string sWord) { //过滤关键字 string StrKeyWord = @"select ...

- Android课程---Android Studio安装及使用

2013年Google I/O 大会首次发布了Android Studio IDE(Android平台集成开发环境).它基于Intellij IDEA 开发环境,旨在取代Eclipse和ADT(And ...

- File类的createNewFile()与createTempFile()的区别

最近,在看代码时看到了一个方法, File.createTempFile() ,由此联想到File.createNewFile() 方法,一时间不知道两者到底有什么区别,感觉都是创建新文件嘛,后来查看 ...

- dom4j解析xml文档&保存数据的乱码问题

package itcast.dom4j; import java.io.File; import java.io.FileOutputStream; import java.io.FileWrite ...

- SignalR in a WebSite Project

Question(http://stackoverflow.com/questions/19924678/signalr-in-a-website-project) I have a test we ...