scrapy实验1 爬取中国人寿官网新闻,保存为xml

一、scrapy 实验 爬中国人寿新闻,保存为xml

如需转发,请注明出处:小婷儿的python https://www.cnblogs.com/xxtalhr/p/10517297.html

链接:https://pan.baidu.com/s/1HeIbBuAWjk8uNRl7ZIXh-A

提取码:z3hh

1.1 代码结构

scrapy框架具体内容,请参考

1、scrapy(一)scrapy 安装问题 https://www.cnblogs.com/xxtalhr/p/9170437.html

2、Scrapy 框架(二)数据的持久化 https://www.cnblogs.com/xxtalhr/p/9164186.html

3、scrapy (三)各部分意义及框架示意图详解 https://www.cnblogs.com/xxtalhr/p/9170343.html

4、scrapy (四)基本配置 https://www.cnblogs.com/xxtalhr/p/9169484.html

5、scrapy shell https://www.cnblogs.com/xxtalhr/p/9158651.html

1.2 书写 spiders

# -*- coding: utf-8 -*-

import scrapy

import json class RrSpider(scrapy.Spider):

name = 'rr'

allowed_domains = ['www.chinalife.com.cn']

start_urls = ['https://www.chinalife.com.cn/chinalife/xwzx/gsxw/7934bcc5-%d.html' % (i) for i in range(1, 12)] def parse(self, response):

news = response.xpath('//div[@class="easysite-article-content"]/ul/li')

print('========================================', len(news))

items = []

fp = open('./xml-4.xml', 'a', encoding='utf-8')#打开文件,不用手动创建

for new in news:

new_date = new.xpath('./span/text()').extract()[0]

new_title = new.xpath('.//div/span/a/@title').extract_first()

new_info = new.xpath('.//div/a/span/text()').extract_first()

new_link = 'https://www.chinalife.com.cn/' + new.xpath('.//div/span/a/@href').extract_first()

item = {}

item['date'] = new_date

item['title'] = new_title

item['info'] = new_info

item['link'] = new_link fp.write(json.dumps(item))#写入文件 items.append(item)

print('+++++++++++++++++++++++++++++++', new_date, new_info, new_link, new_title,)

fp.close()

return items

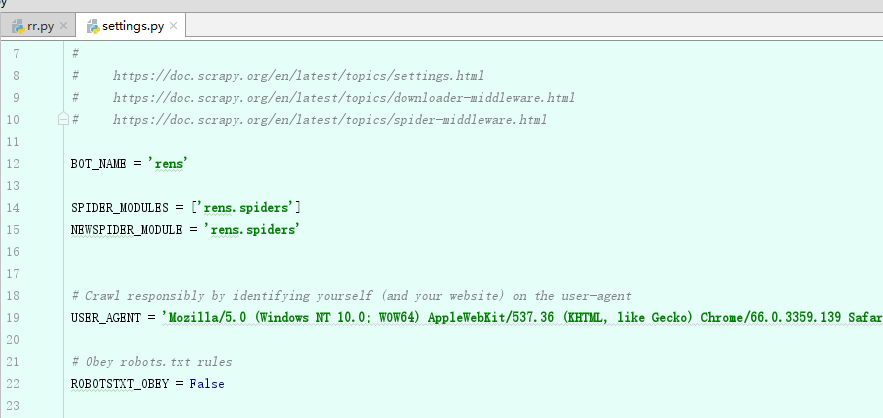

二、修改 setting中 USER_AGENT 和 ROBOTSTXT_OBEY

三、 终端 执行命令

scrapy crawl rr -o renshou.xml

# ('json', 'jsonlines', 'jl', 'csv', 'xml', 'marshal', 'pickle')

欢迎关注小婷儿的博客:

csdn:https://blog.csdn.net/u010986753

博客园:http://www.cnblogs.com/xxtalhr/

有问题请在博客下留言或加作者微信:tinghai87605025 或 QQ :87605025

python QQ交流群:py_data 483766429

OCP培训说明连接:https://mp.weixin.qq.com/s/2cymJ4xiBPtTaHu16HkiuA

OCM培训说明连接:https://mp.weixin.qq.com/s/7-R6Cz8RcJKduVv6YlAxJA

小婷儿的python正在成长中,其中还有很多不足之处,随着学习和工作的深入,会对以往的博客内容逐步改进和完善哒。

重要的事多做几遍。。。。。。

scrapy实验1 爬取中国人寿官网新闻,保存为xml的更多相关文章

- 爬虫之爬取斗鱼官网LOL部分主播的状态

一个爬虫小程序 爬取主播的排名及观看人数 import re import requests import request class Spider(): url = 'https://www.dou ...

- 实战爬取Plati官网游戏实时最低价格-Python

需要修改url中的id_r="这个",这个id需要从Battlefield V (plati.ru)中获取,其实也是这个链接中的#s24235. 配合了e-mail推送,其实这个e ...

- Scrapy实战篇(一)之爬取链家网成交房源数据(上)

今天,我们就以链家网南京地区为例,来学习爬取链家网的成交房源数据. 这里推荐使用火狐浏览器,并且安装firebug和firepath两款插件,你会发现,这两款插件会给我们后续的数据提取带来很大的方便. ...

- Python Scrapy 爬取煎蛋网妹子图实例(一)

前面介绍了爬虫框架的一个实例,那个比较简单,这里在介绍一个实例 爬取 煎蛋网 妹子图,遗憾的是 上周煎蛋网还有妹子图了,但是这周妹子图变成了 随手拍, 不过没关系,我们爬图的目的是为了加强实战应用,管 ...

- Python的scrapy之爬取顶点小说网的所有小说

闲来无事用Python的scrapy框架练练手,爬取顶点小说网的所有小说的详细信息. 看一下网页的构造: tr标签里面的 td 使我们所要爬取的信息 下面是我们要爬取的二级页面 小说的简介信息: 下面 ...

- 使用 Scrapy 爬取去哪儿网景区信息

Scrapy 是一个使用 Python 语言开发,为了爬取网站数据,提取结构性数据而编写的应用框架,它用途广泛,比如:数据挖掘.监测和自动化测试.安装使用终端命令 pip install Scrapy ...

- 爬取西刺网的免费IP

在写爬虫时,经常需要切换IP,所以很有必要自已在数据维护库中维护一个IP池,这样,就可以在需用的时候随机切换IP,我的方法是爬取西刺网的免费IP,存入数据库中,然后在scrapy 工程中加入tools ...

- python爬虫基础应用----爬取校花网视频

一.爬虫简单介绍 爬虫是什么? 爬虫是首先使用模拟浏览器访问网站获取数据,然后通过解析过滤获得有价值的信息,最后保存到到自己库中的程序. 爬虫程序包括哪些模块? python中的爬虫程序主要包括,re ...

- selenium爬取煎蛋网

selenium爬取煎蛋网 直接上代码 from selenium import webdriver from selenium.webdriver.support.ui import WebDriv ...

随机推荐

- git常用命令以及如何与fork别人的仓库保持同步

简单常用命令1.git status查看当前仓库是否有文件改动a:提示Your branch is up-to-date with 'origin/master'.nothing to commit, ...

- Python全栈学习_day005知识点

今日内容大纲: . 字典的增删改查以及其他操作 . 字典的嵌套 . 字典的增删改查以及其他操作 , 'sex': '男'}, 'name_list': ['无双', 'alex', 'BlameK'] ...

- SP8093 JZPGYZ - Sevenk Love Oimaster(广义后缀自动机)

题意 题目链接 Sol 广义后缀自动机板子题..和BZOJ串那个题很像 首先建出询问串的SAM,然后统计一下每个节点被多少个串包含 最后直接拿询问串上去跑就行了 #include<bits/st ...

- 【代码笔记】Web-ionic-安装及第一个app

一,下载ionic v1.0.1版本,下载地址为:ionic-v1.0.1.zip. ionic 最新版本下载地址:http://ionicframework.com/docs/overview/#d ...

- 微信小程序/网站 上传图片到腾讯云COS

COS简介: 腾讯云提供的一种对象存储服务,供开发者存储海量文件的分布式存储服务.可以将自己开发的应用的存储部分全部接入COS的存储桶中,有效减少应用服务器的带宽,请求等.个人也可以通过腾讯云账号免费 ...

- python自动化开发-7

socket编程 Socket是应用层与TCP/IP协议族通信的中间软件抽象层,它是一组接口.在设计模式中,Socket其实就是一个门面模式,它把复杂的TCP/IP协议族隐藏在Socket接口后面,对 ...

- python txt文件数据转excel

txt content: perf.txt 2018-11-12 16:48:58 time: 16:48:58 load average: 0.62, 0.54, 0.56 mosquitto CP ...

- scrapy之spider模块

scrapy中的spider的用法 : 1.scrapy命令行可以传参数给构造器 scrapy crawl myspider -a category=electronics 构造器接收传入的参数 im ...

- EasyUI datagrid.getSelections 没有返回正确的选择行数

Actually i solved the problem. It was because the idField of the table i was using was incorrect. it ...

- Linux的命名空间详解--Linux进程的管理与调度(二)【转】

Linux Namespaces机制提供一种资源隔离方案. PID,IPC,Network等系统资源不再是全局性的,而是属于特定的Namespace.每个Namespace里面的资源对其他Namesp ...