图解GNN:A Gentle Introduction to Graph Neural Networks

1.图是什么?

本文给出得图的定义为:A graph represents the relations (edges) between a collection of entities (nodes).

即:图表示实体(节点)集合之间的关系(边)。

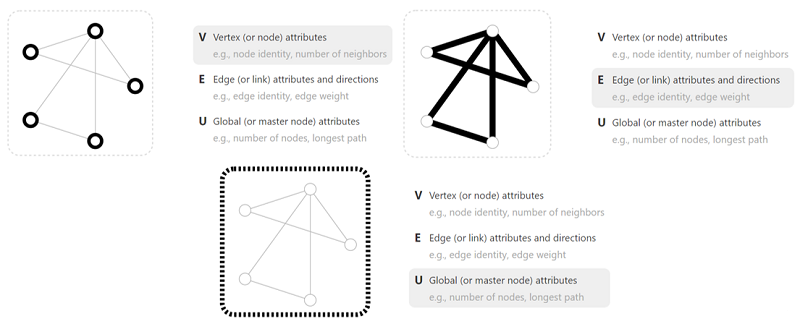

其中 $V$ 表示顶点,$E$ 表示边,$U$ 表示全局。可以看到每一个定义后面都有一个 attributes,这意味着我们不能只关注图的一个结构信息,还应该关注属性信息,比如节点的邻居数,边的权重,最长路径等等。

- $V$:节点信息(节点标识、节点邻居数)

- $E$:节点信息(边标识、边权重)

- $U$:全局信息(节点数、最长路径)

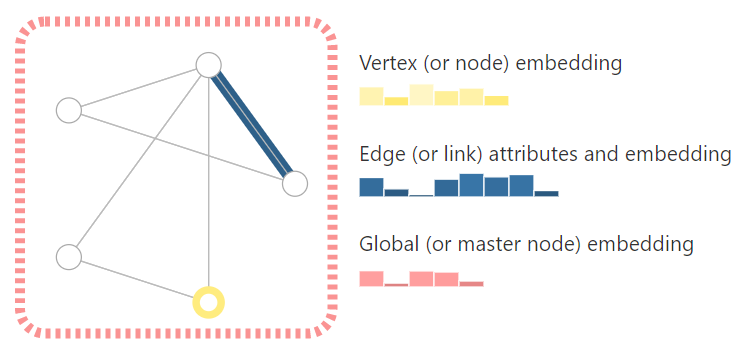

为了深入表示每个节点、边和整个图,我们可以用如下的存储方式:

把节点信息、边信息和全局信息做 embedding,通俗地说就是把这些信息存储为向量的形式。所以图神经的核心就是,怎么样把我们想要的信息表示成向量,以及向量是否能通过数据学习到。

图的边分为无向边和有向边。

2.数据如何表示成图?

以下是几种图表示的例子:

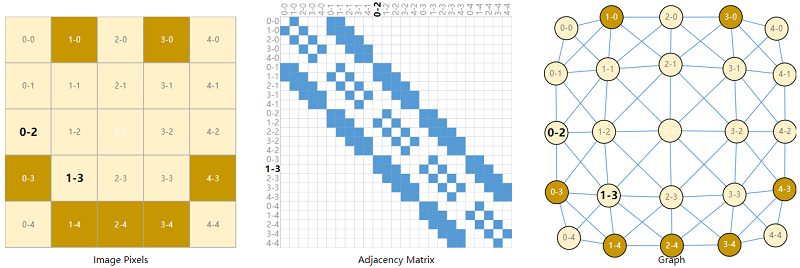

2.1 图像

Images as graphs(将图片表示为图)

通常把图片表示为三维 $tensor$,如 $224x224x3$。实际上可以把每个像素作为一个点,存在邻接关系则形成一条边。

每一个像素点都和周围八个像素点相连,因此邻接矩阵中这八个位置都为1。

因此对于 $image$ 数据,如果它有 $5 × 5 $ 个像素点,那么我们就能够建立一个拥有 $25$ 个节点的图,每个节点可以跟其周围八个节点相连。

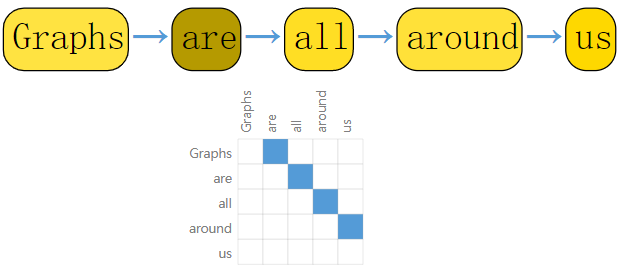

2.2 文本

文本可以被认为是一个序列,其中每一个词作为一个节点,每一个词和其下一个词之前有一条有向边:

2.3 其他数据

除了上述图像和文本外,还有一些数据,除了图以外,我们很难用其他形式来表示他们!

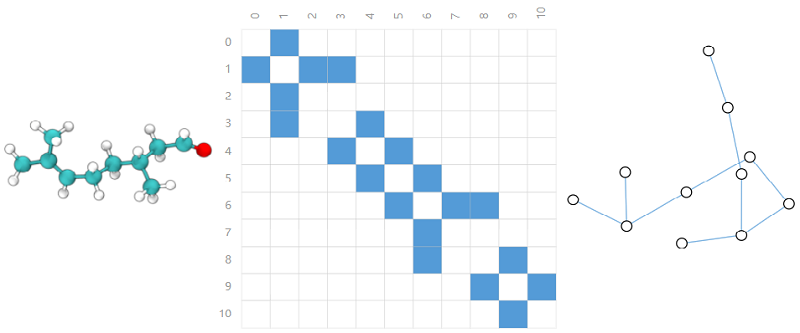

2.3.1 分子

分子中原子通过作用力连在一起,因此每一个原子可以表示为一个点,原子间键表示为边。 如下图是一个香料分子:

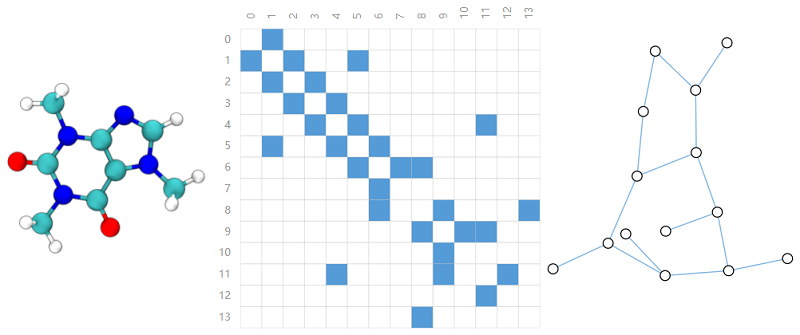

以及咖啡因分子:

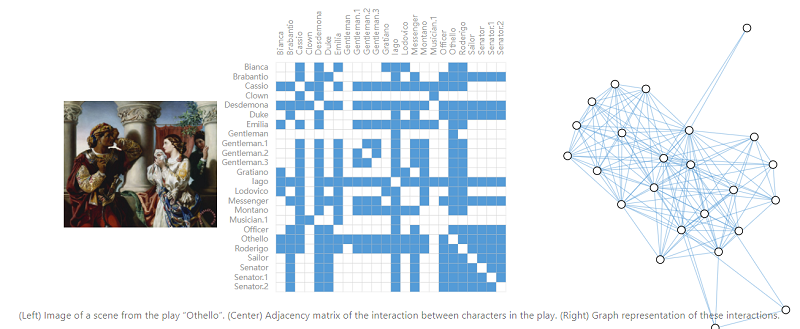

2.3.2 社交网络

在社交网络中,我们将个人表示为节点,将他们间的关系表示为边。

比如戏剧中人物关系图:

2.3.3 引文图

将论文抽象为节点,论文 $A$ 引用了论文 $B$ ,则有一条有向边 $A->B$ 。

3.图中的任务

图里面的任务主要分为三大类:图级、节点级和边级。

在图级任务中,我们预测整个图的属性。对于节点级任务,我们预测图中每个节点的一些属性。对于边级任务,我们希望预测图中边的属性或者是否存在这条边。

3.1 图级任务

在图级任务中,我们的目标是预测整个图的属性。 比如对于某一分子,我们可能想要预测该分子的气味,或者它是否会和与疾病有关的受体结合。

这里我们输入的是一张图,输出的是该图的 $label$ ,比如该图是否有两个环?

3.2 节点级任务

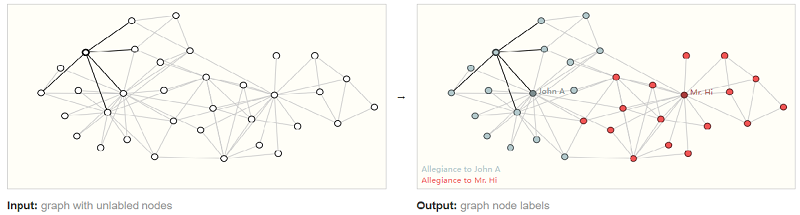

节点级任务主要预测单个节点的属性。

节点级预测问题的一个经典示例是空手道俱乐部数据集,该数据集是一个社交网络图,每个节点都具有一个唯一的 $label$。

这里每一个节点的标签要么为 Mr. Hi,要么为 Officer。在这种情况下,我们就可以建立一个模型对某一个节点的 $label$ 进行预测。

因此,节点预测的输入是一个图,输出是节点的标签:

3.3 边级任务

对于边级任务:给定一些节点,我们希望预测这些节点中的哪些共享一条边或该边的权值是什么。

边的预测(链路预测)的例子是通过语义分割把人物、背景拿出来,然后分析实体间的关系(属性)。比如黄衣服的人在踢绿衣服的人,他们都站在地毯上。

4.使用图数据的挑战

在使用神经网络对图进行处理前,我们得先将图表示成神经网络能够处理的数据类型。

图上的信息有四种:节点属性、边属性、全局属性以及连接性。

图表示的难点在于怎么来表示图的连接性。 最容易想到的就是邻接矩阵:相连为1否则为0。

不过,使用邻接矩阵来表示连接性的缺点是显而易见的:对于一些大型网络,其节点数可能上百万,并且每个节点的边数变化可能会很大,比如某些节点连接了几万条边,有些节点只连接了一条边,这样邻接矩阵将会非常稀疏,虽然我们可以利用压缩的办法来对这些稀疏矩阵进行存储,但稀疏矩阵的计算一直都是一个难题。

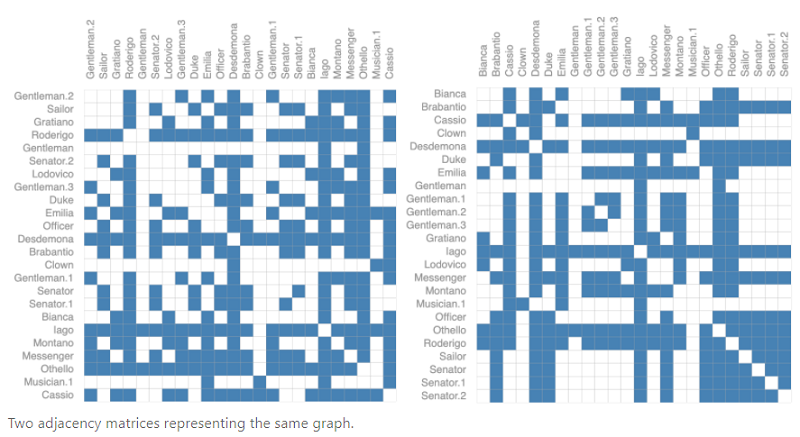

此外,还有一个问题:对于同一个图,我们将矩阵中任何行或列之间进行交换:

虽然两个邻接矩阵看起来不一样,但二者表示的却是同一个图。

也就是说,不同的邻接矩阵,可以表示相同的连接性!这意味着如果我设计了一个神经网络,在上述两个不同的矩阵输入后我得保证神经网络的输出是一样的。

对于上面提到的两个问题,一个有效的解决方式是邻接表:

上图有8个顶点,7条边。对于每个顶点或者每条边的特征我们用一个标量(一般为向量)来表示,全局特征也用一个标量(一般为向量)来表示。对于连接性,不再用邻接矩阵来表示,而是用邻接列表来表示。

使用邻接列表来表示连接性的两个好处:

- 对于稀疏矩阵来说,使用邻接列表存储显然更加节省空间。

- 不存在两个不一样的邻接列表表示同一张图。

5.图神经网络

在经历了将数据转为graph以及将graph进行表示后,我们就能使用GNN来对图进行处理了。

一句话概括GNN:GNN是对图的所有属性(节点、边、全局上下文)进行的可优化的一种变换,它保留了图的对称性(置换不变性)。

简单来说就是,我们初始给定了节点或者边或者全局的属性,GNN将对这些属性进行变换,但是这种变换不会影响节点之间的连接性,变换优化后的图依旧保持着原图的连接结构。

当然,也只有在变换后依旧保持着原图的连接结构,我们才能使用这些变换后的属性对图进行预测。 试想在一个社交网络中,原来有朋友关系的节点经过GNN的变换后不再具有朋友关系,此时再用这些变换后的属性对某一对节点进行预测,结果显而易见!

5.1 最简单的GNN

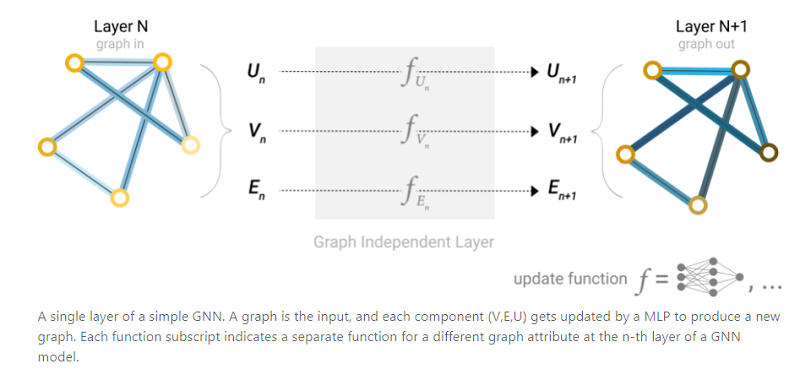

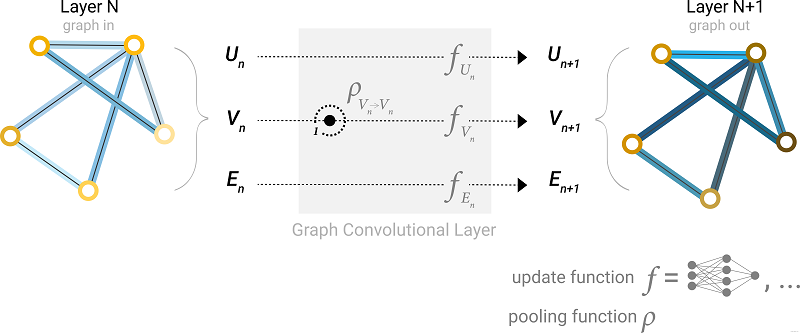

如下所示:

首先,对节点向量、边向量、全局向量分别构建一个MLP(多层感知机),MLP的输入输出的大小相同。

三个MLP组成GNN的一层,一个图经过MLP后仍然是一个图。对于顶点、边、全局向量 分别 找到对应的MLP,作为其更新函数(update function)。可以看到,输出后图的属性变化了,但是图的结构没有改变,符合我们的需求。MLP对每个向量独自作用,不会影响的连接性。

5.2 Pooling

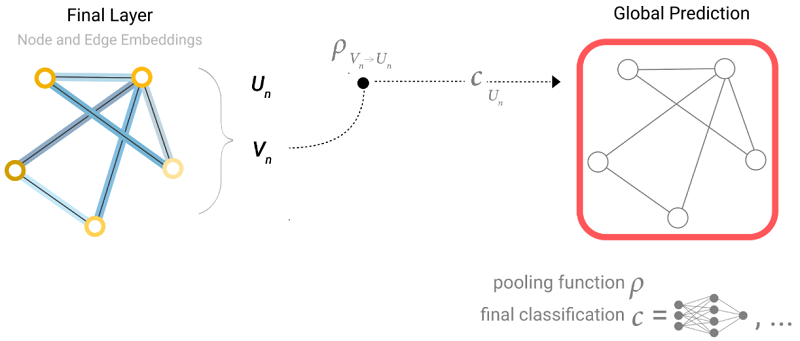

堆叠了多层上述的模型后得到了GNN,现在来到最后一层,对节点进行预测。

对于一个简单的二分类问题,比如上面3.2节提到的空手道俱乐部网络图,我们需要对每个节点进行分类,在我们得到每个节点的状态向量后,我们可以搭建一个输出为2的全连接层,然后再经过一个Softmax,就能进行二分类了。多分类问题类似,只要将全连接层的输出改为n即可。

如下所示:

将经过最后一层后输出的节点状态向量 $V_n$ 与一个全连接层相连,就能进行分类任务了。

值得一提的是,这里所有节点都是共用一个全连接层,也就是所有节点共享同一个全连接层的参数。

以上是最简单的一种情况,但我们不得不考虑另外一种情况:如果我们没有一个节点的向量表示,但我们仍想对该节点进行预测该怎么办? 答案是Pooling,Pooling在CNN中已经有过接触。

具体如下所示:

如果我们没有右上角那个节点的向量表示,此时我们就可以把与该节点相连的四条边的状态向量以及全局状态向量相加,得到这个节点的状态向量,然后再经过全连接层进行预测。

类似地,如果没有某条边的状态向量,只有节点的状态向量,如下所示:

此时我们就可以把这条边上的两个节点的向量相加得到该边的向量,然后再进行预测。

又比如我们只有节点信息,没有全局信息,而我们想对图的全局标签进行预测:

此时同样可以将图中所有顶点的向量加起来,得到一个全局表示,然后再进行预测。

因此,无论缺少哪一种信息,我们最终都能通过Pooling操作来汇聚已有的信息,进而得到我们想要的信息。

具体来讲,上面描述的GNN可以通过下图概括:

我们将原始graph通过一个个GNN层(每一层都有三个MLP,分别对三种状态进行转换),然后,无论是顶点、边还是全局,都通过同一个全连接层进行输出预测。

上述这种最简单的GNN存在着一个很明显的缺陷:我们在GNN层对节点或者边进行更新时,每层内所有节点共用一个MLP,所有边共用一个MLP,此时我们并没有考虑连接信息,也就是说我们在对节点更新时没有考虑与该节点相连的其余节点或者边,更新边时没有考虑与该边相连的节点。

简单来说,我们在更新时没有将图的结构信息考虑进去。

5.3 消息传递

那么我们怎么在更新时考虑结构信息呢?

$\boldsymbol{x}_{n}(t+1)=f_{\boldsymbol{w}}\left(\boldsymbol{l}_{n}, \boldsymbol{l}_{\mathrm{co}[n]}, \boldsymbol{x}_{\mathrm{ne}[n]}(t), \boldsymbol{l}_{\mathrm{ne}[n]}\right)$

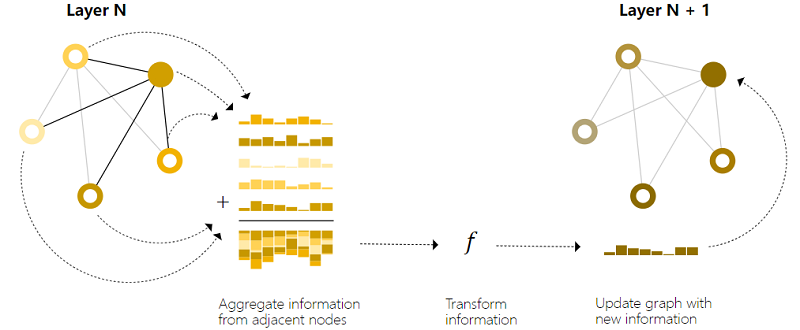

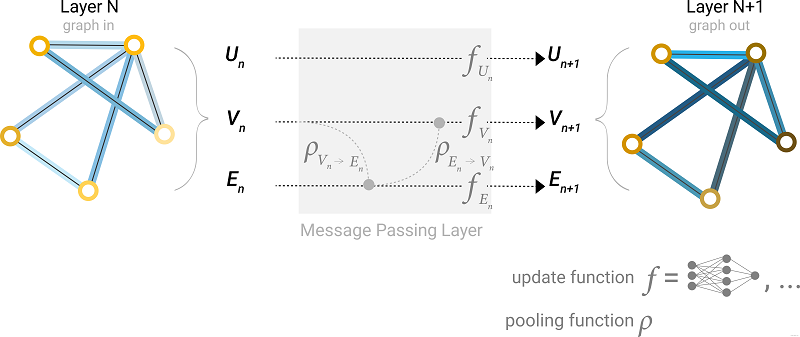

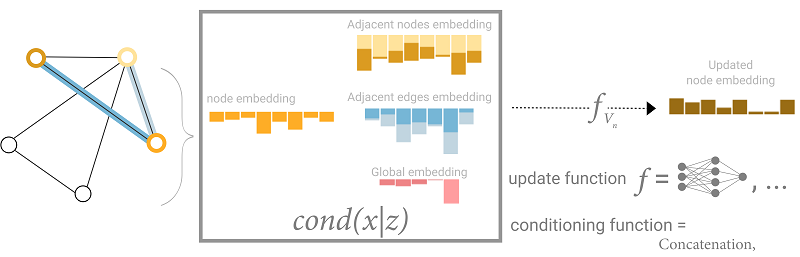

如下图所示:

我们在更新每一个节点的向量时,并不只是简单地将该节点的向量通过一个MLP后得到更新后的向量,而是还要考虑与该节点相连节点的向量,也就是在下述更新公式中:

$\boldsymbol{x}_{n}(t+1)=f_{\boldsymbol{w}}\left(\boldsymbol{l}_{n}, \boldsymbol{l}_{\mathrm{co}[n]}, \boldsymbol{x}_{\mathrm{ne}[n]}(t), \boldsymbol{l}_{\mathrm{ne}[n]}\right)$

我们要考虑 $x_{n e[n]}$ 这一项了。

当然上图这种更新方式并没有太复杂,只是将该节点的向量与其相连节点的向量相加。

考虑一种更为复杂的情况:

在进行边的更新时,我们可以将与该边相连的两个顶点的向量加入到该边的向量中(如果维度不同则需要变换),然后再对该边进行更新。同样,对于某一个节点的更新,我们也可以将与该节点相连的边的向量加入到该节点中,然后再对该节点进行更新。

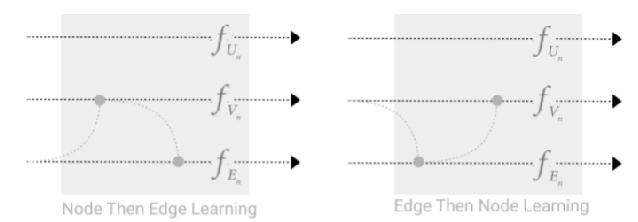

节点和边之间的消息传递存在一个选择:

我们可以先把边的信息传递给顶点,顶点更新后,再将更新后的顶点信息传递给边,边再更新(上图左),或者相反(上图右)。

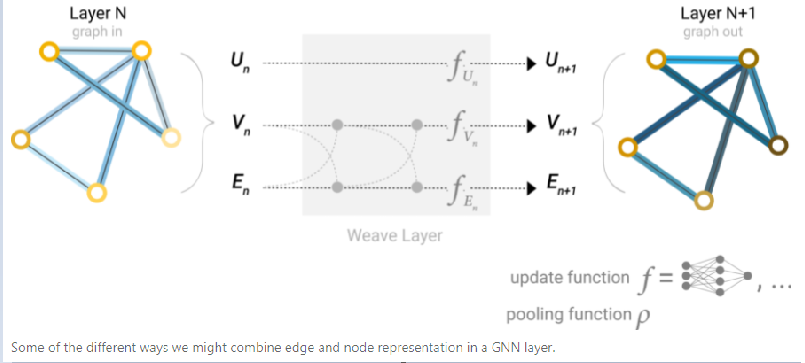

还有一种办法是交替传递:

我们可以同时进行两种操作:将边的信息给节点,然后节点的信息也给边。此时的节点和边都包含了各自的信息,然后再进行一次传递,将二者的信息互相传递,随后再用两个MLP对节点和边进行更新。

5.4 全局表示

对一个large graph来讲,即使我们多次进行消息传递,图中相距较远的两个顶点间也可能无法有效地相互传输信息。

一种解决办法是加入master node(主节点)或者 context vector(上下文向量)。主节点是一个虚拟的点,我们假设它与图中所有节点都相连,同时它也跟所有的边都相连。

因此在进行顶点或者边的更新时,如果我们加上全局表示 $U$,就能保证所有顶点(边)间都能传递信息。

作者说这个其实可以认为是featurize-wise attention mechanism(特征级的注意力机制),因为将相近的节点聚集了过来。现在我们就知道了基于消息传递的图神经网络是怎么样工作的。

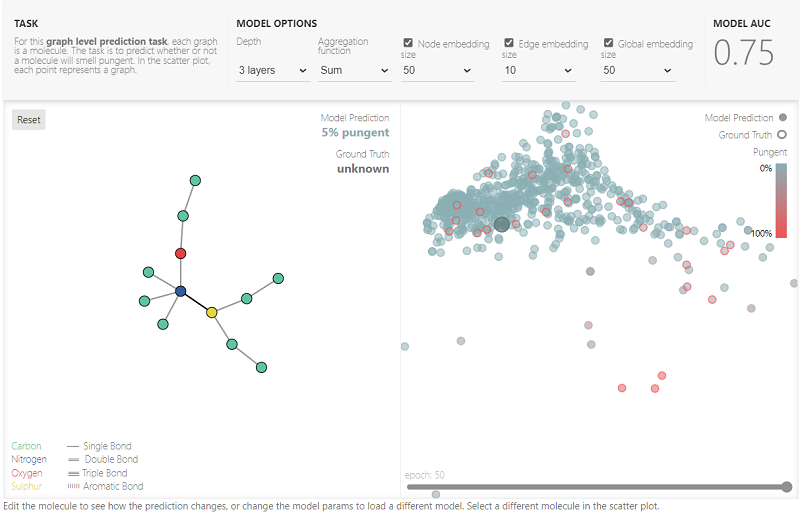

6.实验

在这篇文章中,作者非常费心将GNN嵌入到JavaScript中,搭建了这样一个playground,给出分子结构的数据集,通过调节超参数,得到训练效果和结果可视化。分子结构是可以自定义的,非常值得玩一玩。

7.相关知识

7.1 其他类型的图

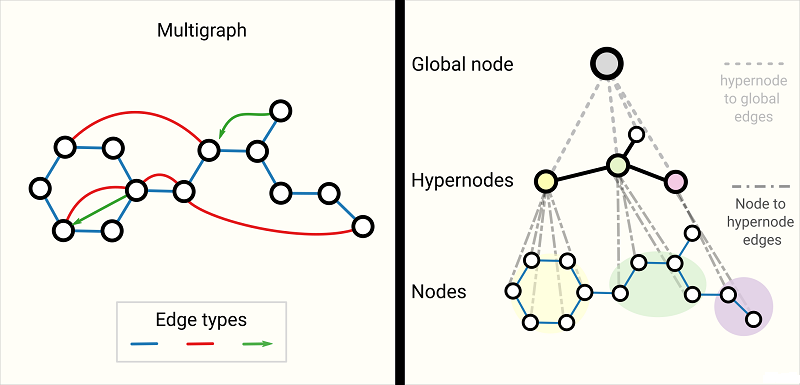

multigraph和分层图

这里主要介绍了两种其他类型的图:多重图和嵌套图。

所谓多重图,就是指图中一对节点间可以有多种不同类型的边。 比如在社交网络中,两个节点(用户)之间的边,可以表示这两人是熟人、家人或者情侣。这种情况下,GNN可以通过为不同类型的边设置不同类型的消息传递方式来进行调整。

所谓嵌套图,就是说图中的某一个节点可能就表示一个图。 比如在一个分子网络中,一个节点代表一个分子,如果一个分子能通过某种反应转换为另一个分子,则两个分子之间有一条边。在这个网络中,节点(分子)本身也是一个图(原子-原子)。在这种情况下,可以让GNN学习分子级别的表示和另一个反应网络级别的表示,并于训练期间在它们之间进行交替。

此外,还有超图,超图的一条边可以连接到多个节点,而不仅仅是两个。对于这种情况,可以通过识别节点社区并分配连接到社区中所有节点的超边来构建超图。

7.2 采样和批处理

图采样介绍了随机采样、随机游走、随机游走+邻居采样、扩散采样Z。

GNN存在邻居爆炸的问题,即:GNN会不断地聚合图中相邻节点的信息,第L层GNN中的每个目标节点都需要聚合原图中L层以前的所有节点信息。邻点爆炸式增长,使得GNN的minibatch训练极具挑战性。

此外,由于彼此相邻的节点和边的数目不同,我们也不能使用恒定的批量大小。

解决该问题的办法是从图中进行采样,得到一个子图,然后对子图进行处理。

对一张图进行采样的四种方式如下图所示:

- Random node sampling:先随机采样一些点(Sampled nodes),然后再采样它们的邻居。

- Random walk sampling:做一些随机游走,从当前点的邻居节点中进行采样。

- Random walk with neighborhood:结合前两种:先随机走一定长度,然后再采样它们的邻居。

- Diffusion Sampling:取一个根节点,然后对它的一近邻、二近邻一直到K近邻进行采样,类似于一个BFS。

7.3 Inductive biases

先说一说CNN的平移不变性:即使目标的外观发生了某种变化,但是利用CNN依然可以把它识别出来。即图像中的目标无论是被平移,被旋转,还是被缩放,都可以被成功地识别出来。

而在GNN中,也具有图对称性:也就是排列无关性,即使交换了顶点的顺序,GNN对其的作用都保持不变。

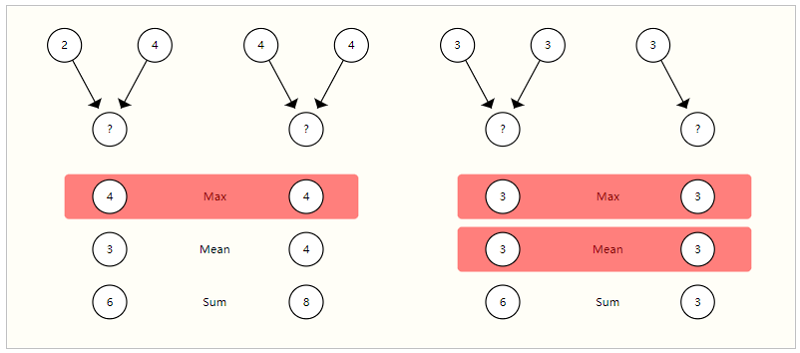

7.4 不同的Pooling方式

在GNN中,对节点和边的信息进行Pooling是关键操作,选择一个最优的Pooling方式是一个比较好的研究方向。

常见的Pooling方式有max、mean和sum,作者对三者进行了比较:

左边这幅图中,有2-4和4-4两个网络,如果我们采用max,二者结果都是4,没法进行区分,而mean和sum可以对二者进行区分;右边这幅图中,max和mean没法区分两种网络,而sum却可以。

因此,没有一个Pooling方式是明显优于其它Pooling方式的。

7.5 GCN作为子图函数近似

GCN如果是k层,每一层都往前看一个邻居,那么最后一个节点看到的是一个子图,这个子图大小是k,和节点的距离是k。这里我理解的就是,GCN有多少层,就看到了多少阶的邻居。

所以,GCN实际上是有N个子图,每个子图都是从原节点出发,往前走k步。

7.6 边和图对偶

点和边做对偶,把边变成点,点变成边,邻接关系保持不变。

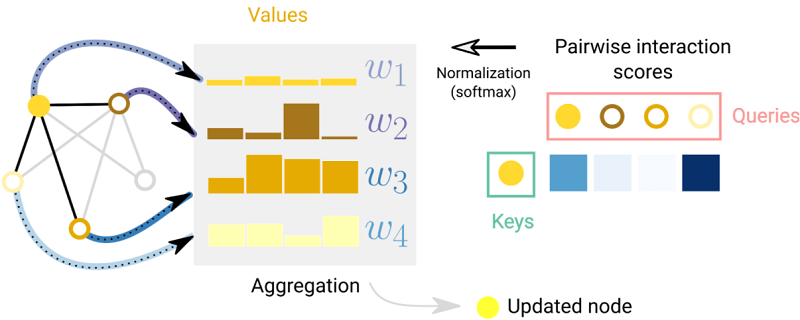

7.7 图注意力网络

在GCN中,将邻居节点汇聚到某个节点上,实际上是没有加权的。其实图神经网络中也可以像CNN中的卷积核一样,在3x3窗口中带有基于空间位置的不同的权重。图上不需要空间位置,只需要通过注意力机制计算两个节点向量的关系强弱,按计算出来的权重来聚合。

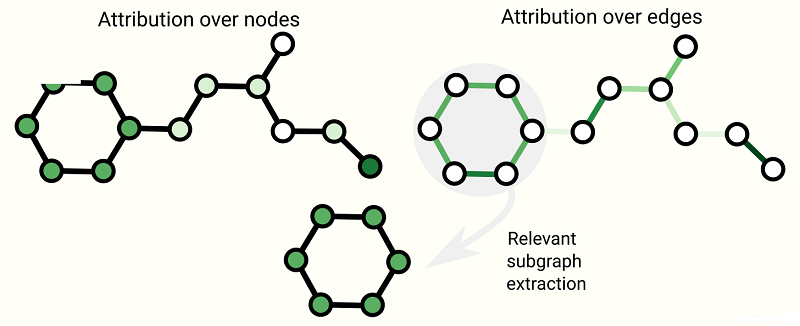

7.8 图解释

神经网络到底学到了什么东西,可以抓取子图来看学到了什么。

7.9 生成模型

我们之前的模型是不改变图结构的,这里通过生成模型可以对图的拓扑结构进行有效建模。

8 对文章和GNN的评论

- 对于文章

从头到尾读下来非常流畅!先介绍什么是图,在图中我们对顶点、边、全局都用向量表示,以及现实中的数据如何表示为图,如何对图做预测,算法用到图上有什么挑战。然后开始介绍图神经网络,首先定义了GNN是对属性做变换而不改变其结构,从最简单的例子开始讲解,用三个MLP做属性向量的变换,用全连接层做输出从而实现预测。如果有缺失向量怎么办,那就做聚合操作,把边、节点、全局属性利用上,也可以完成我们的预测工作。最后介绍真正意义的GNN,每一层通过汇聚操作把信息传递过来,从每个顶点看到邻居节点的信息,在每一层能充分汇聚到图中的信息。然后是实验部分,作者搭建了playground供读者玩,跑出了不同的超参数对模型效果的影响,最后对GNN的相关技术进行了展开。

文章写得是非常精美的,文中存在大量的交互图,文字围绕图展开。这么多的交互图既是缺点也是优点,用JavaScript写如此多的交互图是非常耗时间的事情,作者尽可能用图来代替大量的公式和代码,更直观易懂。本文的缺点就是,文章的宽度的展开,很多地方让读者一知半解,了解不到其中细节,导致懂GNN的人能感受到GNN的强大,不懂GNN的人仍然不知道其核心在哪里。

- 对于GNN

图是非常强大,几乎所有数据都能表示成图,但是图上做优化很难,涉及到CPU和GPU的训练也是一个挑战,同时图神经网络对超参数非常敏感。近些年图神经网络在学术界迅速发展,实际上工业落地的并不多,GNN的发展还需要时间的沉淀。

图解GNN:A Gentle Introduction to Graph Neural Networks的更多相关文章

- 论文解读(soft-mask GNN)《Soft-mask: Adaptive Substructure Extractions for Graph Neural Networks》

论文信息 论文标题:Soft-mask: Adaptive Substructure Extractions for Graph Neural Networks论文作者:Mingqi Yang, Ya ...

- 论文解读(GIN)《How Powerful are Graph Neural Networks》

Paper Information Title:<How Powerful are Graph Neural Networks?>Authors:Keyulu Xu, Weihua Hu, ...

- 论文阅读 Streaming Graph Neural Networks

3 Streaming Graph Neural Networks link:https://dl.acm.org/doi/10.1145/3397271.3401092 Abstract 本文提出了 ...

- 论文解读(DAGNN)《Towards Deeper Graph Neural Networks》

论文信息 论文标题:Towards Deeper Graph Neural Networks论文作者:Meng Liu, Hongyang Gao, Shuiwang Ji论文来源:2020, KDD ...

- 论文解读(LA-GNN)《Local Augmentation for Graph Neural Networks》

论文信息 论文标题:Local Augmentation for Graph Neural Networks论文作者:Songtao Liu, Hanze Dong, Lanqing Li, Ting ...

- 论文解读(GraphSMOTE)《GraphSMOTE: Imbalanced Node Classification on Graphs with Graph Neural Networks》

论文信息 论文标题:GraphSMOTE: Imbalanced Node Classification on Graphs with Graph Neural Networks论文作者:Tianxi ...

- 论文解读(KP-GNN)《How Powerful are K-hop Message Passing Graph Neural Networks》

论文信息 论文标题:How Powerful are K-hop Message Passing Graph Neural Networks论文作者:Jiarui Feng, Yixin Chen, ...

- 论文解读(ChebyGIN)《Understanding Attention and Generalization in Graph Neural Networks》

论文信息 论文标题:Understanding Attention and Generalization in Graph Neural Networks论文作者:Boris Knyazev, Gra ...

- Introduction to Deep Neural Networks

Introduction to Deep Neural Networks Neural networks are a set of algorithms, modeled loosely after ...

随机推荐

- HTTP强缓存和协商缓存

一.浏览器缓存 Web 缓存能够减少延迟与网络阻塞,进而减少显示某个资源所用的时间.借助 HTTP 缓存,Web 站点变得更具有响应性. (一).缓存优点: 减少不必要的数据传输,节省带宽 减少服务器 ...

- 设置项目的开始/完成日期(Project)

<Project2016 企业项目管理实践>张会斌 董方好 编著 在设定完日程排定方法,或者不作任何设置,依其默认的[项目开始日期]的设置,接下来就要设置项目的开始时间了.依然是在[项目] ...

- 自定义日历(Project)

<Project2016 企业项目管理实践>张会斌 董方好 编著 日历有三种:标准日历.24小时日历和夜班日历. 但这三种在现实中远远不够用,别的不说,就说那个标准日历,默认是8点到12点 ...

- textarea控件好奇怪啊,用<s:if>标签居然不在一行回出现很多的空格,奇葩啊

textarea控件好奇怪啊,用<s:if>标签居然不在一行回出现很多的空格,奇葩啊

- Hive实战—时间滑动窗口计算

关注公众号:大数据技术派,回复: 资料,领取1024G资料. 目录 时间滑动计算 外部调用实现时间循环 自关联实现滑动时间窗口 扩展基于自然周的的滚动时间窗口计算 总结 时间滑动计算 今天遇到一个需求 ...

- 【LeetCode】72. Edit Distance 编辑距离(Python & C++)

作者: 负雪明烛 id: fuxuemingzhu 个人博客: http://fuxuemingzhu.cn/ 目录 题目描述 题目大意 解题方法 递归 记忆化搜索 动态规划 日期 题目地址:http ...

- 【LeetCode】851. Loud and Rich 解题报告(Python)

[LeetCode]851. Loud and Rich 解题报告(Python) 标签(空格分隔): LeetCode 作者: 负雪明烛 id: fuxuemingzhu 个人博客: http:// ...

- 面渣逆袭:JVM经典五十问,这下面试稳了!

大家好,我是老三,"面渣逆袭"系列继续,这节我们来搞定JVM.说真的,JVM调优什么的一个程序员可能整个职业生涯都碰不到两次,但是,一旦用到的时候,那就是救命了,而且最重要的是-- ...

- IM2603资料 Type-C 扩展坞电源管理芯片

用于带有集成降压转换器的 Type-C 外围应用的电源管理 IC IM2603 是一款主要用于 Type-C 外围应用的电源管理 IC. 它集成了一个带有内置高侧 MOSFET 的同步降压转换器和一个 ...

- Java+Eclipse+MySQL+Swing实现学生会考成绩管理系统(免费完整项目)

版权声明:原创不易,本文禁止抄袭.转载,侵权必究! 目录 一.需求开发文档 二.数据库设计文档 三.功能模块部分代码及效果展示 四.完整源码下载 五.作者Info 一.需求开发文档 项目完整文件列表: ...