HDFS的操作SHELL和API

HDFS的shell操作和JavaAPI的使用:

WEB

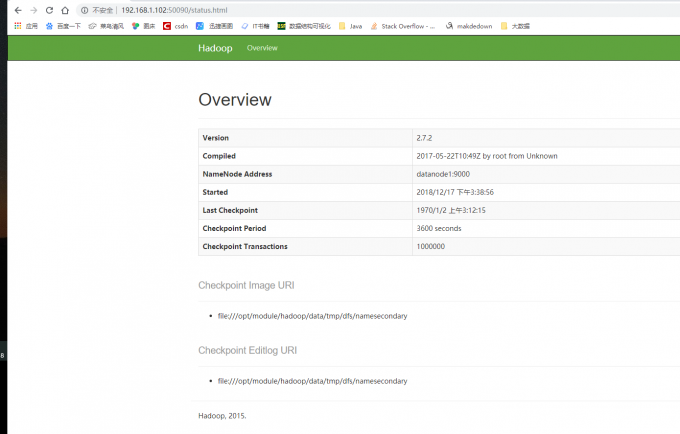

WEB端口50090查看SecondaryNameNode信息。可以查看Hadoop的版本,NameNode的IP,Checkpoint等信息。

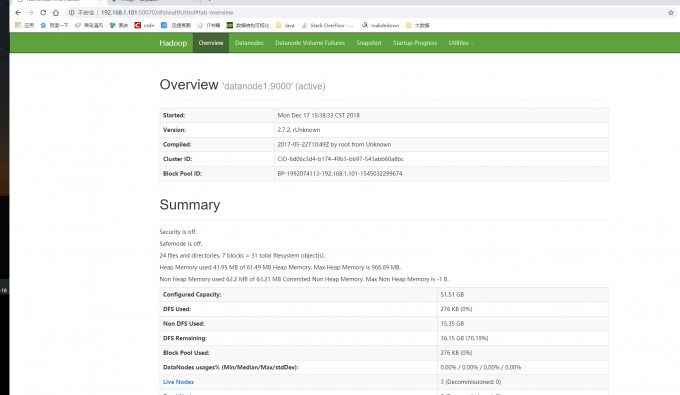

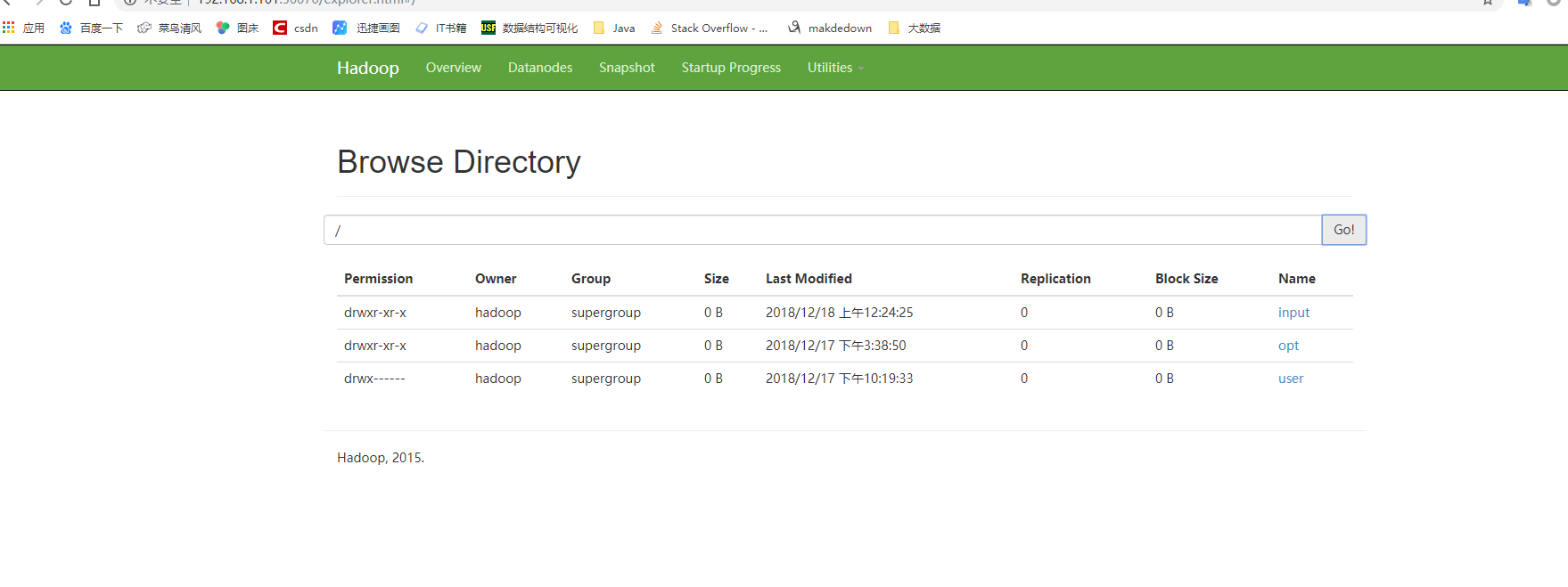

WEB端口50070可以查看HDFS的信息和目录结构

SHELL

查看

hdfs dfs -ls [-d][-h][-R] <paths>

[-d]:返回path

[-h]:按照KMG数据大小单位显示文件大小,默认B

[-R]:级联显示paths下文件

创建文件夹

hdfs dfs -mkdir [-p]<paths>

新建文件

hdfs dfs -touchz<paths>

查看文件

hdfs dfs -cat/[-ignoreCrc] [src]

hdfs dfs -text -ignoreCrc /input/test #忽略校验

hdfs dfs -cat -ignoreCrc /input/test

追写文件

hdfs dfs --appendToFile <localsrc> <dst>

如果localsrc为"-"表示数据来自键盘输入用"Ctrc+C"取消输入

上传下载

hdfs dfs -put [-f][-p]<localsrc> <dst> # 上传到指定目录

hdfs dfs -get [-p]<src> <localhost> # 现在到本地

删除文件

hdfs dfs -rm [-f] [-r] <src>

-f 如果要删除的文件不存在,不显示错误信息

-r/R 级联删除目录下所有文件和子目录文件

磁盘空间

hdfs dfs -du[-s][-h]<path>

[-s]显示指定目录所占空间大小

[-h]按照K M G 数据显示文件大小

JAVA API

步骤

- 实例化Configuration

Configuration封装了客户端或服务器的配置,Confiuration实例会自动加载HDFS的配置文件core-site.xml,从中获取Hadoop集群中的配置信息。因此我们要把集群的配置core-site.xml放在Maven项目的resources目录下。

Configuration conf = new Configuration();

- 实例化FileSystem

FileSystem类是客户端访问文件系统的入口,是一个抽象的文件系统。DistributedFileSystem类是FileSystem的一个具体实现。实例化FileSystem并发挥默认的文件系统代码如下:

FileSystem fs = FileSystem.get(conf);

- 设置目标对象的路径

HDFS API 提供了Path类来封装文件路径。PATH类位于org.apache.hadoop.fs.Path包中,代码如下:

Path path = new Path("/input/write.txt");

执行文件操作

得到Filesystem实例后,就可以使用该实例提供的方法成员执行相应的操作。如果:打开文件,创建文件、重命名文件、删除文件。

FileSystem类常用成员函数

| 方法名称及参数 | 返回值 | 功能 |

|---|---|---|

| create(Path f) | FSDataOutputStream | 创建一个文件 |

| open(Path f) | FSDatatInputStream | 打开指定的文件 |

| delete(Path f) | boolean | 删除指定文件 |

| exsits(Path f) | boolean | 检查文件是否存在 |

| getBlockSize(Path f) | long | 返回指定的数据块的大小 |

| getLength(Path f) | long | 返回文件长度 |

| mkdir(Path f) | boolean | 检查文件是否存在 |

| copyFromLocalFile(Path src, Path dst) | void | 从本地磁盘复制文件到HDFS |

| copyToLocalFile(Path src, Path dst) | void | 从HDFS复制文件到本地磁盘 |

| ……….. | ………. | ……………. |

上传文件

package hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; import java.net.URI; public class PutFile {

public static void main(String[] args) throws Exception { Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create("hdfs://datanode1:9000"),conf,"hadoop"); //本地文件

Path src = new Path("D:\\上传文件.txt"); //HDFS 路径

Path dst = new Path("/input/上传文件.txt"); fs.copyFromLocalFile(src, dst);

fs.close();

System.out.println("文件上传成功");

}

}

创建文件

package hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; import java.net.URI; public class CreateFile {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create("hdfs://datanode1:9000"), conf, "hadoop");

Path dfs = new Path("/input/上传文件.txt");

FSDataOutputStream newFile = fs.create(dfs, true); //是否覆盖文件 true 覆盖 false 追加

newFile.writeBytes("this is a create file tes");

System.out.println("创建文件成功"); }

}

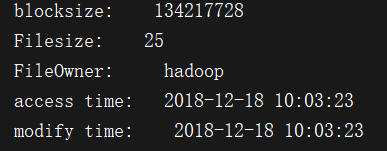

文件详情

package hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; import java.net.URI;

import java.text.SimpleDateFormat;

import java.util.Date; public class SeeInfo {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create("hdfs://datanode1:9000"), conf, "hadoop"); // HDFS文件

Path fpath = new Path("/input/上传文件.txt"); FileStatus fileLinkStatus = fs.getFileLinkStatus(fpath);

//获得块大小

long blockSize = fileLinkStatus.getBlockSize();

System.out.println("blocksize: " + blockSize); //获得文件大小

long len = fileLinkStatus.getLen();

System.out.println("Filesize: " + len); //获得文件所有者

String owner = fileLinkStatus.getOwner();

System.out.println("FileOwner: " + owner); //获得创建时间

SimpleDateFormat formater = new SimpleDateFormat("yyyy-MM-dd hh:mm:ss");

long accessTime = fileLinkStatus.getAccessTime();

System.out.println("access time: " + formater.format(new Date(accessTime))); //获得修改时间

long modificationTime = fileLinkStatus.getModificationTime();

System.out.println("modify time: " + formater.format(new Date(modificationTime))); }

}

下载文件

package hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils; import java.io.FileOutputStream;

import java.io.InputStream;

import java.io.OutputStream;

import java.net.URI; public class GetFIle {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create("hdfs://datanode1:9000"), conf, "hadoop");

// HDFS 文件

InputStream in = fs.open(new Path("/input/上传文件.txt")); //保存到本地位置

OutputStream out = new FileOutputStream("D://下载文件.txt");

IOUtils.copyBytes(in, out, 4096, true); System.out.println("下载文件成功");

fs.close(); }

}

删除文件

package hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; import java.net.URI; public class DeleteFile {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create("hdfs://datanode1:9000"), conf, "hadoop"); Path path = new Path("/input/上传文件.txt");

fs.delete(path);

System.out.println("删除成功");

}

}

HDFS的操作SHELL和API的更多相关文章

- HDFS的基本shell操作,hadoop fs操作命令

(1)分布式文件系统 随着数据量越来越多,在一个操作系统管辖的范围存不下了,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,因此迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管 ...

- JAVA API 实现hdfs文件操作

java api 实现hdfs 文件操作会出现错误提示: Permission denied: user=hp, access=WRITE, inode="/":hdfs:supe ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hdfs简单的shell命令

实验目的 了解bin/hadoop脚本的原理 学会使用fs shell脚本进行基本操作 学习使用hadoop shell进行简单的统计计算 实验原理 1.hadoop的shell脚本 当hadoop集 ...

- HDFS简单介绍及用C语言訪问HDFS接口操作实践

一.概述 近年来,大数据技术如火如荼,怎样存储海量数据也成了当今的热点和难点问题,而HDFS分布式文件系统作为Hadoop项目的分布式存储基础,也为HBASE提供数据持久化功能,它在大数据项目中有很广 ...

- Hadoop之HDFS文件操作常有两种方式(转载)

摘要:Hadoop之HDFS文件操作常有两种方式,命令行方式和JavaAPI方式.本文介绍如何利用这两种方式对HDFS文件进行操作. 关键词:HDFS文件 命令行 Java API HD ...

- hadoop的hdfs文件操作实现上传文件到hdfs

这篇文章主要介绍了使用hadoop的API对HDFS上的文件访问,其中包括上传文件到HDFS上.从HDFS上下载文件和删除HDFS上的文件,需要的朋友可以参考下hdfs文件操作操作示例,包括上传文件到 ...

- Hadoop---Java-API对HDFS的操作

Java-API对HDFS的操作 哈哈哈哈,深夜来一波干货哦!!! Java-PAI对hdfs的操作,首先我们建一个maven项目,我主要说,我们可以通过Java代码来对HDFS的具体信息的打印,然后 ...

- Hadoop JAVA HDFS客户端操作

JAVA HDFS客户端操作 通过API操作HDFS org.apache.logging.log4jlog4j-core2.8.2org.apache.hadoophadoop-common${ha ...

- 通过流的方式操作hadoop的API

通过流的方式操作hadoop的API 功能: 可以直接用来操作hadoop的文件系统 可以用在mapreduce的outputformat中设置RecordWrite 参考: 概念理解 http:// ...

随机推荐

- Pycharm乱码解决

现象:输出栏出现乱码 解决方案: 结果:

- k8s-YAML配置文件

一.YAML基础 YAML是专门用来写配置文件的语言,非常简洁和强大,使用比json更方便.它实质上是一种通用的数据串行化格式. YAML语法规则: 大小写敏感 使用缩进表示层级关系 缩进时不允许使用 ...

- python列表(list)遍历

list = ['html', 'js', 'css', 'python'] 遍历列表方法1:for i in list: print("序号:%s 值:%s" % (list.i ...

- STL 的 vector 根据元素的值来删除元素的方法

vector 的 erase( ) 只能删除迭代器,所以要想删某种值的元素,需要这样: 假设有一个 vector 叫 vt ,则 vt.erase( remove( vt.begin() , vt.e ...

- kettle判断是否是数据首行(第一行)

可以用组件:分析查询(Analytic Query) 后面可以通过判断pre_id 是否为空值(null)判断.

- Flask--异常处理

异常处理: abort(404)-捕获HTTP抛出的统一状态码 @app.errorhandler-捕获全局异常错误码,捕获异常错误 @app.route("/demo4") de ...

- LeetCode——6. ZigZag Conversion

一.题目链接:https://leetcode.com/problems/zigzag-conversion/description/ 二.题目大意: 给定一个字符串和一个数字,将其转换成Zigzag ...

- Office 2016 Pro Plus \ Project 专业版 \ Visio 专业版 \ 64 位vol版本方便KMS小马oem

在使用上,零售版和批量授权版并没有区别,只是授权方式方面的区别,相对而言,VOL 版的更容易激活一些,其他并没有什么区别了. 有需要的可以在下面下载:(以下均是 64位VL 版) 版本:Office ...

- ubuntu安装最新的mercurial

Mercurial 是一种轻量级分布式版本控制系统,采用 Python 语言实现,易于学习和使用,扩展性强 之前安装的mercurial版本(2.8.2)太老了,想安装最新版本的. 网上搜到方法 su ...

- SQL优化系列——索引

索引可能是数据库中最被误解的主题,因为有很多方式让你糊涂索引如何工作,以及服务器如何使用它们.要正确设计索引,让索引在数据库服务器中满足以下三个重要目的:1,索引使服务器查找一组相邻行,而不是单独的行 ...