Hbase数据IO

场景及方案分析

场景1:logs --> HBase

- logs -> flume -> hfile -> import -> HBase (实时)

- csv导入HBase 使用hive 作为临时表csv导入HBase

- tsv导入HBase 直接import 方式1

场景2:RDBMS --> HBase

- RDBMS -> sqoop -> Hfile -> import -> HBase (非实时) 方式1

- RDBMS -> JDBC -> Put API -> HBase (实时较高,纯手写,较常用,因为需要过滤处理) 方式3

- RDBMS -> Stome -> HBase (实时)

- RDBMS -> Spark -> HBase (实时)

场景3:集群性能测试

- 自己写多线程并发程序(),测试读写速度

场景4:HBase -> RDBMS

三种方式

1.Using the HBase Put API

使用Put API import,缺点:数据保存在内存中,大数据量处理速度慢,数据缺少过滤

HADOOP_CLASSPATH=`$HBASE_HOME/bin/hbase mapredcp` \

$HADOOP_HOME/bin/yarn jar \

$HBASE_HOME/lib/hbase-server-1.2.0-cdh5.12.0.jar \

importtsv \

-Dimporttsv.columns=HBASE_ROW_KEY,info:name,info:sex,info:age \

user_from_tsv \

/user/cen/data/hbase_import_user.tsv

2.Using the HBase bulk load tool

使用MapReduce存储成HBase底层文件,优点,减少HBase集群插入压力(不经过插入),降低Job集群时间提高运行速度

# 跟上述命令不用的是,这个导入并不会将数据导入到HBase而是到一个指定的文件夹

# 使用import生成Hfile文件到HDFS,底层通过MapReduce(只有Map)实现

HADOOP_CLASSPATH=`$HBASE_HOME/bin/hbase mapredcp`:${HBASE_HOME}/conf \

$HADOOP_HOME/bin/yarn jar \

$HBASE_HOME/lib/hbase-server-1.2.0-cdh5.12.0.jar \

importtsv \

-Dimporttsv.columns=HBASE_ROW_KEY,info:name,info:sex,info:age \

-Dimporttsv.bulk.output=/user/cen/hbase/hfileoutput \

user_from_tsv_bulk \

/user/cen/data/hbase_import_user.tsv

# 加载数据(非MapReduce),相当于移动数据

HADOOP_CLASSPATH=`$HBASE_HOME/bin/hbase mapredcp`:${HBASE_HOME}/conf \

$HADOOP_HOME/bin/yarn jar \

$HBASE_HOME/lib/hbase-server-1.2.0-cdh5.12.0.jar \

completebulkload \

/user/cen/hbase/hfileoutput \

user_from_tsv_bulk

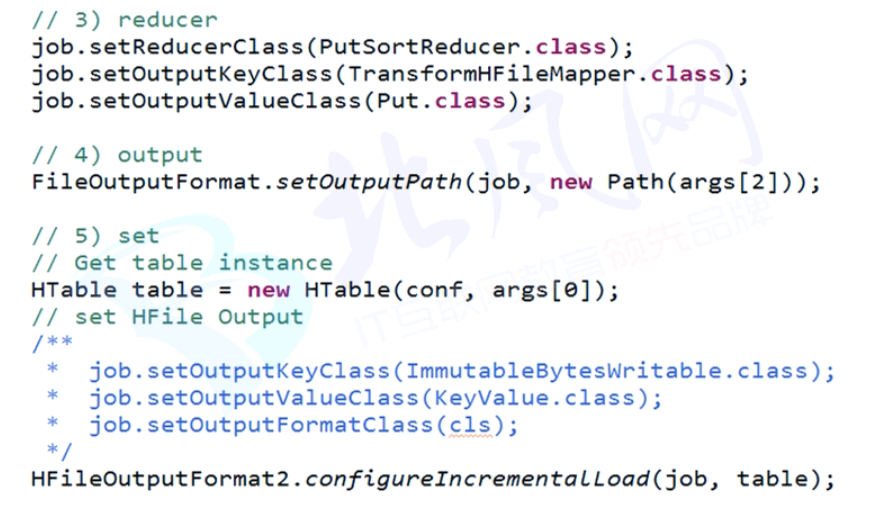

3.Using a customized MapReduce job

自定义 MapReduce Job 优点:前所未有的自由度,缺点:我有一句mmp不知当讲不当讲

a.mapreduce

csv -> hfile

b.bulk load

hfile -> table

Hbase数据IO的更多相关文章

- HBase数据存储格式

好的数据结构,对于检索数据,插入数据的效率就会很高. 常见的数据结构 B+树 根节点和枝节点非常easy,分别记录每一个叶子节点的最小值,并用一个指针指向叶子节点. 叶子节点里每一个键值都指向真正的 ...

- HBase 数据迁移方案介绍

一.前言 HBase数据迁移是很常见的操作,目前业界主要的迁移方式主要分为以下几类: 图1.HBase数据迁移方案 从上面图中可看出,目前的方案主要有四类,Hadoop层有一类,HBase层有三类.下 ...

- HBase 数据迁移方案介绍 (转载)

原文地址:https://www.cnblogs.com/ballwql/p/hbase_data_transfer.html 一.前言 HBase数据迁移是很常见的操作,目前业界主要的迁移方式主要分 ...

- 大数据-05-Spark之读写HBase数据

本文主要来自于 http://dblab.xmu.edu.cn/blog/1316-2/ 谢谢原作者 准备工作一:创建一个HBase表 这里依然是以student表为例进行演示.这里假设你已经成功安装 ...

- 大数据应用之HBase数据插入性能优化实测教程

引言: 大家在使用HBase的过程中,总是面临性能优化的问题,本文从HBase客户端参数设置的角度,研究HBase客户端数据批量插入性能优化的问题.事实胜于雄辩,数据比理论更有说服力,基于此,作者设计 ...

- Hadoop生态圈-使用MapReduce处理HBase数据

Hadoop生态圈-使用MapReduce处理HBase数据 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.对HBase表中数据进行单词统计(TableInputFormat) ...

- Bulk Load-HBase数据导入最佳实践

一.概述 HBase本身提供了非常多种数据导入的方式,通常有两种经常使用方式: 1.使用HBase提供的TableOutputFormat,原理是通过一个Mapreduce作业将数据导入HBase 2 ...

- 使用MapReduce读取HBase数据存储到MySQL

Mapper读取HBase数据 package MapReduce; import org.apache.hadoop.hbase.Cell; import org.apache.hadoop.hba ...

- SparkSQL读取HBase数据

这里的SparkSQL是指整合了Hive的spark-sql cli(关于SparkSQL和Hive的整合,见文章后面的参考阅读). 本质上就是通过Hive访问HBase表,具体就是通过hive-hb ...

随机推荐

- gitlab 邮件服务器配置

一.修改 /etc/gitlab/gitlab.rb 文件,添加邮件服务器信息 SMTP settings 例如163 邮件服务器 external_url 'http://你的IP地址或域名' ## ...

- Tinkoff Challenge - Final Round (ABC)

A题:从两个保安中间那钞票 #include <bits/stdc++.h> using namespace std; int main() { int a,b,c; scanf(&quo ...

- 「bzoj3687: 简单题」

题目 发现需要一个\(O(n\sum a_i )\)的做法 于是可以直接做一个背包,\(dp[i]\)表示和为\(i\)的子集是否有奇数种 \(bitset\)优化一下就好了 #include< ...

- DateTime小综合

实现效果: 关键知识: 1>DateTime类的ToString()方法: 2>DateTime类的IsLeapYear(); 3>DateTime类的DaysInMomth(); ...

- vue中a的href写法

注意点:href前面要加“:”或者v-bind: 2.字符串要用单引号“ ’ ”包住 加上了冒号是为了动态绑定数据,等号后面可以写变量. 如果不使用冒号,等号后面就可以写字符串等原始类型数据.这是就无 ...

- <jsp:include>和<%@include file=""%>的区别(简单了解)

简单了解 include指令是编译阶段的指令,即include所包含的文件的内容是编译的时候插入到JSP文件中,JSP引擎在判断JSP页面未被修改,否则视为已被修改.由于被包含的文件是在编译时才插入的 ...

- intellij idea下载安装以及创建项目(输出Hello World)

主题一:下载 第一:可以百度下载 第二:直接进行官网链接下载地址:http://www.jetbrains.com/idea/ 第一步: 第二步: 下载完成后进行安装 主题二:安装 点击Next速度可 ...

- Linux 和类 Unix 系统上5个最佳开源备份工具

转载:http://linux.cn/article-4623-weixin.html#rd?sukey=cbbc36a2500a2e6cb7678c4d38b691a9fa7403b259f898e ...

- data-ng-hide指令

<!DOCTYPE html><html><head><meta http-equiv="Content-Type" content=&q ...

- iOS | AFNetworking封装

为大家分享一个IOS处理网络请求,网络上传,网络下载等功能全面的一个第三方框架-AFNetworking,这是一个使用非常方便的网络框架. 最新的版本是基于NSURLSession,原来的NSURLC ...