使用Xpath爬虫库下载诗词名句网的史书典籍类所有文章。

# 需要的库

from lxml import etree

import requests

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'

}

# 保存文本的地址

pathname=r'E:\爬虫\诗词名句网\\'

# 获取书籍名称的函数

def get_book(url):

response = requests.get(url,headers)

etrees = etree.HTML(response.text)

url_infos = etrees.xpath('//div[@class="bookmark-list"]/ul/li') for i in url_infos:

url_info = i.xpath('./h2/a/@href')

book_name = i.xpath('./h2/a/text()')[0]

print('开始下载.'+book_name)

# print('http://www.shicimingju.com'+url_info[0])

get_index('http://www.shicimingju.com'+url_info[0])

# 获取书籍目录的函数

def get_index(url):

response = requests.get(url, headers)

etrees = etree.HTML(response.text)

url_infos = etrees.xpath('//div[@class="book-mulu"]/ul/li')

for i in url_infos:

url_info = i.xpath('./a/@href')

# print('http://www.shicimingju.com' + url_info[0])

get_content('http://www.shicimingju.com' + url_info[0])

# 获取书籍内容并写入.txt文件

def get_content(url):

response = requests.get(url, headers)

etrees = etree.HTML(response.text)

title = etrees.xpath('//div[@class="www-main-container www-shadow-card "]/h1/text()')[0]

content = etrees.xpath('//div[@class="chapter_content"]/p/text()')

content = ''.join(content)

book_name=etrees.xpath('//div[@class="nav-top"]/a[3]/text()')[0]

with open(pathname+book_name+'.txt','a+',encoding='utf-8') as f:

f.write(title+'\n\n'+content+'\n\n\n')

print(title+'..下载完成') # 程序入口

if __name__ == '__main__':

url = 'http://www.shicimingju.com/book/'

get_book(url)

控制台查看下载过程;

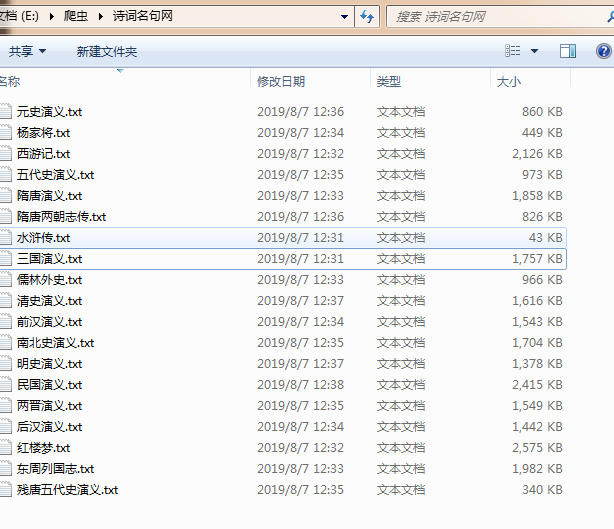

打开文件夹查看是否下载成功;

done.

使用Xpath爬虫库下载诗词名句网的史书典籍类所有文章。的更多相关文章

- 使用Xpath+多进程爬取诗词名句网的史书典籍类所有文章。update~

上次写了爬取这个网站的程序,有一些地方不完善,而且爬取速度较慢,今天完善一下并开启多进程爬取,速度就像坐火箭.. # 需要的库 from lxml import etree import reques ...

- python3爬虫.4.下载煎蛋网妹子图

开始我学习爬虫的目标 ----> 煎蛋网 通过设置User-Agent获取网页,发现本该是图片链接的地方被一个js函数代替了 于是全局搜索到该函数 function jandan_load_im ...

- Python爬虫实例(六)多进程下载金庸网小说

目标任务:使用多进程下载金庸网各个版本(旧版.修订版.新修版)的小说 代码如下: # -*- coding: utf-8 -*- import requests from lxml import et ...

- python爬虫三大解析库之XPath解析库通俗易懂详讲

目录 使用XPath解析库 @(这里写自定义目录标题) 使用XPath解析库 1.简介 XPath(全称XML Path Languang),即XML路径语言,是一种在XML文档中查找信息的语言. ...

- 从0开始学爬虫11之使用requests库下载图片

从0开始学爬虫11之使用requests库下载图片 # coding=utf-8 import requests def download_imgage(): ''' demo: 下载图片 ''' h ...

- Python3 常用爬虫库的安装

Python3 常用爬虫库的安装 1 简介 Windows下安装Python3常用的爬虫库:requests.selenium.beautifulsoup4.pyquery.pymysql.pymon ...

- xpath爬虫实例,爬取图片网站百度盘地址和提取码

某套图网站,套图以封面形式展现在页面,需要依次点击套图,点击广告盘链接,最后到达百度网盘展示页面. 这一过程通过爬虫来实现,收集百度网盘地址和提取码,采用xpath爬虫技术 1.首先分析图片列表页,该 ...

- [转载]AxureRP 7超强部件库下载

很多刚刚开始学习Axure的朋友都喜欢到网上搜罗各种部件库(组件库)widgets library ,但是网络中真正实用的并且适合你使用的少之又少,最好的办法就是自己制作适合自己工作内容的部件库. 这 ...

- 【Android 应用开发】Android 开发环境下载地址 -- 百度网盘 adt-bundle android-studio sdk adt 下载

19af543b068bdb7f27787c2bc69aba7f Additional Download (32-, 64-bit) Package r10 STL debug info androi ...

随机推荐

- 【NPDP笔记】第五章 工具与度量

5.1 创意工具 Ideation 创意开发 创意工具 Scamper Substitute Combine Adapter Modify Put to another use Eliminate ...

- Unity3D 使用SQLite

使用Unity操作SQLite,需要用到三个库文件,分别是Mono.Data.Sqlite.dll和System.Data.dll和Sqlite3.dll,前两个库文件可以在unity中找到,具体步骤 ...

- 头部文件jq嵌入笔记

var headHtml = '<div class="container">' + '<div class="navbar-header"& ...

- 实现简单的string类

摘要 实现了一个string类,包括基本的构造.赋值.判断.大小写等. String API Constructors string(); string(const char& ch); st ...

- [转帖]NSO到底是个什么样的公司?揭秘三叉戟0day的缔造者

NSO到底是个什么样的公司?揭秘三叉戟0day的缔造者 dawner2016-09-07共248912人围观 ,发现 3 个不明物体其他安全报告 https://www.freebuf.com/art ...

- poj1458公共子序列 C语言

/*Common SubsequenceTime Limit: 1000MS Memory Limit: 10000KTotal Submissions: 56416 Accepted: 23516D ...

- js中Function引用类型中一些常见且有用的方法和属性

Function类型 函数由于是Function类型的一个实例,所以函数名就是一个指向函数对象的指针,不会与某个函数死死的连接在一起,这也导致了js中没有真正的重载,但好处是,函数对象可以作为另一个函 ...

- svn-疑难解决

Linux下搭建SVN服务器 https://blog.51cto.com/19940919/2095011 [SVN]出现SVN--Authorization failed错误原因 https:// ...

- emmet html缩写

HTML缩写 Emmet使用类似于CSS选择器的语法来描述元素在生成的树中的位置和元素的属性. 元素 您可以使用元素的名字,如div或p以生成 HTML标签. Emmet没有一组预定义的可用标签名称, ...

- (转)微服务_.NET Core Consul服务发现与治理

原文地址:https://www.cnblogs.com/waynechan/p/9354909.html Consul官网:https://www.consul.io Consul下载地址:http ...