Python数据分析与爬虫

数据分析重要步骤:

1.数据获取

可以进行人工收集获取部分重要数据

可以在各个数据库中导出数据

使用Python的爬虫等技术

2.数据整理

从数据库、文件中提取数据,生成DataFrame对象

采用pandas库读取文件

3.数据处理

数据准备:

对DataFrame对象(多个)进行组装、合并等操作

pandas操作

数据转化:

类型转化、分类(面元等)、异常值检测、过滤等

pandas库的操作

数据聚合:

分组(分类)、函数处理、合并成新的对象

pandas库的操作

4.数据可视化

将pandas的数据结构转化为图表的形式

matplotlib库

5.预测模型的创建和评估

数据挖掘的各种算法:

关联规则挖掘、回归分析、聚类、分类、时序挖掘、序列模式挖掘等

6.部署(得出结果)

从模型和评估中获得知识

知识的表示形式:规则、决策树、知识基、网络权值

原网址:https://blog.csdn.net/qq_35187510/article/details/80078143

爬取网页数据步骤:

简介:

(1)网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者):

是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。其实通俗的讲就是通过程序去获取web页面上自己想要的数据,也就是自动抓取数据。

(2)爬虫可以做什么?

你可以用爬虫爬图片,爬取视频等等你想要爬取的数据,只要你能通过浏览器访问的数据都可以通过爬虫获取。当你在浏览器中输入地址后,经过DNS服务器找到服务器主机,向服务器发送一个请求,服务器经过解析后发送给用户浏览器结果,包括html,js,css等文件内容,浏览器解析出来最后呈现给用户在浏览器上看到的结果

所以用户看到的浏览器的结果就是由HTML代码构成的,我们爬虫就是为了获取这些内容,通过分析和过滤html代码,从中获取我们想要资源。

页面获取

1.根据URL获取网页

- URL处理模块(库)

import urllib.request as req - 创建一个表示远程url的类文件对象

req.urlopen(' ') - 如同本地文件一样读取内容

import urllib.request as req

# 根据URL获取网页:

#http://www.hbnu.edu.cn/湖北师范大学

url = 'http://www.hbnu.edu.cn/'

webpage = req.urlopen(url) # 按照类文件的方式打开网页

# 读取网页的所有数据,并转换为uft-8编码

data = webpage.read().decode('utf-8')

print(data)

2.网页数据存入文件

#将网页爬取内容写入文件

import urllib.request

url = "http://www.hbnu.edu.cn/"

responces = urllib.request.urlopen(url)

html = responces.read()

html = html.decode('utf-8')

fileOb = open('C://Users//ALICE//Documents//a.txt','w',encoding='utf-8')

fileOb.write(html)

fileOb.close()

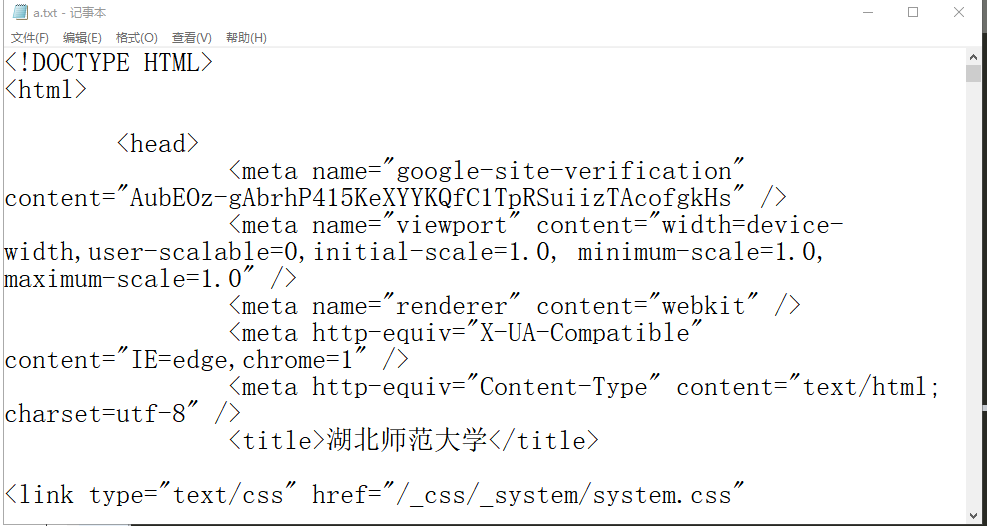

此时我们从网页中获取的数据已保存在我们指定的文件里,如下图所示:

网页获取

从图中可以看出,网页的所有数据都存到了本地,但是我们需要的数据大部分都是文字或者数字信息,而代码对我们来说并没有用处。那么我们接下来要做的是清除没用的数据。

之后需要数据清洗,接下来的请听下回分解。

Python数据分析与爬虫的更多相关文章

- Python爬虫与数据分析之爬虫技能:urlib库、xpath选择器、正则表达式

专栏目录: Python爬虫与数据分析之python教学视频.python源码分享,python Python爬虫与数据分析之基础教程:Python的语法.字典.元组.列表 Python爬虫与数据分析 ...

- 零基础学习Python web开发、Python爬虫、Python数据分析,从基础到项目实战!

随着大数据和人工智能的发展,目前Python语言的上升趋势比较明显,而且由于Python语言简单易学,所以不少初学者往往也会选择Python作为入门语言. Python语言目前是IT行业内应用最为广泛 ...

- 【Python数据分析】Python3多线程并发网络爬虫-以豆瓣图书Top250为例

基于上两篇文章的工作 [Python数据分析]Python3操作Excel-以豆瓣图书Top250为例 [Python数据分析]Python3操作Excel(二) 一些问题的解决与优化 已经正确地实现 ...

- Python即时网络爬虫项目启动说明

作为酷爱编程的老程序员,实在按耐不下这个冲动,Python真的是太火了,不断撩拨我的心. 我是对Python存有戒备之心的,想当年我基于Drupal做的系统,使用php语言,当语言升级了,推翻了老版本 ...

- Python即时网络爬虫:API说明

API说明——下载gsExtractor内容提取器 1,接口名称 下载内容提取器 2,接口说明 如果您想编写一个网络爬虫程序,您会发现大部分时间耗费在调测网页内容提取规则上,不讲正则表达式的语法如何怪 ...

- 【读书笔记与思考】《python数据分析与挖掘实战》-张良均

[读书笔记与思考]<python数据分析与挖掘实战>-张良均 最近看一些机器学习相关书籍,主要是为了拓宽视野.在阅读这本书前最吸引我的地方是实战篇,我通读全书后给我印象最深的还是实战篇.基 ...

- 手把手教你从零搭建Python数据分析环境

由于最近再做推荐系统的特征处理,需要借助一些工具来筛选特征.最初使用了R,R的安装很简单,而且API也很容易使用,直接就能出图.后来,发现很多人在python和R之间做选择,所以我也在两个工具间摇摆不 ...

- 零基础学习Python数据分析

网上虽然有很多Python学习的教程,但是大多是围绕Python网页开发等展开.数据分析所需要的Python技能和网页开发等差别非常大,本人就是浪费了很多时间来看这些博客.书籍.所以就有了本文,希望能 ...

- 【python数据分析实战】电影票房数据分析(一)数据采集

目录 1.获取url 2.开始采集 3.存入mysql 本文是爬虫及可视化的练习项目,目标是爬取猫眼票房的全部数据并做可视化分析. 1.获取url 我们先打开猫眼票房http://piaofang.m ...

随机推荐

- Linux shell自动读mongo数据、远程获取文件大小示例脚本

1.示例1 功能:对mongoDB导出数据,根据sid的不同状态进行统计 技术点:shell bash 读写文件.字符串截取.函数.用多个文件提到的map.grep查找并赋值给变量 #!/bin/b ...

- SSM整合教程

接着一直next下去 创建各个目录 pom.xml文件中引入各种包 <?xml version="1.0" encoding="UTF-8"?> & ...

- 机器学习(八)--------支持向量机 (Support Vector Machines)

与逻辑回归和神经网络相比,支持向量机或者简称 SVM,更为强大. 人们有时将支持向量机看作是大间距分类器. 这是我的支持向量机模型代价函数 这样将得到一个更好的决策边界 理解支持向量机模型的做法,即努 ...

- JVM的监控工具之jps

jps的功能和ps命令相似:可列出正在运行的虚拟机进程,并显示虚拟机执行主类(Main Class,main()函数所在的类)名称以及这些进程的本地虚拟机唯一ID(Local Virtual Mach ...

- v-model绑定一个对象,组件内部分别负责不同字段的场景实现

我们知道v-model对于单个property双向数据绑定非常有用,保持父子组件之间的数据传递和同步,但也有很多场景下希望一个组件能够处理多个数据字段,这时就有一些小小技巧了. https://sim ...

- Python对csv排序

#/usr/bin/evn python # -*- coding: utf-8 -*- import sys from operator import itemgetter # input_file ...

- 面试前必须要知道的21道Redis面试题

1.使用redis有哪些好处? 速度快,因为数据存在内存中,类似于HashMap,HashMap的优势就是查找和操作的时间复杂度都是O(1) 支持丰富数据类型,支持string,list,set,so ...

- Java生鲜电商平台-商品无限极目录的设计与架构

Java生鲜电商平台-商品无限极目录的设计与架构 说明:任何一个商品都应该是先属于某一个目录,然后在目录中添加商品,目录理论上最多支持三级,因为级别太多,不容易管理.但是设计中需要设计无限制的级别. ...

- vue笔记(一)

Vue的开发 一丶下载 # 中文下载地址: https://cn.vuejs.org/ # 使用方式: # 1. 单独使用 vue.min.js.文件 # 2. 结合node.js使用集成工具 二丶v ...

- AJAX小示例

一. 基本内容 定义:AJAX(Asynchronous Javascript And XML)翻译成中文就是"异步的Javascript和XML",即使用Javascript语言 ...