python爬虫--用xpath爬豆瓣电影

- 将目标网站下的页面抓取下来

- 将抓取下来的数据根据一定规则进行提取

- 将目标网站下的页面抓取下来

import requests

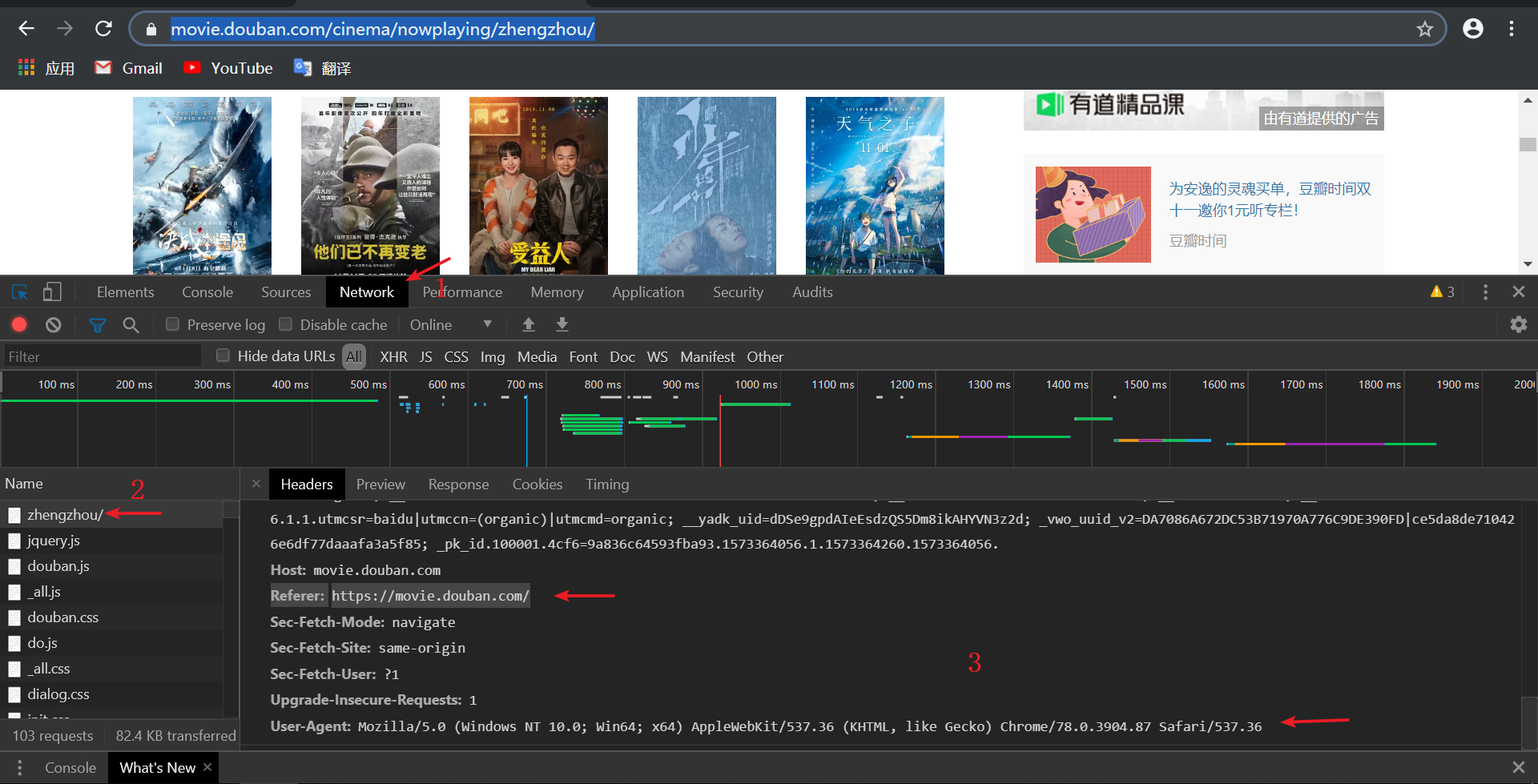

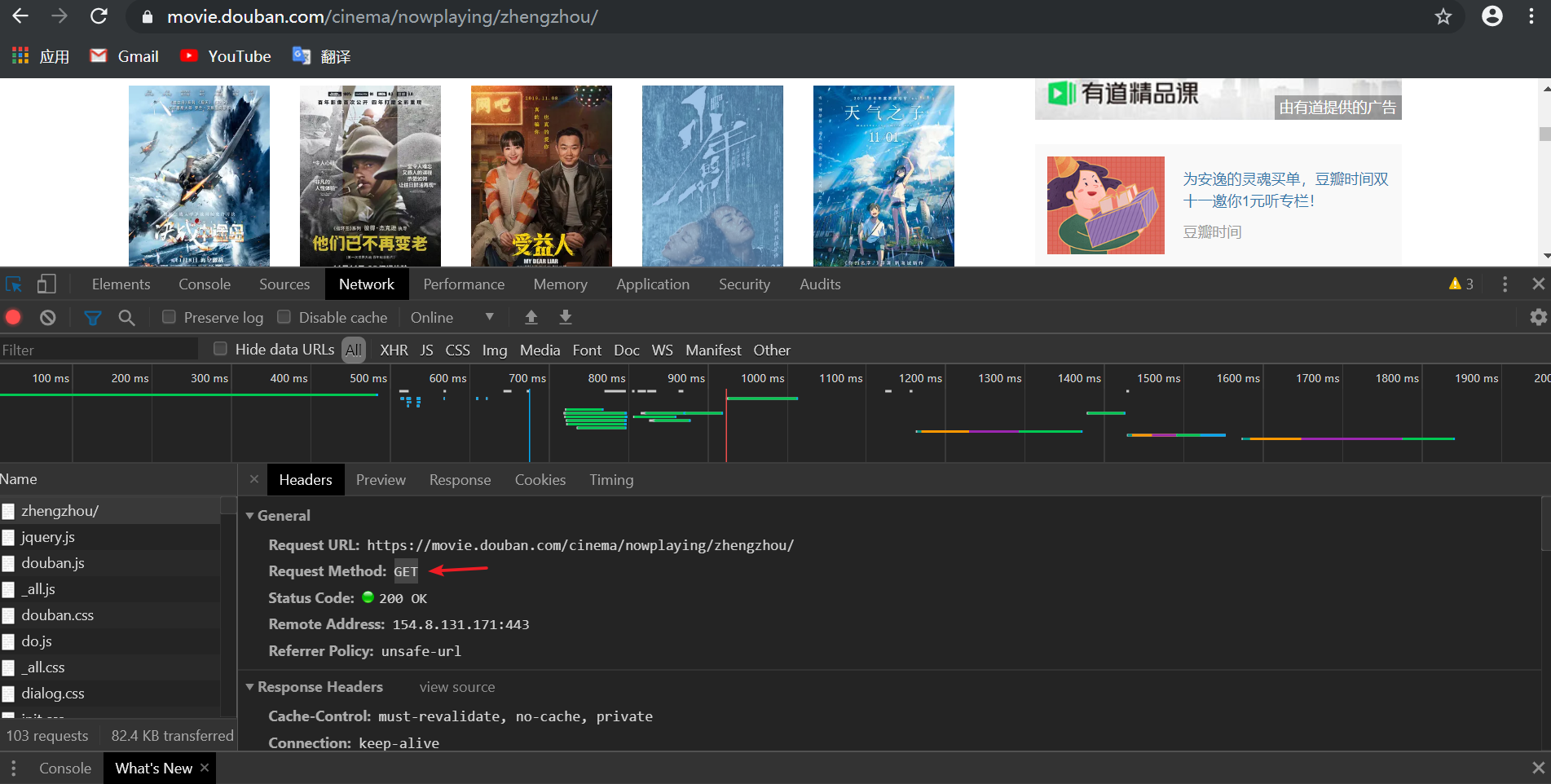

headers = {

#请求身份/默认为User-Agent:python

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.87 Safari/537.36',

'Referer': 'https://movie.douban.com/'

}

url = 'https://movie.douban.com/cinema/nowplaying/zhengzhou/'

response = requests.get(url,headers=headers) #响应

#print(response.text)

text = response.text

from lxml import etree

html = etree.HTML(text)

ul = html.xpath("//ul[@class='lists']")[0]

#print(etree.tostring(ul,encoding='utf-8').decode('utf-8'))

lis = ul.xpath('./li')

for li in lis:

#print(etree.tostring(li,encoding='utf-8').decode('utf-8'))

title = li.xpath('@data-title')[0]

#print(title)

score = li.xpath('@data-score')[0]

# print(score)

poster = li.xpath('.//img/@src')[0]

# print(poster)

request.urlretrieve(poster, 'D:/A/' + score + title + '.jpg')

下载到D盘下A目录中,文件名为 评分+影名.jpg

2.显示进度条

fns_num = 1

num = len(lis)

for li in lis:

···

print("\r完成进度: {:.2f}%".format(fns_num * 100 / num), end="")

fns_num += 1

#coding=UTF-8 import requests

from lxml import etree

from urllib import request headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.87 Safari/537.36',

'Referer': 'https://movie.douban.com/'

}

url = 'https://movie.douban.com/cinema/nowplaying/zhengzhou/'

response = requests.get(url,headers=headers)

# print(response.text)

text = response.text html = etree.HTML(text)

ul = html.xpath("//ul[@class='lists']")[0]

# print(etree.tostring(ul,encoding='utf-8').decode('utf-8'))

lis = ul.xpath("./li")

# movies = []

fns_num = 1

num = len(lis)

for li in lis:

# print(etree.tostring(li,encoding='utf-8').decode('utf-8'))

title = li.xpath('@data-title')[0]

# print(title)

score = li.xpath('@data-score')[0]

# print(score)

poster = li.xpath('.//img/@src')[0]

# print(poster) request.urlretrieve(poster, 'D:/A/' + score + title + '.jpg')

print("\r完成进度: {:.2f}%".format(fns_num * 100 / num), end="")

fns_num += 1

python爬虫--用xpath爬豆瓣电影的更多相关文章

- 一个简单python爬虫的实现——爬取电影信息

最近在学习网络爬虫,完成了一个比较简单的python网络爬虫.首先为什么要用爬虫爬取信息呢,当然是因为要比人去收集更高效. 网络爬虫,可以理解为自动帮你在网络上收集数据的机器人. 网络爬虫简单可以大致 ...

- Python爬虫教程-17-ajax爬取实例(豆瓣电影)

Python爬虫教程-17-ajax爬取实例(豆瓣电影) ajax: 简单的说,就是一段js代码,通过这段代码,可以让页面发送异步的请求,或者向服务器发送一个东西,即和服务器进行交互 对于ajax: ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- python简单爬豆瓣电影排名

爬豆瓣电影 网站分析: 1 打开https://movie.douban.com,选择 [排行榜],然后随便选择一类型,我这里选择科幻 2 一直浏览网页,发现没有下一的标签,是下滑再加载的,可 ...

- 非常全的一份Python爬虫的Xpath博文

非常全的一份Python爬虫的Xpath博文 Xpath 是 python 爬虫过程中非常重要的一个用来定位的一种语法. 一.开始使用 首先我们需要得到一个 HTML 源代码,用来模拟爬取网页中的源代 ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- python爬虫:XPath语法和使用示例

python爬虫:XPath语法和使用示例 XPath(XML Path Language)是一门在XML文档中查找信息的语言,可以用来在XML文档中对元素和属性进行遍历. 选取节点 XPath使用路 ...

- Python爬虫之xpath语法及案例使用

Python爬虫之xpath语法及案例使用 ---- 钢铁侠的知识库 2022.08.15 我们在写Python爬虫时,经常需要对网页提取信息,如果用传统正则表达去写会增加很多工作量,此时需要一种对数 ...

随机推荐

- [C/C++]详解结构体

引子 设计程序时,最重要的步骤之一就是选择表示数据的方法.在许多情况下,简单变量甚至是数组还不够.为此,C提供了结构变量(structure variable)提高表示数据的能力,它能够创造新的形式. ...

- 怎么用CDR来批量导出图片

我们通过CorelDRAW上方菜单栏"布局"中的"插入页面"可以创建多个页面,同时编辑,适合比如书籍排版,杂志排版等等这些需要进行多页面编辑的工作. 图1:CD ...

- Python GUI之Tkiner实战

前言 Tkinter 是 Python 的标准 GUI 库.Python 使用 Tkinter 可以快速的创建 GUI 应用程序. 由于 Tkinter 是内置到 python 的安装包中.只要安装好 ...

- 记XShell无法连接虚拟机中的Linux,但Linux系统中可以连接外网。

如题. 原本设置如下: 本地机IP 为192.168.43.XXX VMWare中"虚拟机网络编辑器"中子网设置为192.168.39.0. 虚拟机中IP为192.168.39.1 ...

- Contest 991

A 先判合法然后容斥. 时间复杂度 \(O\left(1\right)\). B 贪心选最小的实验做成 \(5\) 分. 时间复杂度 \(O\left(n\right)\). 剩下的鸽了.

- SpringBoot整合Elasticsearch7

SpringBoot连接ElasticSearch有以下种方式, TransportClient,9300端口,在 7.x 中已经被弃用,据说在8.x 中将完全删除 restClient,9200端口 ...

- C语言初级编程实践:2048小游戏

大部分同学学习C语言编程以后不知道能通过什么样的项目才可以锻炼自己的思维功力,2048相信大家都应该熟悉,不管是手机上还是网页版的相信大家都玩过,这个简单的控制台版本的游戏是我曾经在伟易达上班时一个嵌 ...

- 深度阅读:大学生课外知识补充,这些课堂上不教的 C++ 的基本特性你都知道吗?

来源:知乎 王师傅的专栏 C++ 作为一个历史久远,功能丰(yong)富(zhong)而且标准与时俱进的语言,理应什么都能做,什么都用得起来.不过日常使用中我们初学者真的好像只学到了其中的一部分,对于 ...

- schema设计陷阱

1.太多的列: mysql的存储引擎api工作时需要在服务器层和存储引擎层之间通过行缓冲格式拷贝数据,然后在服务器层将缓冲内容解码成各个列.从行缓冲中将编码过的列转换成行数据结构的操作代价是非常高的. ...

- 【mq读书笔记】消息确认(失败消息,定时队列重新消费)

接上文的集群模式,监听器返回RECONSUME_LATER,需要将将这些消息发送给Broker延迟消息.如果发送ack消息失败,将延迟5s后提交线程池进行消费. 入口:ConsumeMessageCo ...