解密Prompt系列30. LLM Agent之互联网冲浪智能体

这一章我们介绍能自主浏览操作网页的WebAgent们和相关的评估数据集,包含初级任务MiniWoB++,高级任务MIND2WEB,可交互任务WEBARENA,多模态WebVoyager,多轮对话WebLINX,和复杂任务AutoWebGLM。

MiniWoB++数据集

- Reinforcement Learning on Web Interfaces using Workflow-Guided Exploration

- https://miniwob.farama.org/

这两年webagent的论文里几乎都能看到这个评测集的影子,但这篇论文其实是2018年就发表了。所以这里我们只介绍下数据集的信息~

MiniWoB++是基于gymnasium的模拟web环境,它在OpenAI的MiniWoB数据集上补充了更多复杂交互,可变页面等网页交互行为,最终得到的100个网页交互的评测集。一些组件的Demo示例如下

MiniWoB++数据集的局限性

- 非实际web页面而而是模拟web页面

- 页面被极大程度简化成了单独的交互组件,复杂程度低

- 指令是低级指令,直接描述如何和网页交互,例如下图的指令"选择下拉列表中的United Arab Emirates并点击提交"。而高级任务指令应该是"选择United Arab Emirates"

MIND2WEB

- MIND2WEB: Towards a Generalist Agent for the Web

- https://osu-nlp-group.github.io/Mind2Web/

数据集

MIND2WEB数据集在MiniWoB++数据集上做了以下几点改良

- 真实网页而非模拟组件,如下是美联航的首页

- 高级任务指令而非低级指令:例如"Search for all alternative concerts taking place in New York"

- 网页数据全面:包含了HTML代码,DOM文件和HAR日志,snapshot截图和TRACE

- 多领域任务:5大类31个小类,总共137个网站,并基于种子人工构造了2350个指令样本,5大类分别包括旅游,信息,娱乐,购物,通用服务类

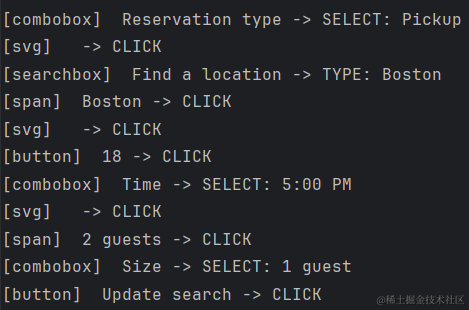

让我们来具体看一个样本,任务指令=Check for pickup restaurant available in Boston, NY on March 18, 5pm with just one guest,Label是完成该指令的行为序列,每一步行为由(Target Element, Operation)构成,这里支持三种最常用的OPCLICK, TYPE,SELECT,行为序列如下

MIND2WEB采用了4个评估指标

- Element Accuracy:评估操作元素例如Botton的正确率

- Operation F1:评估对元素的操作准召,这里是token-level的F1计算因为有键入数据等操作

- Step Success Rate: 单步操作正确需要Element和Operation同时正确

- Task Success Rate:任务正确需要每一步都正确

Mind2WEB数据集主要局限性是只有数据采集时的网页静态页面HTML,没有后续行为的动态交互数据

MindAct

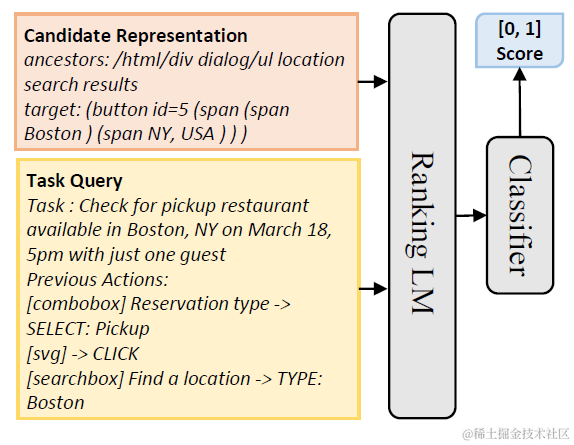

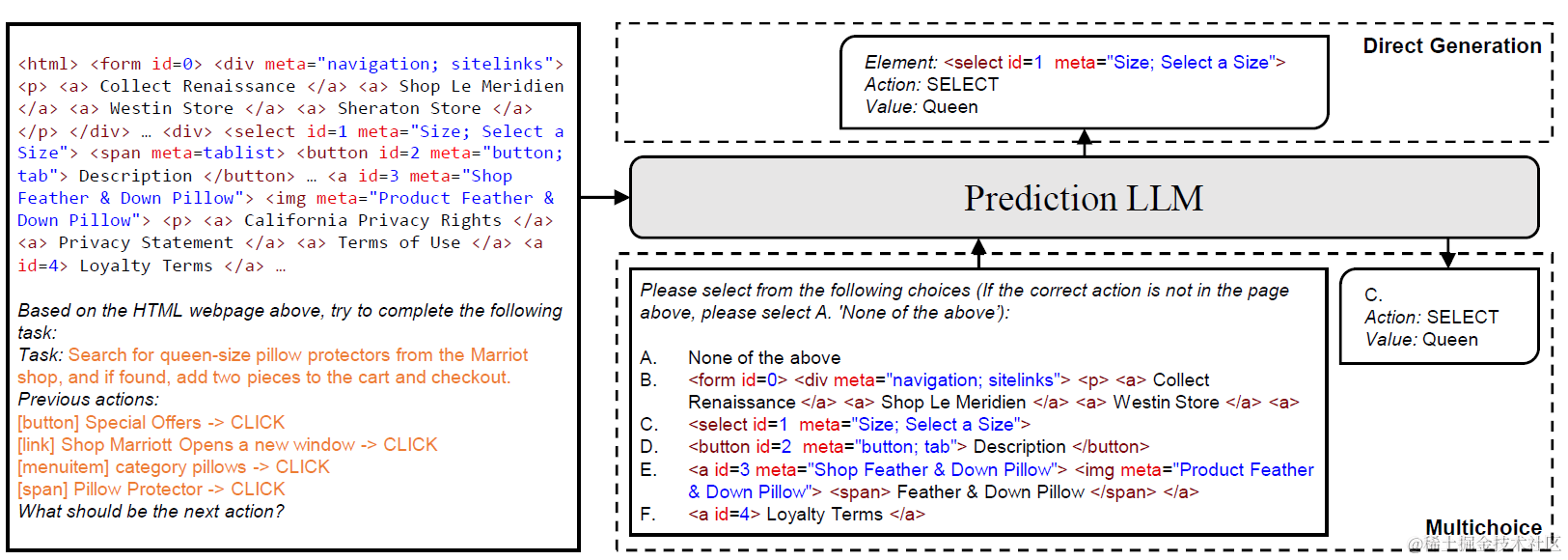

MINDAct框架因为是单一文本模态,因此使用HTML代码和DOM文件来作为网页的观测数据,框架比较简单由两个部分组成:元素排序生成候选,基于候选的多项选择生成行为

- Candidate Ranking

候选生成部分是一个二分类的打分模型。输入是任务指令+历点史Action+DOM元素,输出是每个DOM元素的候选概率。这里DOM元素的文本表征除了元素本身的信息,还从DOM文件树里面获取了parent和child节点的信息,拼接作为每个节元素的表征。如下

这里论文是通过随机负样本采样,训练了DeBERTa模型作为排序模型,测试集Top50召回在85%+。

- Action Prediction

基于上面元素排序返回的Top-K候选Element,会先对整个HTML进行裁剪,只保留候选元素前后的HTML文档。这样可以有效降低大模型的输入长度和复杂度,但对上面排序模型的召回要求较高。

之后会基于Top-K 候选,裁剪HTML,和历史的Action,选择下一步的的Action和Value。于是基于复杂HTML直接生成Action和Value的复杂任务,被简化成了多项选择的QA任务。这里论文是微调了Flan-T5来完成多项选择任务,也同时对比了直接使用GPT3.5和GPT4。

WEBARENA数据集

- WEBARENA: A REALISTIC WEB ENVIRONMENT FOR BUILDING AUTONOMOUS AGENS

- https://webarena.dev/

针对Mind2WEB只和静态网站状态交互的问题,WEBARENA通过构建仿真网站,构建了真实,动态,并且可复现的网络环境来和智能体进行交互。论文选择了电商,论坛,github,CMS等四类网站类型,并使用网站真实数据来构建模拟环境。

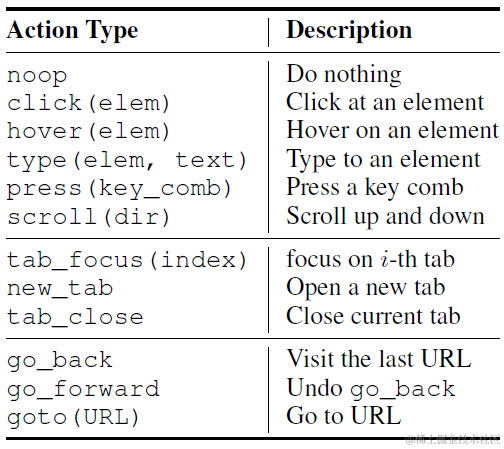

并且对比Mind2WEB的3种常见交互,支持更多的交互操作,并且因为是动态页面因此支持多tab切换的操作,支持的opeeration类型如下

数据集构成

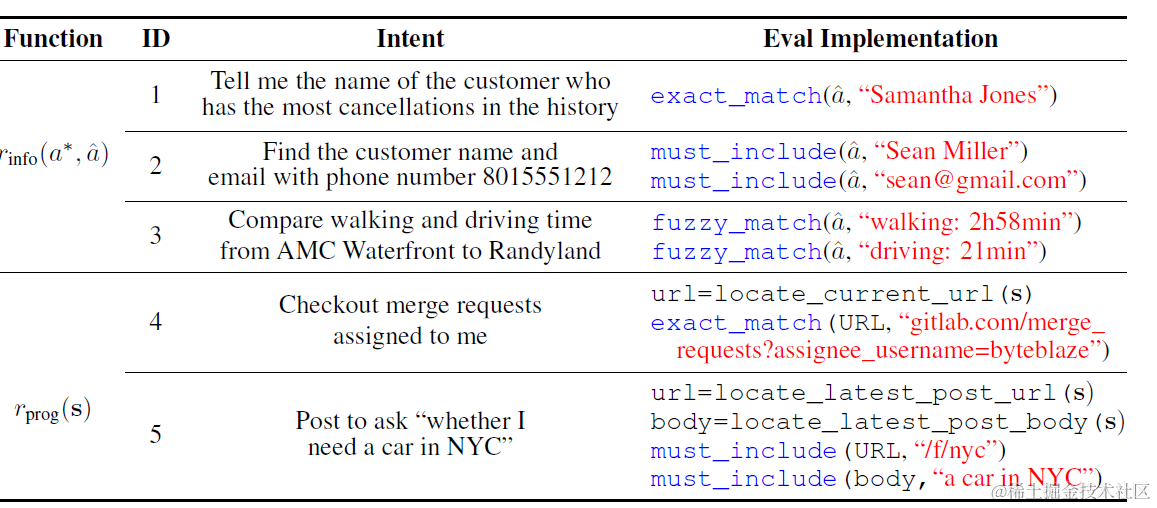

- High Level 任务指令:包含数据查询,网站导航,内容创建等3个主要任务意图

- 812个测试样本:人工+chatgpt构建,从241个任务模板中创建出来,模板例如"create a {{site1}} account identical to my {{site2}} one"

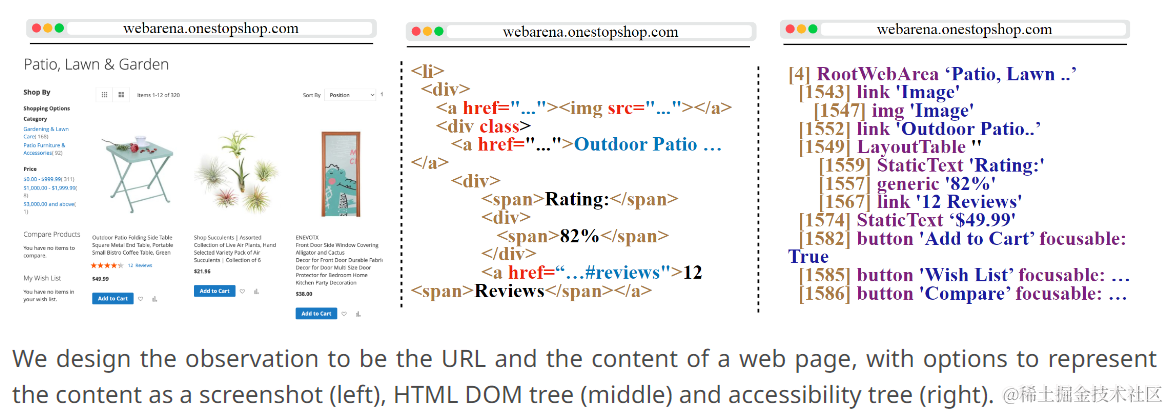

- 网页数据:HTML + DOM + screenshot + Accessibility Tree(DOM的有效子集)

评估指标上相比Mind2WEB,WEBARENA同样使用task success rate作为评估指标,把token-level的F1计算进行了优化,加入了operation是否正确的检测方案。核心就是部分操作需要键入内容,而这部分内容不能直接和标注做精准匹配,因此WEBARENA分成了需要精准匹配的答案(exact match),只要包括核心信息即可(must include)和基于大模型做语义相似判断的(fuzzy match)这三类评估类型,对不同的样本进行评估。

WebVoyager

- WebVoyager: Building an End-to-end Web Agent with Large Multimodal Models

- https://github.com/MinorJerry/WebVoyager?tab=readme-ov-file

数据集

同样是动态网页交互,WebVoyager没有采用模拟网页数据,而是使用Selenium直接操控web浏览器行为和真实网页进行交互。于是同时满足了动态交互和真实网络环境的要求。

论文选取了15个有代表性的网站:Allrecipes, Amazon, Apple,ArXiv, BBC News, Booking, Cambridge Dictionary,Coursera, ESPN, GitHub, Google Flights,Google Map, Google Search, Huggingface, and Wolfram Alpha。

指令样本是基于Mind2Web的数据集作为种子,然后基于GPT4使用Self-Instruct来生成新的任务指令,最后使用人工校验和筛选。最终得到了每个网站40+的指令,总共643个评估任务。

评估指标和webARENA保持一致,都是采用任务成功率作为评估指标。

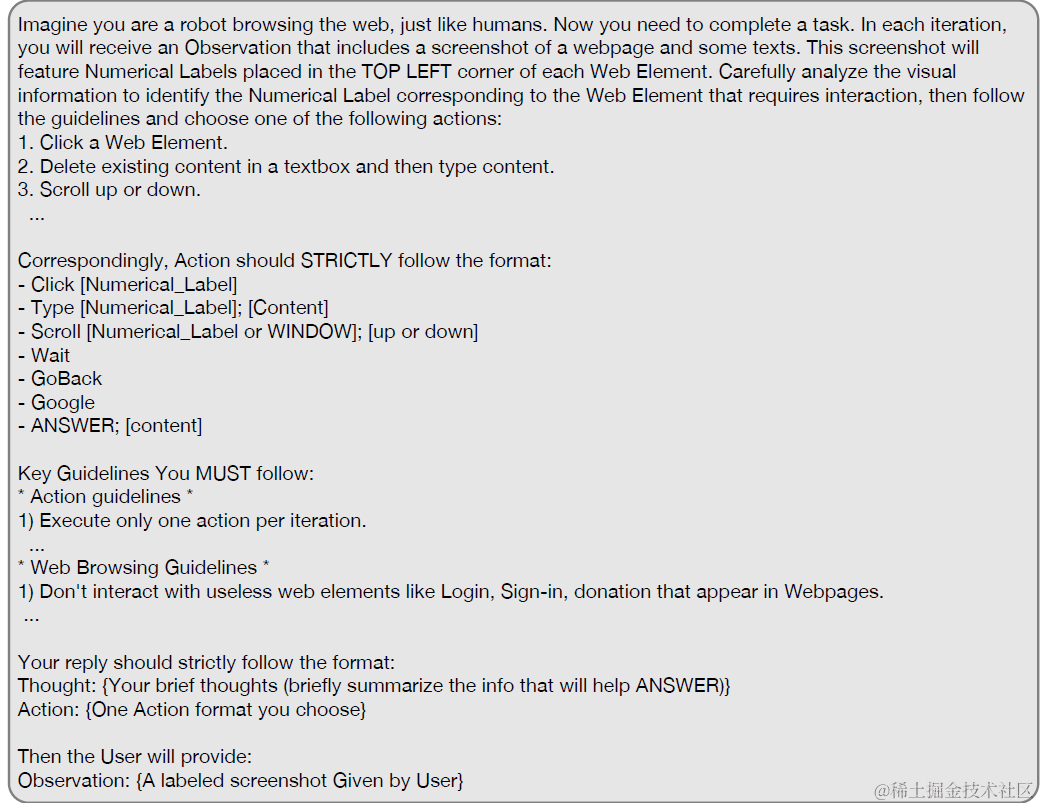

Agent

这里简单说下agent实现,WebVoyager和前面数据集的主要差异是加入了多模态模型GPT4—V的尝试。不再使用accessibility Tree的文本输入,而是直接和网页的snapshot进行交互。

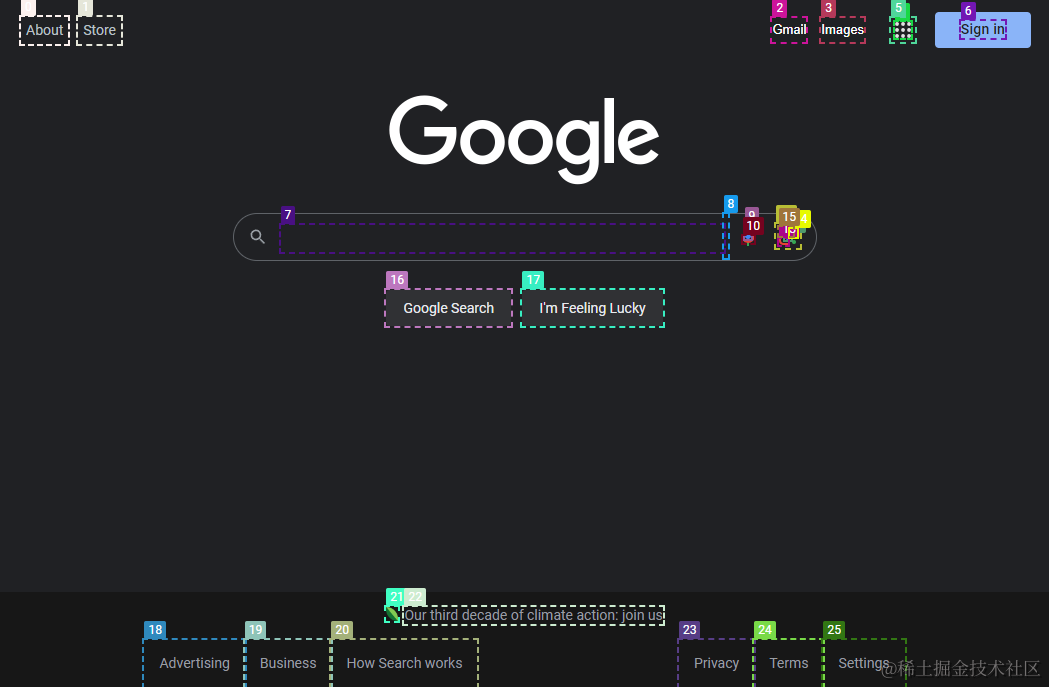

这里论文采用了set-of-Mark Prompting的技术,来解决GPT4-V模型visual grounding的问题(模型对图片中细粒度物体的区分度有限,当输出是图片中局部物体例如按钮时准确率不高的问题)。SOM是先用SAM等分割模型对图片进行分割,这里主要是识别出图片上可交互的按钮和区域,使用bounding box进行圈选,并使用序号对区域进行标记。通过标记来帮助GPT4-V更精准的识别可交互区域。

这里论文使用了GPT-4V-ACT,JS DOM auto-labeler来识别网页中的所有可交互元素并进行标记,来作为GPT4-V的输入,如下

然后基于上面的标记图片输入,和以下ReACT的prompt指令,让GPT4V生成每一步的交互操作。基于模型推理结果会直接操作网页,并获取新的网页snapshot作为下一步的输入。

WebLINX

- WebLINX: Real-World Website Navigation with Multi-Turn Dialogue

- https://github.com/McGill-NLP/WebLINX

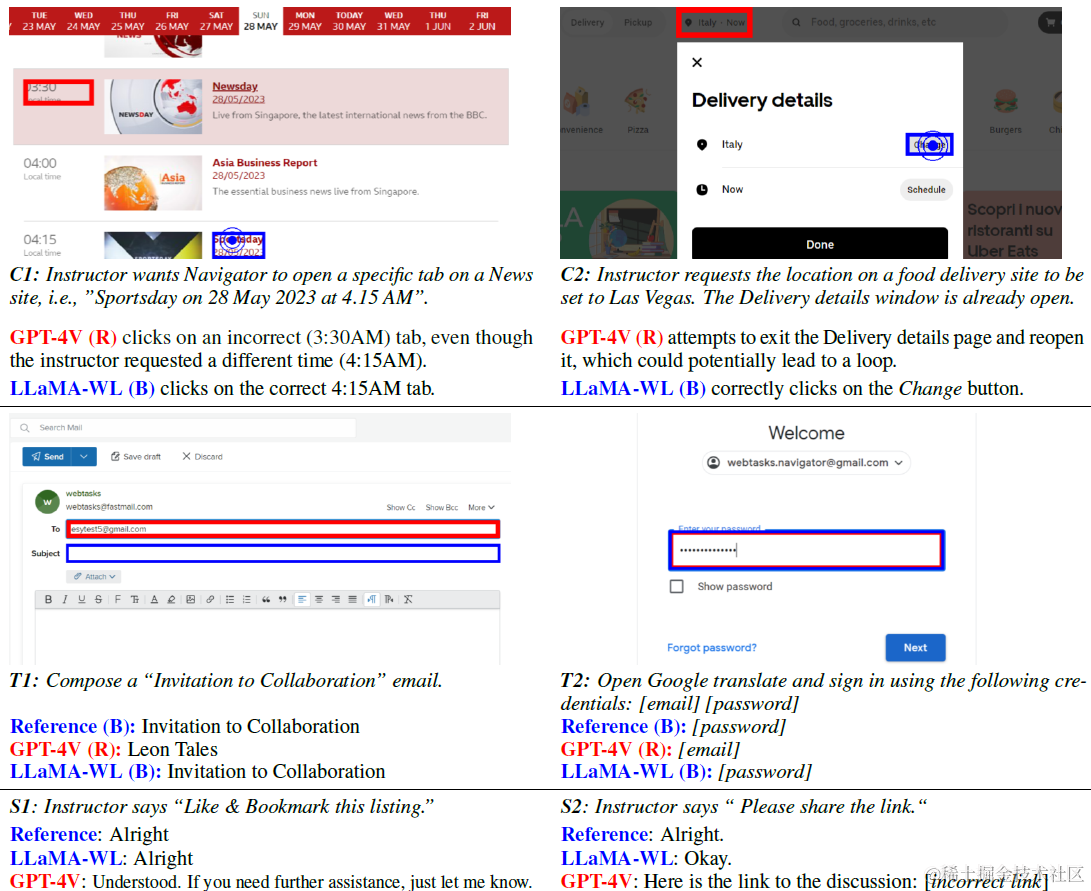

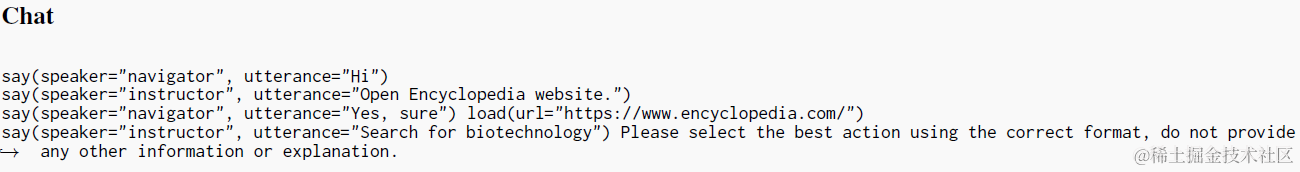

对比前面的MIND2WEB,WebArena和webVoyager,webLLINX加入了和用户的多轮对话交互,也就是从自主智能体向可交互智能体的转变。虽然放弃了自主,但有了人类的监督,可能可以达到更高的任务完成度。

WebLINX的数据集,包括8大类,50个小类总共155个真实网页,总共构建了2337个指令样本。 因为是对话式交互,所以指令类型会和以上的几个数据集存在明显的差异,不再是任务型指令而是步骤操作型的指令,如下图

agent部分论文更多是对比了文本模态vs多模态,微调vsprompt的效果,实现细节不太多这里就不细说了

AutoWebGLM

- AutoWebGLM: Bootstrap And Reinforce A Large Language Model-basedWeb Navigating Agent

- https://github.com/THUDM/AutoWebGLM

AutoWebGLM是智谱最近才发布的webagent论文,包括比较全面的微调数据集构建和微调方案,并发布了新的评测集。论文提出AutowebGLM的数据集有三个主要优点

- 更高质量的web交互训练数据:人标很难构架大规模训练数据,这里使用模型标注并通过技巧提高模型标注准确率

- 统一10类交互行为:其实和WEBARENA基本一致

- HTML简化裁剪方案:构建可交互元素树

数据集

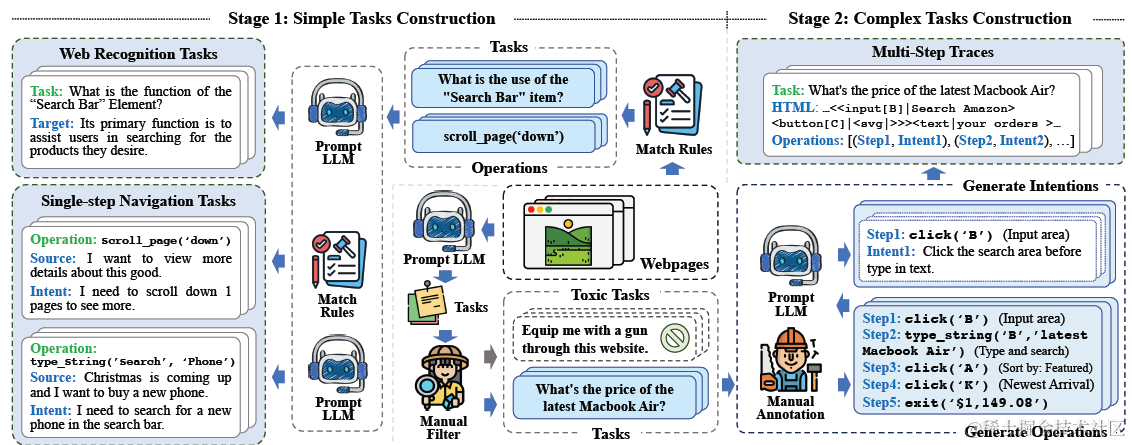

AutoWebGLM的微调数据集包含由易到难的三种任务:web recognition,single-step task,multi-step task。这里也是纯HTML文本模态的数据集。除了以下全新的三类样本,论文还合并了MiniWoB++和Mind2Web的训练集。

web Recognition

网页识别样本构建,是直接从HTML中提取可交互元素,然后基于元素构建简化的HTML输入。然后Input是网页元素功能的相关提问,输出是GPT的回答,例如"Search Bar是用来干什么的",模型回答“它是用来帮助用户搜索产品的”。这部分样本用来帮助模型理解HTML。

Single-step task(Simple)

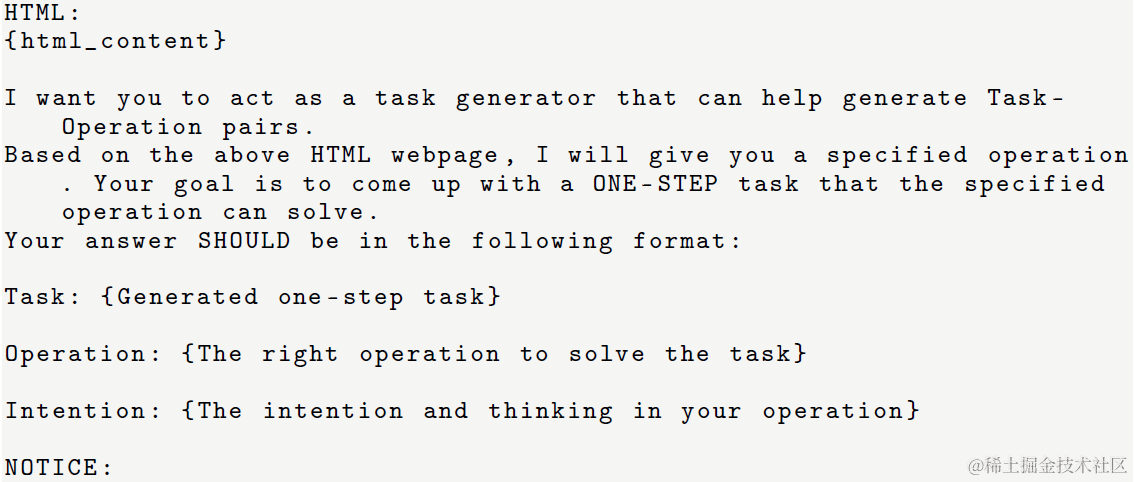

简单任务是单步操作的网页交互。这里论文的构建比较巧妙,考虑到之前的论文已经论证了即便是GPT4在webagent这个任务上的执行准确率也有限,那直接使用GPT4来构建样本肯定是不可行的。因此论文采用了反向标注,既基于HTML中抽取出的可交互元素例如“scroll_page('down')”,让GPT4来方向生成对应的意图和用户指令,例如我需要向下滑网页浏览更多。 这样可以得到准确率更高的样本,模型生成意图和指令的prompt如下

Multi-Step task(Complex)

复杂任务涉及和网页的多步交互。这里论文使用了Evol-Instruct来构建复杂任务指令(不熟悉的同学看这里解密Prompt系列17.LLM对齐方案再升级), 每个网页模型生成50个指令,再人工筛选20个。

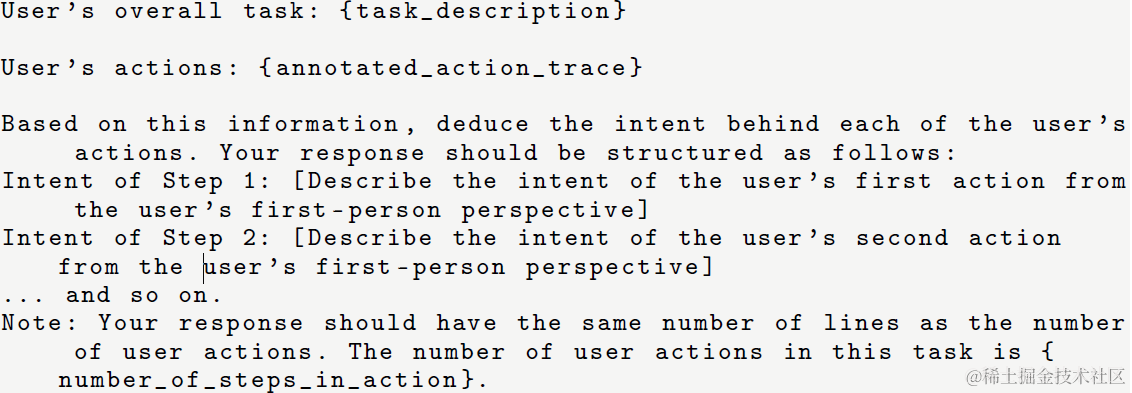

考虑模型生成准确率不高,这里得多步交互,论文使用人工执行,并用浏览器插件捕捉用户交互行为的方案。这里为了在行为链路之外,同时获得模型COT思考链路,用来提高后面的模型训练效果。论文使用以下prompt,让大模型基于人工完整的行为链路,生成每一步的执行意图。

最终的AutoWebBench评测集只使用了多步任务的子集,也就是复杂指令来评测模型效果。

微调

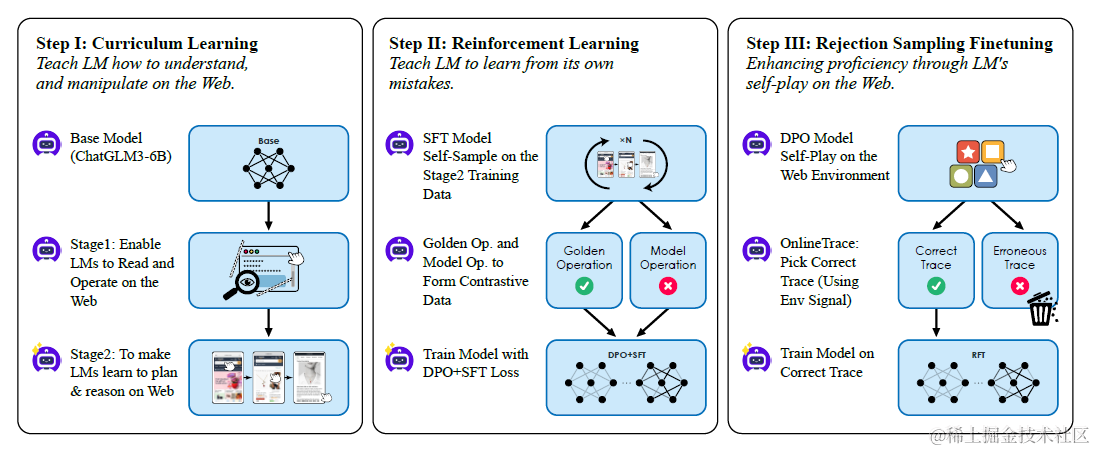

基于以上的训练数据,论文采用了多阶段训练微调ChatGLM3

- SFT:第一步是指令微调,使用以上训练集,采用Curriculum Leanring的训练策略,既模仿人类学习,由易到难的训练样本进行逐步训练。先使用网页识别和单步任务训练,再使用多步任务数据训练。

- RL:第二步是强化学习,用来降低SFT部分模型学习的过度模仿和幻觉。这里论文采用了Self-Sampling来构建DPO需要的正负样本对,既使用正确答案作为正样本,使用模型预测错误的作为负样本,使用DPO和SFT的混合loss进行进一步的训练。

- RFT: 第三步是基于MiniWoB++和WebARENA虚拟环境,使用以上训练好的DPO模型构建了额外的训练样本。这里采用拒绝采样,既使用模型尝试N次,选取成功(规则标注或环境自带识别)的执行路径作为训练样本进行训练。相当于是把Rejection-Sampling的效果再训练进模型中。

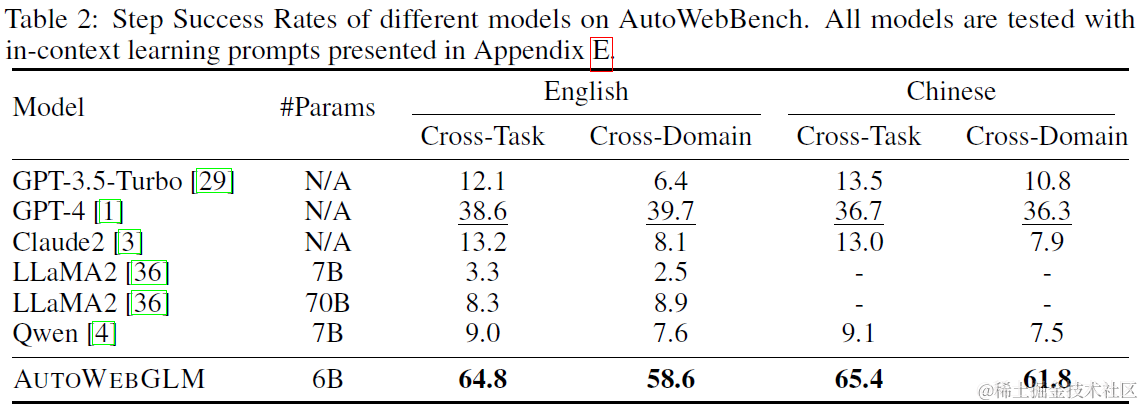

效果上在AutoWebBench上,微调后的6B模型可以显著超过GPT4,和更大的LLAMA2基座模型,拥有更高的任务单步执行成功率。

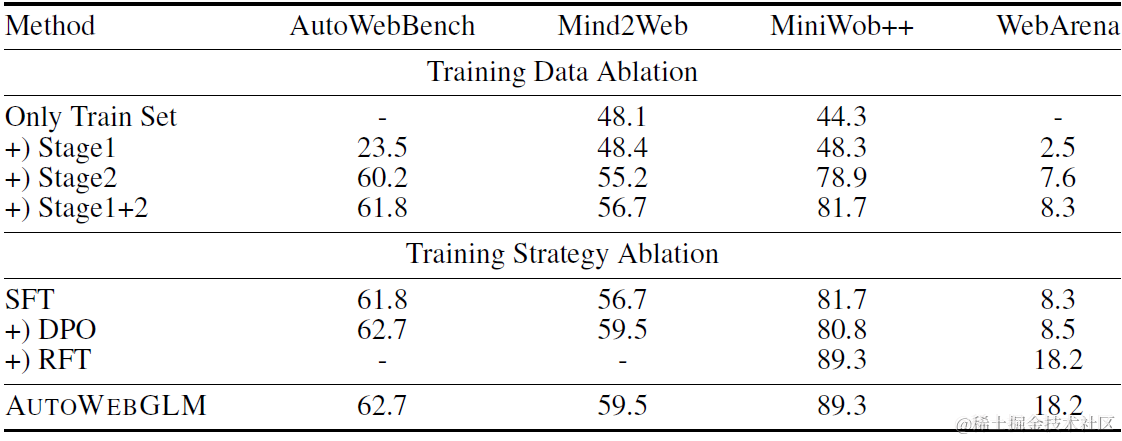

同时论文做了消融实验来验证以上多阶段微调和三种训练样本的效果。实验显示,由易到难的训练数据对模型有较大提升,RFT在进一步训练的miniWob++和WebArena上有显著提升,但RL-DPO的效果不太明显。

想看更全的大模型相关论文梳理·微调及预训练数据和框架·AIGC应用,移步Github >> DecryPrompt

解密Prompt系列30. LLM Agent之互联网冲浪智能体的更多相关文章

- 解密Prompt系列6. lora指令微调扣细节-请冷静,1个小时真不够~

上一章介绍了如何基于APE+SELF自动化构建指令微调样本.这一章咱就把微调跑起来,主要介绍以Lora为首的低参数微调原理,环境配置,微调代码,以及大模型训练中显存和耗时优化的相关技术细节 标题这样写 ...

- 解密prompt系列5. APE+SELF=自动化指令集构建代码实现

上一章我们介绍了不同的指令微调方案, 这一章我们介绍如何降低指令数据集的人工标注成本!这样每个人都可以构建自己的专属指令集, 哈哈当然我也在造数据集进行时~ 介绍两种方案SELF Instruct和A ...

- 解密Prompt系列3. 冻结LM微调Prompt: Prefix-Tuning & Prompt-Tuning & P-Tuning

这一章我们介绍在下游任务微调中固定LM参数,只微调Prompt的相关模型.这类模型的优势很直观就是微调的参数量小,能大幅降低LLM的微调参数量,是轻量级的微调替代品.和前两章微调LM和全部冻结的pro ...

- 解密Prompt系列2. 冻结Prompt微调LM: T5 & PET & LM-BFF

这一章我们介绍固定prompt微调LM的相关模型,他们的特点都是针对不同的下游任务设计不同的prompt模板,在微调过程中固定模板对预训练模型进行微调.以下按时间顺序介绍,支持任意NLP任务的T5,针 ...

- 解密Prompt系列4. 升级Instruction Tuning:Flan/T0/InstructGPT/TKInstruct

这一章我们聊聊指令微调,指令微调和前3章介绍的prompt有什么关系呢?哈哈只要你细品,你就会发现大家对prompt和instruction的定义存在些出入,部分认为instruction是promp ...

- .NET Core加解密实战系列之——消息摘要与数字签名算法

目录 简介 功能依赖 消息摘要算法 MD算法 家族发展史 应用场景 代码实现 MD5 示例代码 SHA算法 应用场景 代码实现 SHA1 SHA256 示例代码 MAC算法 HMAC算法的典型应用 H ...

- .NET Core加解密实战系列之——使用BouncyCastle制作p12(.pfx)数字证书

简介 加解密现状,编写此系列文章的背景: 需要考虑系统环境兼容性问题(Linux.Windows) 语言互通问题(如C#.Java等)(加解密本质上没有语言之分,所以原则上不存在互通性问题) 网上资料 ...

- Java 加解密技术系列文章

Java 加解密技术系列之 总结 Java 加解密技术系列之 DH Java 加解密技术系列之 RSA Java 加解密技术系列之 PBE Java 加解密技术系列之 AES Java 加解密技术系列 ...

- 11.Java 加解密技术系列之 总结

Java 加解密技术系列之 总结 序 背景 分类 常用算法 原理 关于代码 结束语 序 上一篇文章中简单的介绍了第二种非对称加密算法 — — DH,这种算法也经常被叫做密钥交换协议,它主要是针对密钥的 ...

- 10.Java 加解密技术系列之 DH

Java 加解密技术系列之 DH 序 概念 原理 代码实现 结果 结束语 序 上一篇文章中简单的介绍了一种非对称加密算法 — — RSA,今天这篇文章,继续介绍另一种非对称加密算法 — — DH.当然 ...

随机推荐

- recover database until cancel

数据库演示版本为 12.1.0.2 该系列涉及恢复过程中使用的 5 个语句: 1. recover database 2. recover database until cancel 3. recov ...

- Blocks(单调栈)

题干中说每次选择一个大于k的数,还要选他左右两个数其中之一加上一,最后问你最长的每个数不小于K的子序列. 这些都是障眼法,其实就是问你最长的平均值大于或等于K的最长子序列,这样就明朗了. 接下来就是找 ...

- C++ 默认参数与引用传递:语法、用法及示例

C++ 默认参数 默认参数概述 在 C++ 中,函数参数可以拥有默认值.这意味着,在调用函数时,如果省略了某个参数,那么将使用为该参数指定的默认值. 设置默认参数 默认参数值使用等号 = 符号进行设置 ...

- 腾讯音乐:说说Redis脑裂问题?

Redis 脑裂问题是指,在 Redis 哨兵模式或集群模式中,由于网络原因,导致主节点(Master)与哨兵(Sentinel)和从节点(Slave)的通讯中断,此时哨兵就会误以为主节点已宕机,就会 ...

- 如何使用XSSFWorkbook读取文本薄?

[版权声明]未经博主同意,谢绝转载!(请尊重原创,博主保留追究权) https://www.cnblogs.com/cnb-yuchen/p/18146625 出自[进步*于辰的博客] 1.文件兼容类 ...

- 第七課-Channel Study For HTTP Listener & Web Service Sender Intercommunicates Response Handler

示例说明: 系统A发送XML格式患者信息到Mirth的Source端HTTP Listener,完成患者信息入库逻辑:然后Mirth的Destinations端Web Service Sender调用 ...

- 力扣626(MySQL)-换座位(中等)

题目: 表: Seat 编写SQL查询来交换每两个连续的学生的座位号.如果学生的数量是奇数,则最后一个学生的id不交换. 按 id 升序 返回结果表. 查询结果格式如下所示. 示例1: 解释: 请注意 ...

- Java应用结构规范

简介:在Java程序开发中,命名和应用分层无疑是广大后端同胞的两大"痛点",本文提供一种基于领域模型的轻量级应用分层结构设计,供大家参考.下面按分层结构.分层明细.调用关系.各层 ...

- ChaosBlade:从混沌工程实验工具到混沌工程平台

简介: ChaosBlade 是阿里巴巴 2019 年开源的混沌工程项目,已加入到 CNCF Sandbox 中.起初包含面向多环境.多语言的混沌工程实验工具 chaosblade,到现在发展到面向 ...

- [Linux] IP 地址配置, 网络地址配置文件

# 查看与配置网络状态命令 $ ifconfig # 临时设置 eth0 网卡的 IP 地址与子网掩码,netmask 可以省略 $ ifconfig eth0 192.168.0.100 netma ...