Hadoop的FlieSystem类的使用

1.使用FileSystem类需要导入jar包

解压hadoop-2.7.7.tar.gz

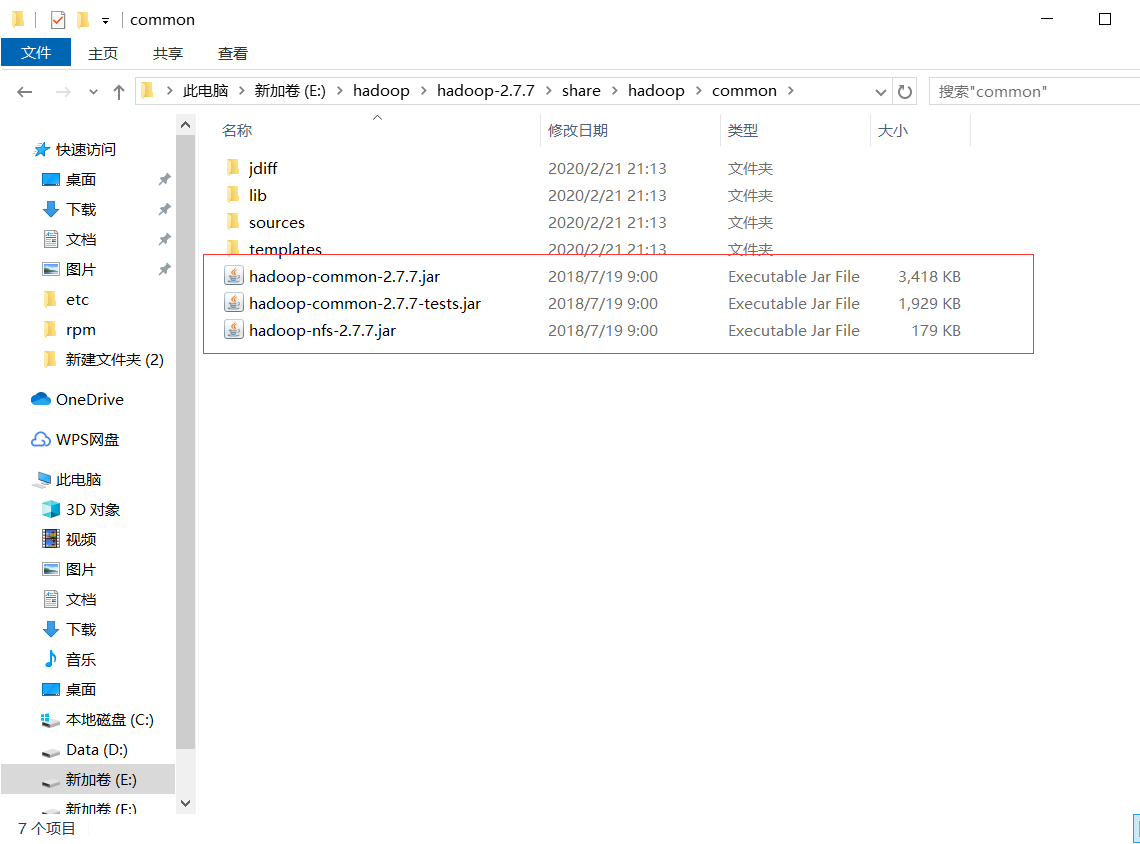

复制如下三个jar包和lib下所有jar包到项目文件下的lib文件

2.查看文件信息

@Test

public void readListFiles() throws Exception {

// 1 创建配置信息对象

Configuration configuration = new Configuration(); FileSystem fs = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),configuration, "root"); // 思考:为什么返回迭代器,而不是List之类的容器

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true); while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

System.out.println(fileStatus.getPath().getName()); //路径

System.out.println(fileStatus.getBlockSize()); //块

System.out.println(fileStatus.getPermission()); //权限

System.out.println(fileStatus.getLen()); //文件大小

System.out.println(fileStatus.isFile()); //是不是一个文件

System.out.println(fileStatus.isDirectory()); //是不是一个目录 BlockLocation[] blockLocations = fileStatus.getBlockLocations(); for (BlockLocation bl : blockLocations) { System.out.println("block-offset:" + bl.getOffset()); String[] hosts = bl.getHosts(); for (String host : hosts) {

System.out.println(host);

}

} System.out.println("----------------------------");

}

}

3.文件下载(get)

@Test

public void download() {

Configuration conf=new Configuration();

try

{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),conf);

FSDataInputStream in = fileSystem.open(new Path("/upload.txt"));

FileOutputStream out = new FileOutputStream(new File("d://lib//updoad.txt"));

byte[]b=new byte[1024];

int len=0;

while((len=in.read(b))!=-1) {

out.write(b,0,len);

}

in.close();

out.close();

} catch (IOException | URISyntaxException e)

{

// TODO 自动生成的 catch 块

e.printStackTrace();

} }

4.上传文件(create)

@Test

public void upload() {

Configuration conf=new Configuration();

try

{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),conf);

FSDataOutputStream out = fileSystem.create(new Path("/jetbrains-agent.jar"));

FileInputStream in=new FileInputStream(new File("d:\\jetbrains-agent.jar"));

byte[]b=new byte[10240];

int len=0;

while((len=in.read(b))!=-1) {

out.write(b,0,len);

}

in.close();

out.close();

} catch (IOException | URISyntaxException e)

{

// TODO 自动生成的 catch 块

e.printStackTrace();

}

}

5.重命名(rename)

@Test

public void mv() {

Configuration conf=new Configuration();

try

{

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),conf);

fileSystem.rename(new Path("/hdp01"), new Path("/HDP01"));

fileSystem.close();

} catch (IOException | URISyntaxException e)

{

// TODO 自动生成的 catch 块

e.printStackTrace();

}

}

6.文件夹删除

@Test

public void deleteAtHDFS() throws Exception{

// 1 创建配置信息对象

Configuration configuration = new Configuration(); FileSystem fs = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),configuration, "root"); //2 删除文件夹 ,如果是非空文件夹,参数2是否递归删除,true递归

fs.delete(new Path("hdfs://192.168.0.xxx:9000/upload/output"), true);

}

7.创建文件夹

@Test

public void mkdirAtHDFS() throws Exception{

// 1 创建配置信息对象

Configuration configuration = new Configuration(); FileSystem fs = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),configuration, "root"); //2 创建目录

fs.mkdirs(new Path("hdfs://192.168.0.xxx:9000/upload/output"));

}

8.遍历所有文件状态

@Test

public void findAtHDFS() throws Exception, IllegalArgumentException, IOException{ // 1 创建配置信息对象

Configuration configuration = new Configuration(); FileSystem fs = FileSystem.get(new URI("hdfs://192.168.0.xxx:9000"),configuration, "root"); // 2 获取查询路径下的文件状态信息

FileStatus[] listStatus = fs.listStatus(new Path("/")); // 3 遍历所有文件状态

for (FileStatus status : listStatus) {

if (status.isFile()) {

System.out.println("f--" + status.getPath().getName());

} else {

System.out.println("d--" + status.getPath().getName());

}

}

}

Hadoop的FlieSystem类的使用的更多相关文章

- Hadoop之TaskInputOutputContext类

在MapReduce过程中,每一个Job都会被分成若干个task,然后再进行处理.那么Hadoop是怎么将Job分成若干个task,并对其进行跟踪处理的呢?今天我们来看一个*Context类——Tas ...

- Hadoop之TaskAttemptContext类和TaskAttemptID类

先来看看TaskAttemptContext的类图 : Figure1:TaskAttemptContext类图 用户向Hadoop提交Job(作业),Job在JobTracker对象的控制下执行.J ...

- hadoop中Text类 与 java中String类的区别

hadoop 中 的Text类与java中的String类感觉上用法是相似的,但两者在编码格式和访问方式上还是有些差别的,要说明这个问题,首先得了解几个概念: 字符集: 是一个系统支持的所有抽象字符的 ...

- Hadoop中Writable类之四

1.定制Writable类型 Hadoop中有一套Writable实现,例如:IntWritable.Text等,但是,有时候可能并不能满足自己的需求,这个时候,就需要自己定制Writable类型. ...

- Hadoop中Writable类之三

1.BytesWritable <1>定义 ByteWritable是对二进制数据组的封装.它的序列化格式为一个用于指定后面数据字节数的整数域(4个字节),后跟字节本身. 举个例子,假如有 ...

- Hadoop中Writable类之二

1.ASCII.Unicode.UFT-8 在看Text类型的时候,里面出现了上面三种编码,先看看这三种编码: ASCII是基于拉丁字母的一套电脑编码系统.它主要用于显示现代英语和其他西欧语言.它是现 ...

- hadoop之mapper类妙用

1. Mapper类 首先 Mapper类有四个方法: (1) protected void setup(Context context) (2) Protected void map(KEYIN k ...

- Hadoop中Writable类

1.Writable简单介绍 在前面的博客中,经常出现IntWritable,ByteWritable.....光从字面上,就可以看出,给人的感觉是基本数据类型 和 序列化!在Hadoop中自带的or ...

- 琐碎-关于hadoop的GenericOptionsParser类

GenericOptionsParser 命令行解析器 是hadoop框架中解析命令行参数的基本类.它能够辨别一些标准的命令行参数,能够使应用程序轻易地指定namenode,jobtracker,以及 ...

随机推荐

- Python3 格式化输出

Python3 格式化输出 今天用字符串功能的时候,我突然忘记了格式化输出的方式X﹏X.所以赶紧恶补一下. 1.打印字符串 print("My name is %s" %(&quo ...

- python学习笔记2018-9-18

1.可选参数传递 此处m=1并不是写定m必为1,而是m为可选参数,当不对其进行赋值时,其默认值为1. 2.函数的返回值 return可以传递0个返回值,也可以传递任意多个返回值 3.局部变量与全局变量 ...

- Live555研究之一 源代码编译

Live555 是一个为流媒体提供解决方案的跨平台的C++开源项目,它实现了对标准流媒体传输协议如RTP/RTCP.RTSP.SIP等的支持.Live555实现了对多种音视频编码格式的音视频数据的流化 ...

- DNS原理和智能DNS及CDN

CDN是什么 CDN(Content Delivery Network)是内容分发网络. 作用: 使用户可以就近取的所需要的内容,加速用户访问网站资源的速度.物理距离更近,响应速度更快.拦截部分网络请 ...

- 061-PHP函数定义默认参数

<?php function add($x=2,$y=3){ //定义函数并设置默认参数 return $x+$y; } echo add(); //不传入参数调用add函数add(2,3) e ...

- 第二阶段scrum-8

1.整个团队的任务量: 2.任务看板: 会议照片: 产品状态: 消息收发制作中

- spring源码 继承AttributeAccessor的BeanDefinition接口

/** * A BeanDefinition describes a bean instance, which has property values, * constructor argument ...

- Maccms后门分析复现(并非官网的Maccms){10.15 第二十二天}

该复现参考网络中的文章,该漏洞复现仅仅是为了学习交流,严禁非法使用!!!! Maccms官网:http://www.maccms.cn/ Maccms网站基于PHP+MYSQL的系统,易用性.功能良好 ...

- Kali桥接模式下配置静态ip

以管理员身份运行虚拟机 打开控制面板-->网络和Internet-->更改适配器 再在虚拟机处桥接到这个WLAN2 点击 编辑-->编辑虚拟网卡 没有网卡就点上图的添加网络作为桥接网 ...

- 大二暑假第三周总结--开始学习Hadoop基础(二)

简单学习NoSQL数据库理论知识 NoSQL数据库具有以下几个特点: 1.灵活的可扩展性(支持在多个节点上进行水平扩张) 2.灵活的数据模型(与关系数据库中严格的关系模型相反,显得较为松散) 3.与与 ...