1.1 Introduction中 Apache Kafka™ is a distributed streaming platform. What exactly does that mean?(官网剖析)(博主推荐)

不多说,直接上干货!

一切来源于官网

http://kafka.apache.org/documentation/

Apache Kafka™ is a distributed streaming platform. What exactly does that mean?

Kafka是一个分布式流数据处理平台。这到底是什么意思呢?

We think of a streaming platform as having three key capabilities:

我们认为一个流数据处理平台必须具备三个关键功能:

- It lets you publish and subscribe to streams of records. In this respect it is similar to a message queue or enterprise messaging system.

- It lets you store streams of records in a fault-tolerant way.

- It lets you process streams of records as they occur.

1、它允许你发布订阅流数据,在这方面,他类似一个消息队列或企业级消息系统(消息中间件);

2、它让你存储的流式数据具有容错机制;

3、它让你能实时处理流式数据

What is Kafka good for?

It gets used for two broad classes of application:

Kafka有什么好处? 它被用于两大类别的程序:

- Building real-time streaming data pipelines that reliably get data between systems or applications

- Building real-time streaming applications that transform or react to the streams of data

1、在系统和应用之间构建实时、可靠获取数据的流数据管道

2、构建用于数据转换、数据重复处理的实时流数据应用

To understand how Kafka does these things, let's dive in and explore Kafka's capabilities from the bottom up.

要想明白kafka如何做这些事情,需要我们从上到下深入探索kafka的功能。

First a few concepts:

- Kafka is run as a cluster on one or more servers.

- The Kafka cluster stores streams of records in categories called topics.

- Each record consists of a key, a value, and a timestamp.

先熟悉几个概念:

1、kafka可以作为集群运行在一个或多个的服务器上;

2、kafka集群存储流数据类别的称为topic。

3、每条记录由一个key,value,timestamp组成的。

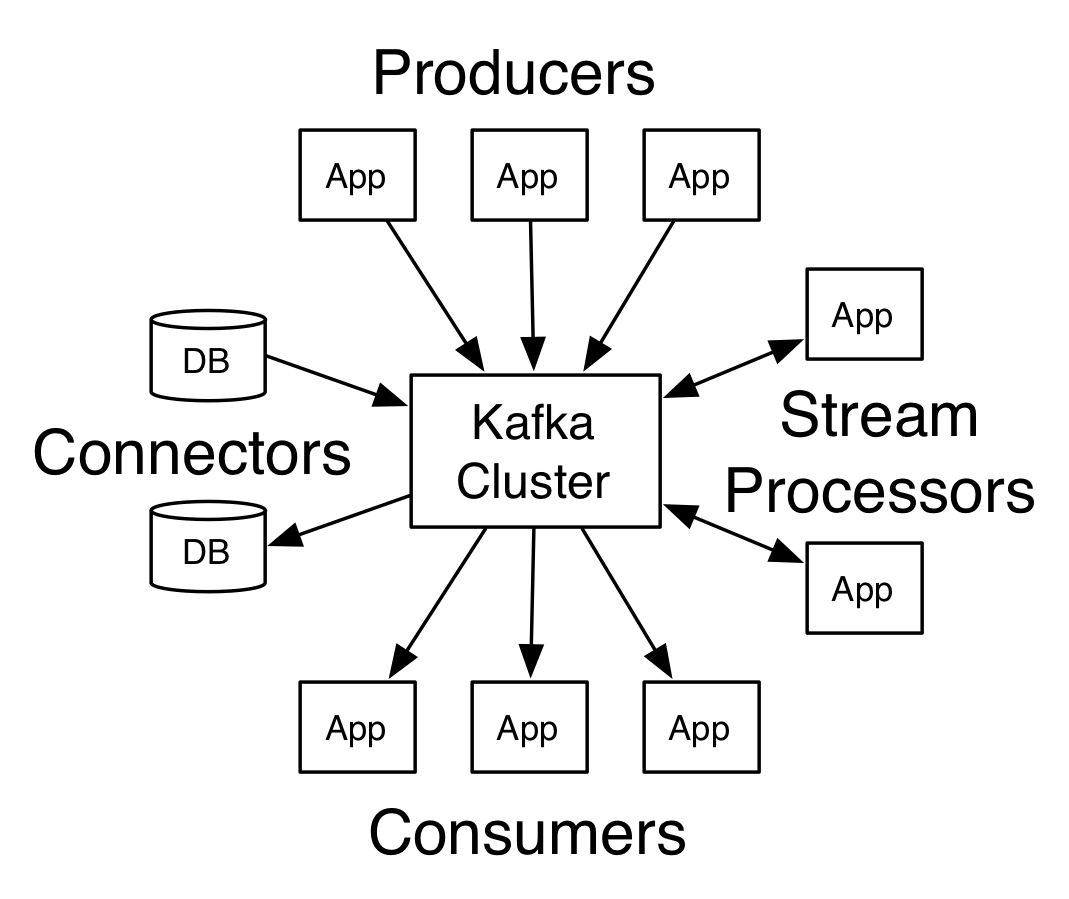

Kafka has four core APIs:

- The Producer API allows an application to publish a stream of records to one or more Kafka topics.

- The Consumer API allows an application to subscribe to one or more topics and process the stream of records produced to them.

- The Streams API allows an application to act as a stream processor, consuming an input stream from one or more topics and producing an output stream to one or more output topics, effectively transforming the input streams to output streams.

- The Connector API allows building and running reusable producers or consumers that connect Kafka topics to existing applications or data systems. For example, a connector to a relational database might capture every change to a table.

Kafka有4个核心的APIs:

Producer API:允许某个应用程序发布流数据到一个或多个kafka topic

Consumer API:允许某个应用程序订阅一个或多个kafka topic同时处理生产的流数据。

Streams API:允许某应用程序作为流处理器,消费一个或多个topic输入流和生产一个或多个topic输出流,高效地转换输入输出流。

Connector API:允许构建和运行可重用的生产者或消费者,连接kafka topic到现有的应用程序或数据系统、例如:一个连接到关系型数据库可能需要捕获一张表的每次改变。(可作为数据库日志同步功能)

In Kafka the communication between the clients and the servers is done with a simple, high-performance, language agnostic TCP protocol. This protocol is versioned and maintains backwards compatibility with older version. We provide a Java client for Kafka, but clients are available in many languages.

在kafka中,客户端和服务器之间的通信采用简单的,高性能,开发语言无关的TCP协议。这种协议是有版本的,并且保持向后兼容性。

Kafka提供了一个Java的客户端,同时也提供其他开发语言的客户端。

1.1 Introduction中 Apache Kafka™ is a distributed streaming platform. What exactly does that mean?(官网剖析)(博主推荐)的更多相关文章

- Apache Kafka® is a distributed streaming platform

Kafka Connect简介 我们知道过去对于Kafka的定义是分布式,分区化的,带备份机制的日志提交服务.也就是一个分布式的消息队列,这也是他最常见的用法.但是Kafka不止于此,打开最新的官网. ...

- Apache Kafka: Next Generation Distributed Messaging System---reference

Introduction Apache Kafka is a distributed publish-subscribe messaging system. It was originally dev ...

- 基于Windows7下snort+apache+php 7 + acid(或者base) + adodb + jpgraph的入侵检测系统的搭建(图文详解)(博主推荐)

为什么,要写这篇论文? 是因为,目前科研的我,正值研三,致力于网络安全.大数据.机器学习.人工智能.区域链研究领域! 论文方向的需要,同时不局限于真实物理环境机器实验室的攻防环境.也不局限于真实物理机 ...

- 1.1 Introduction中 Kafka for Stream Processing官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Kafka for Stream Processing kafka的流处理 It i ...

- 1.1 Introduction中 Kafka as a Storage System官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Kafka as a Storage System kafka作为一个存储系统 An ...

- 1.1 Introduction中 Kafka as a Messaging System官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Kafka as a Messaging System kafka作为一个消息系统 ...

- 1.3 Quick Start中 Step 8: Use Kafka Streams to process data官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Step 8: Use Kafka Streams to process data ...

- 1.3 Quick Start中 Step 7: Use Kafka Connect to import/export data官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Step 7: Use Kafka Connect to import/export ...

- 1.1 Introduction中 Guarantees官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Guarantees Kafka的保证(Guarantees) At a high- ...

随机推荐

- java httpRequest和Response

Web服务器收到客户端的http请求,会针对每一次请求,分别创建一个用于代表请求的request对象.和代表响应的response对象.request和response对象即然代表请求和响应,那我们要 ...

- 不允许 ASSIGNMENT 语句中包含 FOR XML 子句。

DECLARE @guidList NVARCHAR(max) SELECT @guidList=( CAST(OrderGUID AS nvarchar(max)) +',') FROM Order ...

- Coderfroces 864 E. Fire(01背包+路径标记)

E. Fire http://codeforces.com/problemset/problem/864/E Polycarp is in really serious trouble — his h ...

- Network Stack : CookieMonster

CookieMonster The CookieMonster is the class in Chromium which handles in-browser storage, managem ...

- [USACO07JAN]平衡的阵容Balanced Lineup RMQ模板题

Code: #include<cstdio> #include<algorithm> using namespace std; const int maxn = 50000 + ...

- java设计模式--事件监听器模式和观察者模式

监听器模式:事件源经过事件的封装传给监听器,当事件源触发事件后,监听器接收到事件对象可以回调事件的方法 观察者模式:观察者(Observer)相当于事件监听者,被观察者(Observable)相当于事 ...

- webgoat7.1开发版环境搭建

环境准备:git mavenjdktomcat然后进入正文:下载webgoat门户cd ~/webgoatgit clone https://github.com/WebGoat/WebGoat.gi ...

- C#加减乘除

using System; using System.Collections.Generic; using System.Linq; using System.Text; using System.T ...

- Lua 是一个小巧的脚本语言

Redis进阶实践之七Redis和Lua初步整合使用 一.引言 Redis学了一段时间了,基本的东西都没问题了.从今天开始讲写一些redis和lua脚本的相关的东西,lua这个脚本是一个好东西,可以运 ...

- 关于router-link的传参以及参数的传递

1.路径:http://localhost:8081/#/test?name=1 <router-link :to="{path:'/test',query: {name: id}}& ...