pytorch学习笔记(7)--线性层

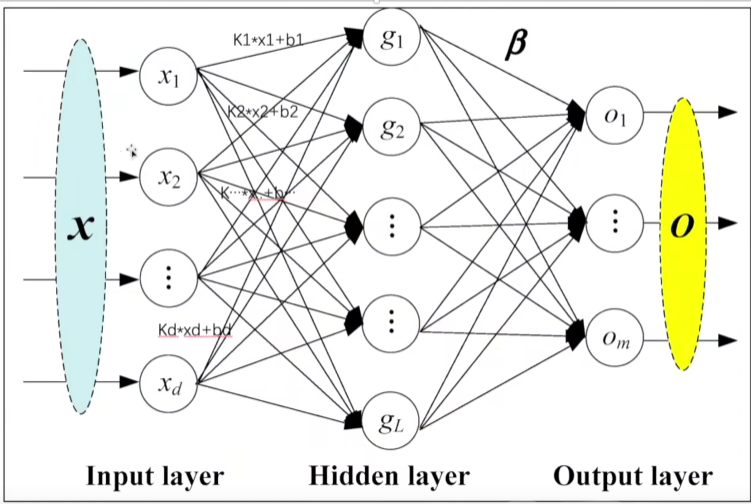

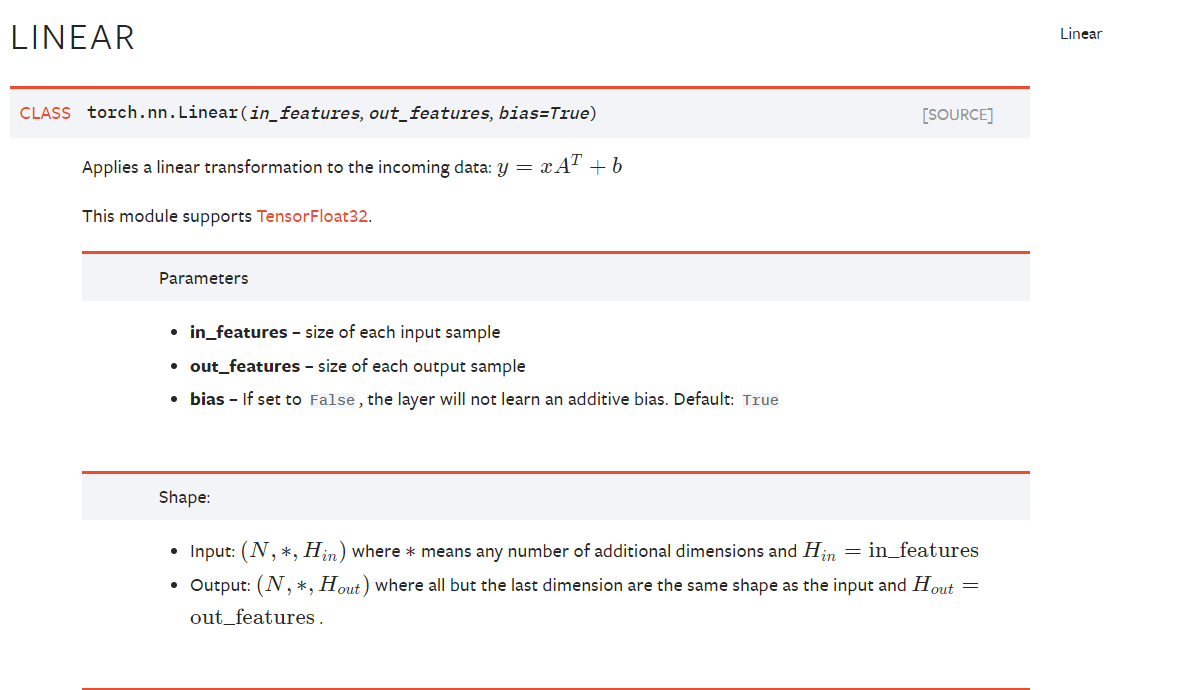

(一)Liner Layers线性层

b 是偏移量bias

代码输入:

import torch

import torchvision

from torch import nn

from torch.nn import Linear

from torch.utils.data import DataLoader dataset = torchvision.datasets.CIFAR10("../dataset", train=False, transform=torchvision.transforms.ToTensor(), download=False)

dataloader = DataLoader(dataset, batch_size=64) class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.linear1 = Linear(196608, 10) def forward(self, input):

output = self.linear1(input)

return output tudui = Tudui() for data in dataloader:

imgs, target = data

print(imgs.shape)

output = torch.reshape(imgs, (1, 1, 1, -1))

print(output.shape)

output = tudui(output)

print(output.shape)

输出:

torch.Size([64, 3, 32, 32])

torch.Size([1, 1, 1, 196608])

torch.Size([1, 1, 1, 10])

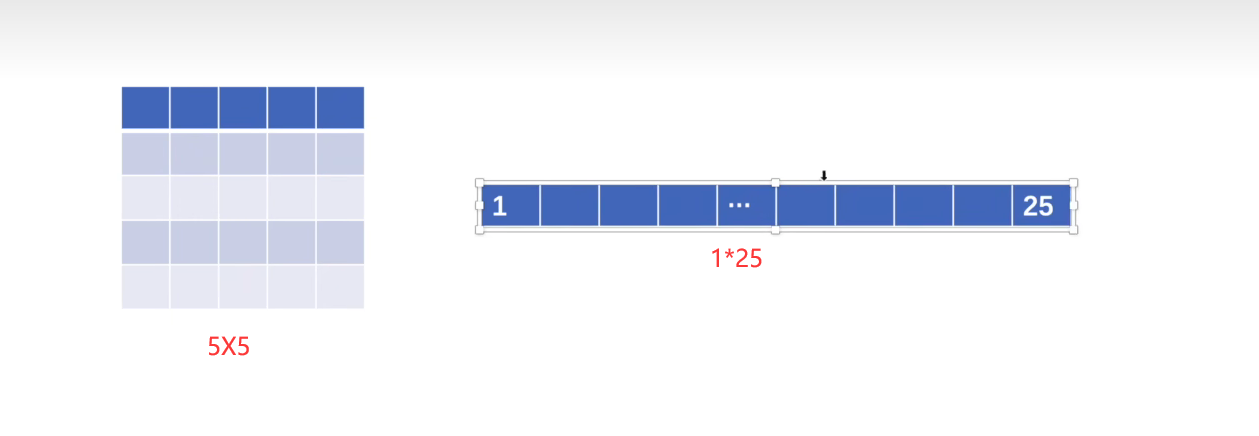

改为 flatten 类似“平铺”:

import torch

import torchvision

from torch import nn

from torch.nn import Linear

from torch.utils.data import DataLoader dataset = torchvision.datasets.CIFAR10("../dataset", train=False, transform=torchvision.transforms.ToTensor(), download=False)

dataloader = DataLoader(dataset, batch_size=64) class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.linear1 = Linear(196608, 10) def forward(self, input):

output = self.linear1(input)

return output tudui = Tudui() for data in dataloader:

imgs, target = data

print(imgs.shape)

# flatten

output = torch.flatten(imgs)

print(output.shape)

输出:

torch.Size([64, 3, 32, 32])

torch.Size([196608])

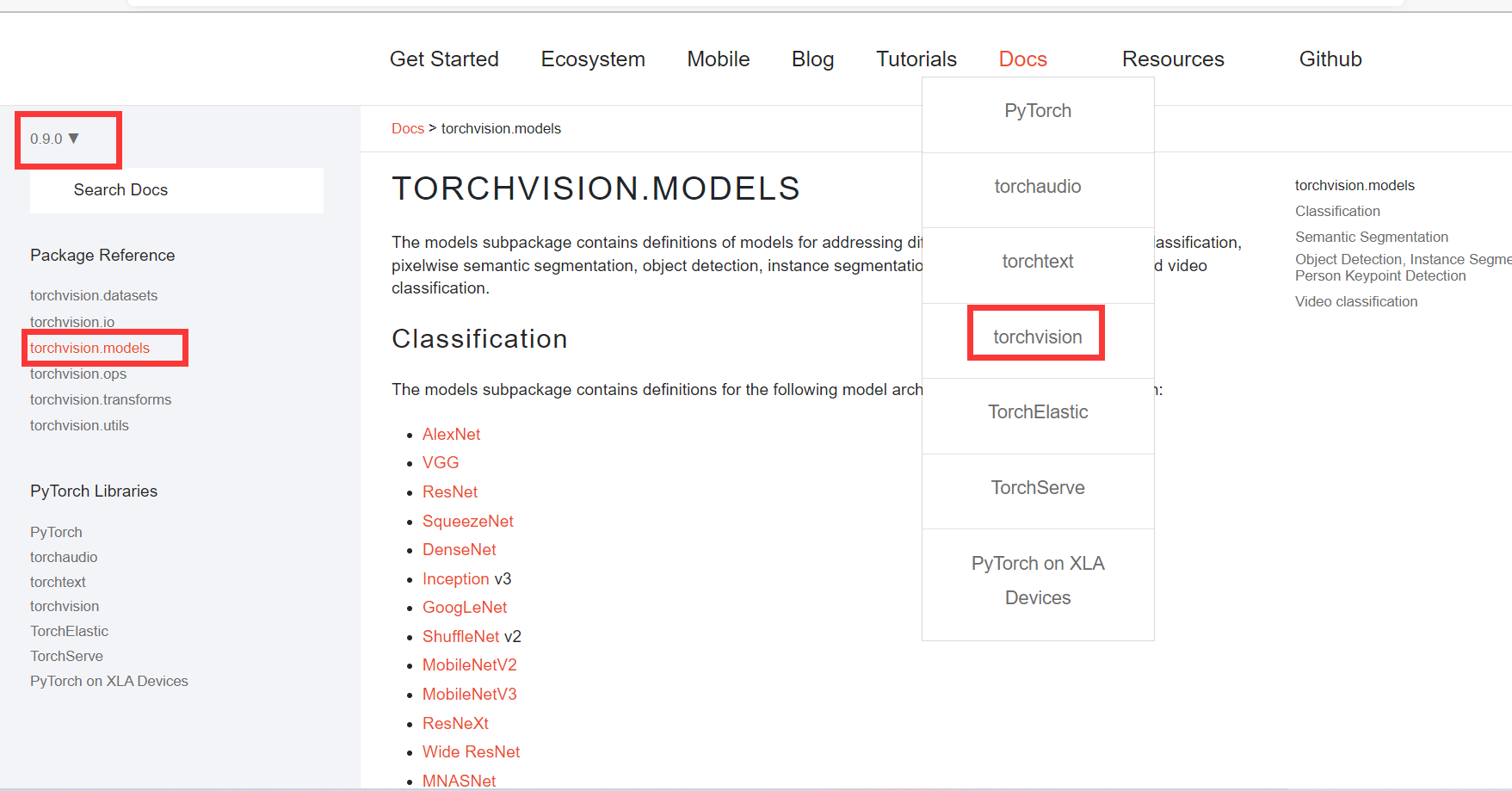

图形图像方面Module:

pytorch学习笔记(7)--线性层的更多相关文章

- [PyTorch 学习笔记] 3.3 池化层、线性层和激活函数层

本章代码:https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson3/nn_layers_others.py 这篇文章主要介绍 ...

- [PyTorch 学习笔记] 3.2 卷积层

本章代码:https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson3/nn_layers_convolution.py 这篇文 ...

- 【pytorch】pytorch学习笔记(一)

原文地址:https://pytorch.org/tutorials/beginner/deep_learning_60min_blitz.html 什么是pytorch? pytorch是一个基于p ...

- [PyTorch 学习笔记] 4.1 权值初始化

本章代码:https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson4/grad_vanish_explod.py 在搭建好网络 ...

- PyTorch学习笔记6--案例2:PyTorch神经网络(MNIST CNN)

上一节中,我们使用autograd的包来定义模型并求导.本节中,我们将使用torch.nn包来构建神经网络. 一个nn.Module包含各个层和一个forward(input)方法,该方法返回outp ...

- 【深度学习】Pytorch 学习笔记

目录 Pytorch Leture 05: Linear Rregression in the Pytorch Way Logistic Regression 逻辑回归 - 二分类 Lecture07 ...

- TensorFlow 深度学习笔记 从线性分类器到深度神经网络

转载请注明作者:梦里风林 Github工程地址:https://github.com/ahangchen/GDLnotes 欢迎star,有问题可以到Issue区讨论 官方教程地址 视频/字幕下载 L ...

- Pytorch学习笔记(二)---- 神经网络搭建

记录如何用Pytorch搭建LeNet-5,大体步骤包括:网络的搭建->前向传播->定义Loss和Optimizer->训练 # -*- coding: utf-8 -*- # Al ...

- Pytorch学习笔记(一)---- 基础语法

书上内容太多太杂,看完容易忘记,特此记录方便日后查看,所有基础语法以代码形式呈现,代码和注释均来源与书本和案例的整理. # -*- coding: utf-8 -*- # All codes and ...

- 学习笔记TF014:卷积层、激活函数、池化层、归一化层、高级层

CNN神经网络架构至少包含一个卷积层 (tf.nn.conv2d).单层CNN检测边缘.图像识别分类,使用不同层类型支持卷积层,减少过拟合,加速训练过程,降低内存占用率. TensorFlow加速所有 ...

随机推荐

- HIVE- 删除功能

删除分区: ALTER TABLE table_name DROP PARTITION (partition_name='20220101');

- Object.create() 方浅析

Object.create()方法创建一个新对象,使用现有的对象来提供新创建的对象的__proto__. Object.create(proto[, propertiesObject]) 参数 pro ...

- go 使用mysql

package main /* 下划线(如:import _ hello/imp)的作用:当导入一个包时,该包下的文件里所有init()函数都会被执行, 然而,有些时候我们并不需要把整个包都导入进来, ...

- git bash 笔记

下载和安装 官网下载地址:https://git-scm.com/ 国内镜像下载地址:https://registry.npmmirror.com/binary.html?path=git-for-w ...

- 5-MIGO收货-请维护容差码VP(公司代码1000)的容差限制-消息号 M8215

请维护容差码VP(公司代码1000)的容差限制 消息号 M8215 诊断 系统试图检查输入输入是否在特定的限度范围之内.由于尚未维护显示的容差码限制,所以无法进行此操作. 步骤 系统管理员必须在公司代 ...

- IDEA使用fastjson1时maven引入依赖没报错,但是用不了JSONObject工具类

删除项目下的.idea文件夹重新打开项目就行, 不知道为什么

- nohup文件的压缩分割

编写sh脚本 先拷贝,之后,清空. 待完成,压缩功能 #!/bin/sh #description split logs time1=$(date -d 'yesterday' "+%Y%m ...

- 关于SaaS的图

- Java 接口内容小结

Java接口学习:https://www.cnblogs.com/mlllily/p/14923837.html 小结内容: 在Java9+版本中,接口内容可以有常量.抽象方法.默认方法.静态方法.私 ...

- Vulnhub 靶机 CONTAINME: 1

Vulnhub 靶机 CONTAINME: 1 前期准备: 靶机地址:https://www.vulnhub.com/entry/containme-1,729/ kali地址:192.168.147 ...