四、Kafka 核心源码剖析

一、Kafka消费者源码介绍

1.分区消费模式源码介绍

分区消费模式直接由客户端(任何高级语言编写)使用Kafka提供的协议向服务器发送RPC请求获取数据,服务器接受到客户端的RPC请求后,将数据构造成RPC响应,返回给客户端,客户端解析相应的RPC响应获取数据。

Kafka支持的协议众多,使用比较重要的有:

获取消息的FetchRequest和FetchResponse

获取offset的OffsetRequest和OffsetResponse

提交offset的OffsetCommitRequest和OffsetCommitResponse

获取Metadata的Metadata Request和Metadata Response

生产消息的ProducerRequest和ProducerResponse

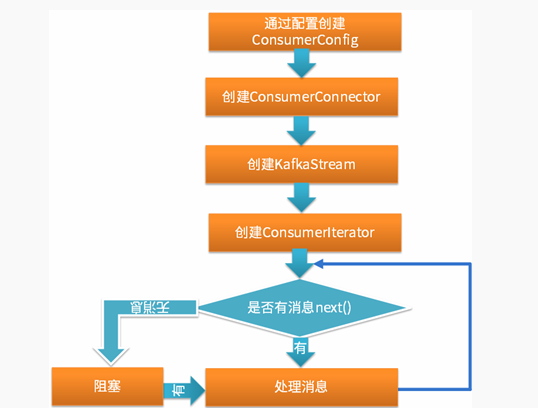

2.组消费模式源码介绍

3.两种消费模式服务器端源码对比

分区消费模式具有以下特点:

指定消费topic、partition和offset通过向服务器发送RPC请求进行消费;

需要自己提交offset;

需要自己处理各种错误,如:leader切换错误

需要自己处理消费者负载均衡策略

组消费模式具有以下特点:

最终也是通过向服务器发送RPC请求完成的(和分区消费模式一样);

组消费模式由Kafka服务器端处理各种错误,然后将消息放入队列再封装为迭代器(队列为FetchedDataChunk对象) ,客户端只需在迭代器上迭代取出消息;

由Kafka服务器端周期性的通过scheduler提交当前消费的offset,无需客户端负责

Kafka服务器端处理消费者负载均衡

监控工具Kafka Offset Monitor 和Kafka Manager 均是基于组消费模式;

所以,尽可能使用组消费模式,除非你需要:

自己管理offset(比如为了实现消息投递的其他语义);

自己处理各种错误(根据自己业务的需求);

二、Kafka生产者源码介绍

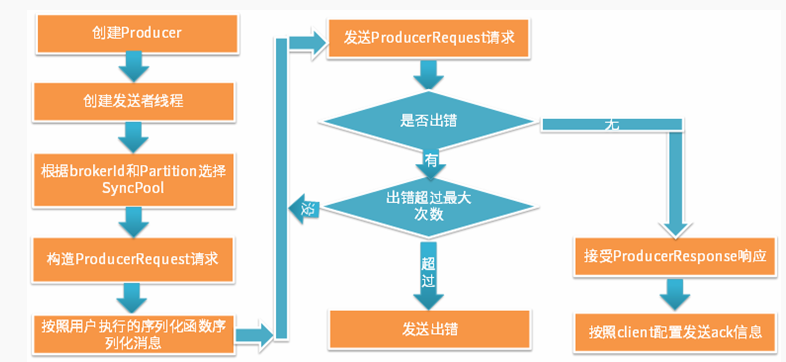

1.同步发送模式源码介绍

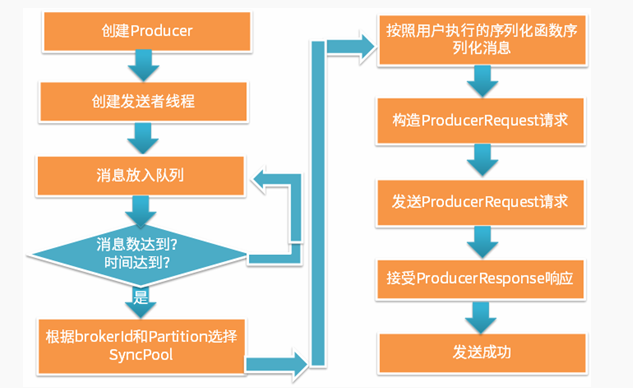

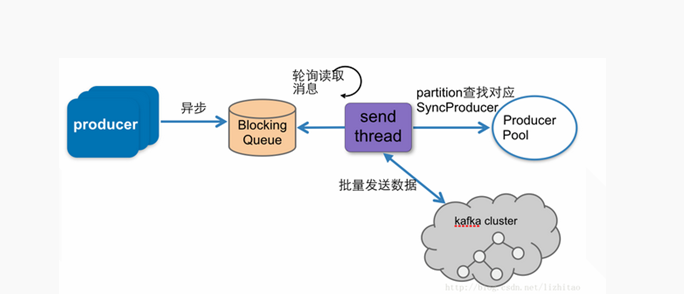

2.异步发送模式源码介绍

3.两种生产模式服务器端源码对比

同步发送模式具有以下特点:

同步的向服务器发送RPC请求进行生产;

发送错误可以重试;

可以向客户端发送ack;

异步发送模式具有以下特点:

最终也是通过向服务器发送RPC请求完成的(和同步发送模式一样);

异步发送模式先将一定量消息放入队列中,待达到一定数量后再一起发送;

异步发送模式不支持发送ack,但是Client可以调用回调函数获取发送结果;

所以,性能比较高的场景使用异步发送,准确性要求高的场景使用同步发送

三、Kafka Server Reactor设计模型

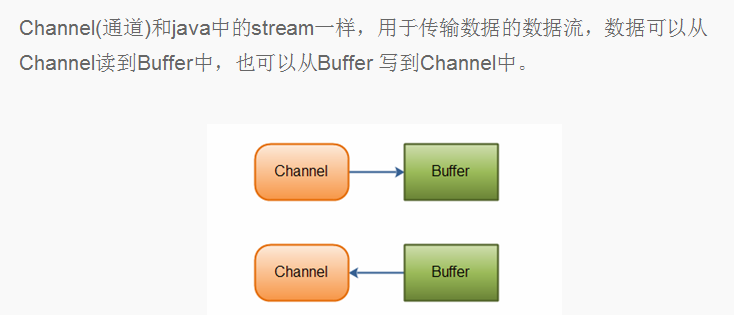

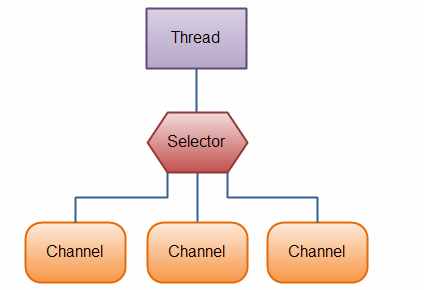

1.认识Java NIO

Java NIO由以下几个核心部分组成 :

Channels;

Buffers;

Selectors

2.认识Linux epoll模型

epoll 是一种IO多路复用技术 ,在linux内核中广泛使用。常见的三种IO多路复用技术为select模型、poll模型和epoll模型。

select 模型需要轮询所有的套接字查看是否有事件发生 。缺点: (1)套接字最大支持1024个;(2)主动轮询效率很低;(3) 事件发生后需要将套接字从内核空间拷贝到用户空间,效率低

poll模型和select模型原理一样,但是修正了select模型最大套接字限制的缺点;

epoll模型修改主动轮询为被动通知,当有事件发生时,被动接收通知。所以epoll模型注册套接字后,主程序可以做其他事情,当事件发生时,接收到通知后再去处理。修正了select模型的三个缺点(第三点使用共享内存修正)。

Java NIO的Selector模型底层使用的就是epoll IO多路复用模型

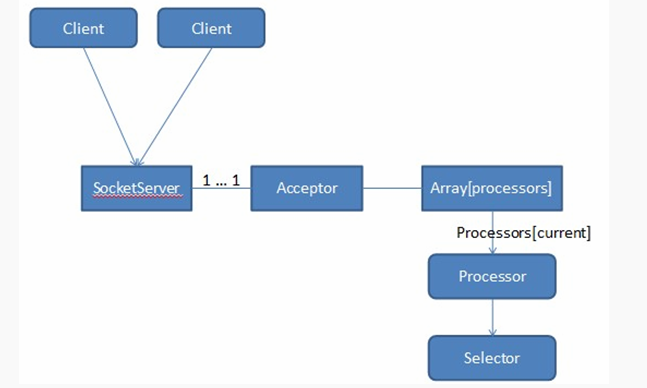

3.Kafka Server Reactor模型

Kafka SocketServer是基于Java NIO开发的,采用了Reactor的模式(已被大量实践证明非常高效,在Netty和Mina中广泛使用)。Kafka Reactor的模式包含三种角色:

Acceptor;

Processor ;

Handler;

Kafka Reacator包含了1个Acceptor负责接受客户端请求,N个Processor线程负责读写数据(为每个Connection创建出一个Processor去单独处理,每个Processor中均引用独立的Selector),M个Handler来处理业务逻辑。在Acceptor和Processor,Processor和Handler之间都有队列来缓冲请求。

Acceptor的主要职责是监听客户端的连接请求,并建立和客户端的数据传输通道,然后为这个客户端指定一个Processor,它的工作就到此结束,这样它就可以去响应下一个客户端的连接请求了;

Processor的主要职责是负责从客户端读取数据和将响应返回给客户端,它本身不处理具体的业务逻辑,每个Processor都有一个Selector,用来监听多个客户端,因此可以非阻塞地处理多个客户端的读写请求,Processor将数据放入RequestChannel的RequestQueue 中和从ResponseQueue读取响应 ;

Handler(kafka.server.KafkaRequestHandler,kafka.server.KafkaApis)的职责是从RequestChannel中的RequestQueue取出Request,处理以后再将Response添加到RequestChannel中的ResponseQueue中;

四、Kafka Partition Leader选举机制

1.大数据常用的选主机制

Leader选举算法非常多,大数据领域常用的有 以下两种:

Zab(zookeeper使用);

Raft;

……

它们都是Paxos算法的变种。

Zab协议有四个阶段:

Leader election;

Discovery(或者epoch establish);

Synchronization(或者sync with followers)

Broadcast

比如3个节点选举leader,编号为1,2,3。1先启动,选择自己为leader,然后2启动首先也选择自己为 leader,由于1,2都没过半,选择编号大的为leader,所以1,2都选择2为leader,然后3启动发现1,2已经协商好且数量过半,于是3也选择2为leader,leader选举结束。

在Raft中,任何时候一个服务器可以扮演下面角色之一

Leader: 处理所有客户端交互,日志复制等,一般只有一个Leader;

Follower: 类似选民,完全被动

Candidate候选人: 可以被选为一个新的领导人

启动时在集群中指定一些机器为Candidate ,然后Candidate开始向其他机器(尤其是Follower)拉票,当某一个Candidate的票数超过半数,它就成为leader。

2.常用选主机制的缺点

由于Kafka集群依赖zookeeper集群,所以最简单最直观的方案是,所有Follower都在ZooKeeper上设置一个Watch,一旦Leader宕机,其对应的ephemeral znode会自动删除,此时所有Follower都尝试创建该节点,而创建成功者(ZooKeeper保证只有一个能创建成功)即是新的Leader,其它Replica即为Follower。

前面的方案有以下缺点:

split-brain (脑裂): 这是由ZooKeeper的特性引起的,虽然ZooKeeper能保证所有Watch按顺序触发,但并不能保证同一时刻所有Replica“看”到的状态是一样的,这就可能造成不同Replica的响应不一致 ;

herd effect (羊群效应): 如果宕机的那个Broker上的Partition比较多,会造成多个Watch被触发,造成集群内大量的调整;

ZooKeeper负载过重 : 每个Replica都要为此在ZooKeeper上注册一个Watch,当集群规模增加到几千个Partition时ZooKeeper负载会过重

3.Kafka Partition选主机制

Kafka 集群controller的选举过程如下 :

每个Broker都会在Controller Path (/controller)上注册一个Watch。当前Controller失败时,对应的Controller Path会自动消失(因为它是ephemeral Node),此时该Watch被fire,所有“活”着的Broker都会去竞选成为新的Controller(创建新的Controller Path),但是只会有一个竞选成功(这点由Zookeeper保证)。竞选成功者即为新的Leader,竞选失败者则重新在新的Controller Path上注册Watch。因为Zookeeper的Watch是一次性的,被fire一次之后即失效,所以需要重新注册。

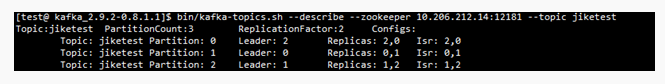

Kafka partition leader的选举过程如下 (由controller执行):

从Zookeeper中读取当前分区的所有ISR(in-sync replicas)集合

调用配置的分区选择算法选择分区的leader

所以,对于下图partition 0先选择broker 2,之后选择broker 0作为leader;对于partition 1 先选择broker 0,之后选择broker 1作为leader;partition 2先选择broker 1,之后选择broker 2作为leader。

四、Kafka 核心源码剖析的更多相关文章

- HashMap的结构以及核心源码分析

摘要 对于Java开发人员来说,能够熟练地掌握java的集合类是必须的,本节想要跟大家共同学习一下JDK1.8中HashMap的底层实现与源码分析.HashMap是开发中使用频率最高的用于映射(键值对 ...

- HTTP流量神器Goreplay核心源码详解

摘要:Goreplay 前称是 Gor,一个简单的 TCP/HTTP 流量录制及重放的工具,主要用 Go 语言编写. 本文分享自华为云社区<流量回放工具之 goreplay 核心源码分析> ...

- Android版数据结构与算法(五):LinkedHashMap核心源码彻底分析

版权声明:本文出自汪磊的博客,未经作者允许禁止转载. 上一篇基于哈希表实现HashMap核心源码彻底分析 分析了HashMap的源码,主要分析了扩容机制,如果感兴趣的可以去看看,扩容机制那几行最难懂的 ...

- Java内存管理-掌握类加载器的核心源码和设计模式(六)

勿在流沙筑高台,出来混迟早要还的. 做一个积极的人 编码.改bug.提升自己 我有一个乐园,面向编程,春暖花开! 上一篇文章介绍了类加载器分类以及类加载器的双亲委派模型,让我们能够从整体上对类加载器有 ...

- 手撕spring核心源码,彻底搞懂spring流程

引子 十几年前,刚工作不久的程序员还能过着很轻松的日子.记得那时候公司里有些开发和测试的女孩子,经常有问题解决不了的,不管什么领域的问题找到我,我都能帮她们解决.但是那时候我没有主动学习技术的意识,只 ...

- 并发编程之 SynchronousQueue 核心源码分析

前言 SynchronousQueue 是一个普通用户不怎么常用的队列,通常在创建无界线程池(Executors.newCachedThreadPool())的时候使用,也就是那个非常危险的线程池 ^ ...

- iOS 开源库系列 Aspects核心源码分析---面向切面编程之疯狂的 Aspects

Aspects的源码学习,我学到的有几下几点 Objective-C Runtime 理解OC的消息分发机制 KVO中的指针交换技术 Block 在内存中的数据结构 const 的修饰区别 block ...

- Backbone事件机制核心源码(仅包含Events、Model模块)

一.应用场景 为了改善酷版139邮箱的代码结构,引入backbone的事件机制,按照MVC的分层思想搭建酷版云邮局的代码框架.力求在保持酷版轻量级的基础上提高代码的可维护性. 二.遗留问题 1.b ...

- 6 手写Java LinkedHashMap 核心源码

概述 LinkedHashMap是Java中常用的数据结构之一,安卓中的LruCache缓存,底层使用的就是LinkedHashMap,LRU(Least Recently Used)算法,即最近最少 ...

随机推荐

- JavaBean 与 EJB 的区别

JavaBean在一般情况下指的是实体类,在大部分情况下和POJO是同义词,基本构成就是一些字段和与之对应的 setter.getter方法,如果一个JavaBean需要在不同的JVM的进程中进行传递 ...

- NBA篮球足球在线直播插件下载

PPlive:点此下载PPLive播放器 Sopcast:点此下载Sopcast播放器 UUSee:点此下载UUSee播放器 CCTVReg:点此下载CCTV插件 PPStream:点此下载PPstr ...

- DRBD 实验

跨主机的块设备镜像系统,工作在内核中完成 drbd工作原理:客户端发起一个写操作的系统调用给文件系统,写请求再到达内核缓冲区,最到达DRBD模块,此时drbd会复制写入磁盘的数据,且进行两步操作,第一 ...

- IE Only的userData

上次我们提到了本地存储的一个方式,那就是Cookie,不过遗憾的是Cookie保存的数据量非常小,更详细的可以参考<在 Internet Explorer 中的 cookie 的数字和大小限制& ...

- 开发者应该掌握的Java代码优化技能

就像鲸鱼吃虾米一样,也许吃一个两个虾米对于鲸鱼来说作用不大,但是吃的虾米多了,鲸鱼自然饱了. 代码优化一样,也许一个两个的优化,对于提升代码的运行效率意义不大,但是只要处处都能注意代码优化,总体来说对 ...

- 重温SQL——行转列,列转行

行转列,列转行是我们在开发过程中经常碰到的问题.行转列一般通过CASE WHEN 语句来实现,也可以通过 SQL SERVER 2005 新增的运算符PIVOT来实现.用传统的方法,比较好理解.层次清 ...

- python自动化之web抓取

''' 从web抓取数据: webbrowser:是python自带的,打开浏览器获取指定页面. requests:从因特网上下载文件和网页. Beautiful Soup:解析HTML,即网页编写的 ...

- BZOJ 2844: albus就是要第一个出场

2844: albus就是要第一个出场 Time Limit: 6 Sec Memory Limit: 128 MBSubmit: 1134 Solved: 481[Submit][Status] ...

- 洛谷 P2805 [NOI2009]植物大战僵尸 解题报告

P2805 [NOI2009] 植物大战僵尸 题目描述 Plants vs. Zombies(PVZ)是最近十分风靡的一款小游戏.Plants(植物)和Zombies(僵尸)是游戏的主角,其中Plan ...

- as, idea 出现 Gradle's dependency cache may be corrupt 错误分析

问题: Error:Failed to open zip file.Gradle's dependency cache may be corrupt (this sometimes occurs af ...