Hadoop的高可用搭建

在已经安装完hadoop单机和zookeeper前提下

1.免密钥

ssh-keygen -t rsa

分发秘钥

ssh-copy-id -i master

ssh-copy-id -i node1

ssh-copy-id -i node2

2.修改hadoop配置文件(我在master中修改)

core-site.xml

hdfs-site.xml

yarn-site.xml

mapred-site.xml

我是直接导入文件覆盖

3.同步到其他节点

scp * node1:/usr/local/soft/hadoop-2.7.6/etc/hadoop/

scp * node1:/usr/local/soft/hadoop-2.7.6/etc/hadoop/

4.删除hadoop数据存储目录下的文件 每个节点都需要删除

rm -rf /usr/local/soft/hadoop-2.7.6/tmp

5.启动zookeeper 三台都需要启动

zkServer.sh start

zkServer.sh status

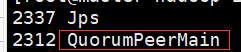

此时一台一个zk的节点

6.启动JN 存储hdfs元数据

三台JN上执行 启动命令: hadoop-daemon.sh start journalnode

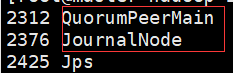

此时一台一个zk节点,一个jn日志节点

7.格式化 在一台NN上执行

hdfs namenode -format

启动当前的NN

hadoop-daemon.sh start namenode

此时master上多了个namenode节点

8.执行同步 没有格式化的NN上执行 在另外一个namenode上面执行

hdfs namenode -bootstrapStandby

这是node1上还没有namenode节点很正常,还没有启动hdfs

9.格式化ZK

在已经启动的namenode上面执行 !!一定要先 把zk集群正常 启动起来 hdfs zkfc -formatZK

10.启动hdfs集群,在启动了namenode的节点上执行

start-dfs.sh

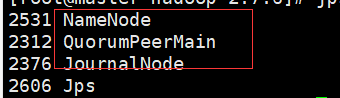

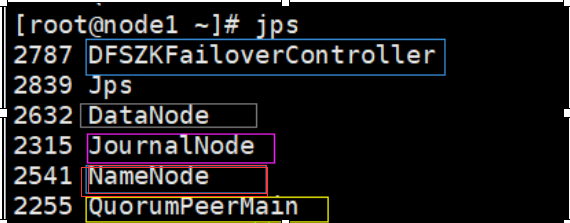

master上:

node1上:

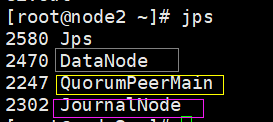

node2上:

黄色:QuorumPeerMain:zk的节点,三台都有 3个

粉色:JournalNode:jn日志节点,三台都头 3个

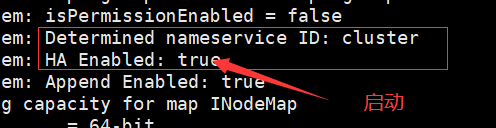

红色:Namenode:管理节点:出现在master和node1上 2个

蓝色:DFSZKFailoverController:ZKFC:用来观察master和node1,防止宕机时可以替代 2个

灰色:DataNode:工作节点,用于存储hdfs数据,出现在node1和node2上 2个

一共12个节点此时

11.启动yarn 在master启动

start-yarn.sh

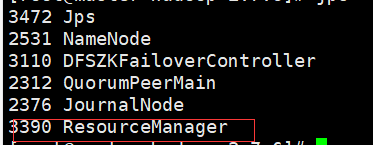

master:多了一个ResourceManager节点,用于处理整个集群资源的总节点

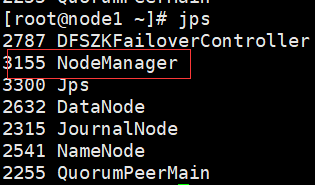

node1和node2上:多个NodeManger节点,用于跟踪监视资源

此时多了一个ResourceManager节点和2个NodeManager节点

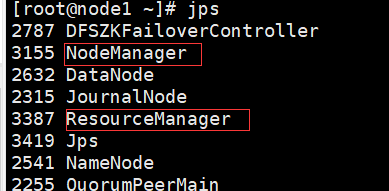

12.在另外一台主节点上启动RM

yarn-daemon.sh start resourcemanager

此时node1上:多个一个nNodeManager节点,用于备份

此时node1多了个 ResourceManager节点

Hadoop的高可用搭建的更多相关文章

- Hadoop HA高可用集群搭建(Hadoop+Zookeeper+HBase)

声明:作者原创,转载注明出处. 作者:帅气陈吃苹果 一.服务器环境 主机名 IP 用户名 密码 安装目录 master188 192.168.29.188 hadoop hadoop /home/ha ...

- hadoop 集群HA高可用搭建以及问题解决方案

hadoop 集群HA高可用搭建 目录大纲 1. hadoop HA原理 2. hadoop HA特点 3. Zookeeper 配置 4. 安装Hadoop集群 5. Hadoop HA配置 搭建环 ...

- hadoop+zookeeper集群高可用搭建

hadoop+zookeeper集群高可用搭建 Senerity 发布于 2 ...

- Hadoop记录-Hadoop NameNode 高可用 (High Availability) 实现解析

Hadoop NameNode 高可用 (High Availability) 实现解析 NameNode 高可用整体架构概述 在 Hadoop 1.0 时代,Hadoop 的两大核心组件 HDF ...

- Hadoop HA(高可用) 详细安装步骤

什么是HA? HA是High Availability的简写,即高可用,指当当前工作中的机器宕机后,会自动处理这个异常,并将工作无缝地转移到其他备用机器上去,以来保证服务的高可用.(简言之,有两台机器 ...

- Hadoop HA高可用集群搭建(2.7.2)

1.集群规划: 主机名 IP 安装的软件 执行的进程 drguo1 192.168.80.149 j ...

- Hadoop HA 高可用集群的搭建

hadoop部署服务器 系统 主机名 IP centos6.9 hadoop01 192.168.72.21 centos6.9 hadoop02 192.168.72.22 centos6.9 ha ...

- Hadoop(25)-高可用集群配置,HDFS-HA和YARN-HA

一. HA概述 1. 所谓HA(High Available),即高可用(7*24小时不中断服务). 2. 实现高可用最关键的策略是消除单点故障.HA严格来说应该分成各个组件的HA机制:HDFS的HA ...

- Hadoop完全高可用集群安装

架构图(HA模型没有SNN节点) 用vm规划了8台机器,用到了7台,SNN节点没用 NN DN SN ZKFC ZK JNN RM NM node1 * * node2 * ...

随机推荐

- MySQL记录之间是单向链表还是双向链表?

前言 本文的观点是基于MySQL使用Innodb存储引擎的情况下进行的! 很多渠道说:MySQL数据按照主键大小依次排列,记录之间是双向链表连起来.如果说我告诉你这种说法很大程度上是错的,你肯定说我在 ...

- sqli-labs lesson 24-25a

less 24: 注意一开始登录后出现无法返回或者跳转页面的话是因为一开始解压sqli-labs文件时出现 logged-in.php文件不正确同名文件有问题. 直接重新解压一边全部替换掉所有文件即可 ...

- 使用Java8改造出来的模板方法真的是yyds

GitHub 21.3k Star 的Java工程师成神之路,不来了解一下吗! GitHub 21.3k Star 的Java工程师成神之路,真的不来了解一下吗! 我们在日常开发中,经常会遇到类似的场 ...

- vivo商城计价中心 - 从容应对复杂场景价格计算

一.背景 随着vivo商城的业务架构不断升级,整个商城较为复杂多变的营销玩法被拆分到独立的促销系统中. 拆分后的促销系统初期只是负责了营销活动玩法的维护,促销中最为重要的计价业务仍然遗留在商城主站业务 ...

- QT 自定义控件 以及信号和槽的使用

自定义login 控件 Login头文件 #ifndef LOGIN_H #define LOGIN_H #include <QWidget> namespace Ui { class L ...

- uwp 的work project 的 取消闹钟

private void initalAlarmHanle() { string cancelAlarm = "CancelAlarmEvent"; ConnectionManag ...

- 输入URL后浏览器的过程

In this article, I want my readers to get a picture of a very basic concept of the web world. Previo ...

- tensorflow 单机多卡 官方cifar10例程

测试了官方历程,看没有问题,加上时间紧任务重,就不深究了. 官方tutorials:https://www.tensorflow.org/tutorials/images/deep_cnn githu ...

- VSCode添加某个插件后,Python 运行时出现Segmentation fault (core dumped) 解决办法

在VSCode添加某个插件后,Debug出现Segmentation fault (core dumped) 解决方案,在当前environment下运行: conda update --all

- VS2017 添加预定义宏

project_name[right click] -> Properties -> C/C++ -> Preprocessor -> Preprocessor Definit ...